新智元报道

【新智元导读】从打破CUDA垄断到国家级万卡集群落地,中国算力大动脉终于接通,国产万亿大模型从此告别「裸奔」时代。

20世纪20年代,美国石油公司给中国戴上了「贫油」的帽子。

那是一个资源匮乏到极致的年代,一滴汽油几乎等于一滴血。

地质学家断言中国无油可采,嘲笑声从大洋彼岸传来。

可中国人硬是从荒原里一锹一锹掘出了黑色黄金,大庆、胜利、华北……一座座油田拔地而起,最终让「石油自给」四个字,成为中国工业奇迹最硬核的注脚。

历史总是惊人地相似。

这一次,美国卡脖子的不再是石油管道,而是高端芯片、CUDA生态,以及全球最顶尖的算力集群。

算力,尤其是万卡级算力,正在取代石油,成为新工业文明的「战略资源」。

美国巨头以吉瓦为单位疯狂扩张算力版图,甚至引发了「电荒」。

当海外巨头以吉瓦为单位扩张算力版图时,中国AI产业则面对芯片管制、生态壁垒和算力碎片化的三重夹击,必须回答一个根本命题——

中国的大模型,到底该用什么算力来喂?

今天的竞争早已不是「某家公司能不能搞到卡」,而是「一个国家能不能把算力当成公共基础能力来运营」。

换句话说:算力竞赛,从拼卡升级为拼基础设施!

而国家级顶层设计,已经明确落子。

2026年2月6日,工信部正式发布的《关于组织开展国家算力互联互通节点建设工作的通知》。

通知提出构建「1+M+N」国家算力互联互通节点体系——

1个国家算力互联网服务节点 + M个区域节点 + N个行业节点。

这份通知最重要的,不是技术条文,而是它释放的强烈信号:国家正在把算力当作「统一规划、统一标准、统一规则」的新型基础设施来建设与治理。

传达出的信息再明确不过:国家级顶层设计已经落子,「万卡大算力+万亿大模型」就是中国AI产业弯道超车的必然路径。

很多人以为算力贵,是因为供不应求。

可更深的原因是:算力是典型的「卖铲人」生意,一旦生态形成,上游就拥有定价权。

看看英伟达的财务数据就明白了:在AI浪潮驱动下,其毛利率长期处在令人咋舌的高位,2025财年毛利率达到约75%。

这意味着你买到的不是硅片,而是生态税!

于是头部厂商走出了一条极具代表性的路线:垂直一体化。

从芯片到系统到软件再到模型再到应用,全链条深度绑定,层层优化,性能拉满,效率极高。

谷歌在TPU体系上反复强调「系统级协同设计」(system-level co-design),把整套TPU Pod当作一个整体超级计算机来设计,从硅到互连到软件栈一体化推进。

这条路线当然强,但它只适合少数「超级玩家」——钱、人才、工程管理、供应链与组织能力缺一不可。

更关键的是:它不适合一个国家的产业全局。

因为国家要解决的不是哪家公司的需求,而是千行百业共同上车。

当美国都在为电力与并网头疼时,你就会明白:即便是超级玩家,都会在基础设施面前遇到现实的天花板。

所以,从产业全局看,更有生命力的路径,其实是——开放路线。

以AI计算开放架构为代表的开放路线,强调的是兼容多品牌加速卡、打通主流软件生态、降低迁移门槛。

两种模式都有价值,但从产业全局看——开放路线一定是最有生命力的,也是最适合大多数厂商的。

因为AI的未来不是一家独大,而是千行百业跨领域、跨层次地深度参与。

没有开放的算力底座,就不可能有繁荣的应用生态。

就像当年PC产业的IBM兼容机战胜苹果封闭体系,开放永远是产业规模化的终极答案。

可现实是残酷的。

全球竞争格局已发生了质变。

当前AI竞争已进入「规模战争」阶段——

国外对先进算力的技术和市场垄断,已成为制约中国AI产业发展的关键瓶颈。

单纯依赖单体技术优化和追赶已无法弥合差距,中国AI亟需探索一条更具战略全局安全优势的系统化突围之路。

过去「先模仿再超越」的幻想已经破灭,现在需要的是不破不立——建立完全自主可控的技术体系。

你必须让国产算力,不仅「有」,还要「好用」;不仅能跑,还要跑得稳、跑得满、跑得省;不仅能训练,还要能交付。

而行业正在用更具体的行动,把这件事从口号拉到现实。

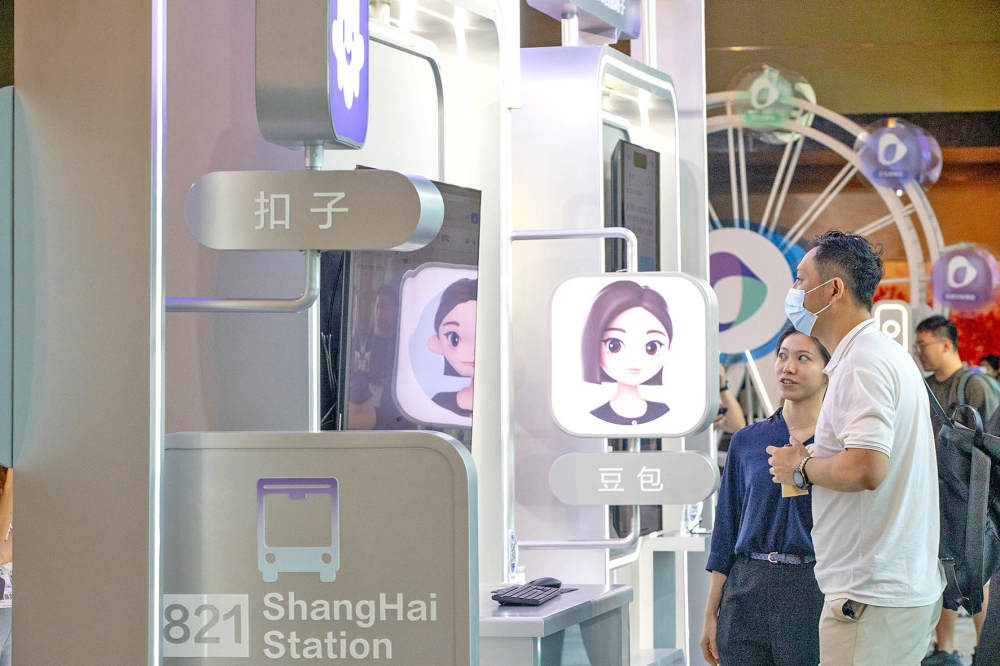

2月10日,光合组织在郑州举办「国产万卡算力赋能大模型发展研讨会暨联合攻关启动仪式」,各方代表在此次会议上形成多项关键共识,几乎把行业痛点说透了:

-

自主算力是「生存底座」:没有万卡级的自主集群,万亿参数的国产大模型就是无本之木。这不仅是技术必选项,更是产业安全的生命线。

-

供需协同是「进化飞轮」:算力不是买来的,是用出来的。没有应用,算力就是「一堆铁疙瘩」。

-

全栈攻关是「破局利刃」:只有打通从底层芯片到顶层应用的每一根「毛细血管」,才能实现从「勉强可用」到「极致好用」的根本性跨越。

这为万亿参数级的国产大模型点明破局方向。

但到底如何做?行业做了哪些探索?

国内有一个长期被严重低估的真相——

现阶段很多模型的发展是离不开和底层软硬件系统深度的结合。底层变得「更重」,对集群和框架的技术要求发生质变。

这颠覆了传统认知:过去,大家认为算法创新可以脱离硬件;现在发现没有自主算力,就没有模型创新自主权。

中国信通院人工智能研究所软硬件与生态部主任李论认为,整个软硬件的生态体系,是下一个阶段模型创新和智算设施竞争的焦点。

她判断:「今天行业是以应用为导向牵引整个AI算力体系的建设。未来,整个智算集群的建设和发展也将会走向更精细化的状况。」

前年,基础模型战争,大家「卷模型」。

去年,AI模型架构趋同和收敛,形成新的行业共识。

特别是,DeepSeek的出现具有历史转折意义——模型层收敛,架构层创新。

这是一个关键转折:架构创新下放至计算层和设施层,革新通用化技术。

于是,算力互联、统一调度、可用算力池,开始从幕后走到台前。

就在几天前的2月5日,国家超算互联网核心节点在郑州上线试运行,部署3套曙光scaleX万卡超集群,是全国首个实现超3万卡部署、且实际投入运营的最大国产AI算力池。

依托得天独厚的区位优势和算力资源,在本次研讨会上同步启动的「国产大算力+国产大模型联合攻关专项计划」则变得水到渠成——分为专属万卡资源池(面向卓越级伙伴,从头训万亿级模型)和千卡级资源池(面向5-10家优选伙伴,推进垂类应用落地),实质是在用国产算力「喂」国产大模型。

光合组织、大模型厂商、模型加速厂商及重点行业用户出席仪式

当万卡集群真正以「可用算力」的形态落地,它带来的变化往往不是「又多了多少卡」,而是生产方式的切换:算力变成可被稳定调用、可被统一编排、可被持续运营的基础能力。

在架构、网络、调度、容错、监控与计量等关键环节上,万卡规模的算力池具备了工程化,模型训练与推理任务可以像使用云计算资源一样「拿来就用」。

对模型团队而言,这意味着从第一天开始就能把精力放在数据、训练策略、对齐与评测等核心工作上,而不是先花几个月做集群适配、排障与手工调优。

更关键的是链式反应:

一旦算力底座变得稳定且可预期,创新的约束条件会发生根本变化——试错成本下降、迭代周期缩短、参与门槛降低。

过去很多团队做大模型,第一阶段往往卡在「能不能跑起来」,第二阶段卡在「能不能跑得稳、跑得满」,第三阶段卡在「能不能降本、能不能交付」。

当万卡集群把这些底层不确定性显著收敛之后,模型侧与应用侧的行为模式会迅速改变:模型团队敢于做更频繁的实验迭代,应用团队也更愿意把试点推向生产环境。

重要的是:这会反向推动国产软硬件体系进入自我加速的正循环——算力越可用 → 模型越敢训 → 应用越敢上 → 需求越真实 → 迭代越快 → 算力越可用。

这就是所谓的「供需协同飞轮」。

当万卡集群解决了算力适配难题,当超算互联网打通了算力调度的「最后一公里」,国产的万亿大模型才能有可能真正摆脱算力制约,从「实验室试点」走向「产业规模化应用」。

回看工信部「1+M+N」算力互联互通节点体系,国家意志已经非常清晰。

算力是AI时代的粮食。

谁的粮仓更大、粮道更通、粮权更自主,谁就掌握智能时代的主动权。

从「贫油帽子」到「石油自给」,中国用几十年把不可能变成事实。

今天从「算力封锁」到「算力自立」,也不会靠一句口号完成,而要靠一套可运行、可扩展、可验证的工程体系完成。

光合组织和它的伙伴们正在做示范:当万卡超集群与超算互联网结合,算力不再是少数巨头的私有资源,而开始成为能被更多模型、更广行业调用的公共底座。

它们走在前面,不是因为喊得更响,而是因为它们把最难的那一步——把「万卡」变成「可用算力」——先走出来了。

这场突围,没有退路,也不需要退路。