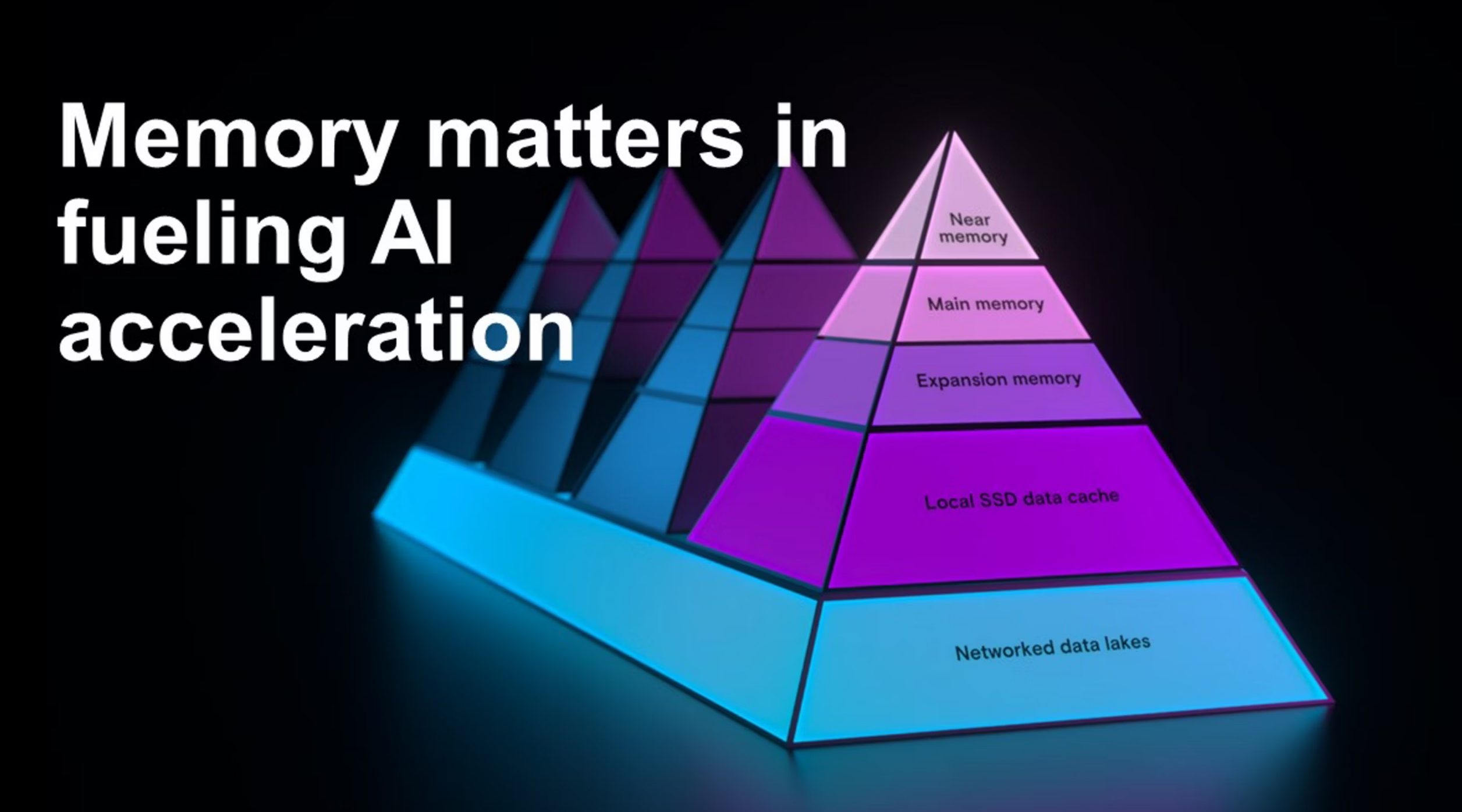

【科技24时区】在讨论人工智能基础设施成本时,业界通常聚焦于英伟达(NVIDIA)及其GPU芯片。然而,内存正日益成为决定AI系统效率与成本的关键因素。随着超大规模云服务商(hyperscalers)计划投入数十亿美元新建数据中心,DRAM内存芯片价格在过去一年内已飙升约7倍。

与此同时,如何高效调度和管理这些内存资源,确保在正确的时间将正确的数据送达正确的计算单元,正逐渐形成一门新的技术学科。掌握这一能力的企业,将能以更少的Token完成相同查询任务,这在当前高成本环境下,可能直接决定企业是继续运营还是被迫退出市场。

半导体分析师丹·奥劳夫林(Dan O’Laughlin)在其Substack专栏中深入探讨了内存芯片的重要性,并采访了Weka公司首席AI官瓦尔·贝尔科维奇(Val Bercovici)。两位均出身半导体行业,因此讨论重点集中在芯片层面,但其对AI软件架构的影响同样深远。

贝尔科维奇特别指出Anthropic公司Prompt缓存机制文档的演变趋势:六个月前,其缓存定价页面仅简单提示“使用缓存,成本更低”;如今却已演变为一本详尽的操作指南,明确指导用户应预购多少缓存写入额度。目前主流提供5分钟和1小时两种缓存保留窗口,且无更长选项。这一变化被视为行业走向精细化内存管理的重要信号。

缓存机制还催生了复杂的套利机会:用户可根据预购的写入量,优化缓存读取成本。由于从缓存中读取数据远比重新加载便宜,合理规划可大幅节省开支。但需注意的是,每次向查询中添加新数据,都可能挤出缓存中已有内容,从而影响整体效率。

尽管技术细节复杂,其核心结论却清晰明确:未来AI竞争的关键之一,将在于内存管理能力。那些在内存编排(memory orchestration)方面表现卓越的企业,有望在行业中脱颖而出。该领域仍处于早期阶段,存在大量创新空间。例如,去年10月曾有初创公司TensorMesh专注于“缓存优化”这一技术栈层级,即为典型案例。

从技术栈底层看,数据中心如何在DRAM与HBM(高带宽内存)之间进行权衡使用,也直接影响整体性能与成本。而在应用层,终端用户正尝试通过构建“模型集群”(model swarms),以共享缓存提升资源利用率。随着内存调度效率提升,推理所需Token数量将持续下降;同时,模型本身对每个Token的处理效率也在提高,双重效应将进一步压低AI运行成本。

当服务器成本持续走低,许多当前看似无法盈利的AI应用场景,或将逐步迈入商业化可行区间。内存,这一曾被忽视的“幕后角色”,正悄然成为驱动AI经济性突破的新引擎。