今天推荐一个好发高区的高潜力方向:大模型+因果推断。

这方向主要围绕大模型在因果推断中的应用做一系列创新。还记得ICLR 2025黑马Celcomen吗?就是今年这方向的明星成果。为提升大模型因果推理的技术路径,目前我们探索的主流思路还是结合传统因果模型、知识增强、提示工程与微调。

未来需结合更复杂的任务和评估框架,会往多模态推理、标准化评估、可解释性优化等方向深入。如果感兴趣,抓紧上车,现在正是入场黄金期,创新空间大竞争未饱和,发论文潜力可观!

本文整理了12篇大模型+因果推断新论文,可做创新点参考,开源代码有,方便大家了解前沿,快速复现。

扫码添加小享,回复“因果大模型”

免费获取全部论文+开源代码

Can Large Language Models Help Experimental Design for Causal Discovery?

方法:LeGIT框架结合LLM与数值方法,用于因果干预目标选择。先由LLM识别潜在目标,再经数值方法筛选,学习因果结构。在四数据集实验中优于现有方法及专家,展现LLM辅助实验设计潜力。

创新点:

提出LeGIT框架,融合大模型与数值方法,助力因果发现实验设计。 在因果发现初期,利用大模型基于世界知识和实验元信息识别潜在干预目标,为因果结构识别提供清晰方向。 随着因果图逐渐清晰,转而采用数值方法继续选择干预目标,精准学习因果结构。

ProMind-LLM: Proactive Mental Health Care via Causal Reasoning with Sensor Data

方法:ProMind-LLM结合大语言模型与因果推断,用于主动心理健康护理。整合主客观数据提升风险评估准确性,关键有领域预训练、自我优化机制和因果链式推理,在真实数据集上表现优于通用LLM,展现护理潜力。

创新点:

提出ProMind-LLM,创新性地将大型语言模型应用于心理健康风险评估,整合主观心理记录和客观行为数据。 设计特定领域的预训练和自我优化机制,提升模型对心理健康数据的理解和处理能力。 引入因果链式推理,增强预测结果的可靠性和可解释性。

扫码添加小享,回复“因果大模型”

免费获取全部论文+开源代码

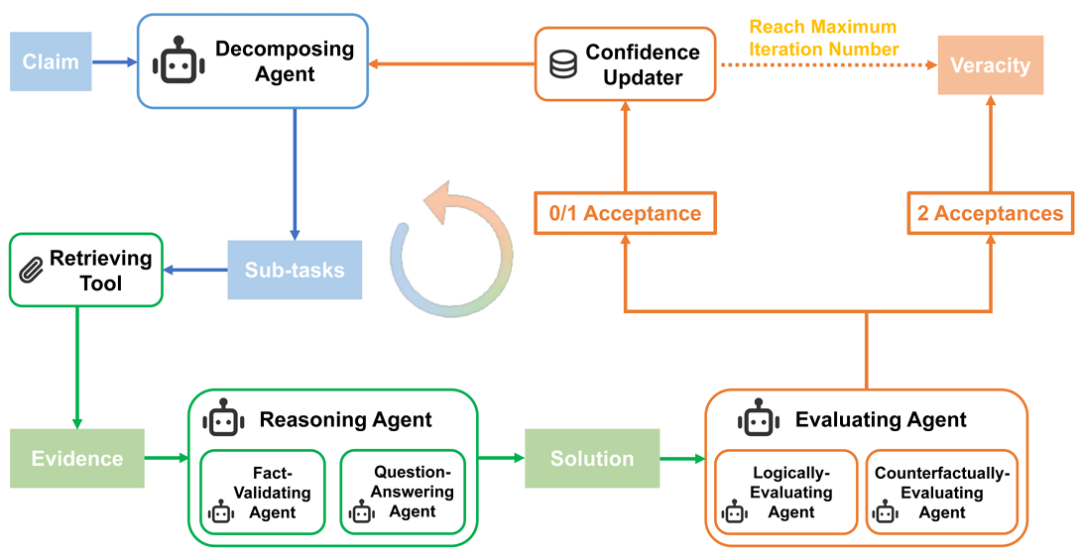

LoCal: Logical and Causal Fact-Checking with LLM-Based Multi-Agents

方法:论文提出LoCal框架,基于多智能体逻辑与因果,利用LLM分解声明为子任务,由专业智能体处理并评估逻辑与因果一致性,迭代优化以提升事实核查准确性和可解释性。

创新点:

提出LoCal框架,基于多智能体系统进行逻辑和因果事实核查。 引入逻辑评估和反事实评估智能体,确保解决方案的逻辑和因果一致性。 通过迭代过程优化事实核查结果,提高准确性和可解释性。

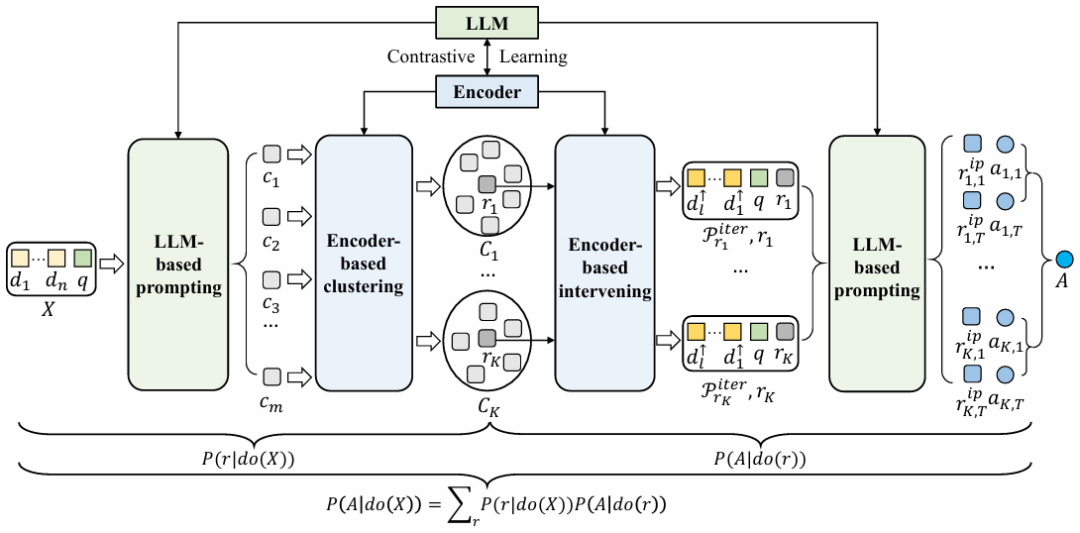

Causal Prompting: Debiasing Large Language Model Prompting Based on Front-Door Adjustment

方法:论文提出“因果提示”方法,减少LLMs在NLP任务中的偏差。通过前门调整分解因果效应,采用链式思考提示结合聚类算法、上下文学习提示结合NWGM近似算法进行估计。同时,用对比学习微调编码器对齐表示空间,提升因果效应估计准确性。

创新点:

提出因果提示方法,基于前门调整分解因果效应并分别估计。 结合链式思考提示、聚类算法、上下文学习和NWGM近似算法进行因果效应估计。 使用对比学习微调编码器,对齐表示空间以提高估计准确性。

扫码添加小享,回复“因果大模型”

免费获取全部论文+开源代码