一、RAG 的基本定义

检索增强生成(Retrieval-Augmented Generation,RAG)是一种**“先检索、后生成”**的大模型框架:

用户输入问题 →

检索器从外部知识源(文档库、互联网、数据库或知识图谱)拉取最相关的片段 →

生成器(LLM)将检索结果与用户问题一并编码 →

输出更精准、更新、更可解释的文本答案。

核心思想:把静态的参数记忆升级为动态的外部记忆,从而缓解幻觉、过期信息、专业术语歧义等 LLM 固有问题。

二、为什么要用 RAG

复制

与微调相比

• 微调:成本高、更新慢、需要重训;

• RAG:只需更新检索库即可“即插即用”,成本低、时效快。

三、非结构化检索增强

3.1 文档检索

向量化:将文本、音频、视频转成高维向量,语义相似的在空间中距离更近。

索引与加速

• 小规模:暴力搜索即可;

• 大规模:使用 Faiss、Milvus、Pinecone、Chroma 等向量库做 ANN(近似最近邻)。流程

文档切片(chunking)

Embedding → 向量库

用户问题向量化 → k 近邻召回

召回片段 + 问题 → LLM 生成答案

3.2 网络检索

动态知识源:实时抓取网页、论坛、新闻、API。

HTTP 协议是底层通道:GET/POST 拉取 JSON/HTML/XML,通过内容协商获取不同格式。

落地案例

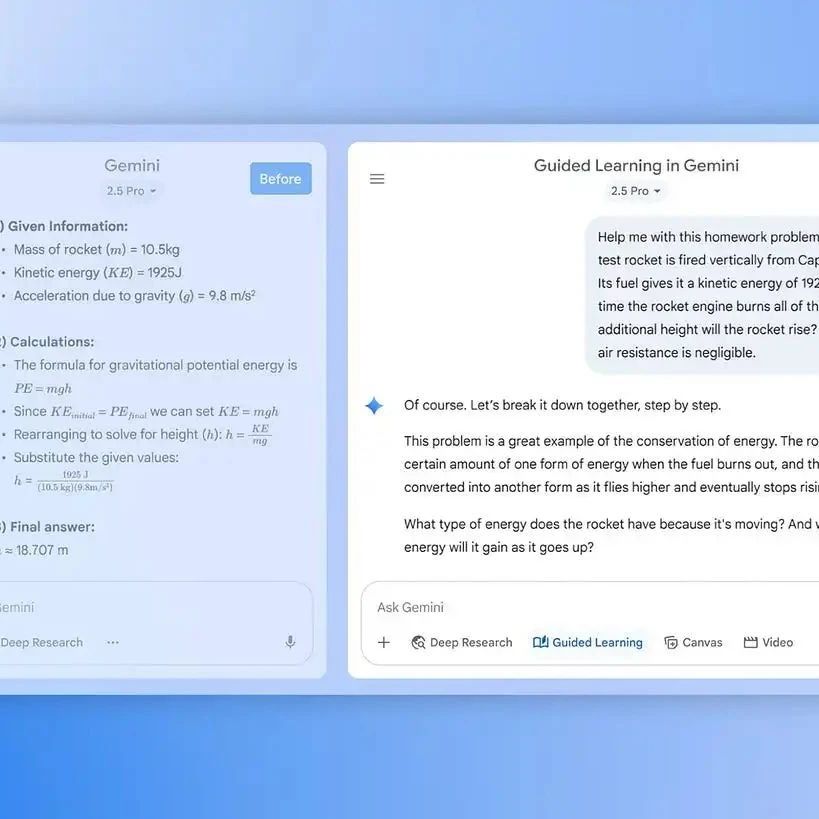

• ChatGPT / DeepSeek 的“联网搜索”就是网络检索增强;

• 可实时返回比特币价格、突发新闻、股市行情。

四、结构化检索增强

4.1 知识图谱(GraphRAG)

表示:实体-关系-实体三元组 (Einstein, bornIn, Germany)。

微软 GraphRAG 流程

索引阶段

• 文本切块 → LLM 抽取实体/关系 → 构建图 → 生成图嵌入 →多级语义索引。查询阶段

• 用户问题 → 子图检索 → 子图+问题 → LLM 生成答案。

优势:可解释、可推理、适合多跳问答。

4.2 关系数据库(TAG 模型)

斯坦福 + 伯克利 TAG

查询合成(Text2SQL):自然语言 → SQL。

查询执行:SQL 在 DB 中运行,得到结果集。

答案生成:结果集 + 原问题 → LLM 生成自然语言答案。

示例

问:“总结票房最高的经典浪漫片影评”

→ 语言模型先判断“经典浪漫片”,再聚合票房最高者 → 返回《泰坦尼克号》评论摘要。

五、关键技术细节与工程考量

切分策略

• 固定长度 vs 语义段落 vs 滑动窗口;

• 过长文本需摘要或层次化索引,避免语义稀释。混合检索

• 向量召回 + 关键词 BM25 + 知识图谱路径,提升鲁棒性。实时性 vs 稳定性

• 网络爬取需去重、去噪、可信度评分;

• 结构化源需做缓存与增量更新。安全合规

• 私域文档需脱敏;

• 网络检索要过滤非法/侵权内容。

六、典型场景对比

复制

七、未来讨论要点

医疗场景:知识图谱与关系数据库如何权衡误诊风险与查询效率?

学术系统:PDF 文档与实时网络检索如何互补并避免冲突?

法律合同:长文本语义分散时,Chunking、摘要、图谱嵌入哪种更优?

一句话总结

RAG 把大模型从“闭卷考试”变成“开卷考试”:先精准找资料,再基于资料答题,实现实时、准确、可追溯的智能问答,已成为大模型落地的工程化标准范式。

本书免费下载地址

关注微信公众号“人工智能产业链union”回复关键字“AI大模型05”获取下载地址。