打造一个有温度、有趣味、专业的全栈式AI&AIGC交流社区,

用心写好每一篇文章!

项目主页-https://amap-ml.github.io/Omni-Effects.github.io/

代码链接-https://github.com/AMAP-ML/Omni-Effects

论文链接-https://arxiv.org/pdf/2508.07981

01-Omni-Effects核心优势

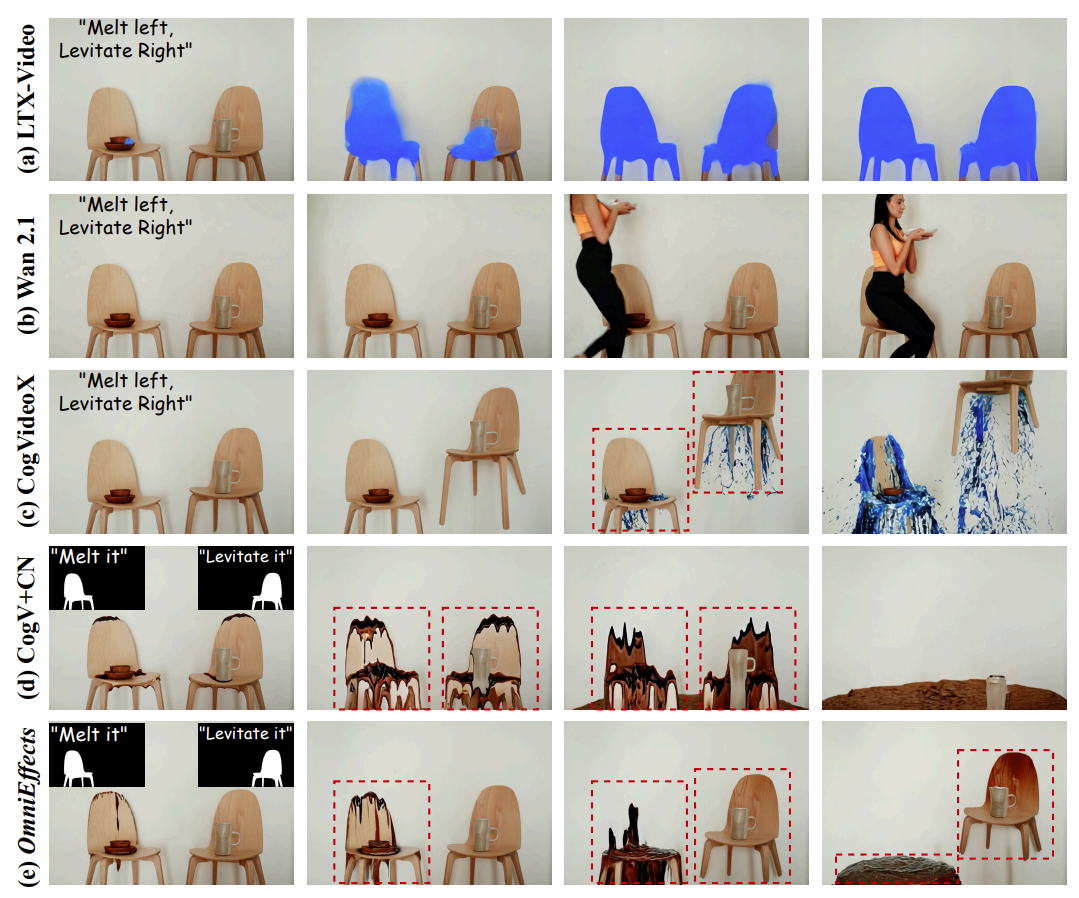

阿里提出了Omni Effects,这是第一个能够生成即时引导效果和空间可控复合效果的统一框架。该框架的核心包括两个关键创新:

1)基于专家混合(LoRA-MoE),它采用了一组专家LoRA,在统一的模型中整合了各种效果,同时有效地减轻了跨任务干扰。

2)空间感知提示(SAP)将空间掩码信息整合到文本标记中,实现了精确的空间控制。

此外,作者引入了集成在SAP中的独立信息流模块,隔离与单个效果相对应的控制信号,用来防止任何不必要的混合。

02-Omni-Effects落地场景

03-Omni-Effects上手指南

# 步骤1-搭建运行环境git clone https://github.com/AMAP-ML/Omni-Effects.gitcd Omni-Effectsconda create -n OmniEffects python=3.10.14pip install -r requirements.txt# 步骤2-不同特效视频生成sh scripts/prompt_guided_VFX.sh # modify the prompt and input imagesh scripts/inference_omnieffects_singleVFX.shsh scripts/inference_omnieffects_multiVFX.sh

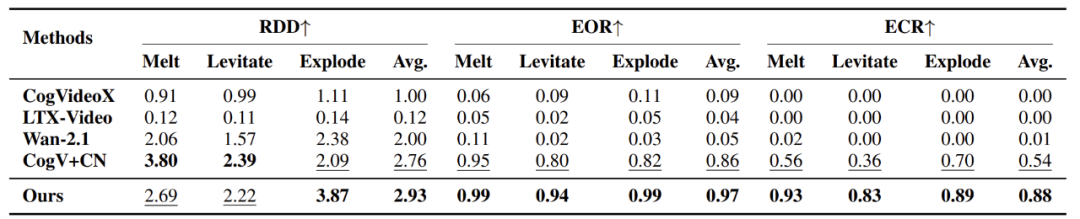

04-Omni-Effects性能评估

关注我,AI热点早知道,AI算法早精通,AI产品早上线!

禁止私自转载,需要转载请先征求我的同意!

欢迎你的加入,让我们一起交流、讨论与成长!