这两天,英伟达一个最新研究结论让业界备受关注——小型语言模型(SLM)才是智能体的未来。紧接着,英伟达又抛出了自己的全新小型语言模型:Nemotron-Nano-9B-V2,该模型在部分基准测试中达到了同类产品中的最高性能。

事实上,小型语言模型(SLM)的风,也刮到了MCU和MPU领域。

小模型,就是“压小”的大模型

小型语言模型(SLM)也许我们早有所接触。SLM 的参数范围从几百万到几十亿不等,而 LLM 则具有数千亿甚至数万亿参数。

SLM是由LLM压缩而来,压缩模型需要在缩小模型的同时,尽可能保留模型的准确性。常见方法如下:

知识蒸馏:利用从大型“教师”模型转移的知识来训练一个较小的“学生”模型;

剪枝:移除神经网络架构中冗余或不那么重要的参数;

量化:降低计算中使用的数值精度(例如,将浮点数转换为整数)。

小型语言模型比大型模型更紧凑、更高效。因此,SLM需要较少的内存和计算能力,非常适合资源受限的边缘或者嵌入式设备。

许多小而强大的语言模型已经出现,证明大小并非一切。常见的10亿到40亿的SLM包括Llama3.2-1B(Meta开发的10亿参数变体)、Qwen2.5-1.5B(阿里巴巴的15亿参数模型)、DeepSeeek-R1-1.5B(DeepSeek的15亿参数模型)、SmolLM2-1.7B(HuggingFaceTB,的17亿参数模型)、Phi-3.5-Mini-3.8B(微软的38亿参数模型)、Gemma3-4B(Google DeepMind的40亿参数模型)。

跑SLM,靠得不光是算力

对MPU来说,跑SLM,似乎不是什么难题。但对开发人员来说,如何知道MCU支持是否支持运行生成式AI?

这个问题没有单一、直接的答案——不过有一个硬性要求,即MCU的神经处理单元(NPU)必须能够加速Transformer运行。

除此之外,跑生成式AI,对于MCU的带宽系统总线以及以及大容量、高速、紧密耦合的内存配置有要求。

其实,现在很多人都去只用GOPS(十亿次运算每秒)或TOPS(万亿次运算每秒)来比较微控制器的原始吞吐量,目前性能最佳的MCU能提供高达250GOPS的算力,而用于生成式AI的MCU将至少提供两倍于此的性能。但原始吞吐量并非衡量实际系统性能的理想指标。

因为成功的生成式AI应用程序需要支持Transformer运算,会在系统内部、内存、神经处理单元、中央处理器以及图像信号处理器等外围功能之间传输大量数据。因此,一个具有高原始吞吐量的系统理论上或许能快速处理大量数据,但如果系统无法将数据快速传输给神经处理单元,实际性能就会十分缓慢,令人失望。

当然,对MPU来说,大带宽、内存、总线之间的紧密耦合也至关重要。

Aizip与Renesas合作的SLM项目

早在去年8月,Aizip就与Renesas携手合作,在MPU上展示了用于边缘系统应用的超高效SLM和紧凑型AI Agents,这些小巧而高效的模型已经集成到基于 Arm Cortex-A55的Renesas RZ/G2L和RZ/G3S主板中。

Aizip创建了一系列超高效的小型语言模型(SLM)和人工智能代理(AI Agents),名为 Gizmo,规模从3亿到20亿个参数不等。这些型号支持多种平台,包括适用于广泛应用的 MPU和应用处理器。

SLM使设备边缘应用程序上的AI代理能够提供与大型语言模型(LLM)相同的功能,但在边缘占用空间上。设备上模型具有增强的隐私保护、弹性作和节省成本等优势。虽然一些公司已经成功地减小了手机语言模型的大小,但确保在低成本边缘设备上为自动化应用提供准确的工具调用仍然是这些 SLM 面临的重大挑战。

据介绍,在运行频率为1.2 GHz的单个A55内核的RZ/G2L上,这些SLM可以实现不到3秒的响应时间。

MCU,也在加大对SLM投入

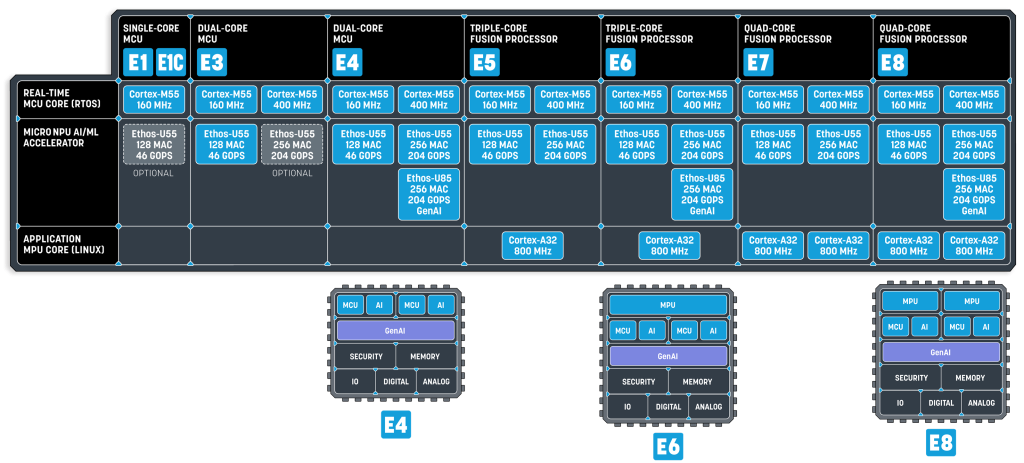

Alif Semiconductor最近发布了最新系列的MCU和融合处理器——Ensemble E4、E6和E8,便主要针对支持SLM在内的生成式AI模型的运行。与此同时,Alif是首家使用 Arm Ethos-U85 NPU(神经处理单元)的芯片供应商,该芯片支持基于Transformer的机器学习网络。

根据基准测试结果显示,该系列在不到2毫秒的时间内进行高能效物体检测、图像分类时间不到8毫秒、在E4设备上执行的SLM在生成文本以根据用户提供的提示构建故事时仅消耗36mW的功率。

Ensemble E4(MCU)采用双Arm Cortex-M55内核,Ensemble E6和E8融合处理器分别基于Arm Cortex-A32内核和双Cortex-M55内核,值得注意的是E4/E6/E8均搭载双Ethos-U55+Ethos-U85,算力非常强大。

Alif认为,相比其他制造商,他们布局更早,因为第一代Ensemble MCU系列早在2021年就发布了,从那时起我们就一直在批量出货E1、E3、E5 和 E7设备。而在其他MCU厂商还停留在第一代AI MCU时,Alif就发布了第二代产品,同时是业界首款支持基于Transformer的网络的MCU,是LLM和其他生成式AI模型的基础。

SLM会是嵌入式的未来

SLM在大幅压缩模型体积的同时,尽可能保留了模型的准确性。这种高效、紧凑的特性,使其完美契合了资源受限的边缘和嵌入式设备,为这些设备带来了前所未有的智能能力。

事实上,边缘AI的未来图景正在徐徐展开,SLM也会是MCU和MPU厂商会布局的关键领域之一。

比如,意法半导体的STM32N6、英飞凌PSoC Edge最新一代MCU、TI的AM62A和TMS320F28P55x、恩智浦的i.MX RT700和i.MX 95、ADI的MAX7800X都开始重视NPU。

嵌入式AI最初主要是在Linux系统上运行的相对昂贵的基于微处理器的产品的一项功能。但很快,市场意识到边缘和端点设备中也有AI的空间——其中许多设备都是基于MCU。所以,在2025年下半年,先进的MCU厂商都将提供AI功能的产品纳入其产品组合中。这些厂商的NPU分为Arm Ethos IP一派和自研一派。目前来看,最新的Ethos-U85开始支持Transformer,并且在半年前展示了搭载SLM的效果,其他厂商也在不断跟进。在未来,相信SLM也会彻底改变MCU和MPU的格局。

参考文献

· END ·

扫码添加小助手回复“机器人”

进群和电子工程师们面对面交流经验