作者 | 理查德·萨顿(Richard Sutton)

原标题 | OaK 架构:一个源于经验的超级智能构想来源 | RLC 2025 会议文章(youtu.be/gEbbGyNkR2U)出品丨AI 科技大本营(ID:rgznai100)随着人工智能发展成为一个庞大的产业,它在很大程度上已经迷失了方向。

我们需要什么才能重回正轨,去探寻真正的智能?

我们需要能够持续学习的智能体、世界模型和规划能力,以及学习高层次知识和通过元学习掌握泛化的能力。

OaK 架构正是对所有这些需求的一个系统性回应。从整体上看,它是一个基于模型的强化学习架构,并具备三个鲜明特点:

1)其所有组件都能持续学习;

2)每一个学习到的权重,都配有一个专门的步长参数,该参数通过在线交叉验证进行元学习;

3)状态和时间上的抽象概念,通过一个我们称之为 FC-STOMP 的五步演进路径被持续创造出来,即:特征构建(Feature Construction)、基于特征提出子任务(posing a SubTask)、学习一个选项来解决该子任务(learning an Option)、学习该选项的模型(learning a Model)、以及使用该选项的模型进行规划(Planning)。

OaK 架构的内容相当丰富。在本文中,我们将勾勒其轮廓,并阐明那些为这一宏大构想——即超级智能如何从智能体的经验中涌现——做出贡献的诸多既有和同期的研究工作。

引言

OaK 架构是一个关于超级智能如何从经验中诞生的构想,它凝结了我为探寻人工智能核心问题而进行的长期思考与探索。在深入细节之前,我想首先强调人工智能这项任务的艰巨性与重要性。

人工智能的探索,本质上是一场伟大的远征。我们试图理解人类心智的运作方式,创造出与人类相仿的智能,并最终赋予我们自身更强大的力量。这无疑是一个意义深远的智力里程碑,其影响将是革命性的。尽管这一认知已是共识,但我们仍有必要时常停下脚步,去真正体味我们所从事事业的非凡难度与深远意义。从智力里程碑的意义上讲,其重要性或可与地球上生命的起源相提并论——至少,当这个星球上的智能体终于开始理解自身如何运作、如何思考,并意识到这种理解将如何颠覆一切时,其意义是同等重大的。

当然,这也是人类文明发展历程的自然延续,只是开启了一个更为宏大的新篇章。

我坚信,这一进程只会导向一个美好的未来。尽管许多人对此心存忧虑,但我认为其本质是纯粹向善的。并且,最伟大的进步仍在前方,这是一场需要耐心与毅力的马拉松。对于强化学习领域的研究者而言,一个值得庆幸的观点是,通往完全人工智能(即强人工智能)的必经之路,是强化学习这类经验性方法,而非大语言模型等非经验性路径。然而,一个看似矛盾的现实是,当前最大的瓶颈恰恰在于我们缺乏足够优秀的学习算法。人们或许会认为,拥有了深度学习,我们最擅长的领域便是学习算法。但在我看来,事实远非如此。我们现有的算法还相当粗糙,亟待改进,而这,正应是我们全力以赴的方向。

在过去半个世纪对智能本质的持续探索中,我每一天都在科研一线,致力于为强化学习、为从经验中学习,设计更优的算法。我的研究遵循着《阿尔伯塔人工智能研究计划》的指引——那是我与 Michael Bowling 和 Patrick Pilarski 在几年前共同制定的蓝图。

今天,我将要探讨的 OaK 架构,正是一个旨在构建通用人工智能智能体的整体性构想。我深信,它为我们指明了一条通往“理解心智”这一终极目标的清晰路径。

OaK 架构:命名与愿景

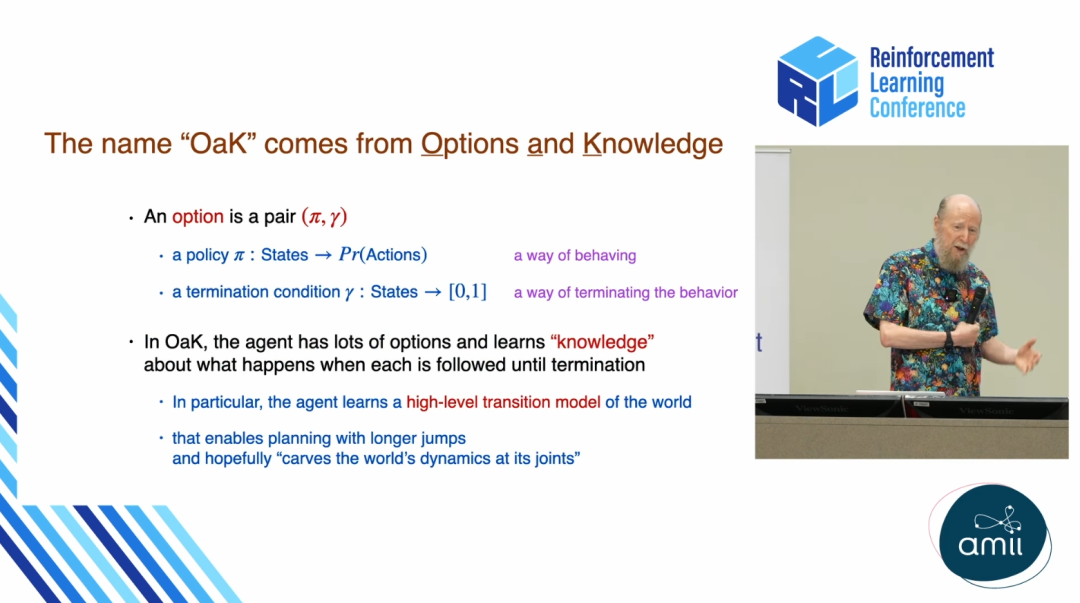

让我们从 OaK 这个名字开始。这个名字源于两个核心概念:“选项”(Options)和“知识”(Knowledge)。

在座的许多研究者都对“选项”这一概念非常熟悉。通常,一个选项被定义为一个三元组,但经过我过去二十年的研究演进,我已经舍弃了起始集(initiation set)的设定。

因此,对我而言,选项是一个更为简洁的组合,仅包含一个策略(policy)——即一种行为方式,和一个终止条件(termination condition)——即决定何时停止该行为的方式。在 OaK 架构中,智能体的核心构成是海量的选项,而它的“知识”,则具体表现为关于执行某个选项后世界会发生何种变化的知识。通过这种方式,智能体旨在学习一个关于世界的高层次转换模型。这个模型使其能够以更长的时间跨度进行规划,并有望深刻洞察世界内在的结构,如同“庖丁解牛”般游刃有余。

这就是 OaK 名称的由来。我认为,我们所面对的是一项宏大的挑战,一场伟大的远征。因此,我常将其比作追寻人工智能的“圣杯”。

为了更清晰地阐述其核心理念,我们可以将其设计目标归纳为以下三点:

领域通用性(Domain-General):该设计不应包含任何针对特定世界的预设知识,而应具备普适性。

经验性(Empirical):心智的成长应完全源于运行时的经验积累,而非依赖于某个特殊的训练阶段。

开放式复杂性(Open-ended Complexity):智能体应能在其心智中形成处理当前世界所必需的任何概念,其复杂性和抽象能力的上限仅受限于其计算资源。

这三大核心诉求,将是我们接下来探讨的重点。

核心理念:运行时学习与“大世界”视角

首先,有必要对两个关键术语——“设计时”(design-time)与“运行时”(run-time)——加以界定。“设计时”指代智能体在“工厂”中被构建的阶段,任何领域知识都应在此时被编码进去。而“运行时”则是智能体进入真实世界后,通过与环境的实际互动来学习、生活并制定计划的阶段。

以大语言模型为例,其几乎所有的“智能”都在设计时完成。一旦被部署使用,它便不再从新的交互中学到任何东西。而我所倡导的理念恰恰相反:所有重要的事情都应在运行时发生,即所谓的“在线学习”、“在岗学习”。

这便引出了“大世界”(Big World)视角。

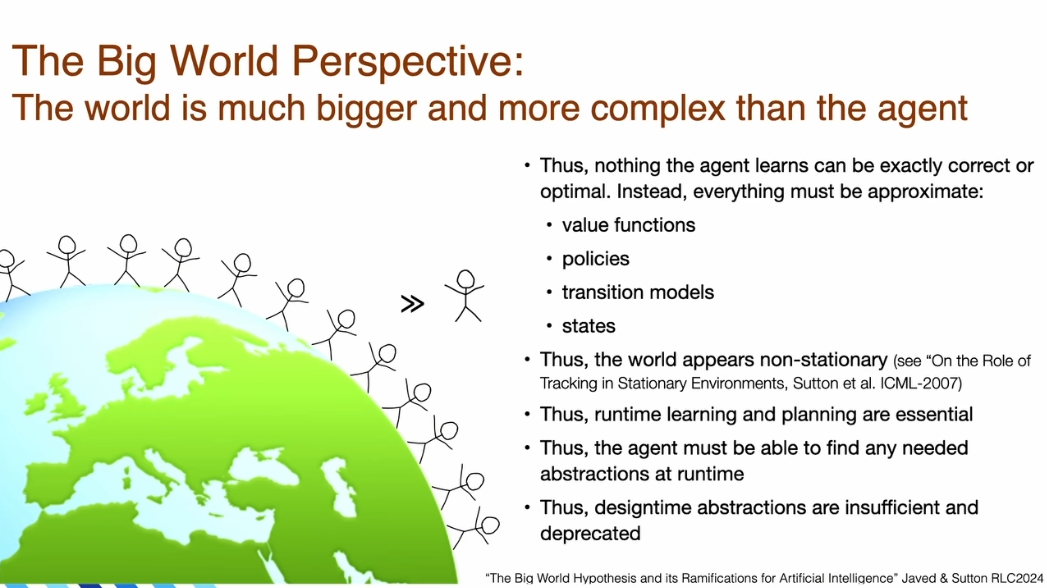

“大世界”假说,这一概念在阿尔伯塔的研究环境中已酝酿多年,并深刻地影响了我们的思维与设计方式。其核心思想十分简单:世界远比智能体更庞大、更复杂——其程度远超想象。世界必然远大于智能体,因为它包含了数十亿其他智能体,以及万物复杂的原子结构和细节。其他智能体(无论是朋友、伙伴还是竞争对手)头脑中的信息都与自身息息相关,必须被纳入考量。

由此得出的一个关键结论是:智能体所做的任何事都不可能是精确的、最优的,而只能是近似的。其构建的价值函数必然是近似价值函数;其策略也不可能是最优策略;其对世界的转换模型,也必然是经过高度简化的。智能体头脑中的世界模型,与外部那个庞大得多的真实世界相比,显得微不足道。智能体永远无法在心智中容纳世界的单个完整状态,更不用说容纳其他所有智能体的心智状态了。

这一视角最重要的推论是,世界对于智能体而言,最终将呈现出非平稳性(non-stationarity)。正如我和 Dave Silver、Anna Koop 在一篇论文中所指出的,当智能体缺乏对世界状态的完美感知和精确模型时,庞大世界中许多看似相似的区域,其实存在着函数逼近器无法捕捉的细微差别。这使得世界看起来是动态变化的。因此,运行时的学习和规划变得至关重要。智能体必须具备在运行时根据实际遭遇的情境,发现任何所需抽象的能力。这也意味着,在设计时预置的抽象概念,不仅是不充分的,甚至应该被摒弃。

运行时的学习总是优于设计时的学习,原因有三:

覆盖范围:“大世界”视角决定了设计时无法预见所有可能情况。

适应性:运行时学习可以针对智能体实际遇到的那部分世界进行高度定制和优化。

可扩展性:运行时学习的能力随可用的计算资源而扩展,而设计时学习则受限于可用的人类专业知识。回顾历史,“惨痛的教训”(the bitter lesson)明确指出,随计算资源扩展的一方终将胜出。

然而,我们必须承认,当今的深度学习方法在持续学习(continual learning)方面表现不佳,这是一个亟待解决的痛点。此外,运行时学习还有一个关键优势:它使得元学习(meta-learning)成为可能。元学习的精髓在于“在学习中提升学习能力”——智能体可以尝试不同的学习策略,评估其效果,并选择更优者用于未来的学习。这种自我改进的过程,要求学习本身必须是一个持续的、在运行时发生的过程。

问题设定:强化学习与奖励假说

在探讨解决方案之前,让我们先明确问题的范畴。人工智能的根本问题,是设计一个能在世界中有效行动以达成目标的智能体。经典的强化学习问题与之本质相同,只是更具体地指出:目标由一个称为“奖励”(reward)的标量信号来定义,且世界是通用的、不完全已知的。这个世界可以是任何形态,从简单的网格世界到复杂的人类社会,它可以是随机的、非线性的、非马尔可夫的。在“大世界”中,状态空间实际上是无限的,其动态变化也呈现非平稳性。

在此,我想重申“奖励假说”(The Reward Hypothesis)的重要性。这个假说并非一个草率的选择,而是经过深思熟虑的理论基石。它主张:我们所说的一切“目标”和“目的”,其含义都可以被严谨地理解为对一个接收到的标量信号(即“奖励”)的累积和的期望值的最大化。

这个定义中的“期望值”、“累积和”等设定都经过了仔细推敲。“标量奖励”本身是一个伟大的思想,它以一种极为清晰的方式指定了目标,并已在人工智能、经济学、心理学、控制论等多个学科中得到广泛应用。长久以来,学术界不乏对其进行修改的尝试,例如引入约束、多目标、风险敏感性等概念。但我个人倾向于保持其简洁性,因为我追求的是概念上的清晰与简约。

真正的问题是:我们是否需要这些额外的复杂性来获得通用性?Michael Bowling 及其同事在一篇题为《为奖励假说正名》的论文中给出了有力的论证。他们证明,增加多目标、风险敏感性或约束等机制,并不会增加通用性。这从侧面验证了我们选择的正确性。此外,在另一篇《奖励即足够》的论文中,我们进一步论证了,在一个足够复杂的世界里,即使是简单的奖励信号也足以引出智能的所有属性。

OaK 架构的解决方案

现在,让我们转向解决方案,即架构本身。一个显而易见的起点是无模型的强化学习,智能体在运行时构建一个策略和一个价值函数。如果能从数据中构建自己的状态表示,就可以处理非马尔可夫问题。然而,一个更优的方案或许是建立一个世界模型,并利用该模型进行规划。

OaK 架构正是在这条演进路径上的又一次飞跃。其核心特点在于引入了辅助问题(或称子问题),并且每个子问题都拥有各自的价值函数和策略。此外,每一个子问题都将基于状态特征表示的不同组成部分。我们可以将状态想象成一个特征向量,而每个子问题都聚焦于该向量的不同维度。

该架构的核心可概括为在运行时并行完成的八个步骤。下文将对这些步骤逐一展开,并会反复审视这一整体框架。

学习主策略与价值函数:学习用于最大化主奖励信号的策略和价值函数。这类似于标准的强化学习。这一项可标记为“概念上已完成,但有待工程实现上的完善”,因为它依赖于我们尚未完全解决的持续深度学习问题。

生成新状态特征:从现有特征中生成新的、可能更有用的状态特征。这是一个核心挑战,我们稍后会详细讨论。

对特征进行排序:维护关于所有特征效用的元数据,并根据其重要性进行排序。

创建子问题:为排名最高的特征创建子问题。例如,若“身处演讲厅”被评估为一个重要特征,系统就会创建一个子问题,其目标是“在不损失过多主奖励的前提下,成功到达演讲厅”。

学习选项:为每个子问题学习一个解决方案,这个解决方案就是一个“选项”(Option),即 OaK 中“O”的来源。

学习选项模型:学习每个选项的转换模型,即预测执行某个选项后世界会发生什么。这是 OaK 中“K”(Knowledge)的体现,构成了高层次的世界模型。

使用模型进行规划:利用学习到的选项模型进行规划,以改进主策略和价值函数。

管理与维护:持续管理所有组件,评估其效用,淘汰无用部分,并不断生成新的组件。

子问题、玩耍与开放式抽象

在 OaK 架构中,子问题的创建是一个核心环节。智能体必须能够自己生成子问题,这一观点回应了关于好奇心、内在动机和辅助任务研究中的一系列关键开放性问题:子问题应该是什么?它们从何而来?智能体能否自己创造子问题?它们如何帮助解决主问题?OaK 的贡献在于,它对这些问题提出了一个统一的答案,并肯定了智能体自我创造子问题的能力,从而实现了开放式的抽象。

我们可以将其想象成一个“问题”与“解决方案”相互促进的循环:我们提出一个要解决的问题,然后去解决它;在解决问题的过程中,会创造出新的特征;这些新特征又成为新子问题的基础,而这些新子问题又必须被解决,从而催生更新的特征,如此循环往复,永无止境。

自然界中的“玩耍”(play)行为能为我们提供生动的启示。一只荡秋千的年轻猩猩,并非为了觅食,而很可能是被摇荡时的感觉所吸引,并试图复现和控制这种体验。一只虎鲸反复将浮标顶到背上,也显然是在探索和完善一个自创的目标。人类婴儿的玩耍更是如此,他们从一个物体转向另一个,了解其特性,感到厌烦,再转向下一个,逐步建立起对世界越来越丰富的理解。

这些行为的本质,可以被看作是智能体在为自己提出子问题——一些需要去了解、理解、预测和控制的事物。因此,子问题不能由设计者预先给定,它们必须由智能体在与世界的互动中自主创造,因为它们数量繁多且与具体环境高度相关。

那么,如何以一种领域无关的方式创造子问题呢?OaK 提出了一种具体机制,称为“尊重奖励的特征达成子问题”(Reward-Respecting, Feature-Achieving Subproblem)。当智能体遇到或创造一个新特征时(例如,听到摇铃的声音),它可以将其作为子问题的基础。这个子问题的目标是:在不损失过多主奖励的前提下,将世界驱动到一个该特征值很高的状态。

该目标的数学表达如下:

在这个方程中,智能体试图找到一个选项(策略 π 和终止函数 γ),以最大化一个期望值。该期望值包含三部分:1)执行选项期间获得的累积奖励 ∑R;2)终止时达成特征 i 所获得的额外奖励 κ·φᵢ(S_T),其中 κ 代表对该特征的渴望程度;3)终止时所处状态的价值 V(S_T),这确保了智能体不会为了达成子目标而陷入一个长期来看很糟糕的状态(例如,为了喝到咖啡而摔断腿)。

FC-STOMP:从特征到规划的演进路径

这个子问题创造机制,是 OaK 架构中一个更宏大流程的核心。我们可以将这个流程总结为一条五步走的演进路径,我们称之为 FC-STOMP:

特征构建 (Feature Construction):感知过程负责构建有趣的状态特征。

提出子任务 (posing a SubTask):基于高排名的特征,构建“尊重奖励的特征达成子问题”。

学习选项 (learning an Option):通过强化学习求解子问题,得到一个选项作为其解决方案。

学习模型 (learning a Model):学习这个新选项的转换模型,即预测其后果。

规划 (Planning):将新选项及其模型整合到已有的世界模型中,用于规划,从而改进整体策略和价值函数。

这五个步骤构成了一个发现与改进的闭环。所有依赖特征的步骤(如学习选项、学习模型、规划)都会向特征构建过程提供反馈,告知哪些特征被证明是有用的,从而引导新特征的生成。

在算法层面,学习选项的价值函数、学习选项模型等任务,都可以利用现有的、成熟的离策略(off-policy)通用价值函数(GVF)学习算法,如 GTD、Emphatic TD、Retrace、ABQ 等。规划过程则可以被视为价值迭代(value iteration)的近似。有趣的是,使用选项模型进行规划,其数学形式与传统的基于单步动作的价值迭代惊人地相似,只是将“动作”替换为了“选项”,将“单步奖励”替换为了“选项执行期间的累积奖励”。这使得“任何可以被学习的东西,也同样可以被规划”这一原则得以实现。

面临的挑战:持续学习与特征生成

尽管 OaK 架构为我们描绘了一幅清晰的蓝图,但仍有两个关键的技术挑战有待攻克。

1. 可靠的持续深度学习:OaK 的所有组件都要求能够持续学习。在线性和表格情况下,我们已有可靠的方法。但在非线性的深度学习场景中,灾难性遗忘(catastrophic forgetting)和灾难性可塑性丧失(catastrophic loss of plasticity)等问题依然存在。尽管目前有持续反向传播(continual backpropagation)等一系列解决方案正在涌现,但这仍是一个活跃且尚未完全解决的研究领域。

2. 新状态特征的生成:这个问题,也被称为“表示学习”或“新术语问题”,历史悠久,可追溯至上世纪 60 年代。尽管反向传播被认为部分解决了这个问题,但它并非万能。除梯度下降外,大多数方法都遵循“生成与测试”的范式:生成大量候选特征,然后通过评估其在解决问题中的效用来进行筛选。我认为,诸如 IDBD 这类根据每个特征的个体学习情况来调整其学习率的元学习算法,将是解决这一问题的关键部分。我相信,这个问题有望在未来几年内取得突破,届时将彻底改变我们使用深度学习的方式。

结论与展望

OaK 架构的构想,是否成功回应了我们最初设定的远征目标?它在设计上是完全领域通用的,不包含任何针对特定世界的内容;它完全是经验性的,所有知识和能力都从运行时经验中成长;并且,它致力于实现无限的、开放式的抽象发现,其唯一的限制是计算资源。

我认为,强化学习与 OaK 架构为人工智能领域的几个根本性问题,提供了第一个合理的、机制性的答案:

知识的起源:高层次的知识如何从低层次的经验中学习而来?

概念的形成:概念从何而来?它们可以被视为为了解决自创子问题而形成的内部表示。

推理的本质:什么是推理?或许它就是基于学习到的高层次世界模型进行的规划。

玩耍的目的:玩耍的目的是什么?是为了发现和构建认知基石的子问题。

感知的意义:在没有人类标签的情况下,感知如何运作?感知可以是为了解决子问题而形成的概念化过程。

对于从事强化学习研究的 AI 科学家而言,OaK 提供了一个思考人工智能各个部分如何协同工作的框架,能够指导未来的研究方向。它提出了一个关于如何用学习到的模型进行规划的构想,这正是当今 AI 所缺失的关键能力。它提供了一种植根于经验和认知,而非匹配人类标签的感知观。最重要的是,它为强化学习中的“发现”问题——即子问题、选项和特征从何而来——提供了纲领性的答案。

综上所述,OaK 是一个关于如何获得一个完全从经验中成长起来的、开放式的超级智能的构想。它描绘了一个在运行时从经验中培育超级智能的蓝图,整合了行动、学习、规划、模型学习、子问题和选项等核心能力,并结合了函数逼近、部分可观测性、非平稳性等现实挑战。所有这一切,都在一个良性的、开放式的发现循环中协同工作:状态特征的发现,激发了问题、选项和模型的发现,而这些新产生的组件又反过来促进了新的、更抽象特征的形成。作为一个完全通用、不含任何领域特定组件的架构,OaK 具有强大的可扩展性,并有望对人工智能的未来产生深远而持久的影响。

【活动分享】2025 全球机器学习技术大会(ML-Summit)北京站将于 2025 年 10 月 16-17 日在北京威斯汀酒店举办。大会共 12 大主题、50+ 海内外专家,聚焦大模型技术和应用变革。详情参考官网:https://ml-summit.org (或点击原文链接)。