打造一个有温度、有趣味、专业的全栈式AI&AIGC交流社区,

用心写好每一篇文章!

项目主页-https://kaijwang.github.io/odyssey.github.io/

代码链接-https://kaijwang.github.io/odyssey.github.io/

论文链接-https://arxiv.org/pdf/2508.08240

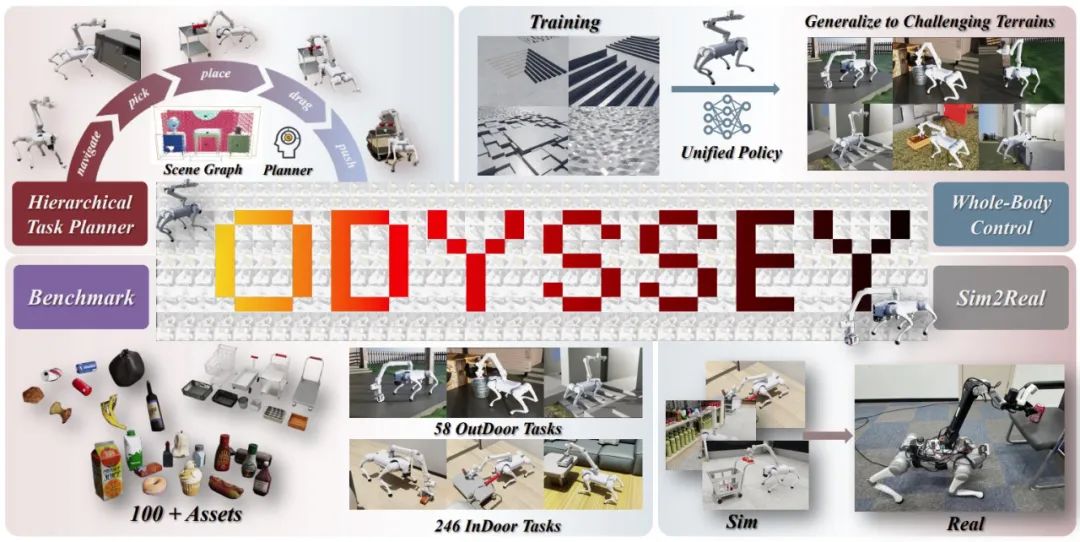

01-ODYSSEY核心优势

ODYSSEY是一个面向配备机械臂的敏捷四足机器人的统一移动操控框架,它将高级任务规划与低级全身控制无缝集成。

为了应对语言条件任务中以自我为中心的感知挑战,作者引入了一个由视觉语言模型驱动的分层规划器,实现了长视域指令分解和精确动作执行。在控制层面,其新颖的全身策略实现了在复杂地形中运动和操控的稳健协调。

除此之外,作者进一步提出了第一个全面的长视域移动操控基准测试,包含各种室内外场景。

02-ODYSSEY落地场景

上面的视频展示了机器狗在一些户外仿真场景下的效果。它可以帮人们完成“收拾庭院”、“把咖啡放在桌子上”、“庭院巡逻”等一些简单&重复&无聊的工作。

03-ODYSSEY软硬件配置

03.01-ODYSSEY软件架构

ODYSSEY涵盖了长期任务的整个过程,包括多模态语义感知、地图感知、全局规划、几何约束动作基础以及通过学习到的低级策略逐步执行。它包含三个关键组件:

从粗到精的任务规划器:一个分层规划器,在基础模型的指导下协调自上而下的任务执行。

四足机器人全身策略:一个基于强化学习的全身控制器,可泛化至各种地形并克服模拟与现实之间的差距。

移动操控基准:第一个可扩展的评估套件,用于评估各种真实场景中长期任务的表现。

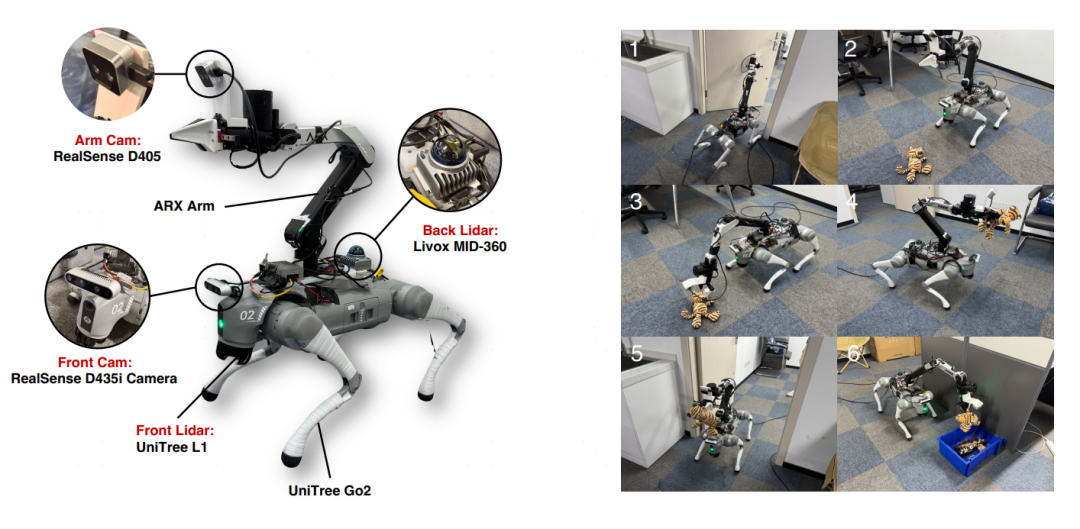

03.02-ODYSSEY硬件架构

如上图所示,整个机器人平台由一个 12 自由度的 Unitree Go2 四足机器人和一个 6 自由度的 Arx5 机械臂组成。Go2(重量 15 公斤,有效载荷 8 公斤)内置 Unitree L1 激光雷达,3.35 公斤的 Arx5 机械臂安装在其背部。

为了实现高级感知,该平台配备了一个 MID-360 激光雷达用于定位,以及两个 RealSense 摄像头:一个头戴式 D435i 用于 RGB 图像,另一个安装在夹持器上的 D405 用于 RGB-D 数据。控制策略以 50 Hz 运行,PD 控制器以 200 Hz 发出电机指令。下面的视频展示了真实的机器狗在真实场景中的表现效果。

04-ODYSSEY基准性能评估

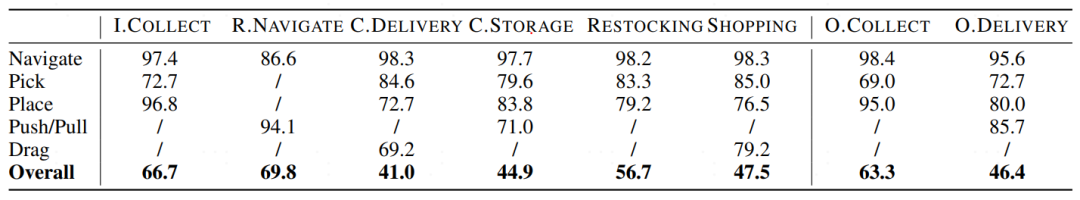

ODYSSEY Benchmark 是首个专为长视域移动操控设计的仿真平台,其主要特点如下:

1)该基准测试包含 8 个多阶段任务,旨在评估具体化移动操控的完整流程,涵盖感知、规划、导航和操控。

2)每个任务包含 2-3 个子目标,涵盖不同的对象类型、空间布局和物理交互模式,以反映现实复杂的场景。

3)ODYSSEY 涵盖室内和室外环境,拥有 300 多种任务变体和众多独特资源,以确保稳健的泛化能力。

4)详细的任务配置支持在各种实际挑战中对系统性能进行全面的基准测试。

上表展示了ODYSSEY在8项长期任务的总体成功率(%),以及每项任务的每个行动的成功率。通过观察与分析,我们可以发现:该方法在8项不同的任务上面获得了高达70%的成功率,未来可期。其实机器狗只是一个会运动的载体而已,如果将其这个能力平移给其它的硬件平台,就可以解决很多现实场景中的问题。

关注我,AI热点早知道,AI算法早精通,AI产品早上线!

禁止私自转载,需要转载请先征求我的同意!

欢迎你的加入,让我们一起交流、讨论与成长!