在通往通用人工智能(AGI)的探索中,具身智能逐渐成为关键方向之一。相比于传统的预设动作序列不同,具身智能强调智能体与物理环境的交互与适应,聚焦于如何让智能体具备在物理世界中感知环境、理解任务、执行动作并反馈学习的能力。

而具身智能领域最重要的两个部分:大脑和小脑构成了具身机器人最重要的模块,如果类比于人,大脑负责思考感知(主导语义理解和任务规划),小脑负责执行(高精度的运动执行)。

国内外相关领域产业分析

近2年,许多具身明星团队陆续出来创业,成立了多家非常有价值的公司。星海图、银河通用、逐际动力等团队陆续从实验室走向商业和工业界,推动具身本体和大小脑技术的不断进步。

国内传统大厂,华为于2024年底启动“全球具身智能产业创新中心”,与乐聚机器人、大族机器人等企业合作,共同建设具身智能大脑、小脑等关键技术;京东自2025年5月以来连续投资智元机器人、千寻智能、逐际动力等多家公司,以强化其在物流科技与家庭服务场景中的效率与服务能力。此外,腾讯、蚂蚁集团、小米等科技巨头也积极通过战略投资与合作布局,加快构建具身智能产业生态。

国外方面,Tesla/Figure AI在工业与物流机器人应用上持续推进,而美国投资机构也积极支持 Wayve、Apptronik 等公司落地自动驾驶与仓储机器人。总体而言,国内企业以产业链投资与综合平台驱动具身智能落地,国外科技巨头则侧重基础模型、模拟环境与类人机器人原型研发,双方在该领域正加速进入关键竞赛阶段。

具身智能的技术演进

具身智能技术的发展经历了从低层感知到高层任务理解与泛化的持续演进,其核心目标是不断提升机器人在真实世界中自主感知、理解和行动的能力。

第一阶段:技术研究主要聚焦于抓取位姿检测(Grasp Pose Detection),通过点云或图像预测合适的末端执行器姿态,实现静态物体的抓取。然而这一阶段的策略多为单步决策,缺乏对任务上下文和动作序列的建模,难以胜任复杂操作任务。

第二阶段:技术研究逐步迈入行为克隆(Behavior Cloning)阶段,机器人可以借助专家演示数据学习从感知到控制的端到端映射,具备了模仿人类完成复杂任务的能力。但这一阶段也暴露出了泛化能力弱、误差累积、在多目标场景中表现不佳等问题。

第三阶段:2023年兴起的Diffusion Policy方法引入了序列建模的范式创新。它通过扩散模型生成整个动作轨迹,从而更好地捕捉任务执行中的时序结构与多样性,大幅提升了策略的稳定性与泛化能力。进一步地,2024年时随着大模型技术的发展,具身智能进入了Vision-Language-Action(VLA)模型阶段。这一阶段强调多模态协同与任务泛化能力的提升,代表性工作如 OpenVLA、RT-2、PI0 等。这些VLA模型融合了视觉感知、语言理解与动作生成模块,使机器人能够“听得懂人类指令、看得懂真实世界、做得出合理动作”。相比于前两阶段的方法,VLA不仅能完成复杂任务,还支持零样本或小样本的快速泛化,体现出从“感知+控制”向“感知+推理+行动”的范式跃迁。

第四阶段:进入 2025 年以来,业界与学界开始进一步探索 VLA 模型与强化学习(RL)、世界模型(World Model)、触觉感知(Tactile Sensing) 等模块的融合,试图弥补当前VLA模型“只能理解不能反馈”、“只能关注当下不能看见未来”“只能看不能触”的局限。

VLA +强化学习的结合提升了机器人在长时任务中的试错能力与自我改进能力;VLA+世界模型引入环境动态预测,使机器人具备“想象未来”的能力,有助于更高效地进行规划与决策;而VLA+触觉信息的加入,则拓展了从“看”到“看+触多模态融合”的具身感知边界,推动机器人在复杂、非结构化环境下实现更精细、更安全的操作。

从抓取位姿检测到行为克隆、再到扩散策略与VLA模型的演进,标志着具身智能技术正从“低层感知->中层策略->高层理解”的链条上不断补齐能力短板,逐步迈向通用任务和开放环境的智能体时代。而这些技术领域的发展造就了各类产品的落地,特别是人形机器人、机械臂、四足机器人。服务于工业、家居、餐饮、医疗康复等各个领域,相关的产品和融资络绎不绝,岗位更是呈现爆发式增长。这也导致了许多同学不断转入具身智能领域,开始相关方向的研究。

然而,整个具身大脑+小脑算法较多,想要成体系的学习非常困难,许多同学甚至搞不清楚有哪些知识体系。一直原地踏步,久久不能入门。更有甚者,无法区分具身大脑与小脑的概念。为此,我们联合业内知名具身智能算法专家,为大家梳理了一套完成的具身大脑+小脑算法体系,并配有大量的实践。助力学习与落地,无论是初学者还是需要进阶的同学都能受益!

具身大脑与小脑全栈教程

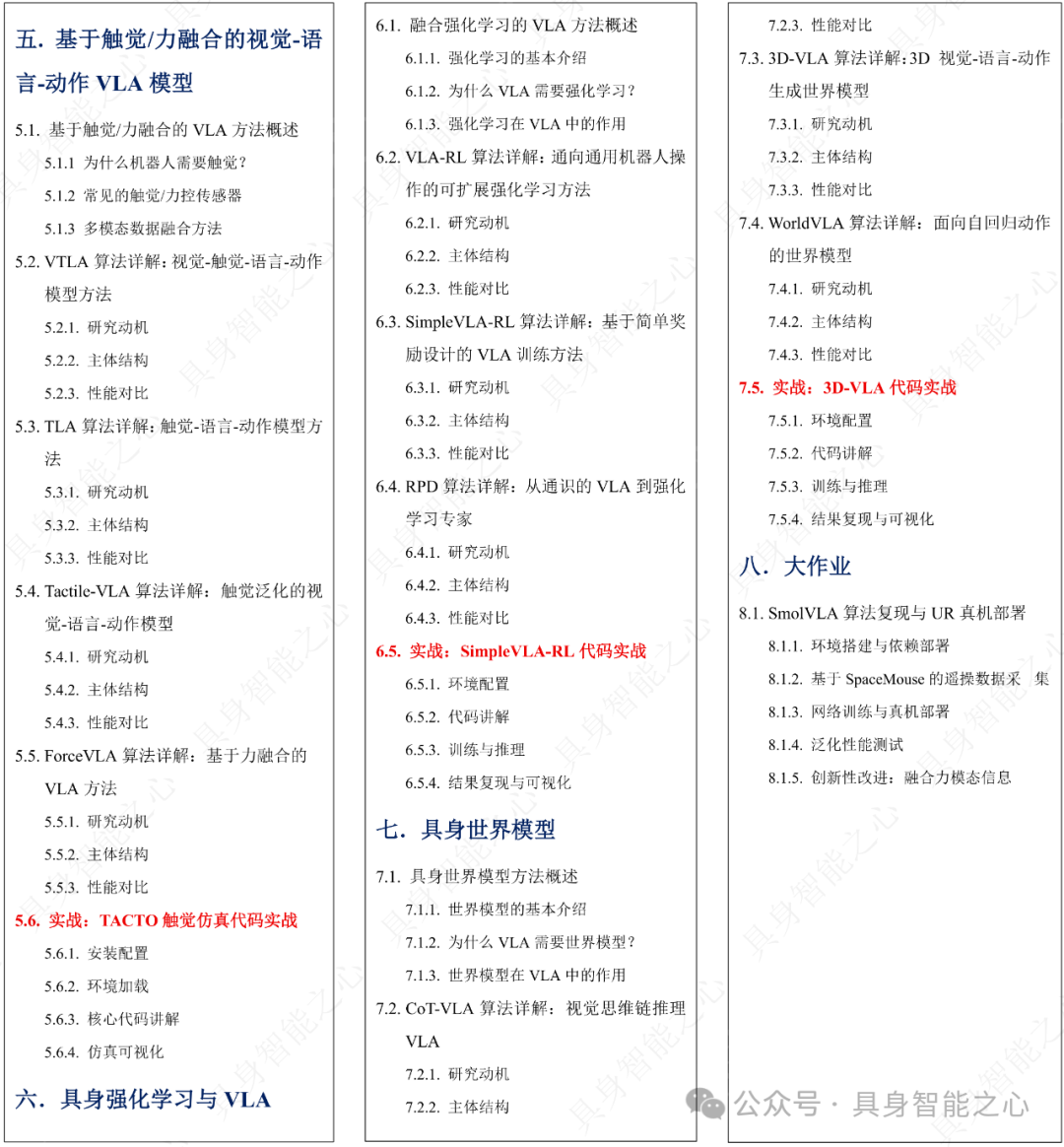

我们为大家梳理了从灵巧操作、移动操作的基础任务->具身仿真体系与框架->Diffusion Policy->VLA->VLA+触觉->VLA+强化学习->具身世界模型等领域。每个模块都配有实战,后面更有大作业监督大家成果与学习内容。大纲一览如下:

从研究走向落地,工程与系统能力需求激增。随着产业界的重视,具身智能从“论文”走向“部署”,对工程能力提出更高要求,本课程目标与面向内容:

如何在Mujoco / IsaacGym / Pybullet等平台完成策略训练与仿真测试?

如何训练并部署Diffusion Policy / VLA / 力触融合的VLA模型?

如何实现强化学习在VLA后训练上的应用,支持机器人的反馈微调?

如何实现从世界建模预测→策略学习→物理执行的一体化具身智能架构?

基础要求

熟悉具身智能基本功能和任务,对具身领域有较大的学习兴趣; 一定的Python和Pytorch基础,显卡3090ti及以上算力;

适合人群

具身算法领域的从业人员,需要进一步进阶提升; 从事VLA/RL、移动操作、世界模型相关方向研究的本科、硕士、博士生; 希望从传统计算机视觉(CV)或自动驾驶领域转行进入具身智能的专业人士; 对具身智能领域感兴趣的其他人员;

学后收获

能够掌握具身大脑+小脑算法的全体系知识点,熟悉如何优化自己模型; 能够掌握仿真、DP、VLA、VLA+RL模型的基本原理和实际应用; 掌握基于触觉信息的VLA主流方案,以提升机器人系统的智能化水平; 熟悉世界模型在具身智能领域中的应用; 获得实用的技能,包括模型训练、数据处理的基本方法; 无论是工程落地还是科学研究都能有所收获; 学习课程后,达到1-2年左右具身算法从业者的经验;

开课说明

本课程线上离线视频教学+vip群内答疑,由于为虚拟商品,购买后不支持退款,购买后1年内支持反复观看!9.15正式开课。

咨询我们

扫码学习课程

咨询小助理了解更多