点击下方卡片,关注“自动驾驶之心”公众号

不及预期的diffusion多模态轨迹输出,能否胜任自动驾驶Action的角色?

不及预期的diffusion多模态轨迹输出,能否胜任自动驾驶Action的角色?

——自动驾驶之心团队

目前自动驾驶VLA占据行业量产的主流地位,以理想、小鹏为代表的新势力智驾已经完成了从端到端到VLA的范式转变。而以华为、蔚来的世界模型-行为(World Action)则是另一个流派,聚焦于直接建模视觉信息到Action的输出。

但无论是VLA还是WA,业内目前普遍都遇到了diffusion多模态轨迹输出不及预期的问题。

这就引发了业内对Action新一轮的思考,今天自动驾驶之心为大家分享 - 从端到端到 VLA一览自动驾驶范式的演进、现状与未来。

一、端到端:让感知直接驱动控制

“端到端”自动驾驶网络把激光雷达、摄像头等原始传感器输入,直接映射为方向盘和踏板控制量,省去了传统“感知—预测—规划—控制”级联链路,从而最大限度地保留传感信息、提高系统上限。典型的端到端闭环包含:数据采集→模型训练→仿真/实车验证。

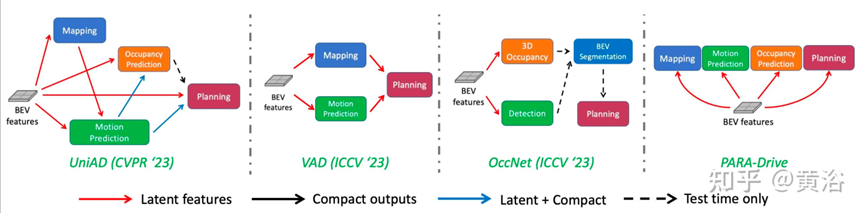

图一描绘了端到端网络结构的迭代:从串行到并行、从单任务到多任务,整体趋向“高并行、低耦合”的设计。

在迭代实践中,工程师通常先对 bad case 做场景聚类,再补标数据或增训样本。为了降低模仿学习的难度,训练一般会拆成多阶段:先独立训练 BEV 感知模块,再端到端联合微调。然而,每一次更新都免不了重训部分子网,导致“治好了旧病、引入新病”。为控制风险,业界普遍采用“仿真 + 实车”双重回归测试。

特斯拉提出的“日更模型”给这一痛点提供了新思路:

每天把筛选后的 bad case 转成训练样本; 以上一版本模型为 warm-start,做轻量级微调; 让 bad case 进入“数据飞轮”,实现 7×24 的持续进化。

这里的核心挑战是:既要保持既有能力,又要把新知识“无缝”注入。这里业内的解决思路是借鉴强化学习思路,在 ref model 与 RL loss 之间做动态平衡,同时精细调配数据配比。

二、端到端 + VLM:双系统时代的萌芽

2023 年,LLM 的 Scaling Law 启示了自动驾驶:当参数量与数据量同步放大时,大模型在 zero-shot/few-shot 场景下也能表现出惊人泛化。于是,“端到端 + VLM(Vision-Language Model)”的双系统方案迅速升温。

早期的 VLM 主要解决“特殊语义”——OCR 识别公交车道文字、潮汐车道箭头、施工区域告示、ETC 提示语等。图 3 所示的 EMMA 架构在 VLM 基础上引入了链式推理(reasoning),开始尝试用自然语言的“思考过程”辅助控车。至此,“VLA(Vision-Language-Action)”呼之欲出。

VLA + Diffusion:多模态轨迹生成的新范式

VLM 本质在离散空间建模,而轨迹是连续高维分布;Diffusion 的多模态建模能力恰好填补这一空白。图 4 所示的 DiffVLA 框架融合了 DiffusionDrive 与 GoalFlow 思想:

VLA 显式输出 Driving Command; 该 Command 作为 initial noise 与 condition,送入 Diffusion 解码器; Diffusion 最终生成安全、平滑的车辆轨迹。

上面介绍的是从端到端发展到VLA+端到端双系统,再到VLA+diffusion的必要性以及历程。下面是自动驾驶之心团队对于目前现状和未来的发展趋势一些自己的看法。

未来

现在的VLA+diffusion架构由于自动驾驶的数据多样性和复杂性,主要的问题在于:

第一,不及预期的多模态轨迹输出。在开放道路的自动驾驶里,想把多模态能力真正“训”出来几乎成了奢望:系统看似能给出多条候选轨迹,实则掺杂大量随机扰动,可控性远逊于预期。反观 Diffusion Policy,其成功建立在固定工位、有限操作的机器人场景之上;而自动驾驶面对的是瞬息万变的道路环境,训练数据天然稀疏且分布极不均衡,想用同样的办法同时覆盖“万景万态”,难度系数直线上升。 第二,脑裂问题。VLA和diffusion双系统都是学习的人驾轨迹,相当于有两个大脑,可能会存在矛盾的场景,虽然会联合训练,但是还是有VLA错误的场景,diffusion会试图通过自己的学习来弥补,从而造成两个大脑之间各有各的想法。 第三,单模态轨迹质量不佳。生成加打分的范式,对于生成器的效率和准确性要求较高,如何在有限的计算资源里生成覆盖全场景安全且合理的轨迹以及挑选出来。 第四,LA之间没有对齐。语言模态(L)究竟能在自动驾驶里发挥多大价值,仍是一个悬而未决的问题。众所周知,GPT 在开放问答时常常“信口开河”,幻觉一旦出现在方向盘上,代价将是不可接受的。引入 L 的初衷是强化导航决策:让系统“听懂”自然语言指令,从而保持在正确车道、自动绕过施工区。但机器人需要 VLA,是因为它们必须在无高精地图的环境里识别电梯口、出口等语义目标;而自动驾驶先天坐拥图商的车道级导航,这些能力靠端到端网络即可学得,未必需要额外请出“语言大模型”。如果仍想借 L 的泛化红利,核心挑战是“LA 对齐”——把抽象语言精准映射到三维空间关系。目前,华为等厂商坚持纯端到端路线,理想等公司则押注 VLA 有望突破现有上限。鹿死谁手,唯有时间作答。

针对上面的一些问题,自动驾驶之心团队认为后续的工作方向会是:

第一,需要一个能够scaling的系统方案,双系统并不是很适合做scaling,充分发挥数据优势还是应该触发模型的scaling能力; 第二,强化学习加强基础模型的能力,强化学习在很多场景很多公司已经取得还不错的应用,但是强化学习效果和基础模型的建模方式强相关,连续空间内的强化学习自由度太高了,很难调出好的效果,所以轨迹模型的建模形式需要设计一下; 第三,“生成 + 打分”范式在 PDM 中已验证高效,但“生得多”不等于“生得好”。下一步的重点是让每条轨迹先“自我反思”再出厂:DiffusionPlanner 用奖励场函数做二次优化只是起点,后续还将持续迭代更多“反思”手段,把单条轨迹的质量推到极致。