目前论文已经被 EMNLP 2025 主会录取,同时模型已经开源

论文: https://huggingface.co/papers/2509.01215

Github: https://github.com/Tencent/POINTS-Reader

HuggingFace: https://huggingface.co/tencent/POINTS-Reader

Demo: https://huggingface.co/spaces/prithivMLmods/POINTS-Reader-OCR

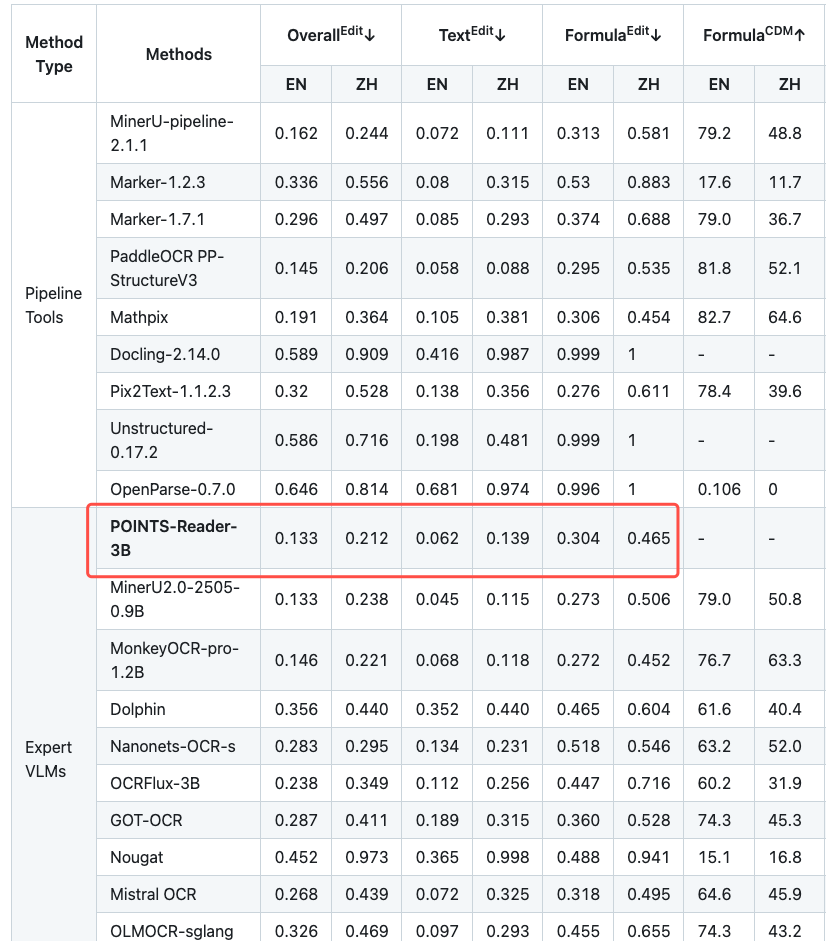

在论文投稿后,我们利用文章中提出的方法持续对模型进行优化,当前在 OmniDocBench 上取得了领先的优势。

介绍

在当今的信息社会,PDF文档是互联网信息传播的重要形式。然而,如何有效地将这些文档内容转换为便于使用的格式一直是一个挑战。这些PDF文档常常蕴含丰富的信息,同时格式也多种多样,包括正文、数学公式和表格等。现有的文档提取方法主要可以分为三类:

1. 传统解析方案:工具如PyMuPDF在解析过程中可能无法准确保留复杂结构,例如数学公式的精确特征,这常导致提取出的文本伴有大量的噪声。 2. pipeline 方案:例如MinerU和Mathpix,这些方法通过集成多个专有模型,可以取得较好的效果。然而,最终的提取效果受限于单个模型的表现,而且优化起来较为繁琐。 3. 端到端方案:端到端方案为文档信息提取提供了一条简洁、高效的路径,它通过直接优化视觉-语言模型来完成任务。然而,这一方案的成败严重依赖于训练数据的质量和规模,而这恰恰是其最大的瓶颈。目前,数据获取方式存在一个两难困境:要么选择成本高昂且难以扩展的人工标注,要么依赖于从现有模型采集数据,但这又面临着继承其原有偏见(bias)的风险。

在端到端方案中,POINTS-Reader提出了一套高度可扩展的数据生成方案,包含两个核心阶段:统一格式预热阶段(Uniform Format Warm-up Stage)和迭代自我改进阶段(Iterative Self-improvement Stage)。这种方法不仅提升了文档提取的效率,还为后续优化提供了坚实的基础。

模型效果

话不多说,我们先来看看模型的提取效果:

单栏 + 数学公式

单栏 + 表格

双栏 + 数学公式

双栏 + 表格

模型特色

1. 简洁性:POINTS-Reader 是一个非常精简的模型,它保持了与 POINTS1.5 相同的架构,唯一的改动是将 Qwen2.5-7B-Instruct 替换为了 Qwen2.5-3B-Instruct。此外,它的输入和输出都极其简单直接。输入由一个固定的提示(prompt)和一张文档图片组成,输出则是一个单一的字符串(即从文档图片中提取的文本)。模型的输出就是交付给用户的最终结果,无需任何后处理。 2. 性能:POINTS-Reader 目前支持提取中文和英文两种文档,并取得了非常惊艳的效果,在 OmniDocBench 基准测试上,其英文得分为 0.133,中文得分为 0.212。 3. 高吞吐量:在当前主流的推理框架(如 SGLang 和 vLLM)中,优化主要集中在大型语言模型(LLM)上。因此,一个大的 ViT(视觉 Transformer)可能会成为一个显著的吞吐量瓶颈,这也是我们选择一个中等规模 ViT(POINTS1.5 中使用的 6 亿参数的 NaViT)的原因。结合我们对 SGLang 的原生支持,我们目前实现了非常高的吞吐量。未来我们也将增加对 vLLM 的支持。 4. 开源技术方案:在 POINTS-Reader 的论文中,我们提出了一种两阶段的数据增强策略。第一阶段利用自动生成的数据,为模型赋予基础的文档提取能力。在随后的阶段,通过一个持续的自我演进过程来提升模型生成数据的质量。这种第二阶段的自我演进方法具有高度的可扩展性,几乎可以应用于任何模型。

方法

当前,多数端到端模型的训练依赖于私有模型(如GPT-4o)的蒸馏数据。该方法主要面临两大挑战:一是继承教师模型的内在偏见(bias),二是自身迭代受限于外部模型的更新。为解决这些问题,我们提出一种完全不依赖蒸馏数据的两阶段训练方案。

第一阶段:统一格式预热阶段 (Uniform Format Warm-up Stage, UWS)

目标是为模型打下坚实的基础,使其能够处理各种文档元素。

1. 统一输出格式:为了简化模型学习,论文为不同类型的文档元素定义了统一的输出格式:

• 纯文本:使用Markdown格式。 • 表格:使用HTML格式(能处理合并单元格等复杂结构)。 • 数学公式:使用LaTeX格式(行内公式用 $...$,行间公式用$$...$$)。

• 使用一个大语言模型(LLM,如Qwen2.5-72B),根据特定的提示(Prompt)生成包含纯文本、含公式的文本、含表格的文本以及多栏布局文本的多样化内容。 • 对生成的公式和表格进行基于规则的过滤(如语法检查)。 • 将过滤后的内容使用HTML模板渲染成图像,并与原始文本配对,形成“图像-文本”对。

第二阶段:迭代式自我提升阶段 (Iterative Self-improvement Stage, ISS)

目标是将第一阶段在合成数据上训练的模型,自适应地迁移到真实世界文档上,并持续提升模型和数据质量。

1. 模型标注:使用第一阶段训练好的模型去自动标注一个大规模的真实文档数据集(如DocMatix)。 2. 数据过滤:对模型生成的标注结果应用一套精心设计的、基于规则的过滤策略,以自动验证和筛选高质量的数据:

• 纯文本过滤:计算模型输出与传统OCR(如PaddleOCR)结果的F1分数,仅保留分数高于阈值(如0.9)的样本,以减少遗漏、幻觉和重复。 • 表格过滤:检查表格结构的有效性,例如确保每行的单元格数量一致,以去除结构错误的表格。 • 公式过滤:检查LaTeX公式的语法是否正确,以去除语法错误的公式。

总结来说,该数据生成方案的核心创新在于:

● 无需蒸馏:完全避免了对昂贵或闭源的教师模型的依赖。

● 自动化闭环:通过“合成数据预热 + 真实数据自我提升”的两阶段设计,构建了一个自动化的数据-模型协同进化闭环。

● 规则化过滤:利用简单但有效的规则对模型自生成的数据进行质量控制,使得模型能在没有人工标注的情况下,利用真实世界数据持续进步。最终我们得到了 POINTS-Reader,在多个基准测试上达到了甚至超过了更大模型的性能。

实验

更强的性能

可以发现,POINTS-Reader 在 OmniDocBench 和 Fox 上都取得了不错的效果,甚至超越了一些私有模型和更大尺寸的模型

消融实验

为了让实验具有更高的可信度,我们对训练 POINTS-Reader 中的每一步进行了详细的消融,下面我们选取几个重点的实验进行展示:

Uniform Format Warm-up 阶段,更好的数据多样性,更好的模型性能

从上表可以发现,当我们使用更丰富的元素和布局,模型的性能呈现出一个持续变好的趋势。

Iterative Self-improvement 阶段,过滤的手段至关重要

可以发现,在这个阶段对模型生成的数据从各个维度进行过滤,例如表格、公式,可以显著提升数据的质量,从而提升模型的性能。

Iterative Self-improvement 阶段,随着迭代次数多增加,数据的质量和模型的性能也持续提升

从上图可以看出,随着迭代的进行,数据的质量在持续的提升(F1-score 不断增加),但是增长的数据变缓了。同时,随着数据质量的提升,训练得到的模型的性能也不断提升,可以从 OmniDocBench 上不断增长的性能可以看出来

除此之外,我们可以发现,随着迭代次数多增加,我们过滤得到的数据数量也是不断提高,也进一步说明数据质量的提升。

总结

本工作提出了一种全自动化的两阶段数据构建方案。第一阶段,通过统一格式的数据进行预训练,使模型初步掌握文档元素的结构化解析能力。第二阶段,我们引入“标注-过滤-再训练”的迭代循环,驱动模型性能的持续优化。最终,我们成功构建了一个性能卓越的端到端文档解析模型。该方案具有高度的可扩展性,可应用于任何模型高效生产训练数据,并通过自迭代机制实现性能的持续提升。

-- 完 --

机智流推荐阅读:

1. LangChain 新一代记忆管理:RunnableWithMessageHistory 全面解析与实战

2. IJRR2025|万字长文解读视觉RL在多目标操作中的痛点与ASIMO的突破

3. 128K上下文+100轮工具调用!港科大联合MiniMax推出WebExplorer-8B,登顶6大信息检索基准

关注机智流并加入 AI 技术交流群,不仅能和来自大厂名校的 AI 开发者、爱好者一起进行技术交流,同时还有HuggingFace每日精选论文与顶会论文解读、Talk分享、通俗易懂的Agent知识与项目、前沿AI科技资讯、大模型实战教学活动等。

cc | 大模型技术交流群 hf | HuggingFace 高赞论文分享群 具身 | 具身智能交流群 硬件 | AI 硬件交流群 智能体 | Agent 技术交流群