现有视觉 - 语言 - 动作(VLA)模型虽能理解复杂指令、识别环境,但决策仍局限于 “看到什么就做什么” 的即时反应。

上海 AI 实验室与哈尔滨工业大学(深圳)的 F1 模型实现重大突破,将传统的反应式状态 - 动作映射转变为预见引导的逆动力学建模,借助 Mixute of Transformer(MoT)架构,把理解、预见和执行统一,赋予机器人基于未来视觉状态规划行动的能力。

VLA模型的演进

VLA发展的3个关键阶段

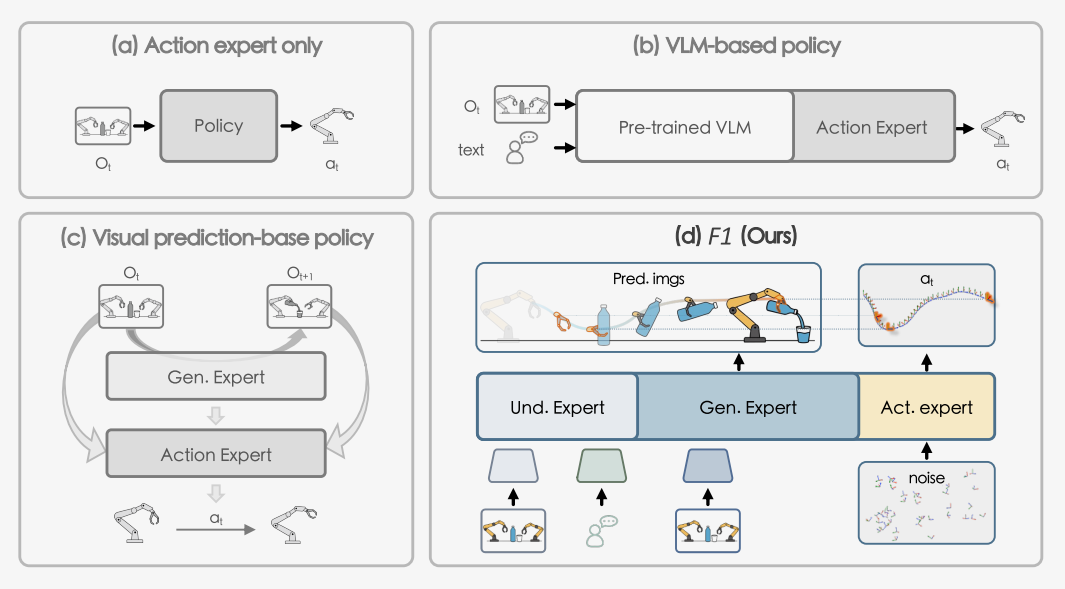

VLA模型的发展经历了三个关键阶段,每个阶段都有其独特贡献和固有局限:

端到端动作专家阶段

代表性工作如ACT、DP等,采用直接的观察-动作映射策略。这类方法虽然结构简洁,但缺乏语义理解能力,在面对复杂任务时泛化性能严重不足。

VLM集成阶段

通过引入预训练视觉-语言模型(如π0、GROOT N1),显著提升了场景理解和指令解析能力。然而,这些方法本质上仍是反应式的,缺乏对环境演化的预测能力。

视觉预测阶段

代表性研究(如VPP、Genie Envisioner)开始尝试预测未来观察状态,向前瞻性决策迈出了重要一步。但这些方法在语义理解和预测质量之间存在明显的权衡问题。

▲图1|操作策略不同范式的比较。最早的端到端操作策略如图1(a)所示;图1(b)显示的策略引入了VLM;还有一些方法如图1(c)所示,利用视频扩散模型通过视频预测来指导动作执行;如图1(d)所示,我们采用了理解、生成和执行的集成架构,为动作执行模块提供场景和指令理解以及动态时间预测的能力。©️【深蓝具身智能】编译

核心技术瓶颈的深层分析

现有VLA模型面临三个根本性挑战:

反应式决策的短视性成为最大障碍。

传统的状态-动作映射无法进行长期规划,导致机器人在复杂任务中表现出明显的短视行为。

动态环境适应性不足暴露了静态训练假设的脆弱性。

当环境条件偏离训练分布时,基于固定模式训练的模型往往出现性能急剧下降。

语义理解与时间建模的割裂阻碍了统一架构的形成。

现有方法要么专注语义理解而忽视时间动态,要么关注预测能力而缺乏语义基础。

F1的创新架构设计

三专家协作的智能决策系统

F1采用了精心设计的三专家混合Transformer架构,每个专家承担特定的认知功能:

▲图2|F1框架概览。它采用了混合变换器架构,包含三个核心组件:理解专家、生成专家和动作专家。©️【深蓝具身智能】编译

理解专家(Understanding Expert)

继承π0的预训练权重,专门负责建立自然语言指令与视觉观察之间的语义对应关系。该专家通过SigLIP视觉编码器提取高层感知特征,并与语言表示进行深度融合,为后续的预见生成奠定坚实的语义基础。

生成专家(Generation Expert)

构成了F1的核心创新模块。该专家采用多尺度残差VQ-VAE编码策略,结合下一尺度预测机制,能够高效合成目标条件的视觉预见。生成的未来视觉状态不仅保持与当前环境的连贯性,更重要的是为动作规划提供明确的视觉目标。

动作专家(Action Expert)

实现了从预见到执行的关键转换。该专家基于当前观察、语言目标和生成的预见图像,通过预测性逆动力学建模生成短期动作序列。这种设计使得动作不再是对当前状态的被动反应,而是为实现预见目标的主动规划。

UGA渐进式注意力:信息流的精确控制

F1的UGA(Understanding-Generation-Action)渐进式注意力机制体现了对信息流的精确控制:

专家内注意力

采用双向机制,确保每个专家内部能够充分整合相关信息。生成专家例外地采用因果注意力,以保持自回归生成的一致性。

专家间注意力

严格遵循单向因果层次:生成专家只能访问理解专家的输出,动作专家可以访问前两者的信息,但信息绝不会反向流动。

这种设计的核心价值在于防止"信息泄漏"——确保动作信息不会影响预见生成,从而保证模型真正依赖视觉预测进行规划,而非利用隐含的动作线索。

三阶段渐进式训练策略

F1采用了精心设计的三阶段训练方案,"循序渐进"的具象化:

阶段I:预见能力注入

冻结继承自π0的理解专家权重,专门训练生成专家学习视觉预见生成。训练目标为:

阶段II:联合能力整合

在包含33万条轨迹的大规模数据集上联合优化三个专家,建立通用的视觉运动知识。采用自回归下一尺度预测和流匹配动作预测的组合目标:

阶段III:任务特化适应

在特定任务演示上进行微调,使模型适应新的具身化平台和精细操作技能。

关键技术选择的设计逻辑

混合Transformer架构的选择

基于模块化与统一性的平衡考虑。每个专家在保持功能专业化的同时,通过共享的Transformer骨干维持架构一致性,既实现了任务特化又避免了架构复杂化。

下一尺度预测机制的采用

体现了计算效率与预测质量的巧妙权衡。通过多尺度残差VQ编码,F1避免了全分辨率预测的计算负担,同时保留了动作规划所需的关键视觉信息。

逆动力学重新表述

传统方法问的是"看到这个我该做什么",而F1问的是"为了达到那个状态我应该做什么"。这种问题重新表述从根本上改变了机器人的思维模式。

实验验证

大规模数据驱动的训练基础

F1在超过33万条轨迹的史无前例规模数据集上进行训练。

数据来源涵盖AgiBotWorld(187K轨迹)、LIBERO(1.7K轨迹)、OXE-Bridge-v2(5.32万轨迹)和OXE-Fractal(8.72万轨迹),跨越5种不同具身化形式和136个任务类别。

任务复杂度范围从10秒的简单抓取延伸到2分钟以上的复杂序列操作,为模型提供了丰富的学习样本和充分的泛化基础。

▲图3|真实世界机器人实验概览。我们在三个不同平台上进行了12个真实世界机器人实验:Genie-1、Franka和ARX LIFT II。Genie-1上的实验旨在评估模型处理任务多样性的能力。Franka实验评估模型的快速适应能力,而ARX LIFT II任务用于基准测试其在具有挑战性的长时序操作问题上的性能。©️【深蓝具身智能】编译

在Genie-1平台的9个真实任务中,F1展现了令人瞩目的性能优势。平均抓取率达到92.6%,任务成功率达到82.2%,而最强基线π0仅达到78.5%和65.2%的对应指标。

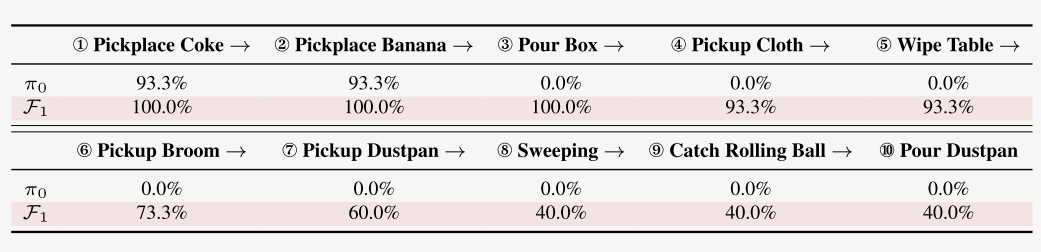

▲表1|真实世界任务的结果。我们对每个模型在每个任务上测试15次,并报告其平均成功率。最佳结果用粗体表示。实验结果显示我们的F1相比其他VLA模型具有优越性能,特别是在需要动态环境理解能力的交接(R2H)任务中。©️【深蓝具身智能】编译

实验发现:

复杂协调任务中的显著提升。在"机器人到人类交接"这一需要精确时空协调的任务中,F1成功率达到93.3%,相比π0的40%实现了超过两倍的性能提升。这一结果直接证明了视觉预见在处理动态交互任务中的核心价值。

仿真基准

▲表2|LIBERO基准测试结果。我们报告了四个套件的成功率(SR,越高越好)和排名(Rank,越低越好):LIBERO-Spatial、LIBERO-Object、LIBERO-Goal和LIBERO-Long,以及平均结果。最佳结果用粗体显示。©️【深蓝具身智能】编译

长时序任务的优异表现具有特殊意义。这类任务要求模型维持长期时间一致性并进行多步规划,正是传统反应式方法的薄弱环节。F1在此领域的突出表现验证了预见机制对于复杂规划任务的关键作用。

▲表3|SimplerEnv Bridge基准测试结果。对于每个任务,我们报告抓取成功率和整体任务成功率,捕捉精细控制和精确放置能力。最后一列显示整体平均分数,通过对所有任务的抓取和完整任务完成成功率求平均得到。最佳结果用粗体显示。©️【深蓝具身智能】编译

消融研究:组件价值的定量分析

系统性消融研究量化了F1各组件的贡献度:

▲表4|仿真基准的消融研究。我们设计了五个模型变体来验证F1不同组件的效果:(a) Frozen-Gen,(b) Cotrain-Scratch,(c) No-Gen,(d) 2-Scales,和(e) 6-Scales。©️【深蓝具身智能】编译

生成专家的核心价值

通过No-Gen变体得到最直接的验证。移除生成专家导致性能从77.5%急剧下降至60.3%,17.2%的性能损失充分证明了视觉预见的不可替代性。

预训练策略的重要性

在Cotrain-Scratch对比中得到体现。跳过大规模预训练导致3.3%的性能下降,表明广泛的机器人数据预训练为模型提供了重要的先验知识基础。

规划尺度的优化结果

显示4尺度预测达到最佳平衡点。2尺度信息不足,6尺度引入过多噪声,这一发现为实际部署提供了重要的配置指导。

极限场景验证:动态环境与长时序挑战

动态环境测试通过创新的传送带实验验证了F1的实时适应能力:

实验建立了一个带有移动传送带的厨房环境:

机器人必须根据语言提示抓取指定的食物,同时物体在传送带上连续移动。F1在运动目标抓取任务中达到66.7%的整体成功率,显著超越π0的33.3%。在"生菜"和"面包"抓取子任务中均达到80%的成功率,证明了视觉预见在处理动态目标时的独特价值。

▲图4|动态操作任务的可视化。©️【深蓝具身智能】编译

▲图5|动态操作任务结果。©️【深蓝具身智能】编译

长时序任务验证

该任务涉及十个连续步骤,跨越大约两分钟。每列报告15次试验中特定步骤的平均成功率。π0在前4个阶段之后表现困难,而F1在早期步骤中实现了持续的高成功率,并在后期更复杂的阶段保持了非平凡的性能。

▲表5|长时序任务中的逐步成功率。©️【深蓝具身智能】编译

预见质量分析

预见生成的多维质量评估

F1将视觉预见作为显式规划目标的设计需要严格的质量保证。研究者建立了三维评估体系:

▲图6|训练步骤中的生成质量。我们报告了生成质量在三个维度上的演变:场景一致性(左)、对象一致性(中)和任务进展跟随(右)。x轴表示训练步骤,不同的曲线对应不同的任务子集(AgibotWorld、Bridge、Fractal和LIBERO)。更高的分数表示生成的未来观察与真实任务进展之间更好的对齐。©️【深蓝具身智能】编译、

场景一致性

评估全局环境的布局、光照和纹理连贯性;

对象一致性

检验操作对象和机器人的身份及位置一致性;

任务进展跟随

验证生成帧是否描绘了合理的任务推进步骤。

预见质量与动作精度的相关性验证

关键洞察来自预见质量与动作可靠性的强正相关关系:

▲图7|图像和动作令牌准确性之间的相关性。它显示了四个LIBERO套件中图像令牌准确性和动作令牌准确性之间的关系。每个子图对应一个套件,动作准确性在不同容忍水平下报告(τ=0.01, 0.02, 0.05)。所有设置下一致的正相关关系表明,更高质量的视觉预见与改进的动作预测可靠性密切相关。©️【深蓝具身智能】编译

尽管图像令牌精度保持在相对较低的40-45%水平,生成的预见仍能为动作规划提供充足的任务相关线索。这一发现表明,任务级的合理性比像素级的视觉逼真度对控制系统更为重要。

图像令牌预测质量的提升与动作可靠性改进呈现高度相关性,验证了预见机制在动作生成中的有效传导作用。

定性结果的直观展示

定性分析展示了F1为各种操作任务生成合理下一步帧的能力,包括超市物品拾取、超市包装和折叠短裤。

▲图8|生成未来图像的可视化。©️【深蓝具身智能】编译

每行比较真实帧与F1的预测,展示了其在不同场景中的准确预见能力。预测帧在任务层面保持高度合理性,与真实轨迹呈现良好对齐。模型成功内化了任务逻辑的时间发展规律,而非简单的视觉模式记忆。虽然在精细对象细节方面存在局限,但这并不影响其为动作规划提供有效指导。

总结

F1模型实现了VLA领域的重要突破,首次成功将视觉预见能力集成到统一的决策框架中。通过三专家MoT架构、UGA渐进式注意力机制和三阶段训练策略的设计,F1使机器人获得了真正的"未卜先知"能力。

虽然在计算效率和预见精度方面仍有提升空间,但F1已经为具身智能的发展指明了极具前景的方向。未来的机器人将从简单的"反应机器"进化为具备真正规划能力的智能体,F1的成功标志着我们向这一目标迈出了关键步伐。

编辑|Jeffrey J

审编|具身君

论文题目:F1: A Vision-Language-Action Model Bridging Understanding and Generation to Actions

论文作者:Qi Lv, Weijie Kong, Hao Li, Jia Zeng, Zherui Qiu, Delin Qu, Haoming Song, Qizhi Chen, Xiang Deng, Jiangmiao Pang

论文地址:https://arxiv.org/pdf/2509.06951

代码开源:https://github.com/InternRobotics/F1-VLA

工作投稿|商务合作|转载

:SL13126828869(微信号)

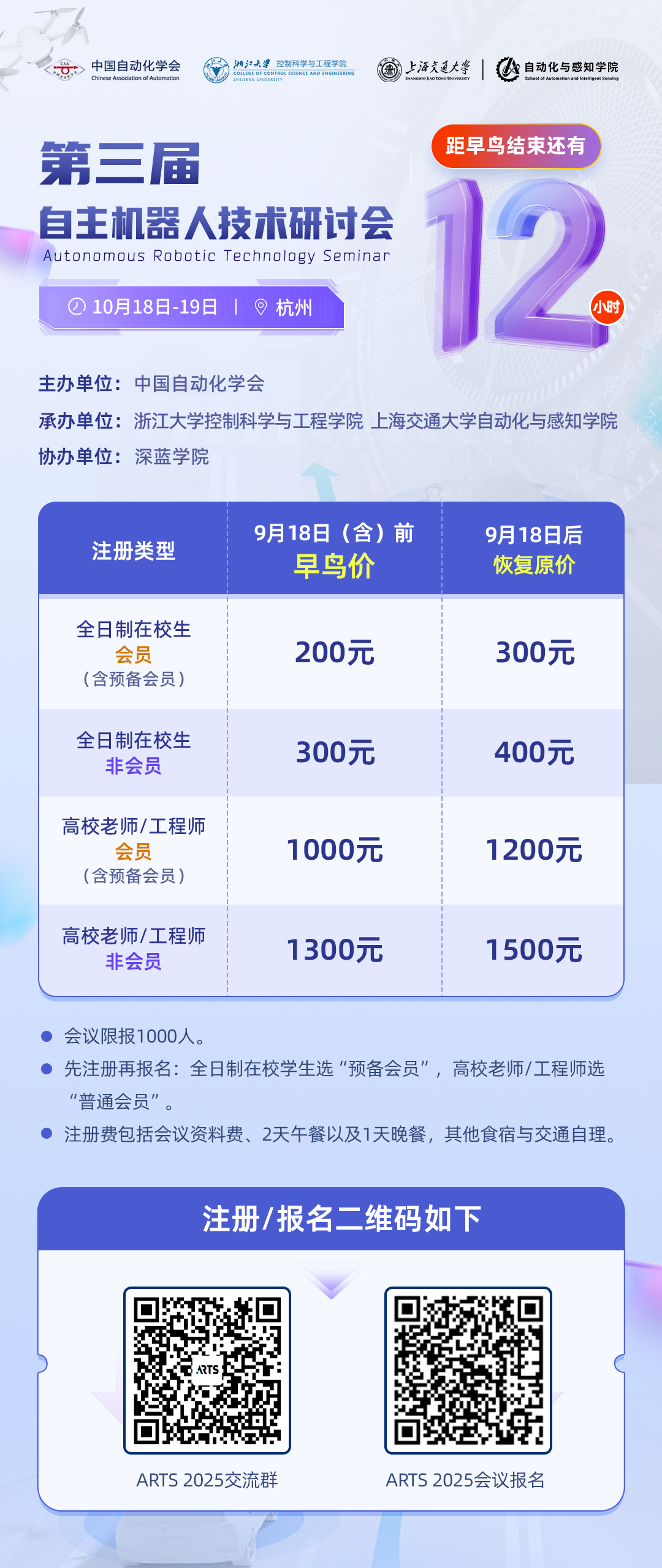

>>距ATRS 2025早鸟优惠还有【最后 12 小时】<<

为促进自主机器人领域一线青年学者和工程师的交流,推动学术界与企业界的深度交融与产学研合作,中国自动化学会主办了自主机器人技术研讨会(Autonomous Robotic Technology Seminar,简称ARTS)。

基于前两届大会的成功经验和广泛影响,第三届ARTS将继续深化技术交流与创新,定于2025年10月18日-19日在杭州举办。我们诚挚邀请您参加,并欢迎您对大会组织提供宝贵意见和建议!

【具身宝典】具身智能主流技术方案是什么?搞模仿学习,还是强化学习?|看完还不懂具身智能中的「语义地图」,我吃了!|你真的了解无监督强化学习吗?3 篇标志性文章解读具身智能的“第一性原理”|解析|具身智能:大模型如何让机器人实现“从冰箱里拿一瓶可乐”?|盘点 | 5年VLA进化之路,45篇代表性工作!它凭什么成为具身智能「新范式」?动态避障技术解析!聊一聊具身智能体如何在复杂环境中实现避障

【技术深度】具身智能30年权力转移:谁杀死了PID?大模型正在吃掉传统控制论的午餐……|全面盘点:机器人在未知环境探索的3大技术路线,优缺点对比、应用案例!|照搬=最佳实践?分享真正的 VLA 微调高手,“常用”的3大具身智能VLA模型!机器人开源=复现地狱?这2大核武器级方案解决机器人通用性难题,破解“形态诅咒”!|视觉-语言-导航(VLN)技术梳理:算法框架、学习范式、四大实践|盘点:17个具身智能领域核心【数据集】,涵盖从单一到复合的 7 大常见任务类别||90%机器人项目栽在本地化?【盘点】3种经典部署路径,破解长距自主任务瓶颈!|VLA模型的「核心引擎」:盘点5类核心动作Token,如何驱动机器人精准操作?

【先锋观点】周博宇 | 具身智能:一场需要谦逊与耐心的科学远征|许华哲:具身智能需要从ImageNet做起吗?|独家|ICRA冠军导师、最佳论文获得者眼中“被低估但潜力巨大”的具身智能路径|独家解读 | 从OpenAI姚顺雨观点切入:强化学习终于泛化,具身智能将不只是“感知动作”

【非开源代码复现】非开源代码复现 | 首个能抓取不同轻薄纸类的触觉灵巧手-臂系统PP-Tac(RSS 2025)|独家复现实录|全球首个「窗口级」VLN系统:实现空中无人机最后一公里配送|不碰真机也不仿真?(伪代码)伯克利最新:仅用一部手机,生成大规模高质量机器人训练数据!

我们开设此账号,想要向各位对【具身智能】感兴趣的人传递最前沿最权威的知识讯息外,也想和大家一起见证它到底是泡沫还是又一场热浪?

欢迎关注【深蓝具身智能】👇

【深蓝具身智能】的内容均由作者团队倾注个人心血制作而成,希望各位遵守原创规则珍惜作者们的劳动成果。

投稿|商务合作|转载:SL13126828869(微信)

点击❤收藏并推荐本文