打造一个有温度、有趣味、专业的全栈式AI&AIGC交流社区,

用心写好每一篇文章!

01-DeepSeekV4核心优势

02-DeepSeekV4核心技术解读

GRPO( Goal-Conditioned Reinforcement Learning with Predictive Representations) 是一种将表征学习和目标条件强化学习巧妙结合的先进算法。它通过一个简单的自我监督任务来预测未来的状态表征,来驱动智能体学习环境的核心动态模型。

这套“内功”使得智能体在面对多样的、甚至是全新的目标时,能够快速理解任务本质,并制定出有效的策略。它被认为是迈向通用、能理解人类指令的AI智能体的重要一步。一个简单的比喻:

传统RL: 像是一个只会背答案的学生,题目一变就不会了。

GRPO: 像是一个先学好物理学原理的学生。无论你问他“球从A点滚到B点需要多久”还是“如何把火箭送上月球”,他都能运用基本原理推导出解决方案。

GPRO具有如下特点:

更高效的学习: 通过预测未来表征进行自我监督学习,智能体能够更早地获得关于其行为质量的信号,极大地缓解了稀疏奖励问题。它不需要等到真正达成目标才知道自己做得好不好,只要它“预测未来”的能力在变强,就说明它正在理解环境、朝着正确方向前进。

更好的泛化能力: 学到的表征是通用且富含信息的,这使智能体能够更好地泛化到它在训练中未见过的新目标上。因为它理解的是环境的基本动态,而非仅仅记忆针对特定目标的动作。

样本效率更高: 相比于直接从稀疏奖励中学习,这种通过预测任务进行“预训练”的方式,能让智能体更快地找到达成目标的有效策略。

与任务目标一致: 预测未来的表征与达成目标在本质上是一致的。为了准确预测未来,智能体必须学会那些能影响环境状态的动作,而这正是达成任何目标的基础。

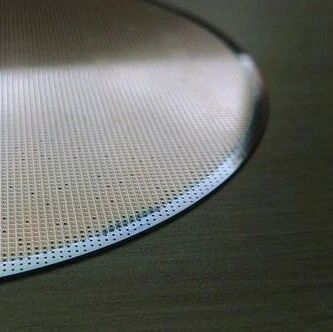

NSA,全称原生稀疏注意力,是DeepSeek AI团队提出的一种革新性的注意力机制。它的核心目标是解决传统Transformer模型在处理长文本时,因注意力计算复杂度随序列长度平方级增长而带来的巨大计算开销。

NSA通过一种 “动态分层稀疏策略” ,智能地选择在计算注意力时需要关注的关键信息,同时忽略不重要的部分,从而显著降低计算量。

NSA的工作原理可以概括为以下三个并行的注意力通路,它们协同工作以兼顾效率与效果:

| 注意力通路 | 核心功能 | 计算量占比 | 类比理解 |

|---|---|---|---|

| 压缩全局注意力 | |||

| 精选局部注意力 | |||

| 滑动窗口注意力 |

NSA具有如下的核心特点/优势:

突破效率瓶颈:NSA成功地将注意力机制的计算复杂度从传统的O(N²)降低到了接近线性水平。在处理64K长度的长文本时,实现了解码速度提升11.6倍,前向传播加速9倍的显著效果。

效果不减,甚至更优:实验表明,NSA不仅在多项通用基准测试中追平了全注意力模型,在部分长文本、数学推理和代码生成任务中,性能甚至实现了反超。

硬件友好的底层优化:NSA设计了专用的计算内核,使其计算步骤能完美匹配GPU等硬件的特性,最大化实际计算效率,解决了以往很多稀疏注意力方法“理论快而实际慢”的问题。

关注我,AI热点早知道,AI算法早精通,AI产品早上线!

禁止私自转载,需要转载请先征求我的同意!

欢迎你的加入,让我们一起交流、讨论与成长!