👇扫码免费加入交流群,如您有工作需要分享,欢迎联系:aigc_to_future

作者:Kunhao Liu等

论文链接:https://arxiv.org/pdf/2509.25161

论文链接:https://arxiv.org/pdf/2509.25161

项目链接:https://kunhao-liu.github.io/Rolling_Forcing_Webpage/

亮点直击

一种滚动窗口联合去噪技术,该技术在单次前向传递中处理多个帧,实现了相互优化,同时保持了实时延迟。 在流视频生成任务中引入了注意力汇机制,这是一项开创性的工作,使得可以将初始帧缓存为一致的全局上下文,从而在视频生成中实现长期一致性。 设计了一种高效的训练算法,该算法在非重叠窗口上运行,并以自生成历史为条件,使得在扩展的去噪窗口上进行少步蒸馏成为可能,同时减轻了曝光偏差。

总结速览

解决的问题

流视频生成中存在的误差累积问题,导致长时间生成的视频流质量下降。

提出的方案

设计了Rolling Forcing技术,通过创新的去噪和注意力机制,最小化误差累积。

应用的技术

联合去噪方案:同时对多个帧进行去噪,逐步增加噪声水平,放宽相邻帧的严格因果关系。 注意力汇机制:引入全局上下文锚点,利用初始帧的关键值状态,增强全局一致性。 高效训练算法:在非重叠窗口上进行少步蒸馏,减轻曝光偏差。

达到的效果

在单个GPU上实现长达数分钟视频的实时流生成,显著减少误差累积,提升视频质量和一致性。

方法

预备知识:自回归视频扩散模型中的曝光偏差

自回归视频扩散模型是一种混合生成框架,它将自回归链式分解与去噪扩散相结合用于视频生成。形式上,给定一个由 帧视频组成的序列 ,它们的联合分布可以使用链式规则分解:。每个条件分布 是通过扩散过程建模的,其中每一帧是通过在之前生成的帧的条件下逐步去噪高斯噪声生成的。在实践中,也可以在每一步生成一组连续的帧,而不是单个帧。为了清晰起见,在后文中将每个这样的组称为一帧。

自回归视频扩散模型的训练有两种方式:(1)通过逐帧去噪损失从头开始训练,或(2)通过蒸馏预训练的双向模型。第一种方法是在教师强迫(Teacher Forcing, TF)或扩散强迫(Diffusion Forcing, DF)范式下进行训练的(Chen et al., 2024)。在TF中,第 帧在噪声水平 的条件分布为 ,其中所有条件历史帧都是来自训练数据的真实干净帧。而在DF中,条件分布为 ,其中历史帧是被独立噪声水平破坏的真实帧。由于训练依赖于真实历史,而推理依赖于模型自身的预测,因此出现了一个称为曝光偏差的训练-测试差距(Schmidt, 2019)。减轻曝光偏差是困难的,因为去噪损失需要模型预测和相应的真实值在其条件下的配对,而这些是不可用的。

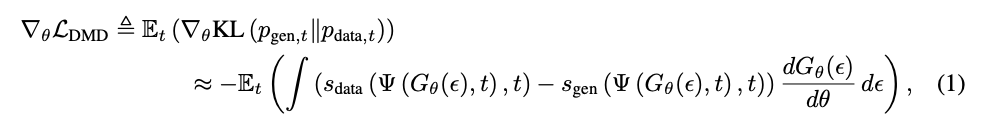

然而,第二种蒸馏方法提供了一种绕过去噪损失并减轻曝光偏差的途径。CausVid(Yin et al., 2025)将预训练的双向模型蒸馏为少步因果模型。它采用了一种分布匹配蒸馏(Distribution Matching Distillation, DMD)损失(Yin et al., 2024b),该损失最小化在随机采样的时间步 上平滑数据分布 与学生生成器的输出分布 之间的反向KL散度。反向KL的梯度可以近似为两个得分函数之间的差异:

其中, 表示前向扩散过程, 是随机高斯噪声, 是由参数化的生成器, 和 分别代表在数据和生成器的输出分布上训练的得分函数。由于使用DMD损失进行训练不需要真实的图像或视频数据(Yin et al., 2024a),自强迫(Self Forcing, SF)(Huang et al., 2025)通过在训练期间将每帧条件化在先前自生成的历史上来减轻曝光偏差。然而,尽管曝光偏差得到了缓解,一旦生成超出了训练的时间窗口,严重的错误积累仍然会发生。

通过滚动扩散窗口实现自回归视频生成

在自强迫(SF)中,视频是以严格的因果方式逐帧生成的。考虑一个噪声计划 ,总噪声级别为 。在每个去噪步骤 和帧索引 上,模型在之前的干净帧 的条件下去噪一个中间的噪声帧 ,然后通过前向扩散过程 将具有较低噪声水平的高斯噪声注入到预测的去噪干净帧中。这会产生一个噪声帧 ,将作为下一步去噪的输入。形式上,在SF中,去噪过程通过以下公式实现:,且 。然而,这种形式没有当前去噪帧 与其历史 之间的双向注意力,其中严格的因果性迫使每一帧继承并随着时间的推移复合其前身的错误。

所提出的滚动强迫(Rolling Forcing)通过将单帧去噪窗口扩展为跨越多帧的滚动窗口来放宽这一限制,如下图3所示。每个去噪窗口包含按时间顺序噪声级别逐渐提高的连续帧,类似于滚动扩散(Rolling Diffusion)。去噪窗口的长度 设置为去噪时间步的数量,即 。为了确保连续性,第 帧的下一个噪声级别与第 帧的当前噪声级别对齐,使窗口能够无限向前滚动。在每次滚动时,会生成一个干净帧,并将纯高斯噪声附加为要合成的下一帧。形式上,对于从第 帧开始的去噪窗口,滚动强迫的去噪分布可以定义为:

其中, 表示去噪窗口中的噪声帧, 表示窗口输出,其中每个帧都去噪到较低的噪声水平。生成器 在输入噪声帧、它们的噪声级别 和干净的历史帧 的条件下预测干净帧。 在噪声级别 上向预测的干净帧注入高斯噪声 ,生成噪声水平降低的帧。

由于去噪窗口的长度等于去噪步骤的数量 ,在视频扩散模型中通常较大(即约50),去噪窗口本身变得非常大。为管理如此大的窗口,以往的工作要么在多个GPU上独立处理每个帧,要么使用少步采样器将 减少到约30。相比之下,我们采用扩散蒸馏,将去噪步骤的数量 减少到仅5,同时保持生成质量,从而使去噪窗口紧凑到足以适应单个GPU,并保持实时延迟。

时间和全局历史上下文

随着生成过程中干净的历史帧 的累积,直接处理它们变得计算上昂贵。为了解决这个问题,我们缓存历史帧的键和值状态,从而避免在生成新帧时的冗余重新计算。注意,尽管去噪窗口内的注意力是双向的,但去噪窗口中的帧与历史帧的KV缓存之间的注意力仍然是因果的。虽然KV缓存减少了计算量,但随着帧的累积,计算复杂度仍然以缓存大小的平方增长,缓存可能变得足够大而导致内存不足错误。给定从第 帧 开始的去噪窗口,我们通过仅保留最近 个历史帧 的KV缓存作为时间上下文来解决这个问题,以保持短期时间一致性。然而,仅依赖短期历史会导致生成视频的长期属性(如曝光、色调、白平衡等)逐渐漂移。

为了保持长期的全局一致性,我们缓存初始 个生成帧 的KV状态作为全局上下文,类似于流式语言模型中的注意力汇聚标记。缓存大小 和 的选择使得总注意力窗口大小与双向教师模型匹配,即 。然而,直接缓存初始帧会导致溢出问题。现代视频扩散模型(DiTs)通常使用相对位置编码(RoPE)。随着去噪帧的索引 增加,它们与初始缓存帧的相对距离增长,最终超出RoPE的训练范围,产生不自然的伪影。为了解决这个问题,我们在应用RoPE变换之前缓存全局上下文帧 的键状态。在生成过程中,我们在有效索引 动态应用RoPE到这些缓存的键状态,将它们视为紧接在时间上下文帧 之前的位置。此调整保持了相对于去噪帧的固定相对位置,防止了过度偏移。

滚动强制后训练

滚动强制通过DMD损失(公式(1))将预训练的双向视频扩散模型蒸馏为一个少步因果自回归生成器。由于DMD匹配整个视频序列的整体分布与数据分布 ,DMD损失的计算在训练期间需要一个预测的干净视频 。在SF中,预测的干净视频通过以下方式生成:

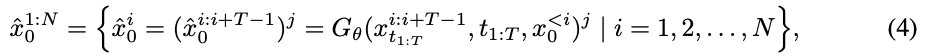

其中, 表示每个帧在去噪前的噪声水平 。对于滚动强制,由于去噪窗口由不同噪声水平的多个帧组成,在每个窗口中选择第 帧,并将所选帧组合为预测的干净视频:

其中, 表示去噪窗口内的帧索引以及帧的噪声水平 。然而,由于查询大小是 倍的缘故,公式 (4) 的计算复杂度比公式 (3) 高出 倍。鉴于 DMD 损失已经计算昂贵,这个额外的成本很容易导致即使在拥有 80G 内存的 GPU 上也出现内存不足错误。

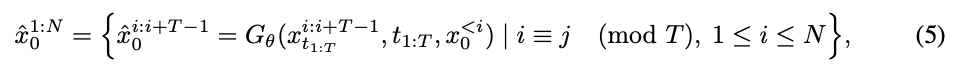

为了解决这个问题,我们不是对每个窗口进行反向传播(这需要每次前向传播的梯度),而是采样一部分不重叠的窗口来构建预测的干净视频,如上图 3 所示。梯度计算仅在这些选定的窗口上进行,这显著减少了内存使用,同时保留了有效的监督。形式上,预测的干净视频给出如下:

其中,。在每次迭代中,我们将需要梯度计算的前向传递次数从公式 (4) 中的 减少到 。滚动强制训练在算法 1 中进行了说明。

与自我强制(SF)类似,训练期间的输入噪声帧 是由模型生成的,而不是取自真实数据,从而减轻了曝光偏差。然而,与公式 (3) 或公式 (4) 不同的是,公式 (5) 中的每个帧在预测的干净视频 中是从不同的噪声水平 去噪的。因此,从不同噪声水平去噪的帧具有不同的质量和清晰度,导致在 DMD 训练中产生不自然的视频 和相机运动。为了解决这个问题,我们采用了一种混合训练策略,在自我强制训练(公式 (3))和滚动强制训练(公式 (5))之间以相等的概率交替进行。自我强制目标作为正则化器,鼓励模型生成具有自然相机运动的视频。在推理中,仅采用滚动强制范式,如算法 2 中详细说明的那样。

实验

实现细节

模型。 我们将滚动强制与 Wan2.1-T2V-1.3B作为基础模型实现,该模型以 16 FPS 的速度生成 5 秒的视频,分辨率为 832 × 480。遵循 CausVid 和自我强制,首先使用因果注意力 mask 在从基础模型中采样的 16k ODE 解对上初始化基础模型。对于 ODE 初始化和滚动强制训练,从过滤和 LLM 扩展版本的 VidProM 中采样文本提示。我们设置 ,并执行块状去噪,每个块包含 3 个潜在帧。模型训练 3,000 步,批量大小为 8,训练的时间窗口为 27 个潜在帧。我们使用 AdamW 优化器用于生成器 (学习率为 )和虚假得分 (学习率为 )。生成器每 5 步虚假得分更新后更新一次。

评估。 我们采用 VBench(Huang 等,2024)质量矩阵来评估在 200 个随机采样的 MovieGen(Polyak 等,2024)提示上的生成质量,这些矩阵测量多个维度,包括时间闪烁、主体一致性、背景一致性、运动平滑度、美学质量和成像质量。为公平起见,所有用于定量评估的视频均以相同的长度(30 秒)、帧率(16 fps)和分辨率(832 × 480)生成。为了评估长视频生成中的质量漂移,遵循 Zhang & Agrawala(2025)和 Yin 等(2025)的做法,我们计算每个视频的前 5 秒和最后 5 秒之间成像质量的绝对差异,。 的大小直接反映了误差累积的严重程度。遵循 Huang 等(2025)的做法,我们从吞吐量和延迟方面评估实时性能。与报告首帧延迟的先前工作不同,在生成过程达到稳定速度后测量延迟。

比较

我们将滚动强制与几个相关的、规模相当的开源视频生成模型进行比较。具体来说,SkyReels-V2(Chen 等,2025)在扩散强制范式下进行训练,该范式在推理过程中破坏历史帧以减轻误差累积。MAGI-1 在训练和推理中均采用 FIFO 式去噪范式。我们还与先前的基于蒸馏的方法进行比较,包括 CausVid 和自我强制。需要注意的是,SkyReelsV2、CausVid、自我强制和我们的滚动强制均从相同的基础模型 Wan2.1-T2V-1.3B 初始化。

如下表 1 所示,Rolling Forcing 达到了最高的整体质量评分。特别是,它获得了显著较低的 ,展示了其在抑制误差累积方面的有效性。下图 4 中的定性比较进一步突显了 Rolling Forcing 在 2 分钟的自回归生成过程中保持高保真和一致的视频质量,而其他比较模型则表现出明显的劣化,如颜色偏移、伪影、不自然的运动等。此外,Rolling Forcing 实现了亚秒级延迟的实时生成,略快于 Self Forcing 和 CausVid,从而确立了其在长时视频流应用中的适用性。

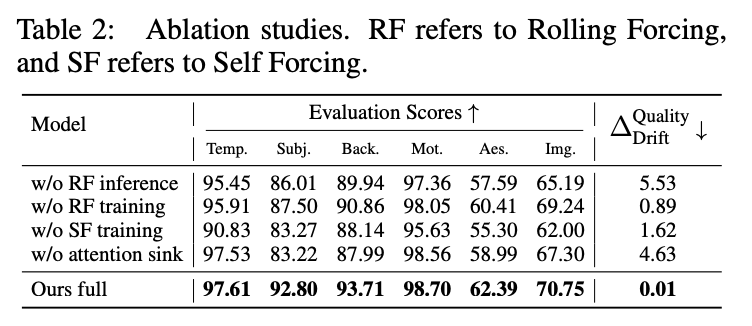

消融研究

进行了消融研究,以评估几种设计选项的贡献,如下表 2 所总结。

滚动扩散窗口。 评估了两个变体:无 RF 推理(w/o RF inference)和无 RF 训练(w/o RF training)。在无 RF 推理中,移除了滚动去噪窗口,并在推理过程中采用逐帧去噪,同时保持与我们完整方法相同的训练过程和模型权重。在无 RF 训练中,模型完全在逐帧范式下进行训练和推理。如下图 5 所示,这两个变体在 30 秒内都遭遇了明显的误差累积,表明滚动窗口对于抑制长期漂移至关重要。

混合训练策略。 为了评估其效果,移除了自我强制训练目标(w/o SF training)。如上表 2 所示,这导致了一致性和整体质量的显著下降,主要是由于不自然的摄像机运动。

注意力陷阱。 最后,移除全局上下文帧(w/o attention sink)导致生成视频中出现明显的漂移,如上图 5 所示。

结论

Rolling Forcing,这是一种用于实时长时视频生成的框架,能够在维持亚秒级延迟的同时减轻误差累积。通过引入滚动窗口联合去噪策略,Rolling Forcing 使得连续帧之间能够进行相互优化,有效减少长期漂移。注意力汇机制的整合进一步通过将初始帧作为持久上下文锚定来增强全局一致性,而我们高效的训练算法则在扩展的去噪窗口上实现了少步蒸馏,同时减轻了曝光偏差。大量实验表明,Rolling Forcing 在长达数分钟流序列中实现了最先进的时间一致性和视觉保真度,在质量和效率上显著优于先前的流媒体方法。

参考文献

[1] ROLLING FORCING: AUTOREGRESSIVE LONG VIDEO DIFFUSION IN REAL TIME

技术交流社区免费开放

涉及 内容生成/理解(图像、视频、语音、文本、3D/4D等)、大模型、具身智能、自动驾驶、深度学习及传统视觉等多个不同方向。这个社群更加适合记录和积累,方便回溯和复盘。愿景是联结数十万AIGC开发者、研究者和爱好者,解决从理论到实战中遇到的具体问题。倡导深度讨论,确保每个提问都能得到认真对待。

技术交流

加入「AI生成未来社区」群聊,一起交流讨论,涉及 图像生成、视频生成、3D生成、具身智能等多个不同方向,备注不同方向邀请入群!可添加小助手备注方向加群!