高自由度灵巧手演示时玩魔方、翻书、弹钢琴,实际应用却连抓鸡蛋都难以胜任……

这一现象背后,是整个行业面临的“最后一厘米霸权”之争:

谁能让机器人真正学会“用手”,谁就能在即将爆发的灵巧手市场中掌握话语权。

据统计,2024-2025年,我国灵巧手行业市场规模由125.33亿元增长至501.33亿元,期间年复合增长率300%;而 2030 年全球多指灵巧手市场规模更将突破 50 亿美元,年复合增长率超 64%。

“热闹”之下,一个奇怪现象引人深思:

一边是能玩魔方、打扑克的高自由度五指灵巧手,另一边却是现场演示机器人多数使用简单的二指夹爪完成精细化操作。

这种矛盾背后,是行业和学界都绕不开一个尴尬的事实——

缺乏真实的力觉和接触信息。没有触觉的灵巧手,即使学会了动作轨迹,也不懂得“如何用手”。

痛点分析:我们究竟缺什么样的数据?

为什么灵巧手的发展总是“雷声大、雨点小”?

是数据不够“多”吗?

在今年机器人顶会RSS的一项研究中,灵巧手的数据规模已经卷到了“10亿”条,但依旧没有解决灵巧手的诸多问题。

实际上数据的“量”并不是关键——归根结底,是因为数据不够“对”。

▲图1|来自于RSS2025的研究Dex1B©️【深蓝具身智能】编译

这项研究“疯狂地”构建了10亿条灵巧手的演示数据,试图解决灵巧手在应用上的诸多问题,然而想要完整的覆盖人类操作的全部场景,问题的核心并非数据的“量”,而在于数据的“质”——

即精确的力觉与接触信息。

过去几年,研究者们尝试了三种主要路径来收集灵巧手数据:

遥操作:专家通过手柄或力反馈设备远程控制机器人,虽然能得到较真实的数据,但效率极低,成本又高。

视频学习:直接用人类操作的视频来训练模型,规模大,但缺少深度和触觉信息,机器人常常“照猫画虎”却不得要领。

纯仿真:在虚拟环境中生成海量轨迹,数据看上去完美,但现实中根本无法复现,sim-to-real 的鸿沟始终无法弥合。

▲图2|不同数据采集方式的优劣对比©️【深蓝具身智能】编译

这就形成了一个让整个领域头疼的“不可能三角”:

要规模?可以有,但往往牺牲了真实感。

要真实?能做到,但数据量远远不够。

要力觉?少数实验室能采,但规模太小,无法支持预训练。

▲图3|灵巧手数据的“不可能三角”©️【深蓝具身智能】编译

结果就是,机器人虽然能学到“怎么动手指”,却始终学不会“怎么用力”。

就像一个学生背熟了写字的笔画顺序,却始终写不好字,因为他不知道笔该轻轻落下还是用力按压。

对灵巧手来说,这个差距尤其致命。

▲图4|人手与灵巧手拿鸡蛋对比©️【深蓝具身智能】编译

当我们用同样的手指姿态抓握鸡蛋时,只要稍稍用力,就能做到“在手势基本不变的情况下”捏碎鸡蛋。

当前的灵巧手训练数据就有这样的问题(缺乏力的先验),机器人只学习抓握的轨迹和姿态——

只管把鸡蛋抓在手里,但不顾鸡蛋的“死活”。

这也解释了为什么今天的机器人能完成一些标准化的工业操作,却难以真正走进生活场景:

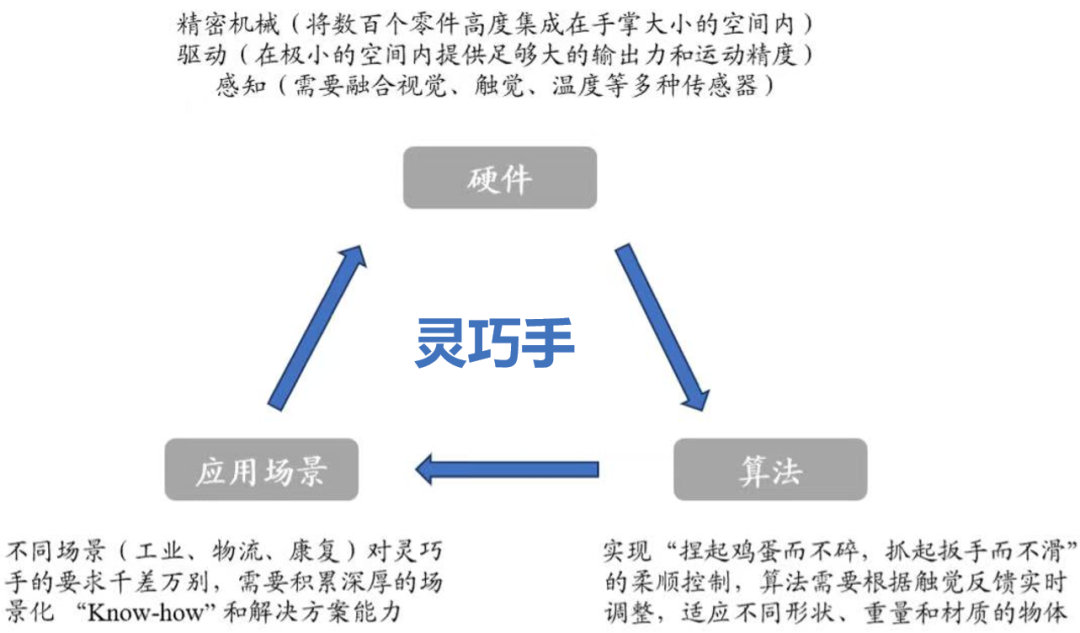

作为不同机器人形态的“共性模块”,灵巧手壁垒深厚,涵盖硬件、算法与应用场景三大环节,同时直接影响机器人“大脑”的决策与训练。

▲图5|灵巧手三大技术壁垒(图源网络)

而目前高自由度方案在工业场景规模化落地上尚缓慢,这其中也「暗藏着」用科研市场”补贴“工业野心的现实困境。

但“不破不立”,“破则百立”。

透过企业宣传的本质,终究还是——谁真正扛得住商业化考验。

解决方案:DexCanvas的突破

既然问题出在“数据缺少灵魂”,那就要让数据真正包含力和接触的维度。

DexCanvas 数据集

灵巧智能近期发布的 DexCanvas 数据集发布的初衷,正源于此。

和以往追求“多少小时、多少条轨迹”的思路不同——

DexCanvas 从一开始就把目标锁定在“质量与物理完备性”上,主要包括三个步骤:

真人示范,精准采集

通过 20 多个动捕相机,记录了 1000 小时人手操作数据,覆盖 22 类常见抓取与操作方式,采集精度达到亚毫米级。

▲图6|DexCanvas中的 22类抓取分类©️【深蓝具身智能】编译

仿真重演,反推力觉

仅有轨迹还不够,DexCanvas 借助强化学习,让智能体在仿真环境中“重想要复现轨迹,智能体必须施加正确的力、找到合适的接触点。

这个过程让系统自动生成了缺失的力觉和接触信息。

▲图7|DexCanvas中的强化学习策略,“复活”轨迹的物理灵魂©️【深蓝具身智能】编译

数据增强,规模放大

在保留真实感的前提下,通过改变物体质量、摩擦系数和初始条件,把原本的 1000 小时演示,扩展成 10 万小时物理增强数据。

▲视频1|DexCanvas通过巧妙的算法,在保证质量的同时对数据集的规模进行了极大的拓展©️【深蓝具身智能】编译

最终得到的 DexCanvas 数据集,在兼顾质量和数量的同时,包含了以往最缺乏的力觉维度!

▲图8|DexCanvas的整体数据采集方案及采集内容©️【深蓝具身智能】编译

更重要的是,这些数据不是绑定在某一款机器人硬件上,而是以人手为通用接口,能迁移到不同类型的灵巧手和不同任务中使用。

DexHand 系列灵巧手

再加上灵巧智能自研的 DexHand 系列灵巧手,数据和硬件形成了天然的闭环。

▲图9|灵巧智能自研的DexHand021,首款商用高自由度多模态感知的智能通用灵巧手。©️【深蓝具身智能】编译

对其而言,首批量产产品的实际交付与客户反馈、成本控制能力,才是其“未来”的真正考验。

核心或许在于,其能否在激烈的市场竞争中快速建立独特的生态优势和商业化路径。

开源计划:质量优先的行业信号

放眼整个行业,不乏动辄“百万轨迹”“千小时演示”的大规模数据集,它们在推动模仿学习、视觉识别等方向上确实起到了作用。

但当这些数据缺少触觉和力觉维度时,灵巧手训练出来的依然只是“动作壳子”,难以支撑复杂操作的落地。

DexCanvas 的开源,正是要打破这种单一比拼规模的惯性。

这一次,灵巧智能选择了“卷质量”:

系统性:

覆盖 22 类人手操作模式(基于Cutkosky分类),采集内容完整而有序。

规模与精度:

包含 1000 小时真人多模态操作演示,扩展至 10 万小时物理增强数据;动捕精度达 0.1mm,保证轨迹毫厘不差。

物理真实性:

全流程物理一致性修复,接触几何精度 1mm,力觉信息精度 0.1N;每条数据都附带抓取规则参数(力闭合、形闭合、支撑方式等)。

模态丰富:

四种模态(RGB、深度、运动捕捉、力/力矩)同步采集,首次为灵巧手数据带来“全维度”描述。

泛化潜力:

基于人手演示而非特定硬件,天然支持跨平台、跨场景的迁移学习。

▲图10|DexCanvas开源情况一览©️【深蓝具身智能】编译

更重要的是,DexCanvas 并非只开放原始数据,还会提供:

完整 pipeline:从动捕、MANO 拟合、物理重演到五指灵巧手执行,全流程处理代码开源。

标准接口:HuggingFace 数据集版本、GitHub 加载器与训练示例,让研究者“开箱即用”。

这意味着,DexCanvas 不只是又一个“更大”的数据集,而是一套真正面向行业的灵巧操作基础设施。

它让研究者第一次拥有了能直接用于模仿学习、强化学习、大规模预训练的高质量灵巧操作数据 。

结语

从学术界到产业界,灵巧手一直是焦点,但发展迟迟受限,根源就在于数据不够真实、不够全面。

DexCanvas 的出现,正是要补上这块短板:

1000 小时真实人手演示、10 万小时物理增强数据为基石,覆盖 22 类操作模式,同步采集 4 种模态数据,并提供亚毫米级动作精度、0.1N 力觉精度、物理一致性修复。

真正让机器人能学到“手上有分寸”的能力。

这不仅是一份数据集,更是一套面向整个行业的灵巧操作研究基础设施。它让学界的研究有了更坚实的出发点,也让产业的落地有了更真实的支撑。

而其更是进一步宣布开源,意义不仅在于共享,更在于导向:它释放出一个清晰信号——

未来的竞争,不在于谁的数据更多,而在于谁的数据更真、更精、更有用!

编辑|阿豹

审编|具身君

工作投稿|商务合作|转载

:SL13126828869(微信号)

>>>现在成为星友,特享99元/年<<<

【具身宝典】||||

【技术深度】|||||||

【先锋观点】|||

【非开源代码复现】||

我们开设此账号,想要向各位对【具身智能】感兴趣的人传递最前沿最权威的知识讯息外,也想和大家一起见证它到底是泡沫还是又一场热浪?

欢迎关注【深蓝具身智能】👇

【深蓝具身智能】的内容均由作者团队倾注个人心血制作而成,希望各位遵守原创规则珍惜作者们的劳动成果。

投稿|商务合作|转载:SL13126828869(微信)

点击❤收藏并推荐本文