作者:matrix明仔,本文已获授权

地址:

https://zhuanlan.zhihu.com/p/1937630548366460708

主页:

https://www.zhihu.com/people/matrix200

1

说在前面的话

具身智能的在今年前三季度的大部分工作的思考也就仍旧集中在数据的收集和数据的利用上即如何高效的利用视频的示例数据去训练一个性能表现都不错的基础模型的研究。这个在上半年一直持续开始挖掘的工作,似乎也没有激起很多的水花。大家在分析和总结前期遇到的问题的时候,不免会对一些无法清晰回溯的内容进行质疑,即在数据采集上是否有大问题,我们对于数据的利用上的思考是否还存在很大的不足。

于是,在对数据分析的过程中,3D/4D的世界模型开始重新回归大家的思考。即针对所采集的数据合理性和丰富性进行进一步拓展优化的研究思路。于是从目前上看,最近的3D/4D的世界模型也开始走成了两派的思路即隐式和显式的研究。

隐式3D的世界模型主张,我们可以通过提取出3D/4D的内容来提升视频的空间理解能力,显式3D的世界模型,则认为,我们需要显式的给出3D Mesh或者其他的结构信息和物理规律,才能保证系统的稳定和可用。

一个金色头发的老头正在参观一个中式的客厅

从实际的应用上看感觉两者的局限性在一开始就暴露得清晰无疑,然后我们对于这些局限性似乎也没有很好的一个解决思路。于是我开始翻看以前的自己的思考和总结,我觉得一年多前自己提出的Real2sim(wm)2Real的思考还挺有道理的,于是我打算在这篇文章中结合现阶段我觉得多个很不错的研究和我之前提出的想法,可以帮助一部分刚入门想做这个或者和我一样还迷糊着不知道自己之后要怎么开展研究的大家理清楚脉络。

2

基于仿真器出发研究,3D Phys-Diff-

Simulator

其实目前我们对于显示世界模型的研究依旧集中在静态3D场景当中,模型来构建场景再结构化的decouple[1]场景,拓展可交互空间,又或者是先构建通过scan的方式构建initiate 3D 场景,再丰富场景。(两种方法其实在性能,成本和效果上都各有优势,目前的方法都很成熟,是可以开箱即用的程度,所以我们暂时进一步讨论优劣。)但是这个整个过程中不涉及动态的物理模拟,所以其实并不满足世界模型最初定义的完整工作流,只初步完成了初始化Env搭建这一环而已。类似于Hunyuanworld-1 [2] ,Matrix-3D[3]的工作中,构建全景图和从全景图中恢复3D Mesh场景就是目前工作中的典型。不过也有很多工作尝试完善这个世界模型的工作闭环,即环境到交互再到环境变化。Discoverse[4]和EmbodiedGen[5]把环境的构建区分为了前景和背景的构建,背景使用pano或者是scan的3D场景构建出静态的内容,前景则使用Mujoco[6]或者Mujoco-Warp[7]中的Mesh物理仿真+3DGS的渲染来完成高保真动态的物体交互。Genesis[8]则是通过Taichi[9]来对Mujoco内素材的再次渲染来完成超高画质的场景重建。

在这些工作中依旧存在我在上文说到的问题,首先是3DGS<===>Mesh方案,目前已知是3DGS对于物理表面建模比较一言难尽,后续一些Sugar,2DGS,这些技术对3DGS进行结构化改造,但是从基本geometry的优化上,我们依旧发现了这些方案对于表面的优化较为粗糙。GSDF,还有Pano2Room这个工作,则把Mesh或者是SDF当成监督,在学习的过程中进行优化,能够一定程度上解决3DGS的表面平滑的问题,但是对于3DGS以及生成出的mesh和却没办法又很好的保障。完全弃用3DGS,而采用提高Image-generation模型提升Mesh面数和贴更加高清UV纹理的方式,可能又会带来渲染饱和度过高和物体-场景光照不平衡的图形学问题(image-gen模型会把光照烘焙进去texture里面),因此又再次把visual-gap的问题引入了回来。这系列问题未来都会有一些优化的paper来帮助做得更完善,光照问题又De-lighiting的工作[10][11]正在逐渐优化,表面的问题也有一些结合了Mesh监督再加上结构化处理3DGS的思考paper,未来越来越高的质量的3D recon工作也会逐步打破real2sim的visual gap以及在geometry上稳定性问题。

不过目前在整个设计上,我们不得不再提到一个点,跨物理仿真器平台之间的部署问题。上述的方案在物理参数设计上基本都是复用了mujoco上物理参数设定,至于在isaac平台上这些方案能不能处理好,在SAPIEN上呢?于是在 Roboverse[12]中也有考虑到仿真器之间的物理差距,从而设计一个统一的跨物理仿真器的平台,来帮助我们进一步的优化世界模型的物理表达。

对于Phys-diff-simulator这种范式而言,如何可以进行大规模数据的scaling-up,是一个难点。我们可以灵活的设计各种动作表达,微分出各种交互,但是相对于imitation learning的数据需求上,仍旧是远远不足的。

3

基于视频生成/多视角出发的世界模型研究

随着,25年的WanX开始,我们发现了规模化的清洗数据和标注数据能够带来motion上的提升。得益于Feed forward 3D 展示出强大的模型带来的3D信息的预测和估计的能力,于是3DGS/4DGS和世界模型的结合的工作也开始逐步的发展起来GWM[13]和 Enerverse[14],与此同时Dust3R/Mono3R/Gssplat3R/MoGe这些3R技术演进到最近的VGGT,逐步把“单/少帧 → 点图/深度/相机/稠密几何”的一站式推理做稳,让示例视频也可以拥有3D属性,强化模型对于空间理解交互的工作Robot4DGen[15]开启了Imitation Learning 3R时代的进一步发展。这些技术的发展是基于目前空间结构化能力还不能很顺利的被我们采集的示例视频学习到,于是我们借助3R/3DGS的技术来帮助我们的模型可以进一步的把没有办法学习到的3D 空间知识进一步学习下来。

这个思路是符合目前大家对于pixel-worldmodel scaling-up的理解,也很好的弥补了在训练过程中不同的训练视频上动作空间不同步的问题。但是目前来说这类技术的问题核心在于从2D到3D的转换问题依旧不够成熟,遮挡时的像素漂移,不同相机角度采样下难以保持跨视角一致,等问题还需要进一步解决。

4

符合物理的4D生成

目前的4D生成主要技术分为以下3类,Template-base即使用模板(静态网格/骨架/蒙皮/4Dmesh)为基础,通过LBS、BlendShapes、MPM,关节轨迹预测,视频生成出的轨迹变换来生成或者是预测对象的motion变化,进而实现4D[16][17][18][19]。Generate-base 即,信息可能从生成的3D模型或者视频中来。通过文本/图像控制生成出3D模型,再通过video来实现motion的变化,最后把motion内容与3D模型的进行绑定,从而实现4D模型的构建[20][21]。同时也还有一种重建的4D方案,也就是从交互视频反演几何+物理,得到可模拟 4D的内容[22]。

如何把4D生成迁移到仿真环境当中

对于4D如何参与到simulation阶段,目前的研究比较空白。无论是基于template和基于video的生成式的4D生成方案,对于motion和interact的模拟以及评价指标依旧停留重建的画质以及几何一致性,然后通过user study对其余的运动属性进行评估来构建指标的体系。

对于如何把可控物理属性,通过这些物理属性预测出的物体状态变化,依旧是比较少的。在视频生成领域多数用高质量的清洗过的物理数据和物理评估指标去优化整个视频的motion变化。目前,大部分的视频生成的工作在motion上能有很好的表现,但是对于物体交互以及物理交互之后在环境中产生的变化,目前的视频生成依旧是没法做好。这样主要集中在视频生成无法理解具体的物理变化,可能多数时间只是在学习一个轨迹变化,打篮球的时候,你会发现运球的时候,球和地面接触再回到手里面,这个状态的改变是不太连贯的。

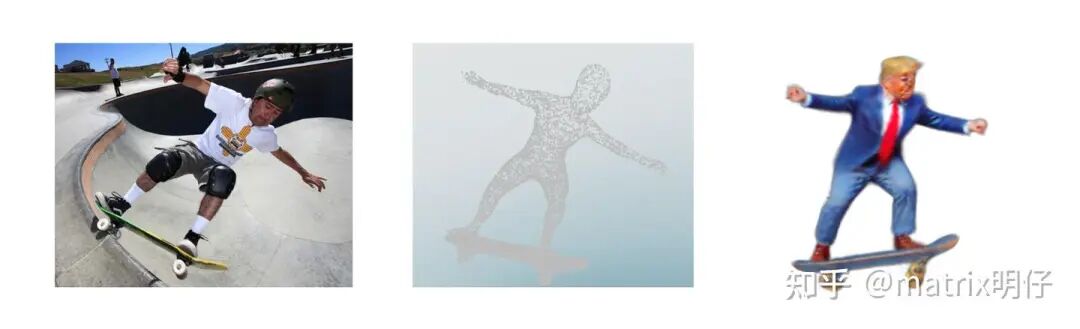

从视频中学习出带时序的3D Point,之后通过Personalization的Text-3D生成4D的抽象表情包

这其中的难点主要集中在视频生成模型能否又足够的能力从训练数据中反演出物理规律,理解物理自身属性和交互属性。这些问题在一段时间内其实似乎还是不好被解决的,所有基于仿真器的物理驱动模拟,并不会被取代,在一段时间可能会发展出仿真器,视频生成组合出现的一些工作[23]。不过以这种方式来压榨视频生成模型的能力,快速克服sim2real上的一些问题,其实一定程度上也极大的限制了视频生成模型进一步进化为世界模型的可能性。

5

关于机器人中数据理论的局限性

上文所说的3D/4D都是一种数据再利用的方式而已,本质上并不改变目前EAI原有的训练架构。属于是把一种3D/4D的模态的信号训练好后以外挂的形式或者是constraint的形式现有的模型进行结合。这种方式其实对于EAI的训练上利用率是较低的,更多只是一种短期内快速榨干VLA能力的一种方式。我们需要做的依旧是通过结合我们对于3D和4D的理解,更多把心思回归到数据理解和利用上,而不是一味追寻fancy,视效,motion的逼真,我们还需要思考更多和现有world-model结合的可能性。把3D信息编码成token混合其中训练,把4D信息编码成token混合训练。同时也要注意与LLM之间的协同,多数的VLA模型依赖于当前的LLM性能的表达还有视觉部分的visual-grounding能力,如何把3D/4D更巧妙和主动的添加其中是一个问题。而由于4D自身的特殊性,也可以成为一个校验模型输出性能的一个GT,当我们把整个数据链路从海量互联网数据-->专门的仿真数据--->少量的真机数据通过3D/4D所构造的校验型simulator或者是改进后的数据输入,来完成全生态的利用和闭环未来对于模型和数据之争或许声音会小一点。这样是我之后打算花更多时间来研究这套范式的原因,目前我们并不缺乏对于VLA模型优化的想象力,缺的更多是对于我们已有数据的进一步打磨和完善的技术和思考。

6

结尾

3D/4D世界模型严格意义上来说其实和现有的V-JEPA2的工作不是一个体系下的内容,现在的工作更注重于3D/4D质量和内容的发展,并不是世界模型的所看重的predict能力。相比于Genie3所生成的交互式,可编辑的概念,目前的3D/4D的工作会更加重视几何一致性的表达,还有场景图像质量上的问题。基于上述的理解和考虑,我们简单就可以预测出之后的工作会朝着进一步的外挂或者内嵌phys知识的方向进行发展。未来的3年内,我们会不断的看到相关工作的发展,通过这种方式来重新让Real2Real的embodied-ai任务焕发生机,不止是机械化的组合simulator,或者是教条化的引入video-gen来处理某些gap的问题。而是更多希望引入这些方法来进一步的支撑起数据金字塔的,打破数据上的瓶颈。本质上还是希望帮助未来的模型拥有更好的直接物理理解能力,以及拥有不错的视推理能力。同时我也会觉得,世界模型最后或许也会发展成EAI基模架构中的一个模块化的内容,当然这也许也取决于后续大家对于WM的思考和不减少功能下,对于WM定义的简化。

参考

END

智猩猩矩阵号各专所长,点击名片关注