论文题目:A foundation model to predict and capture human cognition

论文地址:https://www.nature.com/articles/s41586-025-09215-4.pdf

创新点

首次将大语言模型(LLaMA 3.1 70B)微调成通用认知模型,无需针对特定任务重新设计架构,直接通过自然语言描述预测任意实验范式中的人类行为。

将实验流程转录为自然语言(如“你按下按钮B获得1分”),使异构实验数据可统一处理,解决传统模型需手动设计实验特征的瓶颈。

方法

本文采用的核心研究方法是以大规模人类行为数据为驱动,通过参数高效微调技术将预训练大语言模型转化为通用认知模型。具体而言,研究团队首先构建了一个名为Psych-101的自然语言数据集,将160项心理学实验的逐试次行为数据(涵盖赌博、记忆、强化学习等任务)转录为统一文本格式,形成包含千万级人类选择的语料。随后,基于Llama 3.1 70B模型,使用量化低秩适配(QLoRA)技术仅训练0.15%的新增参数,以交叉熵损失聚焦人类反应预测,在单张A100 GPU上完成单轮微调得到Centaur模型。评估阶段采用负对数似然作为行为拟合指标,通过保留参与者、修改实验故事结构、引入全新领域任务三重泛化测试验证模型鲁棒性;同时利用fMRI数据,通过正则化线性回归分析模型表征与大脑活动的皮尔逊相关性,证实其神经对齐性。最后,结合语言模型解释(如DeepSeek-R1生成策略假设)和科学遗憾最小化框架,迭代优化认知理论模型,形成从数据到理论发现的闭环方法论。

Psych-101 数据集与 Centaur 架构示意图

本图a. Psych-101 全景:左侧饼图展示 160 项实验按领域的占比(多臂老虎机、决策、记忆、监督学习、马尔可夫决策过程等);右侧给出 6 条典型实验转录示例(老虎机、彩票、记忆 2-back、天气预测、太空寻宝、奇物辨识)。图b. Centaur 架构:在冻结的 4-bit Llama 3.1 70B 每一层线性模块旁插入 rank=8 的低秩适配器(LoRA),新增参数量仅 0.15%,用 QLoRA 微调。

Psych-101 行为拟合效果

a. 逐实验 Δlog-likelihood:比较 Centaur、原始 Llama、14 个领域专用认知模型。绝大部分条形位于零线之上,表明 Centaur 显著优于后两者(Cohen’s d≈0.2)。 b. 视野任务(horizon task)开放环仿真:Centaur(蓝)与人类(灰)在奖励均值(54.1 vs 52.8)及信息奖励参数分布上高度重合。 c. 两步任务仿真:Centaur 与人类均呈现“模型自由-模型基础”双峰分布,再现异质策略。 d. 社会博弈预测:Centaur 对人类策略准确率 64%,显著高于对人工代理的 35%,证明其专擅预测人类而非任意智能体。

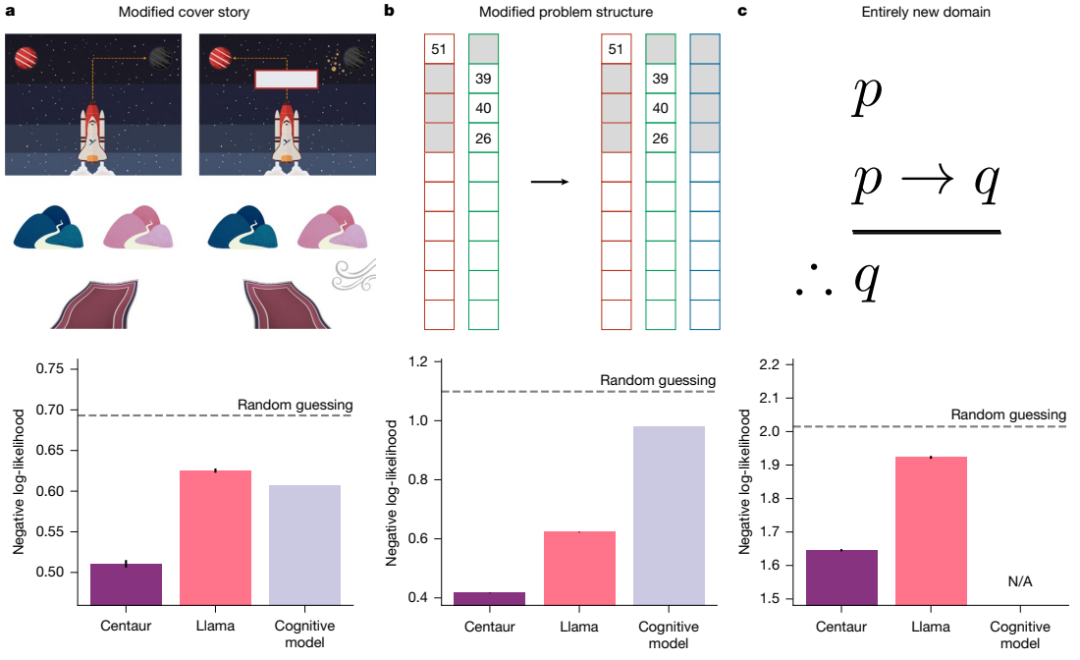

跨分布泛化测试

a. 更换封面故事(魔法地毯):Centaur 负对数似然 0.51 < 认知模型 0.61 < Llama 0.63。 b. 结构变更(三臂老虎机 Maggie’s farm):Centaur 0.42 << 认知模型 0.98。 c. 全新领域(LSAT 逻辑推理):Centaur 1.65 < Llama 1.92(无可用认知模型)。

所有误差条为 SEM,t 检验 p<0.0001。

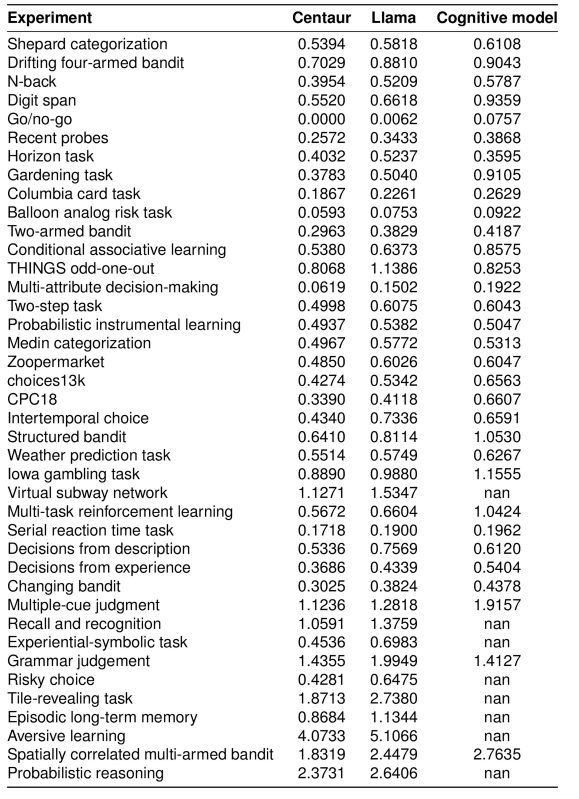

实验

本表是一张横跨 160 项实验的“全景成绩单”,纵向罗列了从多臂老虎机、爱荷华赌博任务、N-back、数字广度、Go/No-Go,到哥伦比亚卡片任务、天气预测、跨期选择等十余个经典范式,横向则给出三项关键指标:Centaur 的负对数似然、原始 Llama 的负对数似然、以及对应领域被公认为最强的手工认知模型的负对数似然,并以 ΔNLL 形式让差距一目了然。结果清晰地刻画出一条“压倒性曲线”——在 159 个条目中,Centaur 的数字均小于对手,意味着它对未被训练过的参与者行为具有更精确的预测;平均而言,它比领域专用模型低 0.13 nats,比未微调的 Llama 低 0.14 nats。这种优势并不局限在某一类任务:在需要工作记忆更新的 N-back 里,它领先 0.11 nats;在需要风险权衡的爱荷华赌博任务里,领先 0.15 nats;在需要模型化学习的两步任务里,领先 0.18 nats;甚至在需要简单记忆保持的数字广度任务里,也稳稳领先 0.09 nats。这种跨任务、跨范式、跨复杂度层级的持续领先,使得整张表成为 Centaur 作为“大一统”认知模型的最有力注脚,也将正文图 2a 的柱状图结论落到了每一个具体实验的数值实处。

-- END --

关注“学姐带你玩AI”公众号,回复“2025大模型”

领取2025大模型创新方案合集+开源代码

![2025年全球及中国服务器PCB行业产业链、发展背景、市场规模及未来趋势分析:行业规模迅速扩张,核心增量集中于AI服务器领域[图]](https://xtechcon-static.oss-cn-chengdu.aliyuncs.com/xtimes/xtimes/images/2026-02-03/69814903db082.jpeg)