摘要

Abstract

来自麦吉尔大学、清华大学、小米公司和威斯康辛麦迪逊大学的研究团队联合发布了全球首篇针对自动驾驶领域的视觉-语言-行动(Vision-Language-Action, VLA)模型的全面综述。

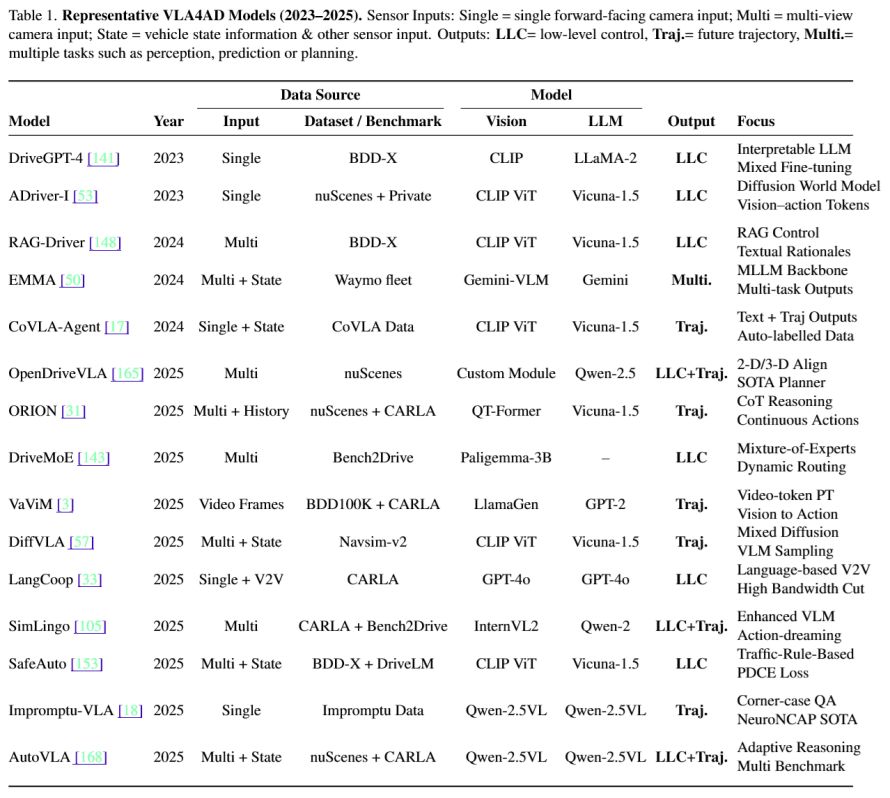

该论文系统性地梳理了VLA模型在自动驾驶(VLA4AD)领域的前沿进展,深入剖析了VLA模型在自动驾驶领域的架构演进、核心技术与未来挑战。

一、 自动驾驶的技术范式演进

自动驾驶技术正从简单的感知-控制,向更高级的认知智能演进,最新的自动驾驶模型可以分为三大范式:

●端到端自动驾驶 (End-to-End AD): 将传感器输入直接映射到驾驶动作。此模式高效但缺乏可解释性,难以处理需要高级推理的“长尾”场景。

●用于自动驾驶的视觉语言模型 (VLMs for AD): 引入视觉语言模型来理解和解释复杂的交通场景,显著提升了系统的可解释性。但其输出的语言与车辆的实际控制脱节,存在“行动鸿沟”。

●用于自动驾驶的视觉-语言-行动模型 (VLA for AD): 当前最新的范式。它在一个统一模型中整合视觉感知、语言理解和动作执行,实现了感知、推理和行动的闭环。车辆遵循自然语言指令直接输出动作或者轨迹。

二、 VLA自动驾驶模型的核心架构

一个典型的VLA模型由输入、处理、输出三部分构成,旨在无缝整合环境感知、高级指令理解与最终的车辆控制。

1.多模态输入 (Inputs):

○视觉与传感器数据:视觉是系统的核心输入,技术已从早期的单前视摄像头发展到如今的多摄像头环视系统。为增强空间感知,系统还融合了多种传感器,包括用于精确3D结构的激光雷达(LiDAR)、用于速度估计的雷达(RADAR)、用于运动追踪的惯性测量单元(IMU)以及用于全局定位的GPS。原始图像可以被直接处理,或转换为鸟瞰图(BEV)等结构化表示,以辅助空间推理。

○语言指令 (Language):语言输入的形式日趋丰富,其演进路径清晰地展示了人机交互的深化:

■直接指令:如“在下一个路口左转”。

■环境查询:如“现在变道安全吗?”。

■任务级指令:用自然语言解析高阶目标,如“安全地把我送到办公室”。

■对话式推理:支持多轮对话和基于“思维链(CoT)”的复杂推理,甚至包括语音指令输入。

2.核心处理模块 (Core Modules):

○视觉编码器:负责将原始图像和传感器数据转换为模型可以理解的潜在表征。通常使用如DINOv2或CLIP等大型自监督模型作为骨干网络。

○语言处理器:使用预训练的语言模型(如LLaMA2或GPT系列)来处理自然语言指令。通过指令微调或LoRA等轻量化策略,高效地让模型适应自动驾驶领域的特定知识。

○动作解码器:负责生成最终的控制输出,其实现方式主要有三种:

■自回归令牌化:将连续的轨迹点或离散的动作(如“加速”、“左转”)作为Token,并依次生成。

■扩散模型:基于融合后的特征,通过采样生成连续的控制信号。

■分层控制器:由一个高阶的语言规划器生成子目标(如“超车”),再由一个低阶的PID或MPC控制器来执行具体轨迹。

3.驾驶输出 (Outputs):

○低阶动作:直接输出方向盘转角、油门和刹车等原始控制信号。这种方式可以实现精细控制,但对感知误差敏感,缺乏长远规划能力,且在不同车型间的拓展性较差。

○轨迹规划:输出一系列未来路径点(Waypoints)。这种方式具有更好的可解释性和拓展性,可以由下游的规划器灵活执行,也使得VLA模型能进行更长时程的推理。

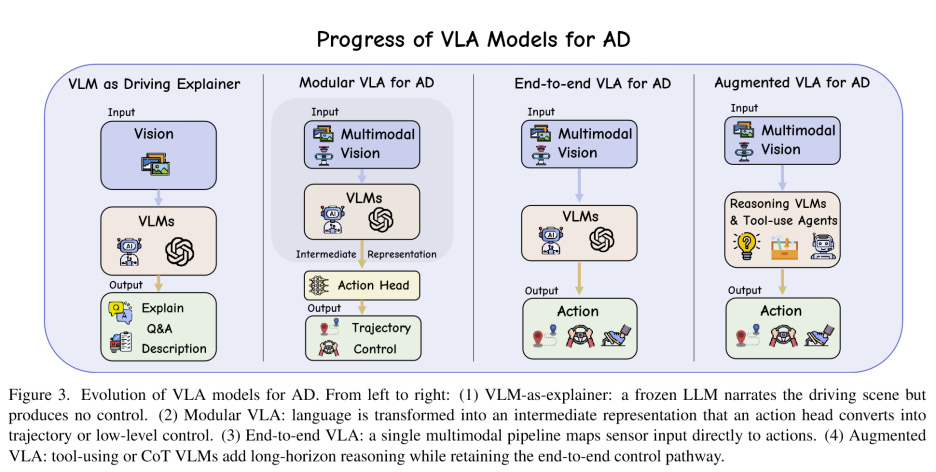

三、 VLA自动驾驶模型的四大发展阶段

综述将VLA的发展划分为四个阶段,清晰地展示了语言在自动驾驶系统中角色和能力的演进:从一个被动的“解释者”,逐步成长为主动的“规划者”,最终演变为具备高级推理能力的“决策核心”。

●第一阶段:语言作为解释器 (Pre-VLA: Language as Explainer)

在最初的探索中,语言模型被用作一个被动的描述工具,其核心目标是增强系统的可解释性。这类系统(如DriveGPT-4)在感知到驾驶场景后,由语言模型生成自然语言描述(如“减速,因为前方有行人”),但这些描述并不直接参与车辆控制。这种模式很快暴露了延迟高、效率低等问题。尽管后续通过注意力聚焦等技术有所优化,但一个根本性的“语义鸿沟”依然存在:描述场景不等于生成精确的驾驶指令。

●第二阶段:模块化VLA (Modular VLA)

随着研究深入,语言的角色从被动的“评论员”演变为模块化架构中主动的“规划组件”。语言的输入和输出开始直接为规划决策提供信息。这些方法显著缩小了语言和行动的差距,但其普遍依赖的多阶段处理流程(感知→语言规划→控制)不仅引入了延迟,还在各模块边界处带来了级联错误的风险。

●第三阶段:统一的端到端VLA (End-to-End VLA)

受益于大型多模态模型的出现,研究者们开始构建完全统一的网络,在一个单一的前向传播中,将传感器输入直接映射到驾驶动作。此类模型往往通过改变语言指令来想象不同驾驶结果,从而强制建立了语言与轨迹的紧密耦合。这些端到端模型反应灵敏,但在长时程规划(如提前预判远处复杂路况)和提供细粒度决策解释方面仍然存在困难。

●第四阶段:推理增强的VLA (Reasoning-Augmented VLA)

它将LLM置于控制环路的核心,使模型超越简单的指令响应,朝着长时程推理、记忆和交互的方向发展。系统不再仅仅是反应,而是在输出动作前,能够进行解释、预测和推理。这类模型学会了将思维链(CoT)和推理纳入决策并赋能动作输出。此类系统预示着将 VLA 自动驾驶与前沿基座模型技术结合的潜力,使得自动驾驶车辆可突破传统的“指令到响应”模式,赋能系统实现跨场景的长时程推理、持续记忆管理以及动态人机交互。

四、 数据集与基准

高质量、多样化的数据集是推动VLA研究的基石。当前的数据集生态系统已覆盖:

●大规模真实世界数据(如nuScenes, BDD-X),提供丰富的多传感器信息和人类驾驶解释。

●关键场景与安全测试(如Impromptu VLA, Bench2Drive),专注于对安全至关重要的“长尾”和边缘案例。

●细粒度推理数据(如Reason2Drive, DriveLM),提供结构化的语言标注,用于训练模型的复杂推理能力。

五、 挑战与未来展望

尽管VLA4AD进展显著,但距离大规模部署仍面临六大挑战与五大机遇。

核心挑战:

1.鲁棒性与可靠性:如何应对模型“幻觉”、传感器噪声和语言歧义,并对AI决策进行安全验证。

2.实时性能:在算力有限的车载硬件上高效运行大型VLA模型。

3.数据瓶颈:包含视觉、语言、行动三模态的标注数据稀缺且昂贵。

4.多模态对齐:如何有效融合摄像头、雷达、激光雷达、高精地图等异构数据。

5.多智能体社会复杂性:如何在密集的城市交通中进行安全、高效的车辆间协作。

6.泛化与评估:如何让模型适应不同国家和地区的交通环境,并建立统一的“AI驾照考试”标准。

未来方向:

1.基础驾驶大模型: 构建一个通用的“GPT for Driving”基础模型,通过少量数据微调即可适配不同车型和任务。

2.神经-符号安全内核: 结合神经网络的灵活性与符号逻辑的可验证性,确保决策的绝对安全。

3.车队级持续学习: 利用整个车队的数据实现模型的快速迭代和知识共享。

4.标准化交通语言: 建立一套车辆间沟通的标准协议,实现高效协同。

5.跨模态社交智能: 让车辆能够理解交警手势、行人意图等非语言类的社会性交通信息。

项目链接:

GitHub:https://github.com/JohnsonJiang1996/Awesome-VLA4A

Arxiv: https://arxiv.org/abs/2506.24044

往期文章

具身专栏(三)| 具身智能中VLA、VLN、VA中常见训练(training)方法

具身专栏(二)| 具身智能中VLA、VLN分类与发展线梳理

具身专栏(一)| VLA、VA、VLN概述

π0.5:突破视觉语言模型边界,首个实现开放世界泛化的VLA诞生!

斯坦福&英伟达最新论文:CoT-VLA模型凭"视觉思维链"实现复杂任务精准操控

RoboTwin2.0全面开源!多模态大模型驱动的双臂操作Benchmark ,支持代码生成!

开源!Maniskill仿真器上LeRobot的sim2real的RL训练代码开源(附教程)

迈向机器人领域ImageNet,大牛PieterAbbeel领衔北大、通院、斯坦福发布RoboVerse大一统仿真平台

CVPR 北大、清华最新突破:机器人操作新范式,3.3万次仿真模拟构建最大灵巧手数据集

人形机器人四级分类:你的人形机器人到Level 4了吗?(附L1-L4技术全景图)建议收藏!

斯坦福最新论文:使用人类动作的视频数据,摆脱对机器人硬件的需求

爆发在即!养老机器人如何守护2.2亿老人?产业链+政策一览,建议收藏!