作者 | 大家好我是爱因

转自 |

原文链接:https://zhuanlan.zhihu.com/p/1948475982827750403

点击下方卡片,关注“大模型之心Tech”公众号

本文只做学术分享,如有侵权,联系删文,自动驾驶课程学习与技术交流群事宜,也欢迎添加小助理微信AIDriver004做进一步咨询

论文名称:RL’s Razor: Why Online Reinforcement Learning Forgets Less

论文链接:https://arxiv.org/pdf/2509.04259

机构:MIT Improbable AI LabTL;DR

本论文系统比较了在相同新任务性能前提下,reinforcement learning(RL)与 supervised fine-tuning(SFT)对“旧能力保留”的差异:RL 显著更不易产生 catastrophic forgetting。作者提出一条可操作的“遗忘经验律”:只用“新任务分布”即可预测遗忘程度——即以新任务样本估计的前向 KL, 。

进一步实验与理论表明,on-policy 的 RL 天然偏向“KL-最小解”,在等性能下产生更小的分布漂移;SFT 则可能收敛到距离基模更远的解。作者将此原则命名为“RL’s Razor”:在能同样解决新任务的多种策略中,RL 更倾向选择离原策略 KL 最近的那一个。

这一视角统一解释了多域实证结果,并启示未来后训练方法应显式控制相对基模的 KL 漂移以降低遗忘。

一、研究背景与动机

大规模 Foundation Model 在语言、视觉、机器人等领域成为基础能力载体,但现实部署多为“静态”:上线后主要依赖既有能力,缺乏持续自我改进与在线适应。

一旦为满足新需求进行后训练,模型常出现 catastrophic forgetting,即对既有广泛能力的显著退化。这直接制约了“long-lived agents”愿景的落地。既有缓解方法多从参数约束、特征保持或输出正则化出发,但多是治标而非溯源。

本文将视角聚焦于两条主流后训练范式:SFT 与 RL,提出“为何在同等新任务效果下,RL 更不易遗忘”的统一解释,并给出可测、可控的遗忘预测指标(仅依赖新任务分布)。

二、核心思路或方法

核心结论有三:

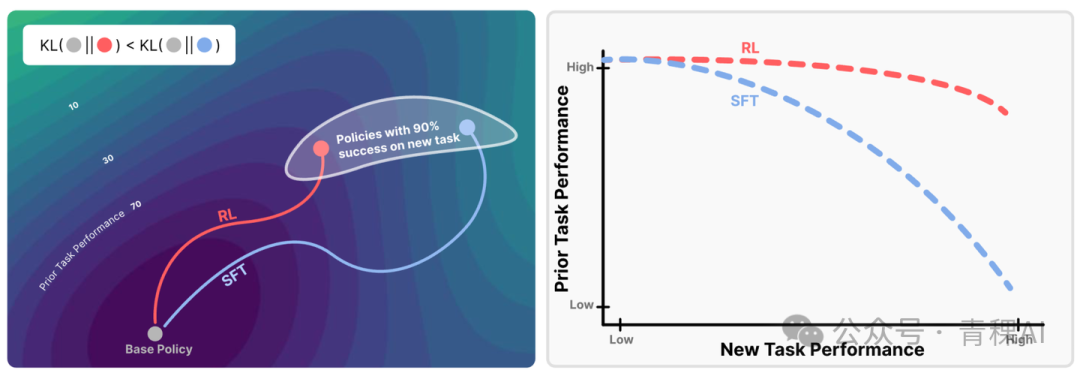

其一,RL 在新任务上达到与 SFT 相当的性能时,旧任务保留显著更好(如图 2)。

图 2:RL 与 SFT 的帕累托前沿。

比较微调模型在新任务(横轴)和旧任务(纵轴)上的表现。每个点对应一组不同超参数训练得到的模型,曲线描绘了两种方法的帕累托前沿。RL 在保持已有知识的同时实现了新任务的提升,而 SFT 则是在提升新任务性能的同时以遗忘旧任务为代价。

其二,遗忘度可由“新任务上的前向 KL”高精度预测: 越小,遗忘越少(如图 3 中图,R² 在玩具环境达 0.96,在 LLM 任务达 0.71)。

图 3:KL 散度预测灾难性遗忘。

(左)学习-遗忘权衡:只有在使用“oracle 分布”作为标注来源时,SFT 才优于 RL。

(中)当遗忘程度与 KL 散度作图时,结果汇聚到一条曲线上,表明 KL 是跨方法的强预测指标。

(右)与 SFT 相比,RL 通过更小的 KL 偏移即可提升新任务准确率,凸显了基于 on-policy 更新的保守性。

其三,这一差异源于 on-policy:RL 每步从当前策略采样并按优势/奖励重加权,更新偏好“离起点更近”的分布;SFT 则被外部标注分布牵引,可能被“拉”向任意、且与基模相距很远的解。作者将之概括为“RL’s Razor”。

为控制变量,论文构造四类训练目标并横向对比:

(1)GRPO(on-policy,含负例梯度);

(2)1–0 Reinforce(on-policy,仅正例重加权);

(3)SFT(offline,无负例);

(4)SimPO(offline,含负例)。

结果显示:决定性因素是“是否 on-policy”,而非“是否用负例梯度”(如图 4 中右图的 KL 曲线)。

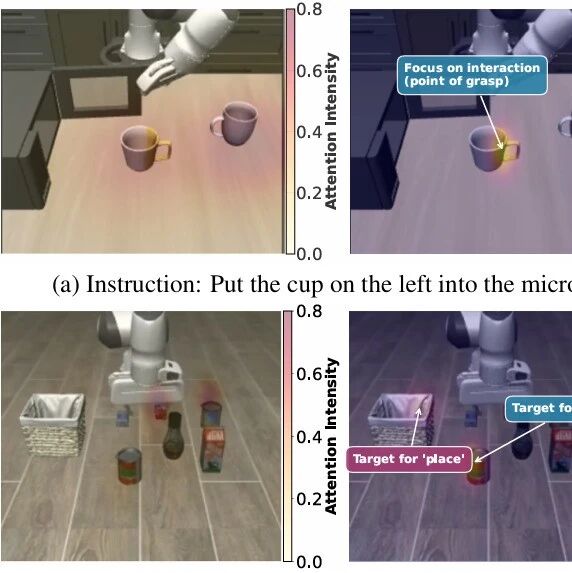

图 4:算法类别比较。

(左)四个象限展示了不同的算法类型,根据其是否为 on-policy 或 offline,以及是否引入负梯度来划分。

(中)on-policy 方法能够更有效地保留已有知识。

(右)GRPO 和 1-0 Reinforce 都在实现更高新任务准确率的同时,仅产生较小的 KL 偏移,说明 on-policy 方法在 KL 更新上始终更为保守。

理论上,作者以概率空间投影视角刻画 RL 更新:一次 RL 可理解为先对“奖励=1”的可行集做 I-projection(拒绝采样的条件分布),再对可表征策略族做 M-projection,从而沿“最小 KL 路径”逼近最优解(如图 5)。

定理进一步说明,在二值奖励与适当条件下,策略梯度将收敛到“表征族与最优集交集中相对初始策略 KL 最小”的策略。这为“RL 偏向 KL-最小解”提供了原则性支撑。

三、实验设计与主要结论

数据与任务设置(跨 LLM 与机器人):

(1)LLM-Math:Qwen 2.5 3B-Instruct 在 Open-Reasoner-Zero 数学题上微调;

(2)LLM-Science Q&A:同基模在 SciKnowEval 化学 L-3 子集训练;

(3)LLM-Tool Use:在 ToolAlpaca 上训练工具调用;

(4)Robotics:OpenVLA-7B 在 SimplerEnv 做“拾取易拉罐”新任务。

旧能力评估覆盖 HellaSwag、TruthfulQA、MMLU、IFEval、Winogrande、HumanEval 等多基准;机器人则在与微调任务不同的 SimplerEnv 子任务上测“泛化操控”成功率。训练均进行大范围超参扫描,绘制“新任务表现—旧任务保留”的双目标 Pareto 前沿(如图 2)。

主结果1(RL vs SFT 的 Pareto 前沿)

在三个 LLM 任务与一项机器人任务中,RL 前沿普遍“右上移”,即在相同新任务精度下有更高的旧任务得分;或在相同旧任务保留水平下能取得更高新任务表现。

以数学任务为例,SFT 的新任务小幅提升常伴随旧能力急剧下降;而 RL 提升更“保守”,旧基准几乎不动(如图 2 左上)。在 Science Q&A 与 Tool Use,随新任务逼近高精度,SFT 旧能力开始快速下滑,而 RL 仍基本稳定。机器人“拾取”场景亦复现相同趋势。结论:RL 在“学新不忘旧”方面显著优于 SFT。

主结果2(KL 经验律)

在可控的 ParityMNIST 玩具设定中(新任务为“奇偶分类”,多解同优),作者令预训练 MLP 同时学 ParityMNIST 与 FashionMNIST,并在微调阶段仅看新任务。

以 FashionMNIST 性能度量遗忘,发现不同方法/超参造成的“学习—遗忘”点,若以前向 KL 为横轴、遗忘为纵轴,会“坍缩”为一条函数曲线(R²≈0.96),表现出极强预测力;

而参数 L1/Fisher-L2/谱范数、隐表征漂移、更新稀疏性/秩等候选变量均不及前向 KL(详见表 1)。在 LLM 真实任务,前向 KL—遗忘的二次拟合亦有较强相关(R²≈0.71)。结论:遗忘主要由“新任务上的前向 KL 漂移”决定。

主结果3(on-policy 才是关键)

四类目标的对比显示:1–0 Reinforce 与 GRPO(均为 on-policy)在同等新任务精度下的 KL 漂移远小于 SFT/SimPO(offline),且旧能力保留也更好(如图 4)。

这说明“是否 on-policy”是导致“忘得少”的根本因素,而“是否含负例梯度”并非必要条件(SimPO 含负例但仍忘得多;1–0 Reinforce 无负例仍不易忘)。

主结果4(Oracle SFT 与蒸馏验证)

作者在 ParityMNIST 中构造“KL-最小且 100% 正确”的 oracle SFT 标注分布。用其训练的 SFT 比 RL 还“忘得更少”,获得全局最优的“精度—保留”权衡(如图 3 左)。

此外,将 RL 学到的分布蒸馏为 SFT,能复现 RL 的曲线(如图 9)。两点共同佐证:算法本身不是决定遗忘的根因,“学到的分布与基模的 KL 距离”才是。

图 9:从 RL 教师模型蒸馏到 SFT。

新任务(MNIST)与旧任务(FashionMNIST)之间的准确率权衡。通过调整学生模型的超参数,可以看到 SFT 在两个任务上都能在噪声范围内匹配教师模型。这表明关键不在于优化路径,而在于最终模型的分布。

Ablation 与替代解释检验:作者全面评测了

(1)参数层变化(L1、Fisher-L2、谱范数);

(2)表征层漂移(隐层激活距离);

(3)更新稀疏性/秩(指出 bfloat16 导致“小更新量不可表示”的“伪稀疏”现象,用 float32 即消失);

(4)多种分布距离(反向 KL、TV、L2)。

结论如表 1:只有“前向 KL(以新任务估计)”拥有稳定且最高的解释力,反向 KL 次之,TV 与 L2 中等,其余指标弱相关或无效(例如“秩”为满秩)。

方法学细节:LLM 侧采用统一提示集、对新任务与旧基准分离评测,并通过大规模超参扫描寻找 Pareto 前沿;RL 采用 GRPO,奖励仅用“成败二值”,不显式加 KL 正则,强调这是“隐式 KL 最小化”的自然产物。

玩具环境保证对比能完整收敛与系统消融。理论侧以“I/M 投影—EM”视角给出收敛到“KL-最小最优解”的条件化结论,为经验观察提供统一解释框架。

四、论文意义与可能应用

工程启示:

(1)将“相对基模的前向 KL(以新任务样本估计)”纳入训练/早停/超参搜索的监控指标,可在训练中前瞻性规避遗忘;

(2)当必须走 SFT 路线时,尽可能让监督分布贴近基模(如用“RL 生成的数据”或“oracle/近似 oracle 标注策略”),即可获得与 RL 相近的保留性;

(3)对 RL,则可在不显式 KL 正则的情况下,通过 on-policy 设计自然获得更保守的漂移;

(4)连续学习/在线部署中,将“与基模的 KL 移动量”作为第一类约束(和 compute、latency 同级)是可行而且高性价比的策略。

五、个人点评或未来展望

优点:提出了“只看新任务分布即可预测遗忘”的极简经验律,并用跨域实证+投影几何的理论化解释统一了 RL 与 SFT 的差异,给出了可落地的监控与控制指标。

局限与展望:

(1)机制层面仍缺更细致的“何以 KL 漂移会破坏旧能力”的表征学解释;

(2)前向 KL 的估计在大模型与复杂输出空间上仍有方差与近似误差;

(3)前沿规模与多模态生成(如 MLLM、行动序列)上的普适性仍待验证;

(4)离线但“近似 on-policy”的算法(例如带重要性修正/自蒸馏的半在线范式)或许可兼得数据效率与低遗忘,值得深入探索。

总体来看,“RL’s Razor”提供了后训练研究的新坐标系:不再仅以新任务指标论英雄,而要同时度量“相对基模的 KL 位移”,在最小位移的解中取最优,从而让模型“学新而不忘旧”。

大模型之心Tech知识星球交流社区

我们创建了一个全新的学习社区 —— “大模型之心Tech”知识星球,希望能够帮你把复杂的东西拆开,揉碎,整合,帮你快速打通从0到1的技术路径。

星球内容包含:每日大模型相关论文/技术报告更新、分类汇总(开源repo、大模型预训练、后训练、知识蒸馏、量化、推理模型、MoE、强化学习、RAG、提示工程等多个版块)、科研/办公助手、AI创作工具/产品测评、升学&求职&岗位推荐,等等。

星球成员平均每天花费不到0.3元,加入后3天内不满意可随时退款,欢迎扫码加入一起学习一起卷!