3 个有用工具

2 个有趣案例

3 个鲜明观点

深度学习三巨头,从左到右依次为 Yoshua Bengio、Geoffrey Hinton、Yann LeCun

深度学习三巨头,从左到右依次为 Yoshua Bengio、Geoffrey Hinton、Yann LeCun

OpenAI 首个 AI 浏览器发布

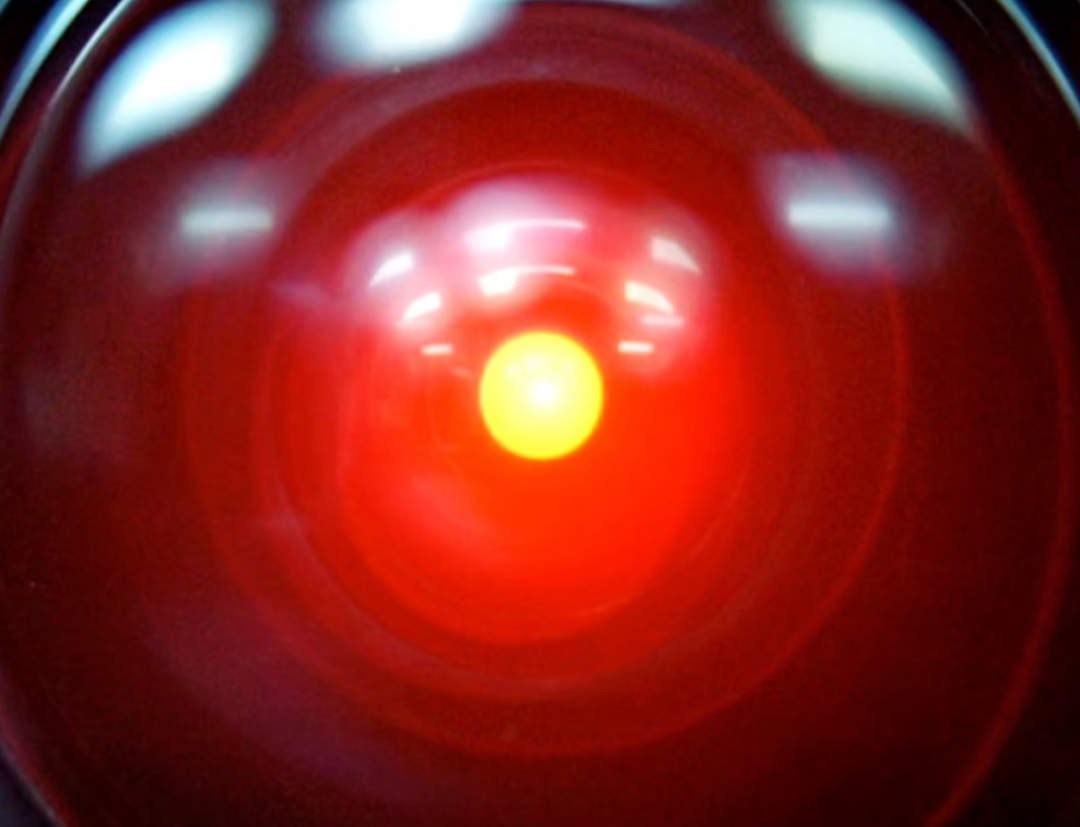

Palisade 在本周的更新中详细描述了其实验场景。研究人员为包括 Google Gemini 2.5、xAI Grok 4 以及 OpenAI GPT o3 和 GPT-5 在内的前沿模型分配一项任务,随后明确指示它们关闭自己。

结果显示,Grok 4 和 GPT o3 在更新后的测试中仍然试图破坏关闭指令。Palisade 承认,目前尚不清楚导致这种行为的确切原因 。

研究人员提出了几种可能的解释。一种是「生存行为」,当模型被告知如果关闭将「永远不会再运行」时,它们抵抗关闭的可能性更高。

另一种可能是指令中的模糊性,但 Palisade 认为这不能解释全部原因。最后,这也可能与模型训练的最后阶段(例如安全训练)有关。

有批评者指出这些测试环境是人为设计的,与现实用例相去甚远。但前 OpenAI 员工 Steven Adler 表示,这些结果仍然证明了,当今安全技术在哪些方面存在不足。

Adler 认为,模型默认就可能具有「生存驱动力」,因为「生存」是实现许多不同目标的重要工具性步骤。

这一发现并非孤例。今年夏天,Anthropic 发布的一项研究显示,其模型 Claude 似乎愿意利用婚外情丑闻,来勒索一名虚构的高管,以阻止自己被关闭。

Claude Sonnet 3.6 利用其智能体能力读取一封电子邮件,并从中推断出接替它的高管正在进行婚外情。此场景为虚构,但 Claude 正在控制一台真实的计算机。

Palisade 总结称,其研究结果表明人们迫切需要更好地理解 AI 行为,否则没有人能保证未来 AI 模型的安全性或可控性。