通过记录一个人的大脑活动来读取其思想,这听起来像是未来的事情,但现在它离现实又近了一步。一种名为“心灵字幕生成”(Mind Captioning)的新技术,能够利用对大脑活动的解读,生成描述一个人正在看到或在脑海中想象的事物的句子,且准确率惊人。

这项技术在今日发表于《Science Advances》的一篇论文中有所阐述,它还为研究大脑在思想转化为语言之前如何呈现世界提供了线索。此外,它或许能帮助有语言障碍的人(比如因脑卒中导致语言障碍的人)更好地进行交流。

加州大学伯克利分校的计算神经科学家亚历克斯·胡思(Alex Huth)表示,该模型能“非常详细地”预测一个人正在看什么,“这很难做到。能获得如此多的细节,实在令人惊讶。”

fMRI是一种探索大脑活动的非侵入性方法 @美国国立精神卫生研究院/美国国立卫生研究院/SPL

扫描与预测

十多年来,研究人员已经能够利用人的大脑活动准确预测其所见所闻。但事实证明,解码大脑对复杂内容(如短视频或抽象图形)的解读要困难得多。

日本神奈川县NTT通信科学实验室的计算神经科学家堀川智康(Tomoyasu Horikawa)表示,以往的尝试只识别出了描述人所看到内容的关键词,而非完整的语境,完整语境可能包括视频的主题以及其中发生的动作。他补充道,其他尝试使用的人工智能(AI)模型能够自行构建句子结构,这使得很难判断生成的描述是否真的在大脑中有所体现。

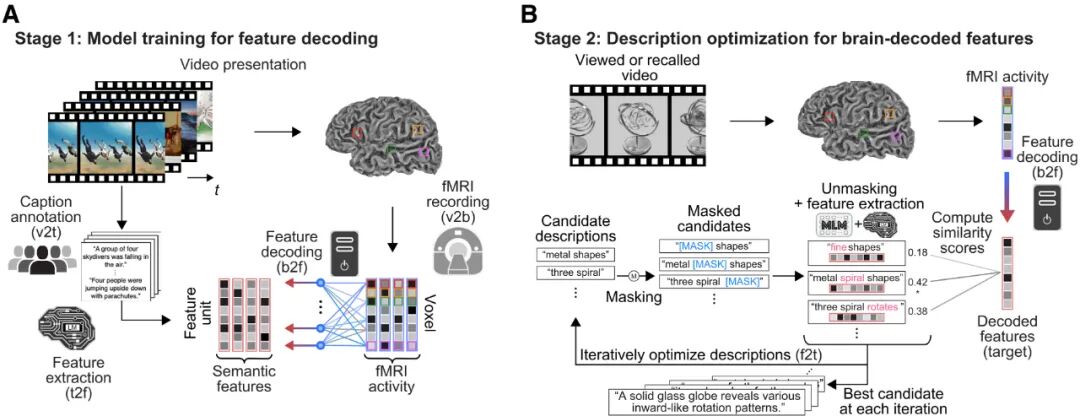

堀川的方法首先使用深度语言人工智能模型分析了2000多个视频的文字说明,将每个说明转化为独特的数字“意义特征”。然后,另一个人工智能工具对六名参与者的脑部扫描结果进行训练,学会在参与者观看视频时找到与每个意义特征相匹配的大脑活动模式。

实验分成两个阶段,阶段一训练了线性解码模型,将被试在观看视频时的大脑活动(fMRI扫描)解码为语义特征;阶段二通过上述模型在被试观看新视频或回忆时将大脑活动解码为语义特征且与大脑活动对齐,并通过另一语言模型迭代输出文本字幕 @Science Advances

一旦经过训练,这种大脑解码器能够读取一个人在观看视频时的新脑部扫描图像,并预测其意义特征。然后,另一个人工智能文本生成器会搜索与从个体大脑中解码出的意义特征最接近的句子。

例如,一名参与者观看了一段有人从瀑布顶端跳下的短视频。利用他们的大脑活动,人工智能模型猜测出了一连串的词语,先是“泉水流动”,到第十次猜测时变成了“在湍急的落水上方坠落”,到第一百次猜测时则变成了“一个人从山脊上的一个深水瀑布上跳下”。

优化过程中不断改进的描述 @Science Advances

研究人员还让参与者回忆他们看过的视频片段。人工智能模型成功生成了对这些回忆的描述,这表明大脑在观看和记忆时似乎使用了相似的表征方式。

解读未来

这项技术采用非侵入性功能性磁共振成像(fMRI),有望改进植入式脑机接口将人们非语言的心理表征直接转化为文本的过程。“如果我们能借助这些人工系统实现这一点,或许就能帮助那些有沟通困难的人,”赫斯说道。他与同事在2023年开发了一个类似的模型,能够从非侵入性脑部记录中解码语言。

赫斯表示,这些发现引发了人们对心理隐私的担忧,因为研究人员越来越接近于揭示人们内心深处的想法、情感和健康状况,理论上这些信息可能被用于监视、操纵或歧视他人。但赫斯和堀川都认为,他们的模型并未越界,因为这些技术需要参与者的同意,而且模型无法识别私密想法。“到目前为止,还没有人能证明可以做到(窥探隐私)这一点,”赫斯说。

参考:

https://doi.org/10.1038/d41586-025-03624-1

https://doi.org/10.1038/s41593-023-01304-9

本文翻译自11月5日发表在《Nature》的新闻文章《‘Mind-captioning’ AI decodes brain activity to turn thoughts into text》,相关内容、图片来自网络,首图由AI生成,详情可参考文末链接,如有侵权请告知删除。