一觉醒来看到了 SGLang 支持了 Diffusion 系列模型的部署,非常激动!

先来看看使用 SGLang部署Qwen-Image-Edit 使用下面的命令生成 “书生抱着 SGLang 广告牌”的效果图。

sglang generate \

--prompt="图片中的书生抱着 SGLang 的广告牌”" --image-path="https://cdn.vansin.top/cute_intern.png" --model-path=Qwen/Qwen-Image-Edit \

--width=1024 --height=1024 --save-output

耗时 102 秒,后面可以批量生成「书小生」表情包创意,书小生要出圈了。

接下来我们来看看官方博客内容

https://lmsys.org/blog/2025-11-07-sglang-diffusion/

我们很高兴推出 SGLang Diffusion,它将 SGLang 的最先进性能带入扩散模型的图像与视频生成加速。SGLang Diffusion 支持主要的开源视频和图像生成模型(Wan、Hunyuan、Qwen-Image、Qwen-Image-Edit、Flux),同时通过多种 API 入口(兼容 OpenAI 的 API、CLI、Python 接口)提供快速推理速度和易用性。SGLang Diffusion 在各种工作负载上实现了 1.2x–5.9x 的加速。我们与 FastVideo 团队合作,提供从后训练到生产部署的完整扩散模型生态系统。代码可在此获取。

SGL Diffusion 在 H100 GPU 上的性能基准

SGL Diffusion 在 H100 GPU 上的性能基准

为什么在 SGLang 中使用扩散?

随着扩散模型成为最先进的图像和视频生成的基石,我们听到了社区强烈的需求,希望将 SGLang 标志性的性能和无缝的用户体验带到这些新模态中。我们构建了 SGLang Diffusion 来响应这一呼声,提供一个统一的、高性能的引擎,既适用于语言任务,也适用于扩散任务。

这种统一的方法至关重要,因为生成的未来在于结合不同架构。开创性的模型已经在融合自回归(AR)和扩散方法的优势——从像字节跳动的 Bagel 和 Meta 的 Transfusion 这类用单个 transformer 同时处理两种任务的模型,到 NVIDIA 的 Fast-dLLM v2,该模型将 AR 模型改造为并行生成。

SGLang Diffusion 旨在成为一种面向未来的高性能解决方案,准备为这些创新系统提供动力。

Architecture 架构

SGLang Diffusion 专为性能与灵活性而设计,构建在经受过考验的 SGLang 服务架构之上。它继承了强大的 SGLang 调度器,并重用高度优化的 sgl-kernel,以实现最大效率。

在核心上,我们的架构旨在适应现代扩散模型的多样化结构。我们引入了 ComposedPipelineBase ,一种灵活的抽象,用来编排一系列模块化的 PipelineStage 。每个阶段封装了一个通用的扩散功能——例如在 DenoisingStage 中的去噪循环或在 DecodingStage 中的 VAE 解码——使开发者能够轻松地组合和重用这些组件,以构建复杂的、定制化的流水线。

为了实现最先进的速度,我们整合了先进的并行技术。其在核心 Transformer 块中支持统一序列并行(USP)——一种 Ulysses-SP 与 Ring-Attention 的组合,同时对于其他模型组件支持 CFG 并行和张量并行(TP)。

为了加速开发并培育一个强大的生态系统,我们的系统建立在 FastVideo 的增强分支之上,并且与他们的团队密切合作。 这种合作使 SGLang Diffusion 能专注于提供尖端的推理速度,而 FastVideo 则为诸如模型蒸馏等与训练相关的任务提供全面支持。

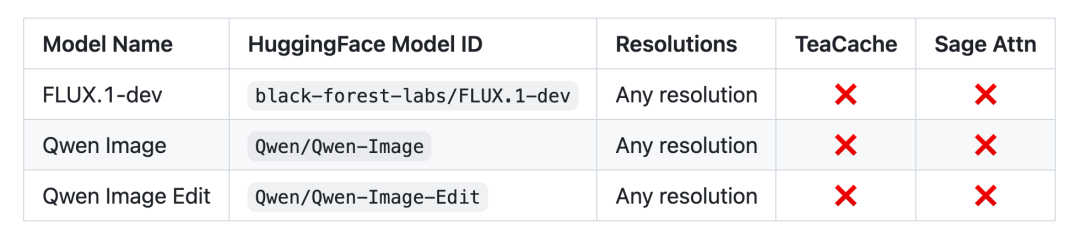

Model Support 模型支持

我们支持多种流行的开源视频和图像生成模型,包括:

视频模型:Wan 系列、FastWan、混元(Hunyuan)

图像模型:Qwen-Image、Qwen-Image-Edit、Flux

视频模型

图片生模型

使用

为了提供无缝的用户体验,我们提供了一套熟悉的界面,包括命令行界面(CLI)、Python 引擎 API 以及兼容 OpenAI 的 API,允许用户以最小的工作量将扩散生成集成到他们的工作流程中。

Install 安装

SGLang Diffusion 可以通过多种方式安装:

# with pip or uv

uv pip install 'sglang[diffusion]' --prerelease=allow

# from source

git clone https://github.com/sgl-project/sglang.git

cd sglang

uv pip install -e "python[diffusion]" --prerelease=allow

CLI 命令行界面

启动服务器,然后发送请求:

sglang serve --model-path black-forest-labs/FLUX.1-dev

curl -s -D >(grep -i x-request-id >&2) \

-o >(jq -r '.data[0].b64_json' | base64 --decode > meme.png) \

-X POST "$OPENAI_API_BASE/images/edits" \

-H "Authorization: Bearer $OPENAI_API_KEY" \

-F "model=Qwen/Qwen-Image-Edit" \

-F "image[]=@example.jpg" \

-F 'prompt=Create a meme based on image provide'

或者,在不启动服务器的情况下生成图像:

sglang generate --model-path black-forest-labs/FLUX.1-dev \

--prompt "A Logo With Bold Large Text: SGL Diffusion" \

--save-output

Demo 演示 (Image to Image: Qwen-Image-Edit)

sglang generate \

--prompt="图片中的书生抱着 SGLang 的广告牌”" --image-path="https://cdn.vansin.top/cute_intern.png" --model-path=Qwen/Qwen-Image-Edit \

--width=1024 --height=1024 --save-output

性能基准

我们将 SGLang Diffusion 的性能与一个流行的开源基线 Huggingface Diffuser 进行了基准测试。正如本帖顶部图表所示,SGLang Diffusion 提供了最先进的性能,显著加速了图像和视频的生成。

Roadmap and Diffusion Ecosystem

我们的愿景是与 FastVideo 团队合作,构建一个全面的扩散生态系统,提供从模型训练到高性能推理的端到端解决方案。

SGLang Diffusion 团队以持续在性能和模型支持方面创新为核心:

模型支持与优化 优化 Wan、FastWan、混元、Qwen-Image 系列、FLUX 支持 LongCat-Video 内核支持与融合 Quantization kernels Rotary embedding kernels 在 sgl-kernel 中为 Blackwell 集成 Flash Attention 4 更多服务器功能 可配置的云存储上传已生成的文件 Batching support More parallelism methods 量化 总体架构 简化对新模型支持的工作量 增强缓存和注意力后端支持

构建这个生态系统是一个社区的共同努力,我们欢迎并鼓励各种形式的贡献。加入我们,共同塑造开源扩散生成的未来。

感谢 SGLang,小编完成了人生第一次部署 Image To Image 模型,书小生表情包生成启动!!!

等 omni 全模态的模型架构收敛的差不多感觉 SGLang 也要全力支持 omni 模型部署了,期待一波!

![2026年全球及中国芯片测试接口行业市场现状、竞争格局及未来前景展望:全球市场规模增长至近30亿美元,本土企业加速追赶[图]](https://xtechcon-static.oss-cn-chengdu.aliyuncs.com/xtimes/xtimes/images/2026-02-28/69a23e89418be.jpeg)