作者 | 黄婉宜

编辑 | 周伟鹏

终于不用打字打到手软了!

11月21日,豆包输入法1.0正式版发布,它最大的优点就是搭载豆包同款语音识别,识别率高,而且界面完全无广告。

但同时,音效和震动反馈略有延迟,缺少双拼、五笔等专业输入方式,功能上有不少局限。

目前,豆包输入法已在多家应用商店上架。

语音输入实测

确实有点东西

豆包输入法的界面特别简洁清爽,跟微信输入法神似。

操作逻辑跟现在主流输入法差不多,支持拼音、9键/26键、手写、语音、滑行输入等常见输入方式。

其最大亮点是语音识别。

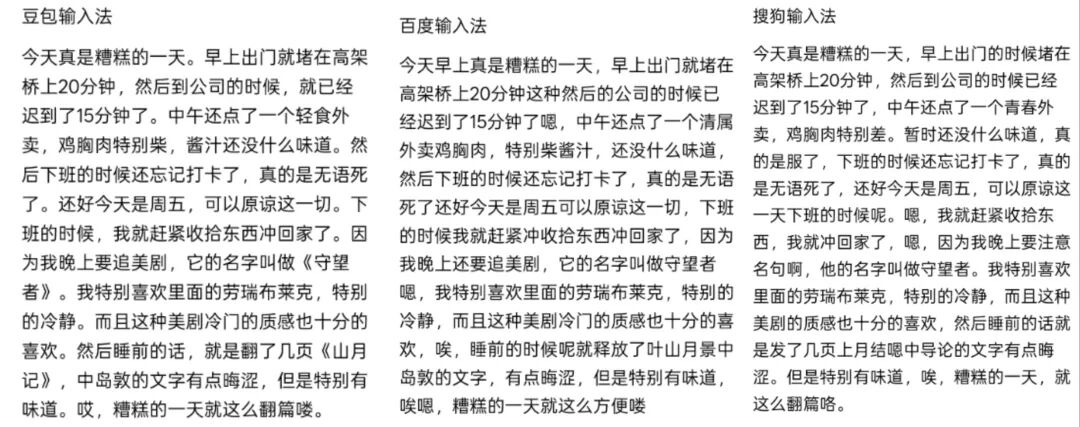

科小编写了段200字左右小作文,特意带着“嗯嗯啊啊”的语气词,说出来模仿平时说话的样子,分别用豆包输入法、搜狗输入法、百度输入法做了测试。

豆包输入法的语音识别基本上是最准的,而且句号、书名号等标点符号用得很得当,还把大部分语气词都去掉了。

百度输入法和搜狗输入法也能识别出大部分意思,但跟豆包输入法比起来,错误不少,比如书名、人名识别不准,还留了很多没用的语气词,看起来很冗长。

再试试冷门电视剧《水龙吟》里的三个角色名,豆包输入法也能精准识别,搜狗和百度还得再努力努力。

上亿点难度,大伙儿有没有听过外企中英文夹杂的说话方式?

科小编找了段日常对话,对三个输入法装了一把。

豆包输入法看得我one愣one愣的,大部分英文都能准确识别,整个句子的语义也很通顺,只是断句上有些小问题,但日常对话完全够用。

搜狗输入法和百度输入法在这方面不是强项,经常出现把中文识别成英文、英文误判为中文的情况,整体通顺度较低,真要用的话得一一纠正,直接打字还更快一些。

至于智能联想功能,豆包输入法能联想文字、标点符号、emoji、公式、日期,实际用下来跟其他输入法差别不大。

语音识别强技术的背后

豆包输入法能有这样的表现,离不开Seed-ASR2.0和豆包老师。

Seed-ASR2.0是字节跳动自研的智能语音识别引擎。

它既能精准捕捉语音信号并转化为文字,还具备DNN降噪能力,能通过AI模型区分语音信号和背景噪音,在嘈杂场景里过滤无效干扰,只留下清晰的人声。

该技术主要负责语音信号的采集、降噪和初步转写,解决“能听清”的基础问题。

而豆包老师则吃了很多东西,在抖音短视频字幕、今日头条新闻、西瓜视频内容等各类场景中到处学习,擅长语义理解和语境判断。

还可以把这些能力用在优化转写结果上,解决“能懂意”的进阶问题。

有了这两者的配合,豆包输入法的语音识别才更贴近日常使用场景,减少错误。

相比之下,传统输入法大多用的是独立ASR语音识别系统,其本质是单纯的语音转文字工具,没有语义理解能力,遇到同音字、专业术语或者语境关联强的表达时,就容易出现误判,也就是我们刚刚测试中遇到的情况。

有数据分析

就会有风险

既然说到大模型,还有个大伙特别关心的问题:它会不会比传统输入法更容易泄露隐私?

传统输入法大多靠本地词库匹配和基础语音转写,数据传输和处理的环节相对简单。

但这类输入法想提供精准联想、跨设备同步等核心功能,大多需要收集用户的输入数据,优化词库和算法,让使用体验更贴合个人习惯。

而这些收集来的数据,如果厂商防护不到位,就可能有泄露风险。

豆包输入法要更智能,豆包大模型就需要分析更多数据,还得通过和云端交互才能处理这些东西,分析技术相对复杂一些。

所以不管是哪种输入法,想实现便捷、智能的功能,都离不开数据的收集和处理,只要这个过程存在,就会伴随着潜在的隐私风险。

但豆包输入法有个隐私模式,叫基础输入,就是入口藏得有点深,得进入APP设置里才能调整,但打开之后,语音转文字、翻译等功能就会完全关闭。

后面的路还很长

目前,豆包输入法刚从内测转为公测,还有很多需要优化的地方。

科小编体验了半天,感觉最大的问题是音效和震动。

本来这俩玩意儿就是为了模仿真实键盘的触碰感,但它的震动反馈有点延迟,给人一种“出错了”的顿挫感。

功能上也比较局限,没有双拼、五笔这类专业输入方式,目前还没有账号同步词库的功能,也没有像微信输入法那样的跨端复制粘贴功能。

皮肤、拆分选词都没有,和搜狗、百度输入法比起来确实逊色一些。

还有,虽然官方声称支持15种方言,但APP里没有明确的方言切换按钮,我试着用粤语语音输入,发现识别准确率很低。

未来的路还很长,但随着AI技术越来越成熟,至少在手机端,语音输入大概率会慢慢成为主流。

•END•