如何让机器像人类一样,既能理解环境又能精准执行动作?传统机器人要么机械执行指令却不懂物理规律,要么能预测环境变化却无法自主决策。

阿里巴巴DAMO Academy联合湖畔实验室与浙江大学推出 WorldVLA——全球首个融合世界模型与动作模型的自回归系统。

动作模型:解析视觉与语言指令,生成抓取、移动等动作序列

世界模型:基于物理规律预测“若执行此动作,环境将如何变化”

两者形成双向增强循环,这种协同改变了传统机器人“盲目执行指令”的局限。

本文将在剖析 VLA 与世界模型各自优势及局限性的基础上,系统阐释 WorldVLA 实现高效性能的核心机理,并结合代码示例展开细致梳理与解读。

VLA模型与世界模型的困境

当前机器人学习领域存在一个尴尬的局面:视觉语言动作(VLA)模型和世界模型各有所长,但也各有局限。这种分离式的架构设计严重制约了机器人系统的整体性能。

VLA模型的优势与不足

VLA模型通过扩展大规模预训练的多模态大语言模型来实现机器人控制,代表性工作包括OpenVLA、π0等。这类模型的主要特点包括:

优势方面:

能够充分利用互联网规模的预训练知识,具备强大的泛化能力;

在感知和决策方面表现出色,能够理解复杂的语言指令;

在开放词汇任务上展现了良好的适应性,可以处理未见过的指令;

继承了大语言模型的推理能力,能够进行复杂的任务规划。

局限性方面:

缺乏对动作的深层理解——动作只作为输出存在,而不能作为输入来帮助模型更好地理解环境;

无法学习环境的物理动力学,对因果关系的理解有限;

在需要精确空间定位的任务上表现不佳;

难以预测动作的长期后果,缺乏前瞻性规划能力。

世界模型的优势与局限

世界模型如iVideoGPT、DWS等专注于预测未来的视觉状态,能够学习环境的物理动力学。这类模型的特点是:

优势方面:

能够基于当前观察和动作预测未来状态,理解环境物理规律

实现对视觉信息和行为动力学的双重理解

可以模拟不同动作的潜在结果,支持基于模型的规划

为强化学习提供了丰富的想象空间

局限性方面:

无法直接生成动作输出,需要额外的策略模块

在需要明确行动规划的场景中存在功能缺陷

与实际执行系统的集成复杂度高

计算开销大,难以实时部署

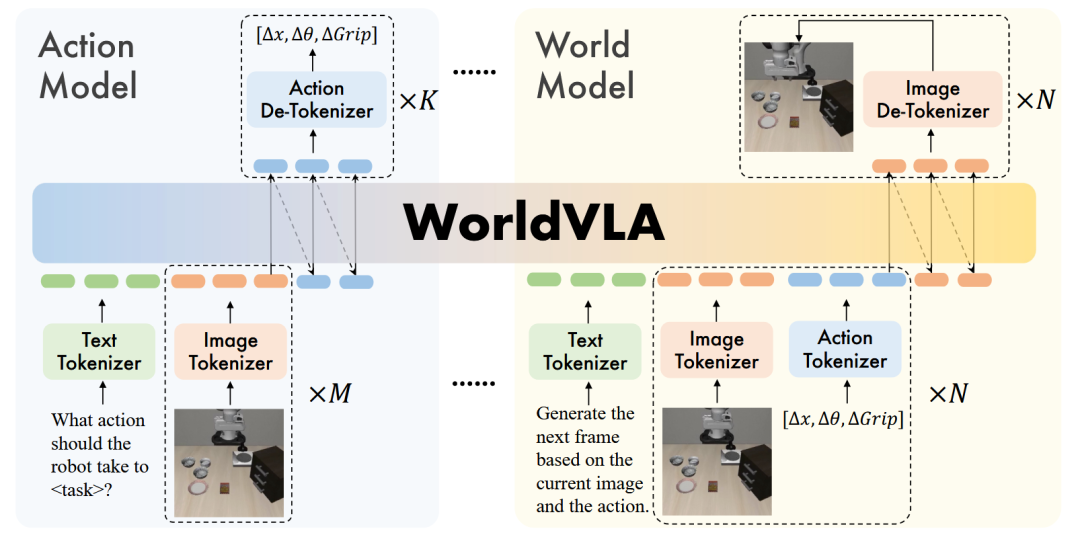

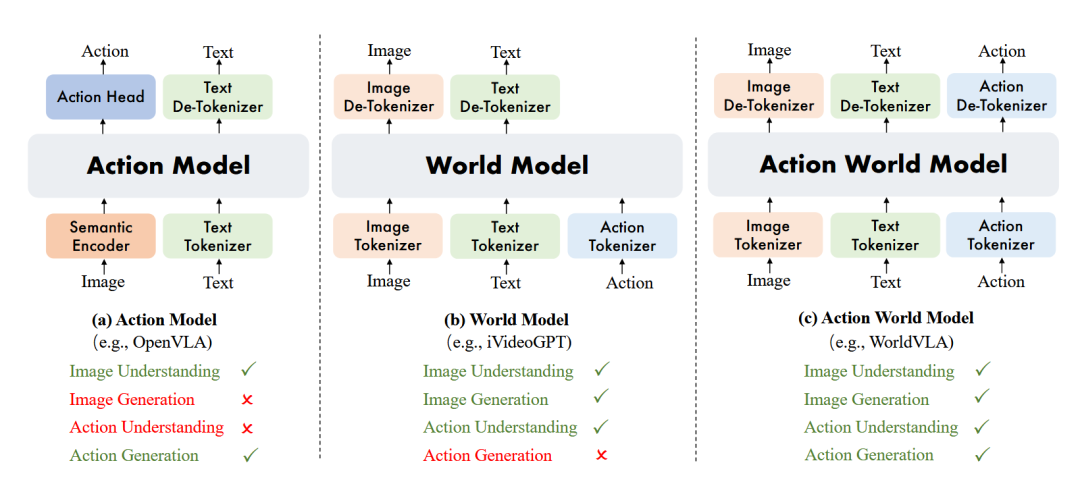

▲图1 (a) 动作模型基于图像理解生成动作;(b) 世界模型基于图像和动作理解生成图像;(c) 动作世界模型统一了图像和动作的理解与生成。©️【深蓝具身智能】编译

如图1所示,传统的动作模型和世界模型各自独立工作,无法实现信息的双向流通。这就像一个人要么只会盲目行动,要么只会纸上谈兵。

现有的解决方案都无法同时具备理解环境物理规律和生成精准动作的能力。

动作序列生成的核心挑战

除了模型架构的局限性,研究团队还发现了一个更深层的技术难题:动作序列生成中的错误累积问题。

▲表1 不同动作和视频生成模型的比较。T:文本;V:视频;A:动作。©️【深蓝具身智能】编译

当需要生成多个连续动作时(action chunking),传统的自回归模型会出现严重的性能退化:

早期动作的错误会传播到后续动作;

预训练模型主要在图像和文本数据上训练,对动作的泛化能力有限;

错误累积导致成功率下降10%-50%。

这个问题在机器人需要执行复杂、多步骤任务时尤为突出,严重制约了实际应用。

统一的自回归动作世界模型

WorldVLA的核心创新在于提出了一个统一的自回归框架,将动作模型和世界模型有机融合,实现了真正的双向理解和生成。

统一建模架构设计

图2展示了WorldVLA的整体架构。

▲图2 WorldVLA概览。WorldVLA集成了两个不同但互补的功能组件:动作模型和世界模型。动作模型负责基于文本和视觉数据生成动作。世界模型的功能是通过利用文本信息、当前图像和当前动作来预测后续的环境状态(例如,下一个视觉帧)。©️【深蓝具身智能】编译

与传统方法不同,WorldVLA采用了一种“优雅”的设计方案:三种专用分词器的协同工作。

(1)图像分词器:

使用VQ-GAN模型,包含对特定图像区域(如面部和显著物体)的额外感知损失

压缩比为16,码本大小为8192

为256×256的图像生成256个token

为512×512的图像生成1024个token

(2)动作分词器:

将连续机器人动作的每个维度离散化为256个bin之一

动作表示为7个token:3个相对位置、3个相对角度和1个绝对夹爪状态

离散化设计使得动作可以与文本和图像在同一空间中处理

(3)文本分词器:

训练的BPE分词器,词汇表大小65,536

包含8192个图像token和256个动作token

实现了跨模态的统一表示

关键设计理念: 所有模态的token共享同一个词汇表,这样的设计使得在单一的大语言模型架构内就能实现跨模态的理解和生成统一。这种统一不仅是形式上的,更是语义层面的深度融合。

双向增强机制的实现

WorldVLA中的世界模型和动作模型不是简单的并列关系,而是通过精心设计实现了相互促进:

世界模型如何增强动作生成?

物理规律学习:通过预测未来状态,世界模型学习了环境的物理动力学,这种理解直接支持更准确的动作决策;

前瞻性模拟:能够评估不同动作的潜在结果,避免导致不良状态的动作;

动作理解深化:世界模型需要精确解释动作输入,这反过来增强了整体系统对动作语义的理解;

错误预防机制:通过预测可能的失败场景,提前调整动作策略。

动作模型如何增强视觉生成?

视觉理解增强:动作生成过程需要深度理解视觉场景,这种理解能力直接提升了图像生成质量;

行为模式学习:通过生成动作,模型学习了物体交互的典型模式;

注意力引导:动作焦点引导视觉生成关注关键区域;

时序一致性:动作序列确保了生成视频的时序合理性。

训练策略的创新设计

WorldVLA采用了混合训练策略,通过平衡不同任务的损失函数实现协同优化:

损失函数设计:

其中:

:动作预测的交叉熵损失

:图像生成的交叉熵损失

α = 0.04:平衡系数,考虑到图像token数量远大于动作token

数据格式设计:

动作模型数据:[BOS]{text}[BOI]{image}...[EOI][EOS][BOA]{action}...[EOA][EOS]

世界模型数据:[BOS]{text}[BOI]{image}[EOI][BOA]{action}[EOA][EOS][BOI]{image}[EOI][EOS]

这种统一的数据格式确保了模型能够在同一框架下处理不同类型的任务。

伪代码

# WorldVLA: 统一的自回归动作世界模型伪代码

注意力掩码策略

错误累积问题的深度分析

研究团队通过大量实验发现,在自回归生成多个连续动作时会出现严重的错误累积现象,如图6所示。

▲图6 动作块长度的消融研究。©️【深蓝具身智能】编译

随着动作序列长度的增加,成功率急剧下降:

LIBERO-Spatial任务:从80%下降到不足40%

LIBERO-Object任务:从90%下降到约40%

长程任务的影响更为严重

问题根源分析:

预训练的多模态语言模型主要接触图像和文本数据,对动作模态的理解有限

在传统的因果注意力掩码下,后续动作依赖于前面可能已经错误的动作

错误像多米诺骨牌一样逐级传播放大

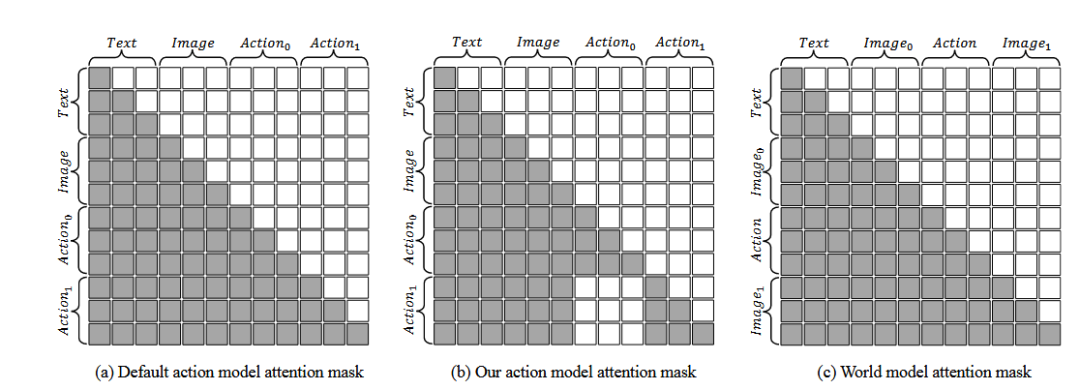

创新的注意力掩码解决方案

WorldVLA提出了一种巧妙的注意力掩码策略,如图3所示。

▲图3 注意力掩码机制:(a) 默认动作模型,(b) 我们提出的动作模型,(c) 世界模型。©️【深蓝具身智能】编译

传统方法(图3a):

使用标准的因果注意力掩码

当前token可以看到所有之前的token

导致错误传播和累积

WorldVLA方法(图3b):

生成当前动作时,只依赖文本和视觉输入

屏蔽对之前动作的注意力

实现多个动作的并行生成

从根本上切断了错误传播路径

效果对比:

传统方法:成功率下降10%-50%

WorldVLA方法:不仅避免了性能下降,某些情况下还带来4%-23%的提升

这种设计的精妙之处在于,它既保留了自回归模型的优势,又避免了其在动作生成中的固有缺陷。

实验验证

LIBERO基准测试

表2展示了WorldVLA在LIBERO基准测试上的表现。

▲表2 LIBERO基准测试的评估结果。预训练表示模型在大规模机器人操作数据上进行了预训练。RetryClaude can make mistakes. Please double-check responses.©️【深蓝具身智能】编译

LIBERO包含了多种具有挑战性的机器人任务:

性能提升分析

整体性能:

256×256分辨率:平均成功率79.1%,超越OpenVLA的76.5%

512×512分辨率:平均成功率81.8%,展现了高分辨率的优势

任务类别表现:

Spatial任务(空间关系):87.6%成功率

Object任务(物体识别):96.2%成功率

Goal任务(程序学习):83.4%成功率

Long任务(长程任务):60.0%成功率,相比基线提升显著

与连续动作模型对比:

虽然连续动作模型如OpenVLA-OFT达到了95.4%的平均成功率,但WorldVLA作为离散模型能达到81.8%已经非常出色,且具有更好的可解释性和稳定性。

消融实验的深入分析

▲表3 动作模型的消融研究。©️【深蓝具身智能】编译

世界模型的贡献(行2 vs 行1):

平均成功率从62.8%提升到67.2%,证明了世界模型对动作生成的增强作用。

注意力掩码的效果(行4 vs 行3):

从54.0%大幅提升到76.6%;解决了动作块生成的核心难题。

组合效果(行5):达到78.1%的最高成功率;证明了各组件的协同效应。

可视化对比分析

(1)图4展示了动作生成的可视化对比:

▲图4 动作模型的可视化。上方:动作模型。下方:我们的动作世界模型。©️【深蓝具身智能】编译

任务:将奶油奶酪放入碗中

上排(普通动作模型):机器人直接移动到目标位置,但未能成功抓取奶酪

下排(WorldVLA):机器人会反复尝试抓取,确保成功后才移动到目标位置

任务:将酒瓶放在柜子顶部

普通模型经常出现抓取失败或定位不准的问题

WorldVLA展现了更稳定的抓取和精确的放置能力

这种差异体现了WorldVLA对环境物理规律的理解。

(2)图5展示了世界模型生成效果的对比:

▲图5 世界模型的可视化。上方:世界模型。下方:我们的动作世界模型。©️【深蓝具身智能】编译

三个典型失败场景:

1. 打开抽屉任务:纯世界模型无法正确模拟抽屉打开的过程

2. 推动盘子任务:物体在移动后神秘消失

3. 放置碗任务:无法正确预测抬起动作的结果

WorldVLA在所有这些场景中都生成了物理合理、视觉连贯的预测结果。

实验结果分析

表4展示了世界模型的定量评估结果:

▲表4 世界模型的消融研究。©️【深蓝具身智能】编译

在生成10帧时,两种模型性能相当

在生成50帧的长序列时,WorldVLA的优势明显(FVD从718.6降至674.1)

表5分析了历史图像输入数量的影响:

▲表5 历史图像输入长度的消融研究。©️【深蓝具身智能】编译

单帧输入性能较差(58.4%)

双帧输入达到最佳平衡(84.4%)

四帧输入性能饱和,但计算成本显著增加

图7比较了世界模型与视频预测模型:

▲图7 动作世界模型与动作视频预测模型的比较。©️【深蓝具身智能】编译

世界模型在所有任务上都带来正面提升

视频预测模型效果不稳定,甚至在某些任务上产生负面影响

WorldVLA高效的原因

架构设计的根本优势

WorldVLA的成功源于多个创新设计协同作用的结果:

(1)统一框架的优势:

信息无损传递:避免了信息在不同模型间传递时的损失和失真;

参数共享高效:相比分离的模型,参数利用率更高,计算效率提升;

模态间深度交互:不同模态在同一表示空间内实现真正的语义融合;

端到端优化:整个系统可以进行联合优化,避免了次优解。

(2)预训练知识的充分利用:

WorldVLA基于Chameleon模型初始化,这带来了几个关键优势:

继承了强大的多模态理解能力;

即使经过机器人数据的密集微调,仍保留了目标检测等预训练能力;

为零样本和少样本学习奠定了基础。

训练策略的精妙平衡

(1)混合训练的优势:

世界模型数据帮助学习物理规律;

动作模型数据提升任务执行能力;

两种数据的交替训练实现了能力的相互增强;

损失函数的精心平衡确保了训练稳定性。

(2)数据效率的提升:

通过共享表示和联合训练,WorldVLA能够从有限的数据中学到更多:

每个样本同时贡献于多个学习目标;

不同任务间的知识迁移更加高效;

减少了对大规模标注数据的依赖。

注意力机制的创新应用

注意力掩码策略的成功揭示了一个重要原则:不是所有信息都是有益的。

通过选择性地屏蔽可能有害的信息(之前的动作),反而能够获得更好的性能。这种"less is more"的设计理念值得在其他领域推广。

总结

WorldVLA首次实现了动作和图像理解与生成的真正统一,打破了传统的模块化界限;解决了动作序列生成的错误累积问题,提出了实用的注意力掩码策略。

这项工作的意义在于,它不仅解决了一个具体的技术问题,更重要的是提出了一种新的思路——通过统一建模来实现不同AI能力的相互增强。

编辑|JeffreyJ

审编|具身君

论文信息

标题:WorldVLA: Towards Autoregressive Action World Model

作者:Jun Cen, Chaohui Yu , Hangjie Yuan, Yuming Jiang, Siteng Huang, Jiayan Guo, Xin Li, Yibing Song, Hao Luo, Fan Wang, Deli Zhao, Hao Chen

代码地址:https://github.com/alibaba-damo-academy/WorldVLA

论文地址:https://arxiv.org/pdf/2506.21539

【深蓝具身智能读者群】-参观机器人:

【深蓝具身智能读者群】-参观机器人:

我们开设此账号,想要向各位对【具身智能】感兴趣的人传递最前沿最权威的知识讯息外,也想和大家一起见证它到底是泡沫还是又一场热浪?

欢迎关注【深蓝具身智能】👇

点击❤收藏并推荐本文