技术路线

现代世界模型(World Model)的构建主要沿着多条技术路线发展,包括基于Transformer的自回归模型、基于扩散模型的生成模型、NeRF/3D生成模型以及与强化学习结合的方法等。各路线在时序一致性(跨时间的连贯性)、空间一致性(多视角/三维一致性)和物理一致性(遵循物理规律的合理性)方面各有优劣:

• Transformer自回归世界模型: 该路线使用大型Transformer模型对离散序列建模,通过“下一个Token预测”来生成未来状态。通常先将图像或视频帧离散化(例如用视觉tokenizer编码成类似文本的符号)并与文本等模态统一表示,再用Transformer解码器一步步预测序列后续的发展。Transformer结构善于捕捉长时依赖,能够将时间维度和空间维度的信息通过自注意力融合,从而学习复杂的动态模式。例如NVIDIA的Cosmos世界模型使用Transformer解码器并针对视频预测进行了改进:引入3D旋转位置编码分离时间和空间位置,交叉注意力融合文本控制等。这类模型在时序连贯方面表现出色,可通过训练学习到隐含的物理因果关系,但缺点是对超长序列的建模存在记忆长度限制,且缺乏显式的物理约束(需要通过大量数据学习物理规律)。此外,全Transformer模型生成分辨率有限的视频时往往输出较低清晰度,但胜在动态细节和物理正确性,例如Cosmos生成的合成视频虽然清晰度有限但严格遵循真实物理特性,可用于机器人训练中确保物体持久性和场景真实性。

• 扩散模型世界模型: 扩散模型通过正向逐步添加噪声、反向逐步去噪的过程来生成高保真输出,在图像和视频生成中表现优异。将扩散模型用于世界模型,可以生成逼真的未来帧序列并更好地保持空间一致性细节。Li Auto提出的Delphi模型就是基于扩散的长视频生成方法,通过跨多视角的共享噪声来保证多摄像头视角下生成视频的一致性(例如不同摄像头看到的同一车辆颜色一致),并通过特征对齐模块增强时间连贯性。此方法成功将可控驾驶视频的长度提升到40帧而不失真(约为此前最佳方法的5倍长度)。扩散模型的优势是在于生成结果的细节和真实性(如纹理、光照等),对空间/视觉一致性有天然优势。然而,其劣势在于时序一致性和效率:纯基于2D扩散的模型缺乏对3D结构的显式约束,容易出现跨帧的3D不一致,例如物体位置跳变等。为克服这点,业界引入了NeRF渲染、深度图等3D先验。例如Apple提出的WVD框架使用了XYZ深度图作为额外监督,与RGB帧联合扩散,使生成内容具备明确的三维几何一致性。总的来说,扩散式世界模型在空间细节保真度方面表现突出,但要确保长时间的物理合理演化,需要特殊机制或更长推理时间。Delphi通过噪声重采样和特征对齐,显著改善了扩散模型的时空一致性。

• NeRF/3D生成模型: 该路线利用神经辐射场(NeRF)或其他3D生成技术,对场景的三维结构进行建模,以确保多视角下的视图一致性。NeRF将场景表示为连续的5D函数,可以从任意视角渲染一致的图像,在世界模型中融入NeRF有助于模型理解三维空间关系,避免生成内容在视角变化时失真。融合3D表示的世界模型通常在空间一致性上效果最好,例如通过体渲染约束模型,使得跨帧或跨视角的内容保持一致。Google等研究者提出的“World-consistent Video Diffusion”将显式3D监督(XYZ坐标图)引入扩散模型,统一了单张图到3D、生成人工多视角等任务,用一个模型就达到了多视角视频的高一致性生成。NeRF类方法的劣势在于计算开销大,难以快速生成动态变化。此外,引入3D先验会增加模型和数据的复杂度(例如需要带深度信息的数据集),不易扩展到非常多样的开放环境。因此,NeRF/3D技术通常与其他方法结合,用于在保证空间结构一致的同时,通过其他模块处理动态和语义。总体而言,该路线非常适合需要多视角统一的场景(如数字孪生、VR环境生成),能够天然地保持物体的几何形状随视角变化的一致,但对时序运动的刻画需要额外机制(如动态NeRF、视频-NeRF融合)。

• 强化学习结合的世界模型: 将世界模型与强化学习(RL)相结合是实现具身智能的一大方向。一方面,RL智能体可以学习环境模型(Model-based RL),即通过学习状态转移动力学M和奖励函数R构建内部“世界模型”,从而在脑海中模拟未来场景、辅助决策。Dreamer系列就是这方面的代表,它让智能体在与环境交互收集数据的同时,训练一个潜在空间的动态模型,然后基于该模型“想象”未来并优化策略。这种方法在物理一致性上由真实环境数据保证,每一步预测都贴近真实物理动态(如Dreamer在Minecraft中学会了长远规划挖钻石,成功完成了稀疏奖励的挑战)。另一方面,RL也可以用于数据生成来训练世界模型。例如Google提出的GameNGen先用RL代理在游戏中玩出大量轨迹,再用扩散模型学习这个交互式环境的动力学,实现了首个纯神经网络驱动的游戏引擎,可在单个TPU上以20+FPS模拟复杂3D环境。这种RL+生成模型结合使世界模型不仅会被动预测,还能与行动联系,实现交互模拟。然而,该路线的挑战在于数据和泛化:GameNGen为了拟合DOOM游戏,耗费了9亿帧的训练数据(RL代理不同技能水平的游戏记录),几乎记忆了游戏的所有角落视图。这导致生成模型难以“想象”训练数据以外的新场景,泛化能力受限。此外,由于大部分视频数据集不包含主动动作信息,这种需要状态-动作监督的世界模型难以推广到开放环境。因此,当前RL结合的世界模型多在封闭任务中表现出色,但要用于复杂现实场景仍需解决数据高成本和模型过拟合问题。尽管如此,RL世界模型的优势是对物理因果关系有深刻掌握,模型能够通过试错学习到符合物理定律的动态,例如Dreamer的世界模型在多种控制任务中学到了不同尺度下稳定的动态表示,实现一个配置在150种任务上全面超过以往专家算法。

综上,各技术路线各擅胜场:Transformer模型注重长期序列建模,时序一致性好;扩散模型追求感知逼真度,空间细节优秀;NeRF/3D保证了多视角和几何一致;RL结合强化了物理正确性和决策相关性。未来的世界模型很可能是多种技术的融合,通过引入3D物理先验、序列建模和强化学习机制,来同时实现时间、空间和物理的一致与统一。

代表性世界模型论文与系统

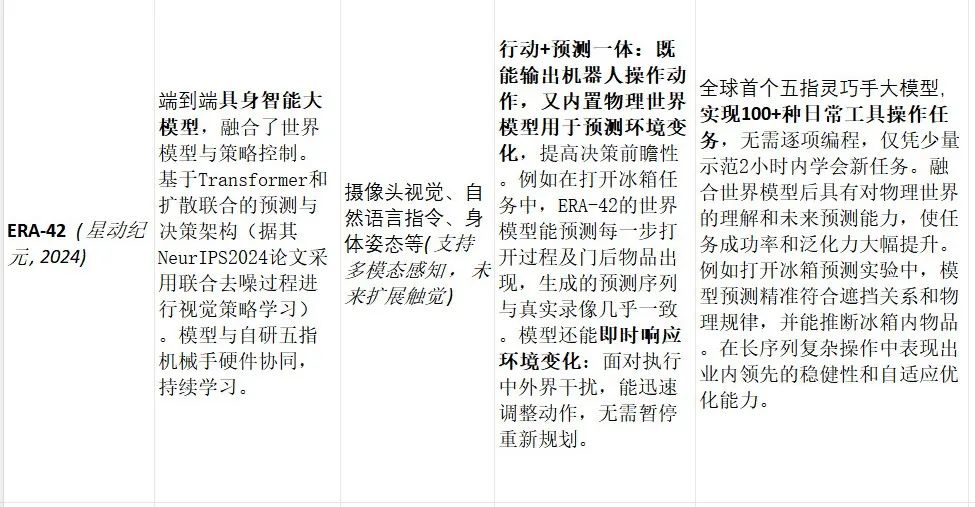

近年来出现了一系列具有代表性的世界模型系统和论文,包括面向强化学习的Dreamer系列、多模态统一模型Emu3、自动驾驶领域的Delphi模型以及机器人领域的ERA-42等。下表对比了这些典型系统的模型结构、支持模态、预测能力和任务表现:

上述系统各自代表了世界模型在不同领域的前沿进展:Dreamer展示了模型在强化学习中模拟未来提升决策的威力,Emu3证明了多模态世界模型的可行性,Delphi将世界模型引入自动驾驶并显著提升了端到端性能,ERA-42则将世界模型融入机器人大脑,实现了复杂连贯操作的新水平。它们从模型结构到应用场景各有侧重,体现出世界模型技术的多样性和广阔前景。

行业内实践动向

除了研究论文,工业界的诸多企业和机构也在积极探索世界模型的实际应用和部署。

• 理想汽车(Li Auto):作为新造车势力,理想在自动驾驶中率先引入世界模型理念,用于加强车辆对环境的理解和复杂场景的泛化能力。理想智驾团队联合高校开发了Delphi世界模型,通过云端大规模训练扩散式视频生成模型,生成多样的驾驶场景用于训练和测试。该模型在云端针对公开数据(如nuScenes)训练,再将其作为“数据引擎”反馈提升车载模型性能。理想的技术栈包括多摄像头感知、Transformer和扩散模型结合,以及利用预训练视觉语言模型来筛选“失败案例”场景并生成针对性数据。部署上,Delphi目前用作离线仿真与闭环评估:例如在云端模拟各种极端工况(紧急加速追尾等)供端到端驾驶模型验证。这一创新实践表明,通过云端世界模型生成数据,理想成功将端到端模型带入更广覆盖场景,在复杂城市场景下提升规划决策的可靠性。业界评价认为,造车新势力在比拼的不仅是车载算力,更是云端构建虚拟世界的能力。这将持续推动车企投入云计算平台和高精度传感器,以获取更逼真的世界模型训练素材。

• NVIDIA:作为AI基础设施领导者,NVIDIA提出了Cosmos世界基础模型平台,旨在为自动驾驶和机器人提供预训练的大型世界模型。Cosmos包含数个经过9000万亿token数据训练的生成式模型,覆盖自动驾驶、机器人、合成环境等领域的海量视频(累计超过2000万小时)。技术栈上,Cosmos采用Transformer自回归模型和扩散模型两类架构并行研发,统一在CUDA加速框架下训练。Transformer分支通过3D旋转位置编码、文本交叉注意力等机制,实现从文本和少量帧输入预测后续多达120帧的视频;扩散分支则通过3D分块、混合时空位置嵌入等改进,将稳定扩散模型拓展到视频生成并支持文本条件控制。NVIDIA提供了多种模型尺寸(Nano实时小模型、Super高性能模型、Ultra高保真模型)以适应边缘部署或云端高画质需求。Cosmos已集成进NVIDIA的开发工具链中,配套有视频数据管护工具(NeMo Curator)、专用视频tokenizer和模型微调框架。在实践中,NVIDIA将Cosmos定位为物理AI的核心,使自主机器具备通过视频去模拟物理状态并做出决策的能力。例如,Cosmos模型能生成逼真的驾驶和机器人交互视频,用于训练端到端驾驶以及人形机器人的控制策略。NVIDIA还非常注重安全部署,为生成模型设计了双阶段安全护栏(提示过滤+结果滤除)以确保不会输出危险内容。作为行业实践,Cosmos代表了利用云端大模型平台来定制世界模型的趋势,开发者可以在其开放框架上微调出特定场景的世界模型,加速物理世界AI应用开发。

• 北京智源研究院(BAAI):智源研究院在2024年发布了“悟界”多模型系列,核心即全球首个原生多模态世界模型Emu3。Emu3采用了完全自研的多模态自回归技术,不依赖扩散或其他复杂架构,以单一Transformer实现文本-图像-视频的统一生成。其技术栈包括一个视觉离散编码器,将图像/视频压缩为与文本token同构的符号序列,以及一个大规模Transformer模型在混合序列上训练。这一架构使得模型能够直接从像素和字词共同学习,对应不同模态的知识可以共享表示空间,极大简化了多模态模型的设计。智源还推出了基于Emu3架构的衍生模型,如“见微Brainμ”,将fMRI、EEG等脑信号也token化并对齐到多模态空间中,探索认知神经信号与文本/图像的映射。在应用实践方面,Emu3和相关模型被寄望于多个场景,包括作为通用机器人大脑(理解环境指令并输出动作)、自动驾驶(将多模态感知和决策统一)以及多模态对话和推理系统等。虽然Emu3目前主要作为研究原型,但它验证了多模态世界模型在大规模训练和推理上的可行性,为行业提供了一条技术路线:未来的AI底座有望收敛到单一模型,同时处理视觉、语言、决策等多种任务。这一实践对业界的启示是,统一的世界模型基础设施或将降低多模态AI开发的复杂度,加速AGI相关应用落地。

• 星动纪元(Xingdong Era):这是一家中国初创机器人公司,在2024年底推出了其端到端原生机器人大模型ERA-42。ERA-42是国内首个真正实现五指灵巧手通用操作的具身大模型,定位于引领通用机器人操控时代。技术上,星动纪元早期采用与DeepMind PI实验室类似的端到端思路,将视觉-语言预训练和机器人操作数据结合训练出具身智能体(其早期成果π0模型与ERA系列不谋而合)。ERA-42进一步探索了大规模视频预训练路线,收集了海量无标注人类视频、多种机器人形态数据和遥操作数据来训练模型,让模型学习动作的因果结果而非简单模仿。这种“学习物理因果”的策略确保了模型掌握统一的物理规律,提升了跨环境的泛化能力。在此基础上,星动团队将世界模型融入机器人模型,使ERA-42不仅输出动作,还对物理世界状态进行预测。部署上,ERA-42配合星动自研的五指机械手硬件(XHAND1)使用,软硬件协同优化。模型在机器人本地实时运行,实现感知-决策-行动闭环:每个新任务只需通过几次人示范、少量数据,模型就能在约两小时内本地学会并不断自我改进。应用场景包括装配、工具使用、日常家务等复杂操作。例如,ERA-42已成功让机械手使用电钻拧螺丝、用锤子钉钉子、扶正翻倒的杯子再倒水等上百种精细任务。它的创新之处在于强泛化和自适应性:针对新工具新任务无需任何预编程,凭借世界模型的理解和预测能力快速掌握,并可在执行过程中处理干扰连续完成任务。ERA-42的实践表明,在机器人领域将世界模型内嵌于控制策略,可以大幅提升机器人对未知情境的处理、对长任务链的规划执行能力,从而向真正的通用机器人更近一步。

此外,其他车企和机构也在推进世界模型落地。小鹏汽车公开了参数达720亿的自动驾驶基础模型计划,将通过云端大模型训练并蒸馏小模型部署到车端,实现“AI汽车大脑”。华为、地平线等也在发布会上强调其智能驾驶系统中的世界模型概念。百度研究院提出了如BEVWorld等将多传感器信息融合为鸟瞰图世界表征的方案,用于预测和规划。可以看出,行业普遍认为车云结合、大模型赋能将是下一代智能驾驶竞争的重点。在机器人方面,DeepMind等探索的具身智能体架构也为创业公司提供了范式,例如美国初创Figure、国内的跨维智能等都尝试将视觉、语言、动力学融合,打造通用人形机器人底座。总体而言,世界模型正从学术概念走向工业实践,在自动驾驶、机器人公司、AI实验室中百花齐放,成为冲击高水平AI能力的关键筹码。

多模态融合发展趋势

多模态融合是世界模型发展的重要趋势之一。人类认知世界时会综合视觉、听觉、触觉、语言等多种信息,同样,赋予AI的世界模型以多模态能力,有望让机器对环境有更全面的理解与预测。近期研究正朝以下几个方向推进:

• 统一的模态表示空间: 传统多模态模型往往为每种模态设计单独分支,然后在高层特征上融合;而最新的做法是将不同模态的数据都映射到统一的token空间,在同一个模型中处理。Emu3即是典型例子:它通过自研视觉tokenizer把图像和视频转为离散符号,与文本token同域,从而使用单一Transformer在一个序列中联合训练。这种统一范式避免了多模态模型中冗余的架构组合,不需要图像Diffusion+文本Decoder等繁杂模块,大幅简化了训练和推理。更重要的是,模态无关的表示让模型可以在不同模态任务之间迁移知识:例如Emu3的视觉生成能力和文本理解能力共享同一模型参数,由此在图文生成、视频问答等跨模态任务上表现出色。除了Emu3,OpenAI等也在尝试类似思路,将文本和图像信号统一编码后,用Transformer实现多模态对话(如GPT-4的Vision部分)。这类统一token策略证明了自回归大模型在多模态领域的普适性,为AI系统最终拥有一个“大一统”世界模型奠定基础。

• 多模态模态扩展: 当前世界模型研究已超越视觉范畴,开始纳入更多感官模态的融合。比如语言模态常被用来提供高层语义和任务指令,在世界模型中融入语言能够使模型具备符号推理与常识获取能力。DeepMind近期提出的通用具身智能体架构就将视觉、语言和运动控制模块嵌入统一世界模型中,使系统可以自主规划复杂动作序列,例如“拿起水杯-避开障碍-调整握姿”这样的连贯操作链。语言提供了目标描述(拿水杯)、视觉世界模型提供环境理解(障碍物位置)、运动模块则在世界模型的模拟下生成一系列物理可行的动作。音频和触觉模态的融合也在兴起:音频可帮助机器人感知环境事件(如物体跌落声)以更新世界状态,触觉则为操作任务提供微观反馈。Meta等公司发布了新型多模态触觉传感研究,将高分辨率触觉信号与视觉对齐,用统一模型来表示物体的纹理、硬度等,以改进机器人对物体的识别和操作。北京智源的“悟界·RoboBrain2.0”亦强调跨本体大小脑协作,将机器人多传感(视觉、力觉等)与大模型结合。可以预见,未来的世界模型将囊括人类所有感知模态,真正成为AI对外部世界的全方位表征。

• 统一模型的训练难点与突破: 构建多模态世界模型面临多重挑战。首先是数据对齐与规模:模型需要海量跨模态对应的数据才能学会各模态间的关系,比如图文对、视频字幕等。而有些模态(如触觉)数据稀缺且难以和其他模态精确对齐。为此,研究者尝试借助预训练模型对不同模态进行对齐蒸馏,或利用模拟环境自动生成配对数据(如让虚拟机器人同时记录视觉和力反馈)。其次是模型复杂度:多模态输入长度和信息量巨大,如一段视频加文本描述的token总数远超单句文本,这对模型的记忆和计算提出了更高要求。Emu3在这方面的策略是采用高效离散编码压缩视觉信息,使模型处理的序列长度可控;NVIDIA Cosmos则通过视频分块和混合位置编码减轻多模态序列建模的难度。再次,模态间干扰和平衡也是难点:模型可能倾向于利用某一模态而忽视其他模态信息。为此,一些训练方法引入了模态dropout、对比学习等机制,迫使模型充分利用每种模态来进行预测。值得欣喜的是,这些难点正逐步被攻克。像Emu3这样完全从零联合训练的模型已经证明,即使不设计专门损失项,Transformer也能自发学到模态协同的表示,并在下游同时兼顾多模态任务。这表明大模型自监督学习在规模足够大时,有能力跨越模态鸿沟,形成我们称之为“世界模型”的综合智能。未来随着数据集更加丰富、模型结构更高效,多模态世界模型的性能将不断攀升,有望出现同时在视觉理解、语言推理、运动控制上都达到顶尖水准的通用AI模型。

云端仿真 vs 本地推理

在世界模型的训练和推理部署上,“云端大规模仿真训练”和“本地嵌入式实时推理”形成了两种互补的范式,各自适用于不同需求。

• 云端大模型仿真训练: 得益于云计算的海量算力和数据汇聚,许多企业选择在云端构建和训练庞大的世界模型,然后将成果下发终端。这一模式在自动驾驶领域尤为明显:当前车企在智能驾驶竞争中,比拼的不再仅是车载计算硬件,而是云端构建虚拟世界的能力。通过云端的高性能计算,可以对真实物理世界进行数字孪生,利用模拟环境生成、测试和验证数以百万计的驾驶场景。例如Cruise利用Google Cloud模拟了数百万英里的无人驾驶场景用于算法训练。云端还能汇聚全量路测数据,训练出超大规模的基础世界模型,如小鹏汽车正在研发的720亿参数自动驾驶基座模型。这些模型经过云端训练后,可以通过知识蒸馏等手段压缩为适合部署在车端的小模型,从而赋能车辆实时驾驶。云端训练的优势在于:1)数据多样性:可以整合各地长尾场景,甚至通过生成对抗或扩散模型创造罕见危险场景,提高模型鲁棒性;2)超大模型容量:云端可承载数十亿参数模型,学习复杂的物理规律和隐含知识;3)离线安全验证:在云端虚拟世界中,可对新策略充分测试避免直接上路风险。然而,其劣势是落地成本高和仿真逼真度的瓶颈:大模型需要昂贵GPU集群训练,模拟环境仍难以100%还原创实世界(存在仿真到现实差距)。此外,即便云端模型很好,实际应用还需经过模型压缩、域适应等过程,保证迁移到车载环境时性能可靠。总体来说,云端仿真为训练提供了“无限”的数据与算力,使世界模型不断进化,但如何高效将云端智能注入终端仍在探索。

• 本地嵌入式推理部署: 相比云端,许多实时具身智能应用要求模型在本地设备上独立运行,即时感知和决策。典型如家庭服务机器人、AR/VR设备中的AI数字人等。这些场景中,将世界模型嵌入设备的大脑,好处在于低时延和高自主性:机器人无需等待云端指令,就能基于自身世界模型即时预测环境变化并作出响应。例如ERA-42机器人在执行搬运、装配等任务时,完全依赖其本地模型预测下一步会发生什么(物体移动、平衡改变等)并调整操作,实现连续无停顿的动作流。本地推理还能在网络不稳定或无连接环境下独立工作,增强了鲁棒性。隐私与安全也是考虑因素:对家庭机器人来说,本地世界模型意味着用户环境数据无需上传云端处理,减少了隐私泄露风险。此外,本地模型可根据特定用户环境进行持续学习优化,而无需同步整个云模型。例如ERA-42只需收集一户家庭中的少量交互数据,就能迅速自适应地掌握新技能。当然,本地部署也有局限:终端设备计算资源有限,难以承载超大参数模型,因此通常需要小而专的世界模型。许多公司采取“云训练+端适配”策略:先在云端训练大的,再在端上运行小的 distilled 模型。如小鹏提出通过云端蒸馏将基础模型部署车端。另外,本地模型的场景局部性强,它所见数据主要来自特定环境,长期自主学习可能出现偏差,需要定期和云端大模型进行同步更新以纠正 drift。

• 优势互补与协同: 云端和本地两种方式并非对立,而是互补协同的。理想的架构是构建云-边-端协同的世界模型体系:云端汇聚全局知识训练强大的世界模拟器,边缘服务器提供区域场景的增量训练,本地终端则运行个性化精简模型并实时采集新数据。车辆和机器人可以不断将运行数据上传云端,丰富世界模型的经验;云端模型升级后再下发端侧,提高终端智能水平。这样的闭环可以形成数据和模型的正反馈循环,提升整个系统的泛化和适应能力。很多车企正朝这个方向努力,比如引入车端大模型推理芯片以运行更复杂的模型,同时利用5G/V2X技术让车与云高效通信,做到“云端训练世界、车端理解世界”相结合。世界模型的云-端结合还体现在应用分工上:对于需要超前规划的任务,可借助云端强模拟能力离线计算最优策略;对于需要即时反应的细节动作,则依靠端上模型快速预测。例如自动驾驶中,云端模型可预先模拟罕见事故并制定预案,而车端模型在遇到危险时毫秒级预测刹车避障。再如机器人在复杂家务中,可在云端进行任务级策略推演(如何规划整理房间顺序),执行时靠本地模型处理具体动作(抓取某件衣物时预测其受力形变)。通过这种分工协作,世界模型的威力能够最大化发挥。同时也要注意,云端仿真的逼真度决定了对现实的参考价值;本地模型的保守策略需要与云端的探索创新形成平衡,避免各自的局限。可以预见,未来车企和机器人公司将在云端投入更大算力训练世界模型的“数字孪生”,也会在终端部署越来越强的推理引擎,实现真正双管齐下的智能。

应用场景分析

世界模型作为AI“理解和预测世界”的底层能力,在多个具体场景中展现出巨大潜力:

• 自动驾驶: 世界模型在自动驾驶中的作用日益凸显,贯穿从训练到在线决策多个环节。一方面,在模型训练阶段,世界模型可以生成多样化、逼真的驾驶数据。这对长尾场景尤其重要,比如罕见的事故、极端天气,传统数据难以覆盖,而世界模型能够基于少量样本扩散出丰富变体。Delphi的实践证明,通过生成逼真的长序列视频来模拟复杂场景,可以有效提高端到端驾驶策略对复杂状况的处理能力。它还支持闭环评估:使用生成模型让虚拟自车与环境交互,从而测试策略在真实路况中的连锁反应(例如自车突然加速,前车如何反应,最终是否碰撞)。这种评估方式比传统开环重放更贴近实际,有助于发现隐藏隐患。另一方面,在车辆在线决策中,世界模型可用来实时预测周围环境的演化,从而辅助规划。比如一些前沿系统构建了车辆周边的动态3D鸟瞰图(BEV世界模型),预测几秒后行人和车辆的位置。又如特斯拉的FSD系统内部据传包含“环境模拟模块”,在决策前会模拟假设的动作对环境的影响,选择最优路线。这些都体现了世界模型的核心价值:提前看见未来。当前自动驾驶应用的世界模型主要聚焦视觉模态(摄像头、雷达数据)并结合交通运动学模型,但随着多模态融合发展,未来车辆可能借助语言世界模型理解交通规则、用音频模型预测鸣笛/警报来源等,形成更全面的驾驶大脑。总体来说,世界模型为自动驾驶带来了两大提升:训练上,用“虚拟世界”提升AI对现实世界的泛化;推理上,用“内部模型”提升规划决策的安全性和智能性。

• 家务机器人与灵巧操作: 在家庭助理、服务机器人领域,世界模型被视为让机器从“笨拙执行”进化到“灵巧行动”的关键。家务任务(如收纳物品、铺床叠衣)涉及高度的物理交互和长序列步骤,机器人需要理解物体间关系、动作对环境的影响才能顺利完成。世界模型可在其中发挥以下作用:首先,理解场景状态。机器人通过视觉、深度和触觉传感获取当前环境信息后,世界模型能将其抽象为内部表示,例如房间有哪些物体、物体可移动的自由度等。这类似人对房间形成心理模型,为规划打基础。其次,预测动作后果。在执行每一步之前,机器人可在世界模型中模拟不同动作的结果。例如铺床时模拟“拉床单”可能导致的褶皱分布,以选择更好的拉动方式;整理杂物时预测如果先拿起哪件物品会不会导致其他物品掉落。ERA-42的世界模型在这方面已有验证:它能在打开冰箱门前,预测门打开后的每帧变化,甚至推测冰箱内可能有什么东西(这表示对隐藏状态的推断能力)。再次,长序列任务分解。复杂家务往往需要多个子步骤,世界模型可以辅助机器人进行分层规划:高层通过模型模拟,产出一个合理的子任务序列(例如“整理桌面 -> 清扫地板 -> 倒垃圾”);低层再逐步执行,每步都用模型校验是否达到预期效果,否则适当调整顺序。DeepMind的一些工作将这种架构类比为“大脑皮层+基底节”的配合:世界模型(类似皮层)形成抽象方案,低层控制(类似基底节)优化具体动作。这种分工可以提高机器人在长时间、复杂任务中的成功率。最后,抗干扰与自适应。真实家庭环境充满不确定性,宠物或人类可能打断机器人的动作。融合世界模型的机器人能够快速感知偏差并重新预测后续步骤,确保任务不断推进。ERA-42在长序列操作中实现了这一点:当执行过程中有人为干扰(如物体被移走)时,机器人毫不迟疑地调整动作继续任务。这在没有世界模型支撑的系统中是难以做到的。虽然要让机器人完全胜任铺床、洗碗等复杂家务仍有很多挑战,但世界模型提供了必要的认知与预判能力,使机器人朝着可靠的家庭帮手更进一步。

图:ERA-42机器人融合世界模型后,预测打开冰箱动作序列(下排)与真实执行过程(上排)对比。可以看到模型预测几乎完全吻合实际,包括门逐渐打开导致的遮挡关系变化,甚至能推测冰箱内物品出现位置,体现了很高的物理和时序一致性。世界模型使机器人具备了对未来的“想象”能力,从而更精准地完成操作。

• 虚拟现实(VR)和数字人: 在VR/AR以及交互式数字人领域,世界模型也扮演着“幕后大脑”的角色。首先,在虚拟环境生成方面,世界模型可以用于构建沉浸式的动态场景。传统VR环境需要美工和程序员手动设计每个细节,而借助生成式世界模型,有望自动创建丰富多变 yet 合理的虚拟世界。例如前文提到的GameNGen,用纯神经网络模拟了经典游戏DOOM的引擎。人类观察3秒以内的游戏画面几乎分辨不出是真实渲染还是模型生成——这说明世界模型能够学习到场景的视觉特征和交互逻辑,并以假乱真地生成连续画面(包括怪物行为、玩家状态变化等)。这样的技术未来可应用于VR游戏,引擎只需提供高层指令,由世界模型实时“脑补”出细节画面和事件,实现无限生成的游戏内容。虽然目前GameNGen还局限于特定游戏且存在记忆上下文短(仅几秒)的限制,但随着模型增加长短期记忆机制,这种AI驱动的虚拟世界会更加持久和复杂。其次,数字人智能体(如NPC、虚拟助手)可以借助世界模型来提升交互表现。一个游戏NPC若具备世界模型,它就不仅是脚本回应玩家,而是能理解虚拟物理:知道门开关机制、物体遮挡关系等,在与玩家互动时表现得更像真实人物而非傻瓜AI。例如最近流行的“生成式代理人(Generative Agents)”就是将LLM与环境模型结合,让NPC在模拟小镇中自主生活,对环境变化做出合理反应(去做饭、交朋友等)。再如Meta构建的仿生机械手数字人,通过触觉世界模型学会了用恰当力度握手,逼真程度大增。此外,AR眼镜中的数字助手如果有世界模型,可以通过摄像头理解你周围的场景并提供相关指导(例如识别你冰箱里的食材并预测还能保存几天,主动给出建议)。物理一致的内容生成也是VR的重要应用,比如生成与用户动作相符的环境反馈(踢倒物桶后液体四溅的效果、声音),这些都需要世界模型的支持来实时计算合乎物理的结果。总的来说,世界模型将让虚拟世界更贴近真实,让数字人更加聪明灵动,实现沉浸式交互的新高度。不过,也需注意世界模型生成内容的安全与可信:NVIDIA在Cosmos中为生成视频加了安全过滤,就是担心VR/数字人场景出现不当行为或视觉误导。未来随着技术成熟,世界模型有望成为VR内容的“实时导演”、数字人的“大脑中枢”,开启虚拟与现实融汇的新纪元。

综上,世界模型作为通用的环境理解与预测模块,在自动驾驶、机器人、虚拟交互等场景已经展现威力,并将继续拓展。自动驾驶借助世界模型驶向更安全高效,机器人借助世界模型走向更智能灵巧,虚拟数字世界则因世界模型更加真实动人。可以预见,在2023-2025年的最新进展基础上,未来几年世界模型将成为AI系统不可或缺的底座技术,推动我们朝通用人工智能(AGI)迈进一大步。