国家互联网应急中心预警:新型 RCtea 僵尸网络快速蔓延,我国近万台物联网设备已中招

2 月 10 日消息,国家互联网应急中心(CNCERT)发布《关于 RCtea 僵尸网络大范围传播的风险提示》。

CNCERT 近期监测发现了一个名为 RCtea 的新型僵尸网络正在互联网上快速传播,该网络自 2025 年 12 月下旬开始活跃,主要针对物联网设备发起攻击。

监测数据显示,2026 年 1 月 20 日至 25 日期间,我国境内已确认的受感染设备达 9827 台,单日最高活跃设备数 4870 台,单日最高控制服务器访问量 27.8 万次。该僵尸网络采用高度复杂的加密技术和反追踪机制,目前正处于快速扩张阶段,已具备发起多种 DDoS 攻击的能力。

RCtea 僵尸网络主要针对 ARM 和 MIPS 架构设备发起攻击,包括路由器、摄像头等物联网设备,暂未发现针对传统 Linux 服务器或主机的样本。其传播方式主要依赖 Telnet 暴力破解,利用内置的常见弱口令列表进行设备入侵。为规避安全检测,该木马采用多重防护措施:启动时需特定参数激活核心功能;使用 RC4、ChaCha20 及 TEA 算法变种进行数据加密;为进程设置最高级别内存保护;采用随机 6 字符文件名;执行后会在控制台输出“here we are”调试标记。

CNCERT 建议用户及时修复系统漏洞,包括历史漏洞和最新漏洞;设置高强度密码,建议使用 16 位以上包含大小写字母、数字和符号的组合,并定期更换;发现感染后立即核实受控情况和入侵途径,对受害设备进行清理。(来源:IT 之家)

GitHub Copilot 集成 GPT‑5.3‑Codex 代理式开发任务提速 25%

今日,GitHub 宣布,OpenAI 最新的代码生成模型 GPT‑5.3‑Codex 已正式在 GitHub Copilot 中开始推送。该公司表示,在内部使用的多项基准测试中,新模型在推理能力以及对依赖多种工具的复杂、长时工作流的执行方面都有明显提升。在实际应用中,GPT‑5.3‑Codex 在「代理式」(agentic)编码任务上的整体性能相比之前的 GPT‑5.2‑Codex 提升约 25%,显著缩短了开发者在这类任务上的等待时间。

目前,要想使用这一新模型,用户需要订阅 Copilot Pro、Pro+、Business 或 Enterprise 等付费方案。支持选择 GPT‑5.3‑Codex 的环境包括 Visual Studio Code(涵盖聊天、提问、代码编辑和智能代理等模式)、GitHub.com 网页端、GitHub 移动客户端(iOS 和 Android)、GitHub CLI 命令行工具以及 GitHub Copilot Coding Agent。如果用户暂时还未在界面中看到该选项,则意味着本次更新仍处于分批逐步推送阶段。

对于在企业或团队环境中统一配置 Copilot 的用户,GitHub 说明,使用 Copilot Enterprise 或 Copilot Business 方案的组织管理员,需要在 Copilot 设置中显式开启 GPT‑5.3‑Codex 相关策略,才能让团队成员使用该模型。GitHub 表示,此次升级将对负责复杂软件架构设计和自动化重构的开发者带来最大收益,因为新模型专门针对代理式工作流进行了优化。通过将依赖工具链的自动化任务耗时缩短约四分之一,这一更新有望明显缓解以往大规模 AI 辅助代码生成中常见的延迟问题。(来源:cnBeta)

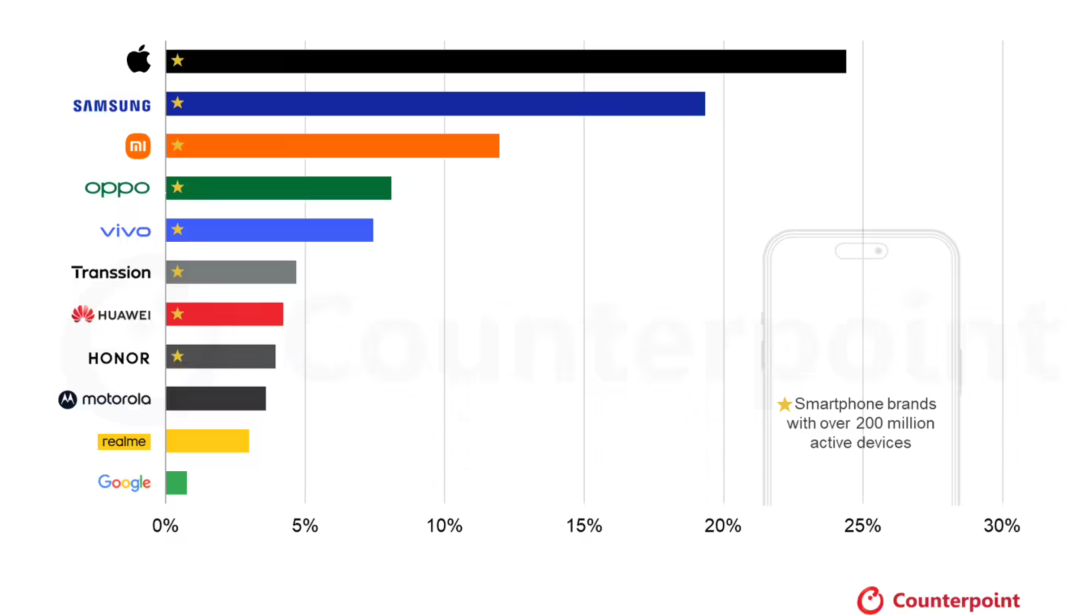

CounterPoint 报告 2025 全球手机存量:8 大品牌破 2 亿,苹果三星断层领先

2 月 10日,Counterpoint Research 发布博文,报告称 2025 年全球智能手机活跃设备存量同比增长 2%,换机周期延长至近四年。

目前全球已有八家智能手机厂商的活跃设备存量超过 2 亿台,这八大品牌合计占据了全球超过 80% 的活跃设备份额,呈现出强者愈强的竞争格局。

细分到厂商方面,在所有厂商中,苹果与三星展现出断层式的领先优势,是仅有的两家活跃设备数突破 10 亿大关的品牌,两者合计占据了全球 44% 的份额。附上相关图表如下:

(来源:IT之家)

累计交付近 37 万辆 雷军宣布初代小米 SU7 正式停产

2 月 11 日消息,昨晚,小米 CEO 雷军开启小年夜直播,这是雷军 2026 年开年以来的第五场直播。

雷军在今晚的直播中透露,最后一辆初代小米 SU7 量产下线,正在运送途中,将安排车主提车,这也意味着初代小米 SU7 正式停产。

据雷军介绍,初代小米 SU7 累计交付量接近 37 万辆。购买最后一辆初代 SU7 的车主是一位 50 多岁的老米粉,从事石油行业,曾长期在国外生活,回国后第一时间选择购买小米汽车。

资料显示,初代小米 SU7 于 2024 年 3 月 28 日正式发布,提供标准版、Pro 版和 Max 版,售价分别为 21.59 万元、24.59 万元和 29.99 万元。据了解,新一代 SU7 预计 2026 年 4 月上市,同样提供标准、Pro、Max 三个版本,预售价分别为 22.99 万元、25.99 万元和 30.99 万元。

新一代小米 SU7 全系标配 V6s Plus 超级电机,全系标配激光雷达、700TOPS 辅助驾驶算力、4D 毫米波雷达、Xiaomi HAD 端到端辅助驾驶。

在安全方面,新一代 SU7 还将全系标配 2200MPa 小米超强钢「内嵌式防滚架」,进一步强化车身结构安全。(来源:快科技)

《黑神话:钟馗》发布 6 分钟实机预告 冯骥发文:别太严肃 差不多得了

2 月 10 日,游戏科学官方发布了《黑神话:钟馗》贺岁性质的 6 分钟「实机小短片」。简要展示了似乎是人和鬼共同烹制菜肴的内容。《黑神话:钟馗》是游戏科学继《黑神话:悟空》后,推出的全新作品,本作最早于 2025 年科隆游戏展上亮相,目前仍在开发当中,发售时间暂未确定。

视频发布的同时,游戏科学创始人兼游戏制作人冯骥也发微博谈到了这支实机视频。

他这样写道:「不知各位看完后,是会心微笑?一头雾水?还是马上分析出一堆细节隐喻、剧情方向或者新的技术 feature?(……)别这么严肃,差不多得了。」

他也在微博中回答了大家的疑惑,毕竟这支短片没有操作没有战斗没有玩法更没有钟馗,因为「根本没做啊(bushi」。此外,他还解释了为什么这支短片是以「吃」为主题,因为「只有吃这件事,才能带来最高频也最稳定的幸福感」。文末,他也向各位玩家献上了新年的祝福:「即将到来的马年,祝大家总是享受吃饭,偶尔享受做饭;常有不错的胃口,最好还有人一起愉快的用餐。人生不只游戏,还有很多、很多好吃的东西。」(来源:快科技)

传百度临近春节秘密启动「O 计划」,内部人士:与百度 App 有关

近日,网传百度内部启动代号「O 计划」项目,内部人士对新浪科技透露该计划与百度 App 有关。

据此前媒体报道,百度 APP 旗下文心助手月活用户数已突破 2 亿,与豆包、千问形成国内三大亿级 AI 入口。百度也曾以 5 亿红包最早入局春节 AI 战,并拿下《2026 北京广播电视台春节联欢晚会》首席 AI 合作伙伴身份。对比行业玩家春节主阵地多为独立 App,而百度包括此次「O 计划」若仍围绕百度 App 展开,可见其仍是百度重点的 AI 入口。(来源:新浪科技)

淘宝闪购:三四线城市年货订单增幅超 580%

2 月 11 日消息,临近小年,即时零售平台年货旺销,淘宝闪购年货销量同比增长超 347%,三四线城市年货订单同比增长超 580%,其中大庆、咸阳、宜昌、潍坊、湛江等城市订单同比增长超一二线主流城市。返乡潮下,下沉市场逐渐成为当下年货节的消费主场。

此外,今年春节,淘宝闪购携手全国零售商超及品质仓门店全程「不打烊」,营业商户数同比增长 32.9%,年货节商品总量较去年显著提升,乡县地区 30 分钟送达已成常态,全国重点城市连锁商超及淘宝便利店等合作门店,春节期间线上门店营业率超过九成。(来源:新浪科技)

互联网大厂春节红包大战首日战报出炉 千问 App 日活暴涨 727.7%

2 月 11 日消息,QuestMobile 发布数据显示,新春活动启动后,多款 AI 应用迎来用户规模快速增长。

其中,在新春活动首日(2 月 6 日),阿里旗下千问 App 日活跃用户(DAU)暴涨 727.7%,达到 5848 万,较前一日净增超过 5100 万,增长幅度十分显著。相比之下,腾讯元宝在活动首日(2 月 1 日)的 DAU 规模为 2399 万,较前一日增长 2.1 倍,同样实现明显拉升。(来源:快科技)

米哈游法务部:终止与汇业律所合作,远景能源撤诉

2 月 10 日消息,米哈游法务部今日发布《关于终止与上海市汇业律师事务所合作的声明》,宣布终止与原常年法律顾问汇业律所的一切合作关系,停止委托其处理任何与米哈游相关的法律事务,同时将上海市汇业律师事务所永久列入公司合作方黑名单,永不合作。

这份声明同时提到,远景能源有限公司已向江阴市人民法院申请撤回前述其与米哈游之间网络侵权责任纠纷案件的起诉,江阴市人民法院已裁定准许其撤诉。(来源:IT 之家)

字节跳动图像生成模型 Seedream 5.0 上线,可免费体验

2 月 10 日,字节跳动旗下图像生成模型 Seedream 5.0 正式上线,在视频编辑应用剪映、剪映海外版 CapCut、字节 AI 创作平台小云雀均已可用。同时,该模型在即梦 AI 平台开启灰度测试,图片生成可限时免费体验。

据悉,新模型主要增强体现在准确性与智能水平、更快的图像创建表现力以及联网知识整合能力。在智能水平方面,Seedream 5.0 能够深入理解提示词语义,生成与用户意图匹配度更高、细节更精准、布局更清晰的图像。针对风格化效果,模型的图像到图像功能增强了风格化表现,提供更清晰细节、精致纹理和平衡的照明效果。本次升级还新增了编辑功能,用户可以通过控制笔刷精准选择并调整相应元素。(来源:新浪科技)

腾讯混元推出 0.3B 端侧模型,内存占用仅 600MB

2 月 10 日,腾讯混元宣布,基于首个产业级 2Bit 端侧量化方案,正式推出一款面向消费级硬件场景的「极小」模型 HY-1.8B-2Bit,等效参数量仅有 0.3B,内存占用仅 600MB,比常用的一些手机应用还小。

据介绍,通过对此前混元的小尺寸语言模型——HY-1.8B-Instruct 进行 2 比特量化感知训练(QAT)产出,这一模型对比原始精度模型等效参数量降低了 6 倍,并且在沿用原模型全思考能力同时,在真实端侧设备上对比原始精度模型生成速度提升 2—3 倍,可大幅提升使用体验。(来源:IT 之家)

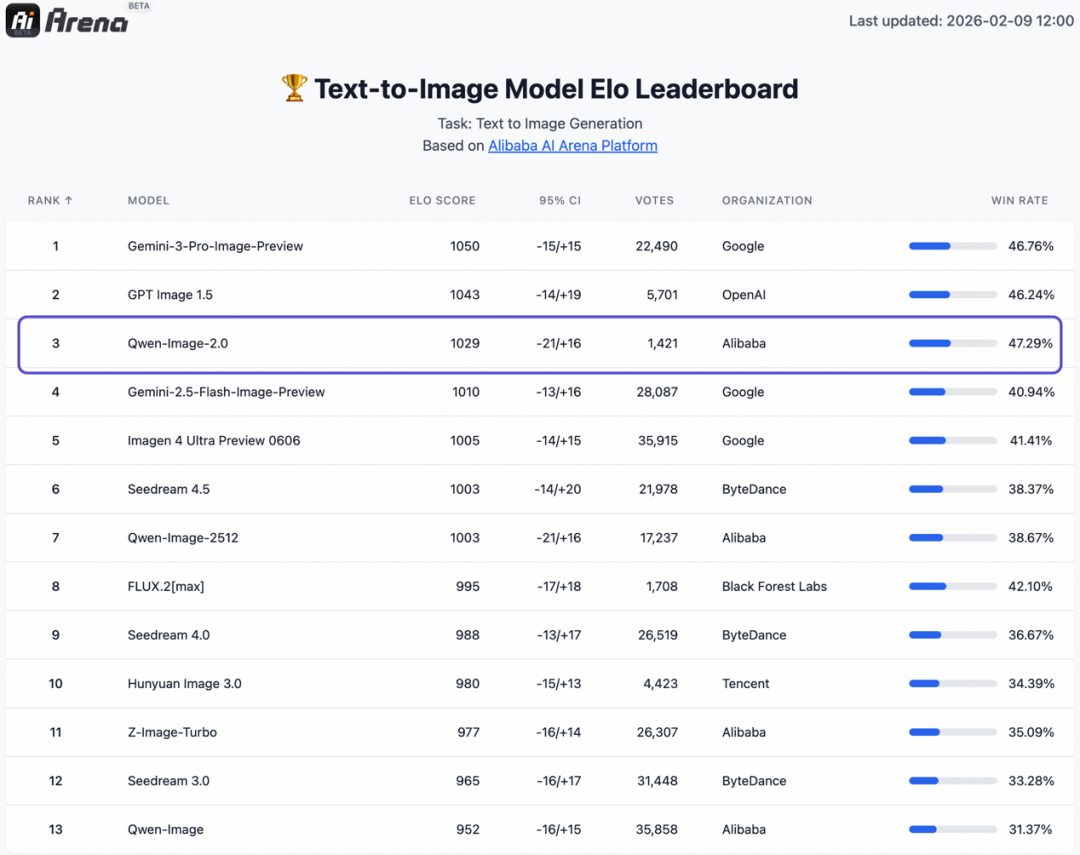

千问发布最新图像模型 Qwen-Image-2.0,超长文字渲染,摄影级真实质感

2 月 10 日,阿里巴巴正式发布新一代图像生成及编辑模型 Qwen-Image-2.0。作为千问大模型的图像生成模型底座,Qwen-Image-2.0 集生图和编辑于一体,在 AI Arena 文生图评测中斩获 1029 分,超过 Seedream4.5、Flux2-Max 等模型,仅次于谷歌 Nano Banana Pro 和 GPT Image1.5。Qwen-Image-2.0 支持 1K token 的超长文字输入和 2K 高分辨率,可准确渲染复杂指令,轻松生成专业的 PPT 及信息图,质感媲美专业级摄影师;同时,千问新模型拥有极强中文汉字渲染能力,数百字的古文全文几乎都能完全渲染在图片中。

Qwen-Image-2.0 在 Qwen-Image 和 Qwen-Image-Edit 两大模型基础上全新升级,首次将图像生成和编辑统一到一个模型中去,以更轻量的模型架构,实现了生图和改图性能的大幅提升。Qwen-Image-2.0 生图质感尤为细腻,小至老人皱纹的褶皱,大到浩然宇宙,模型生成的人物、自然、建筑等常用图片都极其逼真。在权威评测 AI Arena 中,千问新模型在图像生成中得分 1029,位列第三;在图片编辑中得分 1034,仅次于 Nano Banana Pro。(来源:阿里)

机器人首次拥有时空记忆!阿里达摩院开源具身大脑基模 RynnBrain

2 月 10 日消息,阿里巴巴达摩院发布具身智能大脑基础模型 RynnBrain,并一次性开源了包括 30B MoE 在内的 7 个全系列模型。RynnBrain 首次让机器人拥有了时空记忆和空间推理能力,智能水平实现大幅跃升。

在 16 项具身开源评测榜单上刷新纪录(SOTA),超越谷歌 Gemini Robotics ER1.5 等行业顶尖模型。

据介绍,RynnBrain 模型创造性地引入了时空记忆和物理世界推理,这是机器人与环境互动所需的两项基本能力。

时空记忆能力可让机器人在其完整的历史记忆中定位物体、目标区域,甚至预测运动轨迹,从而赋予机器人全局时空回溯能力。

物理空间推理不同于传统的纯文本推理范式,RynnBrain 采用文本与空间定位交错进行的推理策略,确保其推理过程紧密扎根于物理环境,大大减弱了幻觉问题。

例如,运行 RynnBrain 模型的机器人,在执行 A 任务中被突然打断要求先做 B 任务,它能记住 A 任务的时间和空间状态,等完成 B 后继续工作。(来源:快科技)

iKKO Mind One AI 小手机国行上市:主摄可翻转、方形 AMOLED 面板,2899 元

制造商 iKKO 旗下 Mind One AI 小手机国行版本现已在天猫发售,该机主打迷你外观,整合 AI 助手,还能安装全键盘保护壳,国内销售的均为 Pro 版机型,8GB RAM + 256GB 存储定价 2899 元。

IT 之家注:Pro 版机型配 H9 硬度面板(海外标准版使用 H7 硬度面板),同时 Pro 版号称内置的 AI 助手可以在全球 60 多个国家地区免费使用,无需支付移动流量 / Wi-Fi 费用。

该机整体尺寸为 86 x 72mm,厚度为 8.9 mm,配备一块 4 英寸方形 AMOLED 面板,手机背面提供可以翻转的 50MP 索尼 1/1.56 英寸主摄。机器搭载联发科 MT8781 平台,匹配 8GB RAM 和 256GB 存储,内置安卓 15 和一款 iKKO AI OS 系统,提供 Nano SIM 卡槽 + vSIM(注:不是 eSIM)。其他方面,该机(在海外市场)提供一款全键盘保护壳,相应保护壳提供 3.5mm 耳机接口,同时内置 DAC 芯片(CS43198),强调有线外放音质。(来源:IT 之家)

传奇程序员 John Carmack 设想用 200 公里光纤代替内存

传奇程序员约翰 · 卡马克(John Carmack)于 2 月 7 日在 X 平台发布推文,提出一项颠覆性构想:利用长达 200 公里的光纤线路替代传统的 DRAM,充当 AI 数据的二级缓存(L2 Cache)。

卡马克认为,在 AI 模型训练与推理过程中,为了追求极致的带宽和极低的延迟,传统的 DRAM(动态随机存取存储器)可能并非唯一解。他设想构建一个物理上长达 200 公里的光纤环路,利用光信号在纤维中传输的时间差来暂时「存储」数据。

卡马克指出,目前的单模光纤技术已能在 200 公里的距离上实现 256 Tb/s 的传输速率。根据计算,在这个长度的光纤内部,任意时刻都有约 32GB 的数据处于「飞行传输」状态。

这意味着,这根光纤本质上变成了一个拥有 32 TB/s 超高带宽、容量为 32GB 的存储器。这种「在传输中存储」的方式,特别适合处理具有确定性权重参考模式的神经网络数据。

这一前卫设计让不少资深技术专家联想到了计算机发展初期的「延迟线存储器」(Delay-line memory)。计算机先驱们早在上世纪中叶,曾利用水银管或加金酒(Gin)混合液作为介质,通过声波的传播延迟来存储数据。

卡马克的方案在原理上与其异曲同工,只是将介质换成了光纤,载体换成了光子。相比需要持续供电刷新才能保存数据的 DRAM,光传输的能耗极低,这在 AI 能耗日益庞大的今天具有巨大的理论吸引力。

不过这项技术也面临巨大的技术挑战,尽管光传输节能,但铺设或盘绕 200 公里长的光纤本身成本极高,且配套的光放大器和数字信号处理器(DSP)也会消耗额外能源,可能抵消部分节能优势。

埃隆 · 马斯克(Elon Musk)认同这个颠覆性构想,认为这是有趣的想法,使用高折射率材料,可以进一步减慢光速,增加每公里存储的数据量,甚至在讨论中提出了更为激进的「真空存储」设想,但这些目前更多停留在物理思维实验阶段。(来源: IT 之家)

*图片来源:视觉中国