由月之暗面 (Moonshot AI)推出的 Kimi K2 模型,在多项基准测试中取得了惊人的成绩。在 LiveCodeBench 基准上,该模型达到了 53.7 Pass@1 的惊人分数,以近 7 个百分点的优势击败了 DeepSeek-V3,并以超过 16 个百分点的优势大幅领先于 Qwen-235B。

在单次调用(single-shot)的 SWE-bench 智能体编码测试中,其得分高达 65.8%;在 Tau2 零售工具使用测试中,得分更是达到了 70.6%。这些数据使其稳居或接近现有开源模型的顶尖水平。

核心亮点

模型规模:总参数量高达 1 万亿 的专家混合模型 (Mixture of Experts, MoE),激活参数量为 320 亿。 训练优化:使用定制的 Muon 优化器 进行训练。 能力卓越:在前沿知识、推理和代码任务方面表现非常出色。 SOTA 表现:在 SWE Bench Verified、Tau2 和 AceBench 等多个基准测试中,位列开源模型之首。 训练稳定性:在 15.5 万亿 tokens 的预训练过程中,实现了零训练不稳定性。 智能体智能:专为工具使用、推理和自主解决问题而设计。

训练方法创新

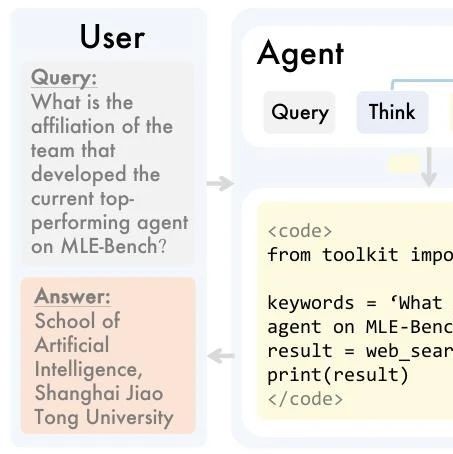

为了提升模型的智能体能力,月之暗面构建了数千个模拟工具环境,让模型同时扮演“执行者”和“批判者”的角色,并从中为强化学习收集了大量高质量的交互轨迹 (traces)。

对于像数学这样可验证的任务,模型使用明确定义的奖励信号;而对于目标模糊的任务,则由模型本身依据评估标准 (rubric prompts) 进行判断,从而建立了一个低成本且可扩展的反馈循环。

他们用自研的 Muon 优化器 取代了 AdamW,并配合使用 MuonClip 技术来解决训练过程中的稳定性问题,确保模型在学习时保持平稳。

MuonClip 的工作原理是在每次更新后重新缩放查询 (query) 和键 (key) 的权重,以此限制失控的注意力分数,从而在整个 15.5 万亿 tokens 的训练过程中保持了损失曲线的平滑。

由于曲线平稳,团队能够一次性向 Kimi K2 投喂海量数据而无需担心出现任何剧烈的峰值。稳定的训练也意味着更少的数据和计算资源浪费,使得模型在同等预算下能够达到更高的智能水平。

定价

$0.15 / 百万输入 tokens (缓存命中) $0.60 / 百万输入 tokens (缓存未命中) $2.50 / 百万输出 tokens

可用性

API 接入:其 API 端点与 OpenAI 和 Anthropic 的模式兼容,而私有化部署的用户可以通过

vLLM、SGLang、KTransformers或TensorRT-LLM加载权重。开源许可:模型权重在 修订版 MIT 许可证 (Modified MIT License) 下发布,对商业用途友好。

🔗 技术博客:https://moonshotai.github.io/Kimi-K2/

🔗 Huggingface 权重与代码:https://huggingface.co/moonshotai

🔗 Github:https://github.com/MoonshotAI/Kimi-K2

🔌 API 接入点:https://platform.moonshot.ai/docs/introduction#text-generation-model

立即试用:https://www.kimi.com/

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!