M50的发布,只是一个开始。

“端边AI”,早已不是一个新颖词汇。

当 AI 大模型从数据中心的 “超级计算机” 里走出来,试图钻进你的手机、汽车和办公电脑时,真正的挑战才刚刚显现:端边设备的“算力天花板”。

轻量化模型让大模型能“挤” 进端边设备,但传统芯片要么算力不够支撑流畅运行,要么功耗太高让设备续航骤降—— 就像给自行车装了跑车发动机,要么跑不起来,要么很快耗尽能量。

那么,为什么在端边领域的应用中,传统芯片显得力不从心?

传统芯片在端边AI 场景中表现乏力,本质上是 “设计目标与场景需求的错位”。传统通用芯片(如 CPU、普通 GPU)的架构逻辑,是为通用计算场景设计的 —— 它们需要兼顾办公、娱乐、基础运算等多元需求,无法针对端边 AI 的核心诉求(低功耗下的高效推理)做深度优化。

因此,用传统通用芯片在端边设备做AI 计算,容易陷入“性能与功耗的矛盾”。举个例子,智能摄像头的供电通常不超过5W,若用传统 GPU 做图像识别,要么因功耗超标频繁死机,要么因降频导致识别准确率下降。

如今大模型向端边下沉的趋势已经明确,用户需要大模型在端边设备上实现“本地快速响应”,但端边设备的物理约束(功耗、体积、成本)又给芯片套上了枷锁。

后摩智能即将落地的存算一体端边 AI 芯片,正是要打破这个困局。它不是简单提升算力参数,而是用架构创新重构了计算逻辑,让端边设备能真正“扛住” 大模型的运行需求。

后摩智能 M50 芯片,最新登场

后摩智能 M50 芯片,最新登场

7月25日,WAIC 2025 前夕,后摩智能正式发布全新端边大模型 AI 芯片——后摩漫界M50,同步推出力擎系列M.2卡、力谋系列加速卡及计算盒子等硬件组合,形成覆盖移动终端与边缘场景的完整产品矩阵。

性能方面,M50 芯片实现了160TOPS@INT8、100TFLOPS@bFP16 的物理算力,搭配最大 48GB 内存与153.6 GB/s 的超高带宽,典型功耗仅 10W,相当于手机快充的功率,就能让PC、智能语音设备、机器人等智能移动终端高效运行1.5B 到 70B 参数的本地大模型,真正实现了"高算力、低功耗、即插即用"。

这已是后摩智能推出的第二代端边大模型AI 芯片。

2024年6月,后摩智能推出了首款端边大模型AI芯片——后摩漫界 M30。这款芯片算力达到100TOPS,典型功耗仅为12W,能够支持包括ChatGLM、Llama2、通义千问在内的多种大模型。

当前大模型行业正经历深刻变革,ChatGPT 仅用 2 年便达成 Google 11 年积累的年搜索量规模,超级应用用户破亿的时间从手机时代的 16 年压缩至 ChatGPT 的 2 周。行业已进入"推理密度"与"能耗密度"双重敏感阶段,未来五年推理成本将占大模型全生命周期 80% 以上。在端边大模型部署"最后一公里"的竞争,或将成为决定未来产业格局的重要拐点。

上述两款产品,便是后摩智能在这一行业变革浪潮中交出的答卷,也是其深耕端边大模型 AI 芯片领域的有力见证。

然而,在端边大模型落地中,底层芯片仅靠堆砌算力参数远远不够—— 当算力需求与功耗、体积的约束持续碰撞,架构创新正愈发成为破局的关键。

存算一体:端边大模型的“关键一跃”

存算一体:端边大模型的“关键一跃”

后摩智能也有着它与众不同的解法,便是存算一体。

存算一体端边芯片的核心是将“存储” 与 “计算” 功能在硬件层面深度融合,打破传统芯片中 “数据在存储器与计算单元间频繁搬运” 的架构限制,从而提升数据处理效率、降低功耗。

简单来说,就是把传统芯片里“分离的计算单元和存储单元” 融合成一个整体 —— 就像把厨房和餐厅合并,厨师做完菜能直接端上桌,省去了传菜环节。

从技术逻辑看,传统芯片的计算单元和存储单元是分离的,处理数据时需要先从存储器读取数据,计算完成后再写回,这个过程会产生延迟和能量损耗。而存算一体技术让数据可以在存储单元内部直接完成计算,减少了数据搬运的环节—— 这对端边场景至关重要,因为端边设备往往受限于体积、功耗(比如摄像头、边缘网关),同时又需要快速处理本地数据(如实时图像识别、边缘推理)。

从端边场景适配来看,这类芯片能更好满足“低功耗”“低延迟” 需求:一方面,省去数据搬运的能耗,契合端边设备的续航要求;另一方面,本地直接计算缩短了响应时间,符合端边场景对实时性的要求(比如工业传感器的即时数据反馈)。此外,存算一体架构还能通过简化数据流转,降低数据在传输过程中的安全风险,这也贴合端边场景 “数据本地化安全” 的核心诉求。

存算一体芯片的价值,不止于解决当下的落地难题,更在于它重新定义了端边大模型的“可能性边界”。

过去,端边大模型的应用只能在“低算力、低体验” 和 “高成本、高功耗” 之间二选一。而后摩智能的存算一体芯片,让端边设备有了“低成本、低功耗、高性能” 的三角平衡能力。

M50 芯片作为这项技术的集大成之作,其第二代SRAM-CIM双端口存算架构能让权重加载和矩阵计算同时进行,支持多精度混合运算,可兼顾模型部署的各项需求;后摩智能自主研发的第二代 IPU 架构——天璇,通过压缩自适应计算周期实现弹性计算(Elastic Computing),最高可提供 160% 的加速效果;通过内建的高速多芯互联技术,可实现算力与带宽扩展;同时适配后摩智能新一代编译器后摩大道,可根据芯片架构自动选择最优算子,无需开发者手动尝试;支持浮点运算,无需量化参数和精度调优。和传统架构相比,M50 的能效提升 5~10 倍,完美适配了端边设备"算得快又吃得少"的需求。

后摩智能 CEO 吴强博士向半导体产业纵横表示:在存算一体技术研发中,后摩智能在其自研二代存算一体技术创新中也取得诸多突破,包括双端口存算架构、灵活的存算分离可测性设计、8bit/16bit混合精度设计以及双电源轨设计等,在基于存算一体技术的端边AI芯片中,后摩智能是一位创新性的先行者。

这种架构创新为行业提供了新的技术路线。当存算一体证明“不用追先进制程也能提升性能”,端边芯片的竞争将从“参数比拼” 转向 “效率优化”—— 谁能更精准地匹配大模型的计算特性,谁能更好地适配端边设备的物理约束,谁就能占据先机。

除了 M50 芯片,后摩智能此次发布的产品矩阵形成了覆盖端侧到边缘的多元算力方案。力擎LQ50 M.2 卡以口香糖大小的标准 M.2 规格,为 AI PC、AI Stick、陪伴机器人等移动终端提供 "即插即用" 的端侧 AI 能力,支持 7B/8B 模型推理超 25tokens/s;力擎LQ50 Duo M.2 卡集成双 M50 芯片,以 320TOPS 算力突破 14B/32B 大模型端侧部署瓶颈;力谋LM5050 加速卡与力谋LM5070 加速卡分别集成 2 颗、4 颗 M50 芯片,为单机及超大模型推理提供高密度算力,最高达 640TOPS;BX50 计算盒子则以紧凑机身适配边缘场景,支持 32 路视频分析与本地大模型运行。

这些产品可广泛应用于消费终端、智能办公、智能工业等多元领域,且均能在离线状态下实现全流程本地处理,从源头杜绝数据联网传输风险。例如在消费终端,赋能笔记本、平板电脑、学习机等设备本地大模型推理能力,无需联网即可完成智能交互、内容生成等任务,用户隐私数据全程闭环留存;智能办公场景中,智能会议系统在断网环境下仍能实现多语种翻译、纪要生成,会议内容不触云、不泄露;智能工业领域,产线质检与车路云协同通过本地算力完成实时分析决策,生产数据与运营信息在设备端闭环处理,避免云端传输隐患。后摩智能通过存算一体技术与大模型的深度融合,推动 AI 大模型在端边侧实现 “离线可用、数据留痕不外露”,构建起 “低功耗、高安全、好体验” 的端边智能新生态。

结语

结语

大模型向端边下沉的过程,就像当年计算机从机房走向桌面—— 真正的爆发点,不是技术概念的出现,而是适配场景的硬件基础设施成熟。

后摩智能的存算一体芯片,正是这样的基础设施。它用扎实的架构创新着手解决“落地最后一公里” 的问题。

面向未来,后摩智能已启动下一代 DRAM-PIM 技术研发,通过将计算单元直接嵌入 DRAM 阵列,使计算与存储的协同更加紧密高效。该技术将突破 1TB/s 片内带宽,能效较现有水平再提升三倍,推动百亿参数大模型在终端设备实现普及,让更强大的 AI 算力能够融入 PC、平板等日常设备。

这样的技术方向和发展愿景也得到了重量级产业方和国有资本的认可,近两年以来,后摩智能已经获得了中国移动产业链发展基金、北京市人工智能基金,北京市亦庄产业升级基金、中国国有企业混改基金等多家机构的投资,为在端边大模型芯片领域的持续创新提供了有力支撑。后摩智能 CEO 吴强博士表示:“M50 的发布只是一个开始,我们的目标是让大模型算力像电力一样随处可得、随取随用,真正走进每一条产线、每一台设备、每一个人的指尖。”

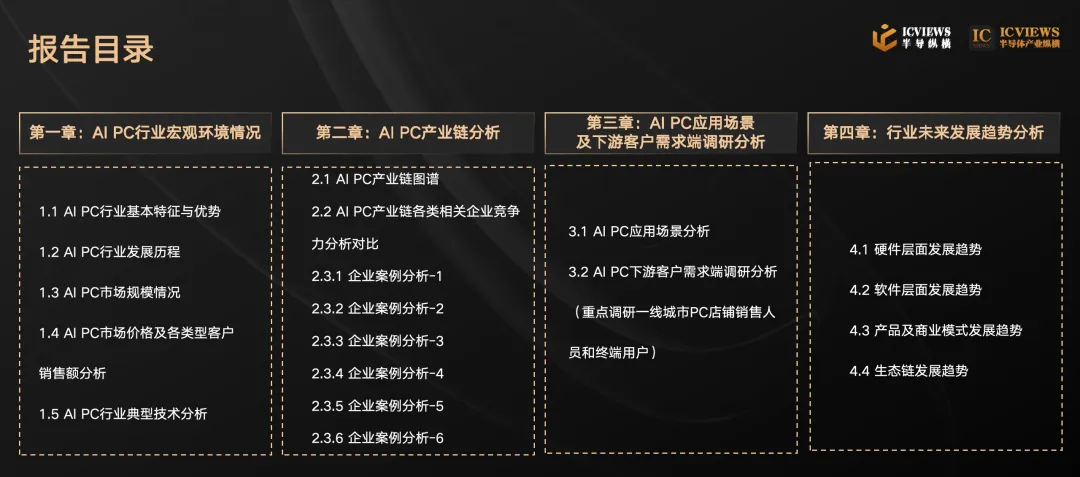

AI PC产业研究报告

为帮助PC领域硬件层、软件层、模型层及终端层各类玩家更清晰地了解AI PC行业的发展现状及未来发展趋势,半导体产业纵横筹备撰写《AI PC产业研究报告》。现征集AI PC产业链各类厂商案例,该报告将通过半导体产业纵横全媒体矩阵发布,参与的案例可获得丰富的宣发支持和曝光机会。本次案例征集自即日起,报告预计7月发布,欢迎相关企业积极参与探讨!有意者联系我方商务:

* 微信号1: icviews2

* 微信号2: Joy8432211