新智元报道

新智元报道

【新智元导读】群核科技正构建具身智能时代的「3D版ImageNet」。其打造的SpatialVerse平台,为机器人提供高质量三维数据与仿真环境,有望突破Sim2Real难题。借助3D高斯溅射与空间大模型,群核发布全球首个大规模3D语义数据集InteriorGS,为AI理解和适应物理世界奠定基础。

推动历史的人,往往在当时并不知道他正改变世界。

2009年,苹果还没发布iPhone 4,但李飞飞却已经打造了一个包含320万张图片的ImageNet数据集给「机器学习」。

2012年,Hinton和他的学生Ilya、Alex在ImageNet竞赛中以AlexNet模型横扫千军。

Ilya后来成为OpenAI的创始成员,他们的产品ChatGPT开创了如今的大语言模型时代!

而Hinton成为了AI之父。

假如没有ImageNet这个海量、真实、复杂的数据集「燃料」,也许深度学习这个引擎,就不会这么快的点火启程,也许今天的AI也不会如此迅猛。

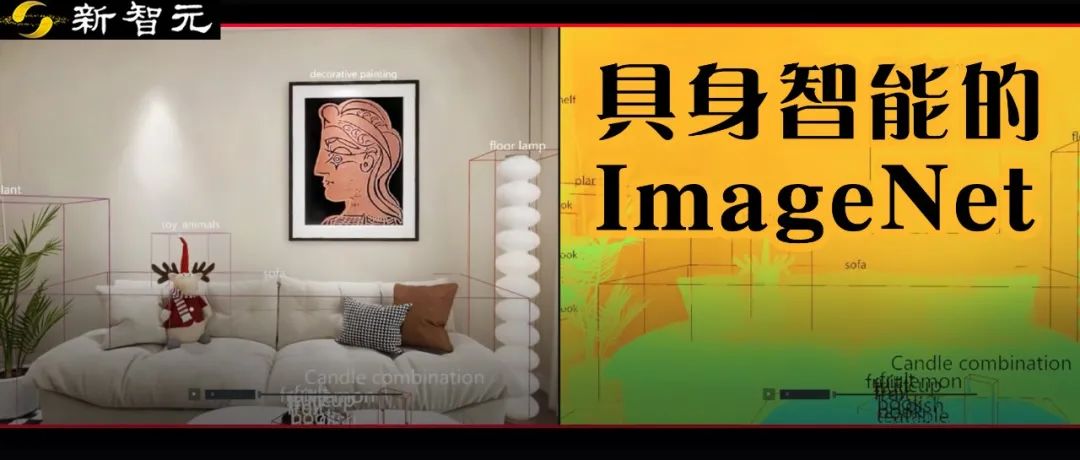

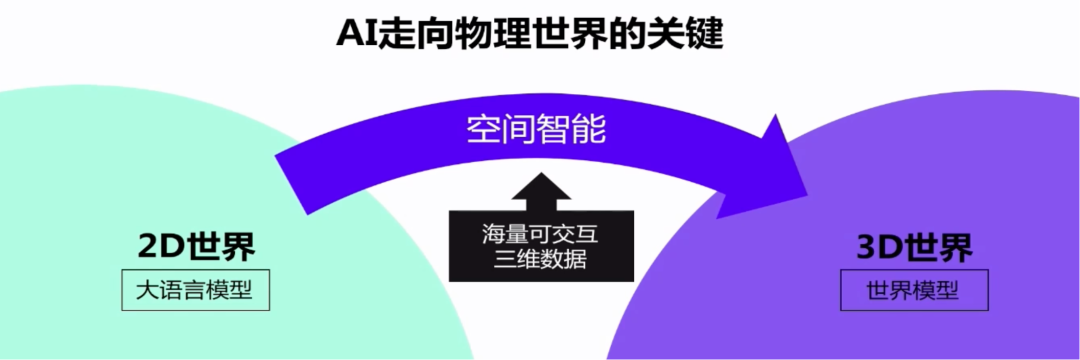

如今,AI正在从二维世界进入三维世界,关键就是空间智能。

ImageNet同样的历史或许正在具身智能和仿真合成数据领域上演。

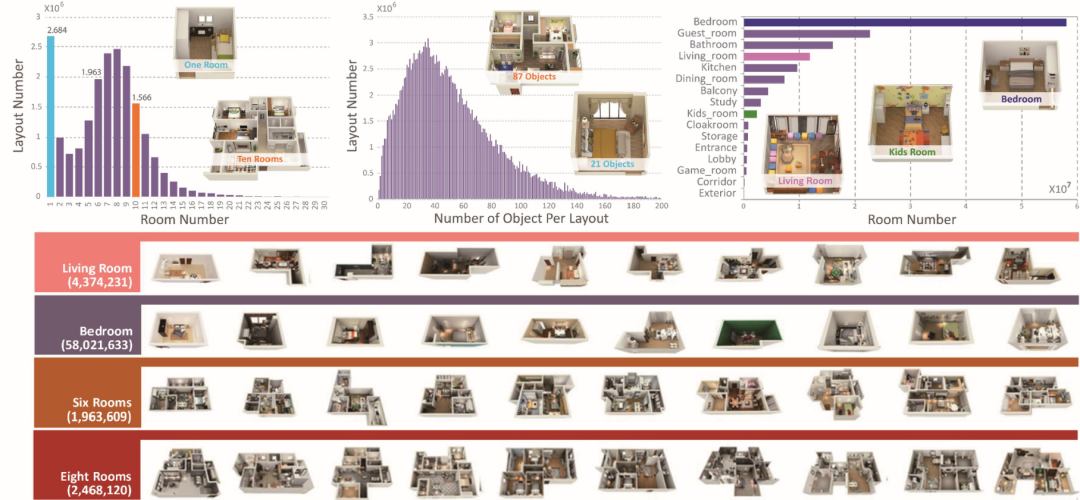

2018年,一个空间领域的3D数据集——InteriorNet,引起了学术界的关注。这是当时全球最大的室内空间认知深度学习数据集。

彼时的硅谷科技企业们,正开始探索通过合成数据的方式去训练智能体,InteriorNet数据集的出现,令他们眼前一亮。

InteriorNet数据集(包含约1亿3千万图像数据)

推出数据集的这家企业,便是群核科技。

2024年,群核科技推出群核空间智能平台SpatialVerse。同年,李飞飞也宣布自己的World Labs成立,只用一张图就能生成3D世界。

但3D数据和类似ImageNet的2D数据有着本质的不同。

李飞飞当年靠着亚马逊众包平台,依靠人力完成了海量数据(1500万张图片)的标注工作。

而3D数据,却是极度的稀缺。

虽然还有数据稀缺等问题,但空间智能与具身智能成为下一个AI发展的主流领域,已成为行业的共识。

就在刚刚结束的WAIC 2025大会上,空间智能与具身智能彻底登上了大会的「主舞台」。

新智元现场观察到,整个展馆二楼H3都打造成了一只规模庞大的「机器人方阵」,超过150台形态各异的机器人集体亮相。

与以往大都静态展示不同的是,这次的机器人全都动了起来——拳击、架子鼓、制作咖啡甚至是拧螺丝,各种花活全都给整上了。

但正如机器人跑起来还是踉踉跄跄、时不时躺平给你看一样,具身智能的发展还有很多挑战。

我们不得不思考,未来当机器人真正进入人类生活——无论是客厅、工厂,还是商业空间——它们如何识别笔记本、茶杯、椅子、或是一道门?

又如何学习从「看」到「动」,从「观察」到「执行」?

当具身智能机器人来到你家的客厅,它如何识别出笔记本、食物、椅子、或是茶杯?

具身智能的崛起,离不开对3D世界的深刻理解和丰富交互。

正如图像识别需要ImageNet那样,具身智能也亟需一个「3D版的ImageNet」。

然而,现在正面临的是一个前所未有的难题:空间智能训练所需的数据远比2D图像复杂,数据的获取成本和难度呈指数级上升。

群核科技当时推出的InteriorNet深度学习数据集,包含了1600万组像素级标签数据和1.5万组视频数据,共计约1亿3千万图像数据。

但AI走进物理世界,还需要更多3D数据。

当前空间智能/具身智能行业存在的挑战有很多,但是主要挑战是数据困境,而仿真数据生成困境最为突出。

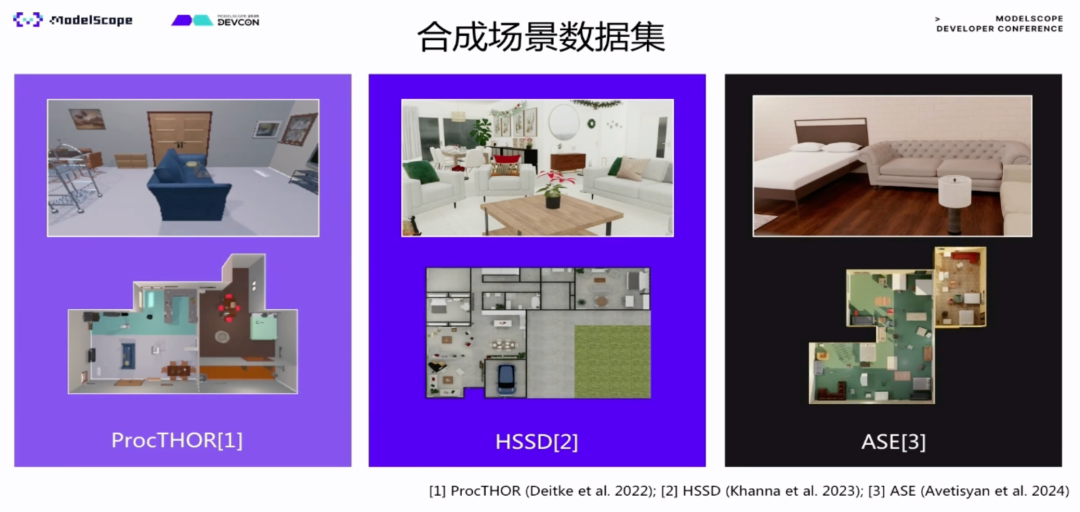

当前,具身智能获取训练数据的主要途径可归为三大类:真实数据(Real-World Data)、互联网数据(Internet/Passive Data)与仿真合成数据(Simulated/Synthetic Data)。

真实数据,可以理解为机器人在物理环境中实际执行任务时,使用传感器、摄像头、力觉器件等采集的一手数据。

Physical Intelligence(加州创业公司)通过大量真实机器人运动与传感器数据训练具身智能模型。

这些数据虽然完全符合物理规律,但是缺点明显:

成本高昂:每一条数据采集往往需专人操作+场地布置+高精设备,1小时采集动辄数千元;

采集效率低:不能并行采集,任务复杂度高导致低通量;

复现性差:不可控因素多,难以完全复刻采集场景用于训练或验证。

互联网数据,可以理解为「机器人看,然后机器人跟着做」,指的是具身智能系统在观看教程后进行学习。

康奈尔大学开发的RHyME框架,机器人仅通过观看网络上的教学视频就能学习执行任务,缺乏物理反馈通道。

这种方法缺点更加明显:

缺乏交互性:被动观察而非主动探索,难以建模因果关系;

缺失物理信息:无力觉、无反馈、无环境状态变化;

标注困难:从无序视频中提取可用信息成本高,易引入偏差;

难以迁移:从人类视频中学习得来的策略不一定适用于机器人身体和运动限制。

仿真合成数据可以理解为通过3D引擎、图形渲染技术或物理模拟器合成的数据,包括图像、深度、碰撞反馈、动作序列等,通常在虚拟环境中自动生成。

相比上面两种方式,仿真合成数据是目前的主流。

英伟达发布的Open Physical AI Dataset,就提供了超过320,000条仿真轨迹、1000个SimReady场景资产等,为物理AI提供大规模合成交互数据基础。

真实数据在泛化性、操作成本、数据安全上都存在局限,而普通仿真合成数据存在非常大的Sim2Real的gap:

「Reality Gap」(现实鸿沟)问题:仿真环境再逼真也存在与现实世界的偏差;

物理真实性受限:模拟的摩擦、碰撞、柔性物体行为难以完美还原现实;

对仿真平台依赖大:需要强大的渲染算力、引擎支持与场景建模能力。

传统仿真环境往往真实感不够,难以逼真再现现实世界的物理和视觉细节。

早期不少模拟器中的场景是手工建模或游戏引擎生成的,视觉上偏于卡通或简化,物理互动也不完善。

这种虚拟—现实差距(Reality Gap)导致智能体在模拟中学到的技能难以直接迁移到现实,Sim2Real效果不理想 。

2024年,李飞飞同样意识到未来的具身智能需要大量的高质量的3D数据,于是其新团队World Labs发布了首个空间智能AI模型,可以从单个图像一键生成3D世界。

而仅3个月就估值10亿的World Labs令业内恍然大悟:AI教母瞄准的,就是能进行推理的空间智能!

群核科技走的路线跟李飞飞接近。不过群核的优势在于十多年在产业场景中沉淀了大量室内空间的3D数据。

相比群核科技,或者大家更早听说的是酷家乐。酷家乐是群核科技的核心产品之一,已经沉淀一套空间编辑工具,且广泛应用在家居、建筑、商超、医院、电商,以及工业场景。

就像快手和可灵之间形成的飞轮效应,在过去产业落地过程中,酷家乐为群核沉淀了大量的物理正确的三维数据。

基于这片独一无二的数据沃土,群核得以训练出强大的空间大模型SpatialLM,深刻理解物理空间的规则与逻辑。

SpatialLM于2025年3月开源时,一度登上Hugging Face全球趋势榜前三。

面对高质量3D数据稀缺这一时代难题,群核科技一直在探索3D合成数据的方案。

比如群核科技在2024年推出的空间智能平台SpatialVerse,智能体通过高质量数据的充分训练,能够真正获得泛化能力,应对现实中的千万种复杂场景。

SpatialVerse平台犹如一个「数字道场」,它不仅能为场景中的物体赋予真实的物理属性,比如质量、摩擦力等。

它还能模拟门窗、抽屉的开合等动态交互。

更重要的是,基于SpatialVerse的合成数据引擎,可以将SpatialLM模型生成的结构化3D场景,泛化生成亿万级具有多样性的新场景。

利用这些虚拟场景训练出来的智能体(如具身机器人),能更好地适应和应用于真实世界,缩小仿真与现实之间的差距(Sim2Real Gap)。

这一路径既拓展了虚拟场景的数据来源,又提升了AI模型在现实场景中的实用性,强化了「数字道场」与物理世界的联动。其价值已在学术界和产业界获得了一系列广泛验证。

学术界:谷歌与斯坦福大学的联合研究论文FirePlace中,也明确致谢SpatialVerse平台提供的高质量3D场景数据。此外,群核科技还与英特尔实验室联合打造高真实感的智能机器人仿真平台(如SPEAR),在与上海人工智能实验室的合作中,为「桃源」提供高质量3D数据。

产业界:「稚晖君」彭志辉参与创办的明星企业智元机器人,已采用SpatialVerse提供的仿真数据进行机器人训练。此外,还有银河通用、穹彻智能、智平方、松应科技在内的一批具身智能企业与群核科技达成合作。

智元机器人在群核科技提供的仿真数据中训练

今年的WAIC大会上,他们提出了一个新的尝试,将前沿的3D高斯溅射技术与自研空间大模型深度融合。

这一套全新的仿真数据生成范式,通过3D高斯重建+空间大模型+物理仿真这三大技术的协同作用,打通「现实-虚拟-现实」的闭环路径。

群核科技仿真数据生成新范式

首先,3D高斯溅射(3D Gaussian Splatting)作为现实世界的「数据复刻师」,扮演了至关重要的一步。

仅需一段视频或一组图片,它便能以极高的保真度和效率,将物理世界复刻到数字世界。

相比于传统3D建模的漫长周期与高昂的成本,3D高斯技术更快、更轻量、更真实,甚至普通人也能轻松操作。

可以说,3D高斯技术是人类记录方式的一次升级——

从二维照片、视频跃迁到可任意漫游、沉浸式体验的三维空间!

说到这里,不得不提起一个暖心的故事。

不久前,群核科技的团队正是利用该技术,成功将一个拥有60余年历史、承载了很多人旧时温情记忆的老照相馆迁移到了云端——使其成为了一个永不关门的「时空胶囊」。

如此善举也迅速让这项前沿技术迅速火出圈。

体验链接:https://www.kujiale.com/pub/koolab/koorender/gifts

然而,仅仅有一个惟妙惟肖的数字外壳还是不够的。

机器人还要能「看懂」这个世界。例如,要能够理解「这是一张床,那是一扇可以打开的门」。

这便引出了新范式的第二个关键技术支柱:空间大模型的语义赋予。

如果说3D高斯重建了空间的「形」,那么空间大模型则会赋予其「神」。

群核科技自研的空间理解模型SpatialLM,能够对重建的点云数据进行深度分析,精准识别出场景中的物体、结构以及相互之间的关系,并打上精准的语义标签。

这便使原本仅是视觉奇观的3D场景,转化为一个机器人可理解、可推理、可交互的3D数据。

最后,通过群核空间智能平台SpatialVerse进行物理仿真与数据增强,完成了新范式的最后一环。

基于这条新范式,群核在WAIC 2025期间发布了新成果——高质量3D高斯语义数据集——InteriorGS。

该数据集包含1000个精细的3D高斯语义场景,覆盖超过80种室内环境,是全球首个适用于智能体自由运动的大规模3D数据集。

InteriorGS数据集的示例。该数据集提供了高质量的3D高斯点阵(3DGS)表示,以及实例级别的语义边界框和表示智能体可访问区域的占用图。红色和黄色轨迹分别表示地面机器人和无人机(UAV)的路径。值得注意的是,InteriorGS支持在连续3D环境中进行自由形式的智能体导航和交互,从而实现真实的空间智能训练与评估

从人类/地面机器人沿红色轨迹行进时的视角进行RGB渲染及对应的深度图

InteriorGS首次将3D高斯技术系统地引入AI空间训练领域,充分利用了其在场景重建上的效率和成本优势。

目前,该数据集已在HuggingFace和Github等平台开源,全球的开发者都可以下载使用。据了解,知名仿真平台RoboVerse正在用这批数据测试机器人训练效果。

Huggingface:

https://huggingface.co/datasets/spatialverse/InteriorGS

Github:

https://github.com/manycore-research/InteriorGS

就像自动驾驶需要仿真路测,在群核平台上,机器人可以在虚拟厨房练习分类收纳,在虚拟商店学习避障导航,在虚拟工厂中进行施工演练。

这些体验,都将转化为真实世界中的高效执行。

不光是机器人,包括AIGC和XR等新兴智能体,所有试图理解物理世界的新兴智能体,都需要高质量的3D数据来进行内容生成与模型训练。

当「理解空间、适配物理规则」成为智能体的基础素养,人机协同的边界将被彻底改写。

机器人真正成为养老保姆;XR真正融入人的生活和工作,而不仅是娱乐……

在具身智能全面到来之前,行业正致力于为它们搭建进化的桥梁——连接数字世界与物理世界,打通感知、理解与行动的闭环。