【导读】AI视频生成进入了秒生极速时代!UCSD等机构发布的FastWan系模型,在一张H200上,实现了5秒即生视频。稀疏蒸馏,让去噪时间大减,刷新SOTA。

单块H200,5秒即生一个5秒视频。

最近,UCSD、UC伯克利、MBZUAI三大机构联手,祭出FastWan系视频生成模型。

论文地址:https://arxiv.org/pdf/2505.13389

它的核心采用了「稀疏蒸馏」全新的训练方案,实现了高效生成,让视频去噪速度实现70倍飙升。

基于FastVideo架构,FastWan2.1-1.3B在单张H200上,去噪时间仅1秒,5秒内生成了480p的5秒视频。

在一张RTX 4090上,则耗时21秒生成一个视频,去噪时间2.8秒。

若仅计算DiT处理时间

升级版FastWan2.2-5B,在单张H200上仅用16秒即可生成720P的5秒视频。

FastWan模型权重、训练方案和数据集全部开源

如今,终于实现AI实时视频的生成了。

「稀疏蒸馏」究竟是什么,能够让模型如此快速地生成视频?

一直以来,视频扩散模型成为了AI视频生成领域的主流,比如Sora采用了扩散模型+Transformer架构。

这些模型虽强大,却长期受困于两大瓶颈:

1. 生成视频时,需要海量的去噪步骤

2. 处理长序列时的注意力二次方计算成本,高分辨率视频必然面临此问题。

就以Wan2.1-14B为例,模型需运行50次扩散步骤,生成5秒720P视频需处理超8万token,其中注意力操作甚至吞噬85%以上的推理时间。

此时此刻,「稀疏蒸馏」就成为了大杀器。

作为FastWan的核心创新,它首次在统一框架中实现稀疏注意力与去噪步骤蒸馏的联合训练。

其本质是回答一个根本问题:在应用极端扩散压缩时,如用3步替代50步,能否保留稀疏注意力的加速优势?

先前研究认为并不可行,而最新论文则通过「视频稀疏注意力」(VSA)改写了答案。

传统稀疏注意力,为何会在蒸馏中失效?

当前,现有的方法如STA、SVG,依赖的是多步去噪中的冗余性,来修剪注意力图,通常仅对后期去噪步骤稀疏化。

但当蒸馏将50步压缩至1-4步时,其依赖的冗余性彻底消失。

实验证实,传统方案在少于10步的设置下性能急剧退化——尽管稀疏注意力本身能带来3倍加速,蒸馏却可实现20倍以上增益。

要使稀疏注意力真正具备生产价值,必须使其与蒸馏训练兼容。

视频稀疏注意力(VSA)是动态稀疏注意力核心算法,能够自主识别序列中的关键token。

不同于依赖启发式规则的方案,VSA可在训练过程中直接替代FlashAttention,通过数据驱动的方式学习最优稀疏模式,同时最大限度保持生成质量。

在步骤蒸馏过程中,当学生模型学习用更少步骤去噪时,VSA无需依赖多步去噪的冗余性来修剪注意力图,而是能动态适应新的稀疏模式。

这使得VSA成为,首个完全兼容蒸馏训练的稀疏注意力机制。甚至,他们甚至实现了VSA与蒸馏的同步训练!

据团队所知,这是稀疏注意力领域的重大突破。

基于视频稀疏注意力(VSA)技术,团队创新性地提出了稀疏蒸馏方法。

这是一种将稀疏注意力训练与步骤蒸馏相结合的模型后训练技术。

它的核心思想,是让一个「少步数+稀疏化」的学生模型学会匹配「完整步数+密集计算」教师模型的输出分布。

如下图所示,该技术的整体框架包含以下关键要素:

稀疏学生网络(VSA驱动,可训练)

真实评分网络(冻结,全注意力)

伪评分网络(可训练,全注意力)

这三个组件均基于Wan2.1模型初始化。

训练时,经过稀疏蒸馏的学生网络接收带噪声视频输入,通过VSA执行单步去噪生成输出。

该输出会被重新添加噪声,随后分别输入到两个全注意力评分网络——它们各自执行一次全注意力去噪。

两个分支输出的差异构成分布匹配梯度,通过反向传播优化学生网络;同时伪评分网络会根据学生输出的扩散损失进行更新。

这种架构的精妙之处在于:学生模型采用VSA保证计算效率,而两个评分网络保持全注意力,以确保训练监督的高保真度。

这种架构的精妙之处在于:这种设计实现了运行时加速(学生模型)与蒸馏质量(评分网络)的解耦,使得稀疏注意力能够与激进的步数缩减策略兼容。

更广泛地说,由于稀疏注意力仅作用于学生模型,该方案可适配各类蒸馏方法,包括一致性蒸馏、渐进式蒸馏或基于GAN的蒸馏损失等。

那么,FastWan如何实现蒸馏的呢?

高质量数据对任何训练方案都至关重要,尤其是对扩散模型而言。为此,研究人员选择使用高质量的Wan模型自主生成合成数据集。

具体而言,采用Wan2.1-T2V-14B生成60万条480P视频和25万条720P视频,通过Wan2.2-TI2V-5B生成3.2万条视频。

采用DMD进行稀疏蒸馏时,需在GPU内存中同时加载三个140亿参数大模型:

· 学生模型

· 可训练伪分数模型

· 冻结真分数模型

其中两个模型(学生模型与伪分数模型)需持续训练,既要存储优化器状态又要保留梯度,加之长序列长度的特性,使得内存效率成为关键挑战。

为此,他们提出的关键解决方案是:

1. 通过FSDP2实现三模型的参数跨GPU分片,显著降低内存开销

2. 应用激活检查点技术缓解长序列产生的高激活内存

3. 精细控制蒸馏各阶段(如更新学生模型/伪分数模型时)的梯度计算开关

4. 引入梯度累积在有限显存下提升有效批次规模

Wan2.1-T2V-1.3B的稀疏蒸馏在64张H200 GPU上运行4000步,总计消耗768 GPU小时。

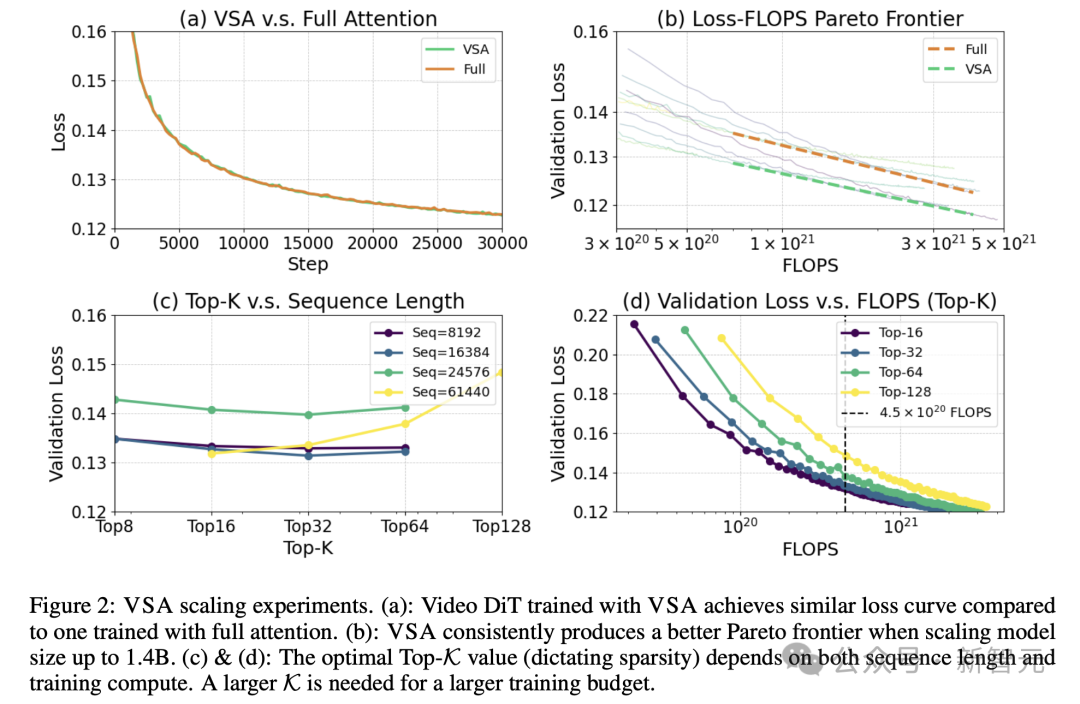

在Scaling实验中,研究团队预训练一个4.1亿参数视频DiT模型,潜在空间维度位(16, 32, 32)。

在保持87.5%稀疏度情况下,VSA取得的损失值与全注意力机制几乎一致。

同时,它将注意力计算的FLOPS降低8倍,端到端训练FLOPS减少2.53倍。

从6000万扩展到14亿参数规模,进一步证实了VSA始终能比全注意力机制实现更优的「帕累托前沿」。

为评估VSA的实际效果,团队在Wan-14B生成的视频潜空间(16×28×52)合成数据上,对Wan-1.3B进行了VSA微调。

如表2所示,采用VSA的模型在VBench评分上甚至超越了原始Wan-1.3B。

在极端稀疏条件下,与免训练的注意力稀疏方法SVG对比时,VSA尽管稀疏度更高仍表现更优,验证了稀疏注意力训练的有效性。

实际应用中,Wan-1.3B的DiT推理时间从全注意力模式的31秒降至VSA模式的18秒。

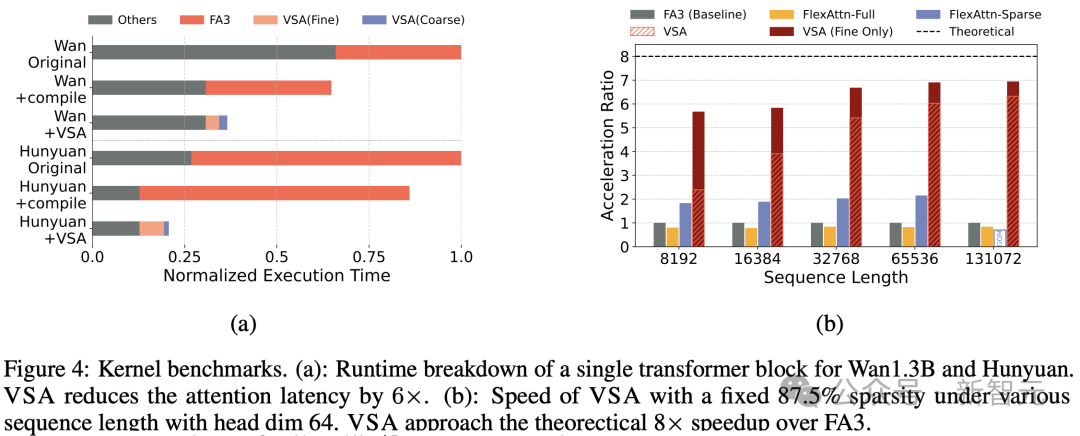

VSA精细块稀疏内核在长序列场景下,更加接近理论极限,相较于FlashAttention-3实现了近7倍加速。

即使计入粗粒度阶段计算开销,VSA仍保持6倍以上的加速优势。

相比之下,采用相同块稀疏掩码(64×64块大小)的FlexAttention仅获得2倍加速。

结果显示,将VSA应用于Wan-1.3B和Hunyuan模型时(图4a),推理速度提升达2-3倍。

下图5所示,研究团队还检测了经微调13亿参数模型,在粗粒度阶段生成的块稀疏注意力,呈现高度动态性。

最后,团队还对模型做了定性实验,下图展示了随着训练推进,模型逐渐适应稀疏注意力机制,最终恢复了生成连贯视频的能力。

这个work来自于咱们的老朋友Hao AI Lab的FastVideo研究小组。

Peiyuan Zhang(张培源)

张培源是UCSD计算机科学与工程系一年级博士生,导师为Hao Zhang教授。

他曾在南洋理工大学担任研究助理,师从Ziwei Liu。

他主要研究机器学习系统以及高效的视频模型架构,是TinyLlama, lmms-eval, LongVA以及FastVideo的作者。

Yongqi Chen

Yongqi Chen是UCSD Hao AI Lab的研究实习生,导师是Hao Zhang教授。

他曾在密歇根大学(UMich)获得机器人学硕士学位,此前于2023年以荣誉毕业生的身份毕业于浙江大学竺可桢学院,获机器人工程学士学位。

现阶段,他的研究方向聚焦高效视频生成技术,致力于实现实时交互式视频生成。

Will Lin

Will Lin是UCSD计算机科学与工程系Hao AI Lab的博士生,导师是Hao Zhang教授。

他在德克萨斯大学奥斯汀分校获得计算机科学学士学位。

目前在Anyscale实习,是开源项目vLLM的活跃贡献者。

Haofeng Huang(黄浩峰)

黄浩峰是清华姚班本科生,导师为Jianfei Chen 和 Jun Zhu教授。

目前,他主要研究方向为高效机器学习,重点关注注意力机制、量化加速,以及图像/视频压缩技术。

☟☟☟

☞人工智能产业链联盟筹备组征集公告☜

☝

精选报告推荐:

11份清华大学的DeepSeek教程,全都给你打包好了,直接领取:

【清华第四版】DeepSeek+DeepResearch让科研像聊天一样简单?

【清华第七版】文科生零基础AI编程:快速提升想象力和实操能力

【清华第十一版】2025AI赋能教育:高考志愿填报工具使用指南

10份北京大学的DeepSeek教程

【北京大学第五版】Deepseek应用场景中需要关注的十个安全问题和防范措施

【北京大学第九版】AI+Agent与Agentic+AI的原理和应用洞察与未来展望

【北京大学第十版】DeepSeek在教育和学术领域的应用场景与案例(上中下合集)

8份浙江大学的DeepSeek专题系列教程

浙江大学DeepSeek专题系列一--吴飞:DeepSeek-回望AI三大主义与加强通识教育

浙江大学DeepSeek专题系列二--陈文智:Chatting or Acting-DeepSeek的突破边界与浙大先生的未来图景

浙江大学DeepSeek专题系列三--孙凌云:DeepSeek:智能时代的全面到来和人机协作的新常态

浙江大学DeepSeek专题系列四--王则可:DeepSeek模型优势:算力、成本角度解读

浙江大学DeepSeek专题系列五--陈静远:语言解码双生花:人类经验与AI算法的镜像之旅

浙江大学DeepSeek专题系列六--吴超:走向数字社会:从Deepseek到群体智慧

浙江大学DeepSeek专题系列七--朱朝阳:DeepSeek之火,可以燎原

浙江大学DeepSeek专题系列八--陈建海:DeepSeek的本地化部署与AI通识教育之未来

4份51CTO的《DeepSeek入门宝典》

51CTO:《DeepSeek入门宝典》:第1册-技术解析篇

51CTO:《DeepSeek入门宝典》:第2册-开发实战篇

51CTO:《DeepSeek入门宝典》:第3册-行业应用篇

51CTO:《DeepSeek入门宝典》:第4册-个人使用篇

5份厦门大学的DeepSeek教程

【厦门大学第一版】DeepSeek大模型概念、技术与应用实践

【厦门大学第五版】DeepSeek等大模型工具使用手册-实战篇

10份浙江大学的DeepSeek公开课第二季专题系列教程

【精选报告】浙江大学公开课第二季:《DeepSeek技术溯源及前沿探索》(附PDF下载)

【精选报告】浙江大学公开课第二季:2025从大模型、智能体到复杂AI应用系统的构建——以产业大脑为例(附PDF下载)

【精选报告】浙江大学公开课第二季:智能金融——AI驱动的金融变革(附PDF下载)

【精选报告】浙江大学公开课第二季:人工智能重塑科学与工程研究(附PDF下载)

【精选报告】浙江大学公开课第二季:生成式人工智能赋能智慧司法及相关思考(附PDF下载)

【精选报告】浙江大学公开课第二季:AI大模型如何破局传统医疗(附PDF下载)

【精选报告】浙江大学公开课第二季:2025年大模型:从单词接龙到行业落地报告(附PDF下载)

【精选报告】浙江大学公开课第二季:2025大小模型端云协同赋能人机交互报告(附PDF下载)

【精选报告】浙江大学公开课第二季:DeepSeek时代:让AI更懂中国文化的美与善(附PDF下载)

【精选报告】浙江大学公开课第二季:智能音乐生成:理解·反馈·融合(附PDF下载)

6份浙江大学的DeepSeek公开课第三季专题系列教程

【精选报告】浙江大学公开课第三季:走进海洋人工智能的未来(附PDF下载)

【精选报告】浙江大学公开课第三季:当艺术遇见AI:科艺融合的新探索(附PDF下载)

【精选报告】浙江大学公开课第三季:AI+BME,迈向智慧医疗健康——浙大的探索与实践(附PDF下载)

【精选报告】浙江大学公开课第三季:心理学与人工智能(附PDF下载)

【AI加油站】第八部:《模式识别(第四版)-模式识别与机器学习》(附下载)

人工智能产业链联盟高端社区

一次性说清楚DeepSeek,史上最全(建议收藏)

DeepSeek一分钟做一份PPT

用DeepSeek写爆款文章?自媒体人必看指南

【5分钟解锁DeepSeek王炸攻略】顶级AI玩法,解锁办公+创作新境界!

【中国风动漫】《雾山五行》大火,却很少人知道它的前身《岁城璃心》一个拿着十米大刀的男主夭折!

免责声明:部分文章和信息来源于互联网,不代表本订阅号赞同其观点和对其真实性负责。如转载内容涉及版权等问题,请立即与小编联系(微信号:913572853),我们将迅速采取适当的措施。本订阅号原创内容,转载需授权,并注明作者和出处。如需投稿请与小助理联系(微信号:AI480908961)

编辑:Zero