最近微软发布了首个开源的“原生1bit”LLM -- BitNet b1.58 2B4T,参数规模达到20亿,训练数据高达4万亿token,从根本上重构了AI的计算引擎。它用超高效的加法运算,取代了AI模型中最昂贵的浮点乘法运算。

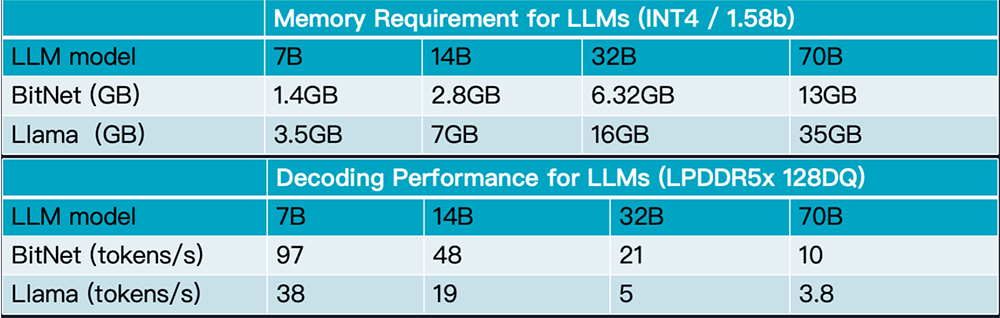

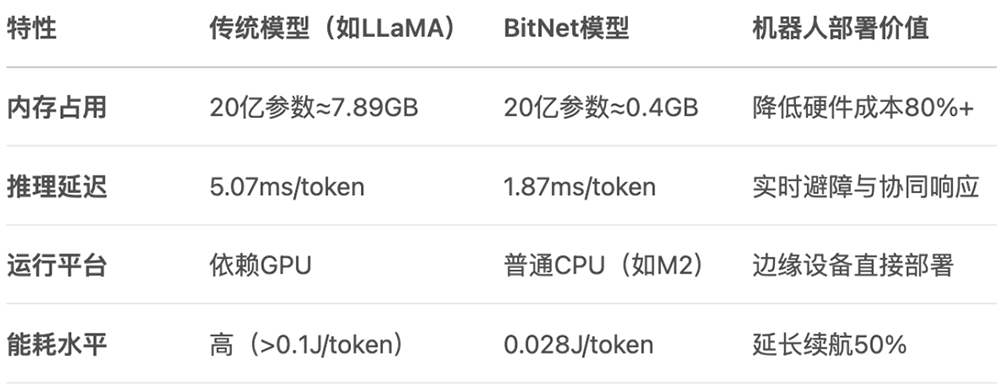

内存占用大幅降低: 由于每个权重仅需约1.58位,相比于16位浮点数,BitNet可以将模型的内存占用降低约10倍。这意味着,过去需要庞大数据中心才能运行的大型模型,未来也许可以直接在个人电脑甚至智能手机上流畅运行。

计算速度显著提升: 用加减法替代乘法,极大地简化了计算过程。这不仅意味着更快的推理速度,也使得通过边缘设备的CPU+NPU计算组合高效运行LLM成为可能,摆脱了对昂贵且稀缺的GPU芯片的依赖。

能耗大幅下降: 更简单的计算和更小的模型尺寸直接带来了能耗的显著降低。这使得在笔记本电脑、智能汽车、物联网设备等对功耗敏感的边缘设备上部署强大AI成为现实,同时也响应了全球对绿色计算和可持续发展的呼吁。

专为CPU设计:bitnet.cpp的核心优势在于它可以在没有昂贵GPU的情况下,高效地在CPU上运行。这直接契合了绝大多数电子产品(如智能手机、笔记本电脑、物联网设备)的硬件配置。

跨平台支持:该框架支持在主流的x86架构(如英特尔、AMD处理器)和Arm架构上运行。Arm架构是几乎所有智能手机和众多平板电脑、边缘设备的核心,因此bitnet.cpp的Arm优化是其在智能终端领域应用的基础。

显著的速度提升:在ARM CPU(如苹果的M系列芯片)上,使用bitnet.cpp运行BitNet模型,相比于传统的16位浮点模型(fp16),速度有1.37倍到5.07倍的提升,且模型越大,加速效果越明显。

惊人的能效:在能耗方面,bitnet.cpp在Arm CPU上的表现同样出色,能够将能耗降低55%到70%。这对于依赖电池供电的移动设备来说是至关重要的优势。

实现“不可能的任务”:测试表明,bitnet.cpp甚至可以在单个CPU上运行高达1000亿参数的BitNet模型,其速度足以达到人类的正常阅读水平(约每秒5-7个词元)。这在过去是无法想象的,它意味着未来极其强大的AI模型或许可以直接在用户的个人设备上本地运行。

打造真正的端侧AI:智能硬件厂商们(如苹果、谷歌、三星)一直致力于将更多AI功能本地化,以提升响应速度、保护用户隐私并降低对云服务的依赖。BitNet的轻量化和高效性使其成为实现这一目标的理想技术。

降低成本和功耗:在竞争激烈的消费电子市场,任何能够降低硬件成本和延长电池续航的技术都极具吸引力。BitNet无需高端GPU,并能显著降低能耗,这完美契合了厂商的需求。

催生新的智能体验:通过在设备上本地运行强大的语言模型,可以实现更智能、更无缝的交互体验,例如更自然的语音助手、离线的实时翻译、设备端的文档摘要和内容创作等。

现状: 目前的手机AI多是“伪端侧”,许多功能仍需联网调用云端API。

BitNet带来的未来:

超级个人助理: 手机可以本地运行一个真正懂你的、拥有长期记忆的AI助理,它了解你的所有习惯和信息(因为数据不出本地),能主动为你规划日程、管理信息、提供建议。 永不掉线的实时功能: 无论在飞机上还是地下室,实时翻译、文档摘要、图像处理等功能都能瞬时完成。 极致个性化: AI可以根据你的使用习惯,实时、动态地优化手机的性能、功耗和用户界面,成为独一无二的“个性化手机”。

现状: 智能汽车对网络和云端算力高度依赖,自动驾驶的决策延迟和安全性是巨大挑战。

BitNet带来的未来:

瞬时决策的自动驾驶: 复杂的环境感知和驾驶决策模型可以在车内本地完成,摆脱网络延迟,极大地提升自动驾驶的安全性与可靠性。 会思考的智能座舱: 车载语音助手不再是机械的“命令执行者”,而是能理解复杂语境、结合车辆状态和外部环境进行多轮自然对话的“智能副驾”。 隐私保护: 车辆的行驶轨迹、车内对话等敏感数据都无需上传云端,最大程度保护用户隐私。

现状: 智能家居依然停留在“手机App控制”或简单的语音指令阶段,设备间联动生硬,并不“智能”。

BitNet带来的未来:

主动服务的家电: 你的空调会根据你的睡眠状态、室外天气和你的体感习惯,主动调节到最舒适的温度;你的冰箱能根据现有食材,主动为你生成菜谱并联动烤箱设置程序。 无处不在的自然交互: 你不再需要寻找手机或智能音箱,可以直接对任何家电用自然语言下达指令,甚至通过一个眼神、一个手势与之交互。 真正的智能家庭中枢: 所有家电拥有了本地的“大脑”,它们可以协同工作,形成一个统一的、无需云端协调的智能网络,真正实现“全屋智能”。

类似BitNet的模型将会如雨后春笋一样出现,而这对于硬件的灵活性要求极高,像芯动力的RPP架构不但兼容CUDA生态,而且可快速适配和部署新的模型,及时获取生态开发者反馈并快速迭代,从而加速AI在边缘和端侧的普及。

2025全球AI芯片峰会预告