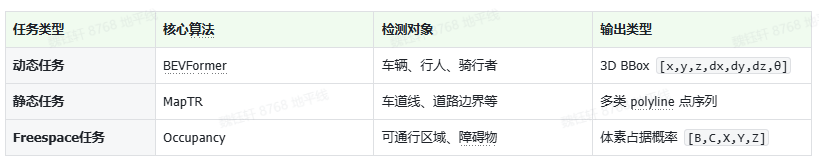

BEVFormer 是近年来领先的 3D 感知框架之一,提出了一种融合 Bird’s Eye View(BEV)视角和 Transformer 架构 的感知方式。它利用多摄像头输入构建 BEV 表征,并结合时序特征做运动物体感知。

BEV 是什么?

每个像素表示地面上一个固定区域(如 0.5m × 0.5m); BEV 具有固定分辨率和尺度,便于与规划、控制模块对接; 动态物体不会因远近发生比例变化,便于稳定检测和跟踪。

BEVFormer 架构简介

图像编码:使用 ResNet+FPN 的 backbone+neck 结构提取多视角图像特征; Lift 操作:将图像特征结合深度预测“抬升”(lift)到三维空间中; Splat 投影:将三维点投影到 BEV 平面网格,聚合形成 BEV 特征图; 时序建模:引入前几帧 BEV 特征,使用 temporal attention 模块进行时序对齐; 目标检测解码器:采用 learnable query,预测 3D 物体框及其类别。

Lift(抬升)

每个像素在原始图像中只提供 2D 信息(x, y),没有深度; 利用深度估计(或相机投影矩阵)推测该像素在 3D 空间中的位置; 所有 3D 点再“划分”为离散的三维网格(Voxel Grid),以统一尺度处理。

3D 物体框表示形式

(x, y, z):中心坐标; (dx, dy, dz):尺寸; θ:朝向角。

MapTR 是一种矢量建图方法,首次在 Transformer 框架中实现了 Polyline 格式的地图元素生成。与传统的栅格输出不同,MapTR 直接输出点序列形式的几何结构,精度更高。

Polyline 是什么?

通常每条 polyline 表示为点集 [p1, p2, …, pn],每个点为 (x, y) 或 (x, y, attr)(带语义)。

MapTR 架构简介

图像特征提取:使用 CNN + Transformer 提取多摄像头图像特征; BEV 表征生成:将图像 lift 到 3D 后,splat 投影为 BEV 特征;(前两步和动态感知任务那儿一样) 结构化 Query 解码: 每个 query 对应一条 polyline; 生成起点后,通过自回归方式生成后续点序列;

多类别建图:支持同时预测多类地图元素,如 divider(车道之间的分隔线)、boundary(道路边界)、arrow(导向箭头)、stopline(停止线) 等。

Occupancy 模型通常采用图像或点云输入,结合深度估计和 3D 重建,生成 Occupancy Grid,即空间占用网格。

什么是 Occupancy Grid?

值为 0:free 空间; 值为 1:确定被障碍物占据; 值介于两者之间:存在不确定性。

典型输出维度为 [B, C, X, Y, Z],其中 B 为 batch size,C 为类别数或 occupancy 状态数,X、Y、Z 表示 3D 空间上的 voxel 网格。

对这里的 C 再展开聊一下:

表示每个 voxel 的被占概率,即该 voxel 被物体占据的概率; 输出经过 sigmoid 激活函数,将值映射到 0,1; 值越接近 1 → 越确定被物体占据;接近 0 → 自由空间。

# 示例:输出为 [B, 1, X, Y, Z],经过 sigmoid 得到概率occupancy_logits = model(input)occupancy_probs = torch.sigmoid(occupancy_logits)

C > 1(多通道分类概率)

每个 voxel 是一个多分类问题,比如:

通道 0:free 通道 1:occupied 通道 2:unknown 或 uncertain 输出经过 softmax,每个 voxel 的 3 个类别概率和为 1:

# 示例:输出为 [B, 3, X, Y, Z],对 C=3 维度做 softmaxoccupancy_logits = model(input)occupancy_probs = torch.softmax(occupancy_logits, dim=1)# occupied 概率提取occupied_prob = occupancy_probs[:, 1, ...]

也可以引入语义标签,将空间分为:

drivable(可通行区域); static obstacle(建筑物、护栏); dynamic obstacle(行人、车); unknown(不确定区域)。

【免责声明】转载出于非商业性的教育和科研目的,只为学术新闻信息的传播,版权归原作者所有,如有侵权请立即与我们联系,我们将及时删除。

☟☟☟

☞人工智能产业链联盟筹备组征集公告☜

☝

精选报告推荐:

11份清华大学的DeepSeek教程,全都给你打包好了,直接领取:

【清华第四版】DeepSeek+DeepResearch让科研像聊天一样简单?

【清华第七版】文科生零基础AI编程:快速提升想象力和实操能力

【清华第十一版】2025AI赋能教育:高考志愿填报工具使用指南

10份北京大学的DeepSeek教程

【北京大学第五版】Deepseek应用场景中需要关注的十个安全问题和防范措施

【北京大学第九版】AI+Agent与Agentic+AI的原理和应用洞察与未来展望

【北京大学第十版】DeepSeek在教育和学术领域的应用场景与案例(上中下合集)

8份浙江大学的DeepSeek专题系列教程

浙江大学DeepSeek专题系列一--吴飞:DeepSeek-回望AI三大主义与加强通识教育

浙江大学DeepSeek专题系列二--陈文智:Chatting or Acting-DeepSeek的突破边界与浙大先生的未来图景

浙江大学DeepSeek专题系列三--孙凌云:DeepSeek:智能时代的全面到来和人机协作的新常态

浙江大学DeepSeek专题系列四--王则可:DeepSeek模型优势:算力、成本角度解读

浙江大学DeepSeek专题系列五--陈静远:语言解码双生花:人类经验与AI算法的镜像之旅

浙江大学DeepSeek专题系列六--吴超:走向数字社会:从Deepseek到群体智慧

浙江大学DeepSeek专题系列七--朱朝阳:DeepSeek之火,可以燎原

浙江大学DeepSeek专题系列八--陈建海:DeepSeek的本地化部署与AI通识教育之未来

4份51CTO的《DeepSeek入门宝典》

51CTO:《DeepSeek入门宝典》:第1册-技术解析篇

51CTO:《DeepSeek入门宝典》:第2册-开发实战篇

51CTO:《DeepSeek入门宝典》:第3册-行业应用篇

51CTO:《DeepSeek入门宝典》:第4册-个人使用篇

5份厦门大学的DeepSeek教程

【厦门大学第一版】DeepSeek大模型概念、技术与应用实践

【厦门大学第五版】DeepSeek等大模型工具使用手册-实战篇

10份浙江大学的DeepSeek公开课第二季专题系列教程

【精选报告】浙江大学公开课第二季:《DeepSeek技术溯源及前沿探索》(附PDF下载)

【精选报告】浙江大学公开课第二季:2025从大模型、智能体到复杂AI应用系统的构建——以产业大脑为例(附PDF下载)

【精选报告】浙江大学公开课第二季:智能金融——AI驱动的金融变革(附PDF下载)

【精选报告】浙江大学公开课第二季:人工智能重塑科学与工程研究(附PDF下载)

【精选报告】浙江大学公开课第二季:生成式人工智能赋能智慧司法及相关思考(附PDF下载)

【精选报告】浙江大学公开课第二季:AI大模型如何破局传统医疗(附PDF下载)

【精选报告】浙江大学公开课第二季:2025年大模型:从单词接龙到行业落地报告(附PDF下载)

【精选报告】浙江大学公开课第二季:2025大小模型端云协同赋能人机交互报告(附PDF下载)

【精选报告】浙江大学公开课第二季:DeepSeek时代:让AI更懂中国文化的美与善(附PDF下载)

【精选报告】浙江大学公开课第二季:智能音乐生成:理解·反馈·融合(附PDF下载)

6份浙江大学的DeepSeek公开课第三季专题系列教程

【精选报告】浙江大学公开课第三季:走进海洋人工智能的未来(附PDF下载)

【精选报告】浙江大学公开课第三季:当艺术遇见AI:科艺融合的新探索(附PDF下载)

【精选报告】浙江大学公开课第三季:AI+BME,迈向智慧医疗健康——浙大的探索与实践(附PDF下载)

【精选报告】浙江大学公开课第三季:心理学与人工智能(附PDF下载)

【AI加油站】第八部:《模式识别(第四版)-模式识别与机器学习》(附下载)

人工智能产业链联盟高端社区

一次性说清楚DeepSeek,史上最全(建议收藏)

DeepSeek一分钟做一份PPT

用DeepSeek写爆款文章?自媒体人必看指南

【5分钟解锁DeepSeek王炸攻略】顶级AI玩法,解锁办公+创作新境界!

【中国风动漫】《雾山五行》大火,却很少人知道它的前身《岁城璃心》一个拿着十米大刀的男主夭折!

免责声明:部分文章和信息来源于互联网,不代表本订阅号赞同其观点和对其真实性负责。如转载内容涉及版权等问题,请立即与小编联系(微信号:913572853),我们将迅速采取适当的措施。本订阅号原创内容,转载需授权,并注明作者和出处。如需投稿请与小助理联系(微信号:AI480908961)

编辑:Zero