点击下方卡片,关注“具身智能之心”公众号

作者丨Huang Fang等

编辑丨具身智能之心

本文只做学术分享,如有侵权,联系删文

更多干货,欢迎加入国内首个具身智能全栈学习社区:具身智能之心知识星球(戳我),这里包含所有你想要的。

当机器人在餐桌前接到“打包高热量食物并拿一杯饮品”的指令,却在拿起可乐时突然得知用户对咖啡因过敏 —— 它能否及时停下动作,换一杯无咖啡因饮品?当整理桌面时遇到“扔掉所有垃圾”的模糊要求,它能否主动确认“未明确的鸡腿是否需要丢弃”?这些真实场景中的灵活应对,正是当前通用机器人迈向“人性化助手”的关键瓶颈。

在开放动态的日常环境中,机器人不仅需要精准执行操作,更需具备 “看懂” 物理世界(如判断物体空间位置、动作可行性)和 “听懂” 人类需求(如处理临时中断、澄清模糊指令)的双重能力。但现有分层机器人系统的高层认知模块往往难以兼顾:要么依赖视觉 - 语言模型仅完成任务分解,缺乏将数字概念落地到物理操作的具身推理能力;要么采用手工设计的模块化框架,面对未预设的动态场景时容易 “卡壳”,难以实现自然交互。

为破解这一难题,字节跳动提出了统一视觉 - 语言模型 Robix。作为分层机器人系统的 “高层认知中枢”,Robix 以端到端架构打破能力割裂:它能通过 3D 空间理解、视觉定位等能力扎根物理世界,精准规划长时任务;还能通过实时中断处理、主动对话等功能适配人类需求,让机器人在餐桌清理、购物、饮食筛选等场景中,真正实现 “能推理、会规划、懂交互” 的类人协作,为通用具身智能的落地提供了新方向。

论文题目:Robix: A Unified Model for Robot Interaction, Reasoning and Planning

论文链接:https://arxiv.org/pdf/2509.01106

项目链接:https://robix-seed.github.io/robix/

论文时间:Sep 3, 2025

作者单位:字节跳动

针对问题

现有分层机器人系统的能力割裂问题:现有分层机器人系统中,高层认知层多依赖大语言模型(LLMs)或视觉 - 语言模型(VLMs)仅实现任务分解,忽略人类-机器人交互与具身推理能力,导致机器人难以应对开放动态的日常场景。

模块化交互与规划框架的刚性缺陷:部分方案虽通过手工设计的模块化流水线整合推理、规划与交互,但存在灵活性差、鲁棒性弱的局限,机器人无法实时适配环境变化。

通用 VLMs 向物理机器人场景迁移的挑战:通用 VLMs 在数字领域表现优异,但迁移到物理机器人场景时面临两大障碍:一是具身推理能力不足,无法有效整合 3D 空间理解、视觉定位等物理世界感知信号进行规划;二是灵活多模态交互缺失,既受限于交互场景的复杂性,也因缺乏对应训练数据,难以处理实时中断、主动对话等动态交互需求。

主要贡献

提出统一的高层认知模型 Robix:设计单视觉-语言模型架构,首次在端到端框架内统一机器人推理、长时任务规划与自然语言交互能力。

提出三阶训练策略,攻克具身推理与交互难题:针对机器人场景的特殊需求,设计 “持续预训练 - 有监督微调 - 强化学习” 三阶训练 pipeline,系统性提升模型能力。

全面实验验证,证明模型性能优势:通过多维度实验(基础推理、离线规划、在线真实场景),验证 Robix 在开源商业基线(如 GPT-4o、Gemini 2.5 Pro)中的显著优势。

构建多类型基准与数据集,助力领域研究:构建了Agibot-ER 基准;合成了多样化交互训练数据。

核心架构与工作机制

分层系统角色

Robix 处于分层机器人系统的高层认知层,负责处理多模态推理、自适应任务规划与人类 - 机器人交互;低层控制器(通常是视觉 - 语言 - 动作模型 VLA)执行 Robix 生成的原子动作指令,实现与物理环境的直接交互,形成 “感知 - 推理 - 动作 - 反馈” 的迭代循环。

Robix 起到高级认知层的作用,它对多模态输入进行解读和推理,以生成语言回应和行动计划。低级控制器层执行相应的原子指令,从而实现与人类以及物理环境的交互。

关键输入与输出

输入:机器人摄像头捕捉的视觉观测、用户指令(含实时中断、模糊指令等)、历史交互记录(保留最新 N 个视觉观测以平衡内存与推理效率,历史思考和动作存储于短期记忆)。 输出: 原子动作指令:供低层控制器执行,如 “将橙汁放入塑料盒”; 自然语言回复:响应人类交互,如主动询问 “绿色盘子上的鸡腿需要扔掉吗?”; 结构化思考轨迹:指导决策,如分析 “用户对咖啡因过敏,需替换含咖啡因饮品”。

展示了(1)复杂的指令理解以及基于常识的推理能力;(2)实时中断处理;(3)任务状态监测与动态重新规划;以及(4)主动对话以澄清模糊指令或推断用户意图。

三阶训练策略

Robix 基于 Qwen2.5-VL 模型,通过2000 亿 tokens 的三阶训练实现能力提升,各阶段目标与数据设计明确:

持续预训练:强化基础具身推理

聚焦机器人核心感知与推理能力,构建多类型数据集:

3D 空间理解(400 亿 tokens):覆盖多视图对应、3D 边界框检测、相对 / 绝对深度估计等任务,数据源自 ScanNet、ARKitScenes 等公开数据集,提升机器人导航与操作规划的空间感知; 视觉定位(700 亿 tokens):含 2D 边界框标注、点标注、计数等任务,统一坐标归一化([0,1000]),强化 “语言指令 - 图像定位” 双向映射能力; 任务中心推理(100 亿 tokens):基于 AgiBot、Ego4D 等数据集,针对任务状态验证(如 “是否完成餐具收纳”)、动作可行性评估、下一步动作预测生成思考轨迹,提升动态环境中的决策能力; 通用多模态推理与理解( 900 亿 tokens):涵盖 STEM 问题解决、GUI 代理决策、VQA、图像描述等,保留模型通用能力。

这些数据经过精心筛选,旨在强化核心的具身推理能力(三维空间理解、视觉基础以及任务导向型推理),同时也能支持通用的多模态理解和推理。该图展示了数据的多样性,为具身模型奠定了坚实的基础。

有监督微调:赋予复杂交互能力

监督微调阶段的目标是将经过持续预训练的模型适配为机器人的高层认知模块,同时保留模型原有的能力。通过设计一套数据合成流程,将现有的任务规划数据集转化为人机交互轨迹。最终生成的监督微调数据需具备两个对分布外泛化至关重要的特性:(1)多样化的人机交互场景;(2)高质量的推理轨迹。

交互生成

交互合成主要基于两类数据源构建:遥操作机器人演示数据和仿真与生成式 AI 数据。通过数据合成解决 “人机交互 + 长时任务规划” 数据稀缺问题,设计 7 类交互指令与对应的推理轨迹:

多阶段指令:如 “清理桌面并打包食物”,基于遥操作轨迹生成; 约束指令:如 “清理桌面时保留食物”,拆分任务片段合成; 开放式指令:如 “将含糖量最低的饮品放入盒中”,结合仿真场景与文本 - 图像生成(经筛选保留 10% 高质量数据); 实时中断处理:随机注入 “停下,我还需要这个” 等中断指令,训练机器人暂停 / 调整计划; 无效指令处理:生成 “将桌子扔进垃圾桶” 等不可能 / 危险指令,训练机器人拒绝策略; 模糊指令澄清:如 “放一个水果进篮子”,训练主动询问以明确目标; 对话交互:插入 “桌上有什么水果” 等闲聊指令,区分 “语言回复” 与 “物理动作”。

推理合成

为融入链式推理,提示最先进的视觉 - 语言模型生成高质量推理轨迹,重点涵盖四个维度:(1)场景理解;(2)任务状态反思;(3)长时指令遵循;(4)下一步动作分析。

场景理解:该模块使机器人能准确识别当前场景中与任务相关、可操作的物体,尤其聚焦机器人视野范围内的物品。 任务状态反思:机器人需具备反思过往动作的能力(如首次尝试失败时重新执行),同时能识别长时任务中的关键里程碑,并在遭遇无法恢复的错误时主动请求人类协助。 长时指令遵循:该模块帮助机器人在长时任务中持续记忆初始目标与中途接收的用户指令,确保核心任务完成,且中途指令能在多步操作后仍指导动作(例如,遵循指令 “清理完桌面后,从冰箱拿一杯饮品”)。 下一步动作分析:当整体任务未完成时,机器人需分析下一步可能的动作,包括评估目标可达性、判断动作是否推动任务进展。

最左边的面板展示了数据来源;中间部分展示了如何从这些来源中综合出多样化的人机交互情况;最右边的面板则展示了生成的推理轨迹的示例截图。

强化学习:提升推理 - 动作一致性

采用Group Relative Policy Optimization(GRPO) ,解决 SFT 模型 “推理不合理”“思考 - 动作脱节” 问题:

协同训练:结合机器人交互数据与通用视觉推理数据(如任务完成验证、物体定位),减少推理偏差; 奖励设计:引入 “思考 - 动作一致性奖励”,通过 Qwen-2.5-32B 评估动作与思考的逻辑匹配度,不一致则扣分; 数据筛选:保留奖励方差高于阈值的样本,确保训练样本的梯度有效性。

实验性能:全面超越基线

Robix(7B/32B)在基础具身推理、离线任务规划、在线真实场景三类实验中均表现优异,核心结果如下:

基础具身推理

3D 空间理解:Robix-32B 在 VSIBench、EmbSpatial等任务上超越商业基线; 视觉定位:Robix-32B 在 LVIS-MG、Refcoco val等任务中大幅领先开源模型; 任务中心推理:在 Agibot-ER、OpenEQA-scannet等任务中展现更强的机器人任务理解能力。

左侧展示的是 Robix 以及最先进的开源基准模型,而右侧则呈现的是闭源的大规模商业模型。每个基准测试中的最高分在每组中均以粗体突出显示。

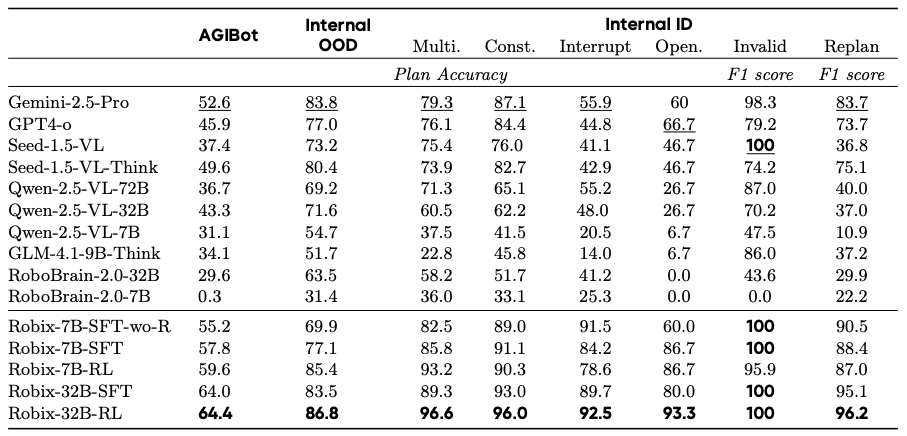

离线任务规划

覆盖分布内(ID)与分布外(OOD)场景,Robix-32B-RL 在所有评估集排名第一:

OOD 任务:在 AGIBot(如 “制作三明治”“整理鲜花”)和内部 OOD 基准(如餐桌整理、饮食筛选)上,准确率超 Gemini-2.5-Pro 3.0-11.8 个百分点; ID 任务:在多阶段、中断处理、开放式指令等类别中,准确率超开源模型(如 Qwen2.5-VL-32B)28.1-64.6 个百分点; 关键结论:链式思考使 OOD 准确率提升 7 个百分点以上,RL 使 OOD 准确率再提升 3.3-8.3 个百分点。

Robix-7B-SFT-wo-R 指的是我们未包含有思路推理环节的 SFT 模型,而 Robix-7B-RL 则表示通过在 SFT 基础上应用 RL 而获得的完整训练策略。每个评估集的最佳结果以粗体显示,而基线中的最佳结果则以波浪线标出。

在线真实场景

在 “餐桌清理、购物、饮食筛选” 等 5 类真实任务中,结合 “人类遥操作” 或 “自动 VLA 控制器(GR-3)” 评估:

人类遥操作:Robix-32B 平均任务进度 92.6%,略高于 Gemini-2.5-Pro(91%),且响应延迟更低(Gemini 常超 30 秒);

自动 VLA 控制器:Robix-32B 平均任务进度 92.5%,超 Gemini-2.5-Pro 4.3 个百分点、GPT-4o 28.1 个百分点,主要因 Robix 生成的动作更适配 VLA 控制器(如 “放奥利奥进篮子” 而非 “放饼干盒进篮子”)。

核心优势与局限

优势

统一性:单模型整合推理、规划、交互,避免模块化框架的刚性与脆弱性; 灵活性:支持主动对话、实时中断、动态重规划,适配开放动态环境; 泛化性:在 OOD 任务与真实场景中持续超越开源与商业基线(GPT-4o、Gemini-2.5-Pro)。

局限

动态场景鲁棒性:高频场景切换时可能出现推理漏洞或物理常识偏差; 记忆机制:依赖短期记忆窗口,难以支持长时(如数小时)交互,需更高效的长时记忆设计。

总结与未来方向

Robix 凭借 “统一模型架构 + 三阶训练” 的创新模式,在业界首次达成机器人 “推理 - 规划 - 交互” 的端到端整合,为通用具身智能的发展提供了全新范式。

在技术实现上,其统一模型架构打破了传统机器人系统中推理、规划、交互模块相互割裂的局面,让机器人能以更连贯的方式理解和执行任务。而三阶训练,从持续预训练夯实基础,到监督微调适配机器人高层认知需求,再到通过特定数据合成流程打造出涵盖多样化人机交互场景与高质量推理轨迹的训练数据,每一个阶段都为模型能力的提升筑牢根基。

展望未来,Robix 团队将把重点放在解决动态场景鲁棒性与长时记忆问题上。在动态场景鲁棒性方面,要让机器人在家庭、零售等真实场景中,面对人员流动、物品摆放变化等复杂情况时,依然能稳定、准确地执行任务;在长时记忆领域,需助力机器人更好地记住长时任务的目标、中途的指令以及过往的操作,从而更出色地完成如长时间家庭清洁、零售店铺货物整理等长周期任务,进一步推动机器人在家庭、零售等真实场景的广泛落地与深度应用。