点击下方卡片,关注“具身智能之心”公众号

作者丨Hongyin Zhang等

编辑丨具身智能之心

本文只做学术分享,如有侵权,联系删文

更多干货,欢迎加入国内首个具身智能全栈学习社区:具身智能之心知识星球(戳我),这里包含所有你想要的。

如今,基于流匹配的视觉-语言-动作(VLA)模型已经能帮机器人完成不少操控任务了,像这类模型,凭借轨迹级建模能力在常规场景里表现还不错,就连 RT-1、PaLM-E 这些大规模预训练模型,也证明了从多模态数据里学通用策略是可行的。

可一碰到复杂的下游任务,比如要在动态干扰下精准抓东西,这些模型就有点 “力不从心” 了——动作精度掉得厉害。说到底,问题出在它们 “学东西的方式” 上:现在的 VLA 流模型全靠模仿学习做后训练,就像只会照搬别人动作,没法分清哪些训练数据质量更好、哪些策略更适合当前任务。而强化学习(RL)本来就擅长挖掘这些数据质量特性,可之前的离线 RL 方法,比如 ReinboT,在 VLA 流模型上效果并不好,因为这类模型是靠向量场建模整个动作轨迹的,ReinboT 只能间接指导动作生成,效率太低。

那怎么让 VLA 流模型既保留流匹配的轨迹建模优势,又能用好强化学习的能力呢?西湖大学团队提出的 “自适应强化流匹配(ARFM)” 方法就是来解决这个问题的。它通过在模型损失函数里加一个能自动调整的 “缩放因子”,一边让强化学习的优势信号充分发挥作用,重点关注高质量数据,一边控制梯度方差避免训练崩溃,让模型微调又稳又高效。后续的大量实验也证明,ARFM 在泛化、抗干扰、少样本学习这些方面都有明显提升,为机器人应对复杂任务提供了新思路。

论文题目:Balancing Signal and Variance: Adaptive Offline RL Post-Training for VLA Flow Models

论文链接:https://arxiv.org/pdf/2509.04063

作者单位:西湖大学;加利福尼亚大学洛杉矶分校;西安交通大学

研究背景与问题

VLA 模型现状:基于流匹配的 VLA 模型(如)在通用机器人操控任务表现出色,且大规模预训练系统(如 RT-1、RT-2、PaLM-E 等)已验证从多模态数据学习通用策略的可行性,但这类模型依赖模仿学习后训练范式,难以深入理解数据质量分布特性,在复杂下游任务中动作精度欠佳。

现有解决方案局限:部分研究尝试用离线 RL(如 ReinboT、RWR)微调 VLA 模型,其中 ReinboT 引入 RL 未来回报指导微调,但在 VLA 流模型中性能有限 —— 因 VLA 流模型通过向量场建模整个动作轨迹分布,推理阶段最大化未来回报仅能间接、低效地指导动作预测,如何有效对 VLA 流模型进行离线 RL 微调仍待探索。

主要贡献

方法创新:提出自适应强化流匹配(ARFM)这一新型离线强化学习(RL)后训练方法,专门用于视觉 - 语言 - 动作(VLA)流模型,可通过自适应调整数据质量分布,解决现有 VLA 流模型依赖模仿学习后训练、难以挖掘数据质量特性的问题,填补了 VLA 流模型高效离线 RL 微调的技术空白。

理论构建:从理论上确立自适应调整缩放因子的优化目标,通过引入该缩放因子构建具有严谨依据的偏差 - 方差权衡目标函数,同时推导得出实时更新缩放因子的二分迭代算法,实现对 RL 信号强度与流损失梯度方差的精准控制,为 VLA 流模型高效微调提供坚实理论支撑。

实验验证:在 LIBERO 仿真基准(含 Object、Long、Spatial、Goal 四大任务套件)与 UR5 真实机械臂平台开展大量实验,验证 ARFM 在泛化能力、动态扰动鲁棒性、少样本学习及持续学习方面均展现出当前最优性能,且超参数敏感性低、工程落地成本低,充分证明其在实际机器人操控场景中的应用价值。

核心算法设计

文章所提出的ARFM作为面向 VLA 流模型的自适应离线 RL 后训练方法,核心围绕 “构建能量加权损失以融合 RL 信号” 与 “设计自适应机制以平衡训练稳定性” 展开,通过理论推导与算法实现,解决传统模仿学习及现有离线 RL 微调在 VLA 流模型中的局限,具体设计可拆解为三部分:能量加权 VLA 流模型构建、缩放因子的自适应优化、完整微调算法流程,各环节紧密衔接且具备理论支撑。

能量加权 VLA 流模型:融合 RL 信号的核心载体

该模块旨在将 RL 优势信号嵌入 VLA 流模型的训练目标,通过能量引导分布重塑动作轨迹的学习偏好,让模型更关注高质量(高 RL 优势)的数据样本,同时沿用流匹配模型对轨迹建模的优势,具体包含分布定义、损失函数设计与实际计算优化三方面。

能量引导的动作分布定义

以原始 VLA 流模型的动作分布为基础(其中 ,对应未来连续动作序列;为多模态观测,包含n幅 RGB 图像、语言指令 token 序列、机器人关节角度),引入 RL 未来回报优势(通过 “留一法” 标准化得到,无偏且低方差),构建能量引导的目标分布: 。其中为缩放因子,是控制 RL 信号强度的核心参数 。具体来讲,项通过能量函数形式,对高(即 RL 优势更强)的动作样本赋予更高权重,使模型在训练中更倾向于学习这类高质量动作的轨迹分布。

条件能量加权流匹配(CEFM)损失设计

为学习上述能量引导分布的向量场(VLA 流模型的核心是通过向量场建模轨迹生成过程),基于能量加权流匹配(EWFM)理论,推导得到条件能量加权流匹配(CEFM)损失,具体形式为:

损失构成解析:

:能量权重项,用于将 RL 优势信号融入损失,计算式为,通过对做归一化,避免因样本间差异过大导致权重失衡,且分母为批次内所有样本的能量均值,保证权重在合理范围。 :模型预测的向量场,为 VLA 流模型(如)的可学习参数,输入为 “带噪声动作”与观测。 :真实去噪向量场,是流匹配模型的核心监督信号,由动作样本与噪声计算得到,具体形式为(为高斯噪声)。 :带噪声动作,生成方式为(为随机时间步,为标准高斯噪声),模拟流匹配模型 “从噪声中逐步恢复真实动作轨迹” 的学习过程,确保模型能学习到轨迹的全局分布特性。

实际训练中的损失近似计算

理论上的 CEFM 损失需计算全局期望,但实际训练中难以直接求解,因此采用批次采样近似策略,将损失转化为可高效计算的批次加权损失,具体形式为:

关键调整:

批次采样:每步训练采样B个数据对(B为批次大小),用批次内样本替代全局样本计算损失。 权重简化:,即批次内归一化的能量权重,替代理论中的全局期望,降低计算复杂度。 标准化处理:对按 VLA 多任务场景的 “任务类型” 进行标准化,确保不同任务(如抓取、放置)的具有可比性,避免因任务间回报尺度差异导致权重偏向某类任务。

缩放因子的自适应优化:平衡信号与稳定性的关键

缩放因子直接决定 RL 信号的影响力与训练稳定性 。过小则 RL 优势信号无法有效体现,微调效果接近传统流匹配;过大则高能量样本权重过高,导致损失梯度方差激增,引发梯度爆炸或训练崩溃。为此,ARFM 通过理论构建优化目标与高效求解算法,实现的实时自适应调整。

的优化目标函数构建

核心思路是 “最小化梯度方差以保证训练稳定” 与 “最大化 RL 优势信号以提升模型性能” 的权衡,基于此构建目标函数: 。

目标函数各部分解析:

:损失梯度的方差,,代表训练过程的稳定性。方差越小,梯度更新越平稳,避免训练崩溃。 :RL 优势得分函数,计算式为(其中),代表 RL 信号的有效利用程度 。越大,模型对高 RL 优势样本的关注程度越高,越能利用 RL 信号提升性能。 :超参数,用于调整 “梯度方差控制” 与 “RL 信号保留” 的相对比重,默认取值为,实验验证对 ARFM 性能影响较小,因方法自身具备自适应平衡能力。

基于高斯假设的目标函数简化与求解

为使可求解,引入三个温和且合理的假设(基于 VLA 流模型后训练的特性):

假设 1:标准化后的 RL 优势信号服从高斯分布(为的方差)——因经过标准化处理,分布接近正态。 假设 2:条件流匹配(CFM)损失服从高斯分布(为损失均值,为损失方差)——后训练阶段 CFM 损失快速收敛到低方差状态,分布近似正态。 假设 3:当批次大小B足够大时,可用批次样本的期望、方差近似全局的、、——工程上(参考附录表 7)即可满足近似精度。

基于上述假设,通过理论推导得到两个关键推论,实现的简化与(最优)的求解:

推论 1(简化):将与用高斯分布的参数表示,简化为: 该式消除了原目标函数中的期望与求和项,仅含与可通过批次样本计算的、,为数值求解奠定基础。 推论 2(求解方程):对求导并令导数为 0(最小化),推导得到关于的非线性方程,通过变量替换,转化为: 其中为替换后的变量,可由与计算得到。

二分迭代算法:高效求解

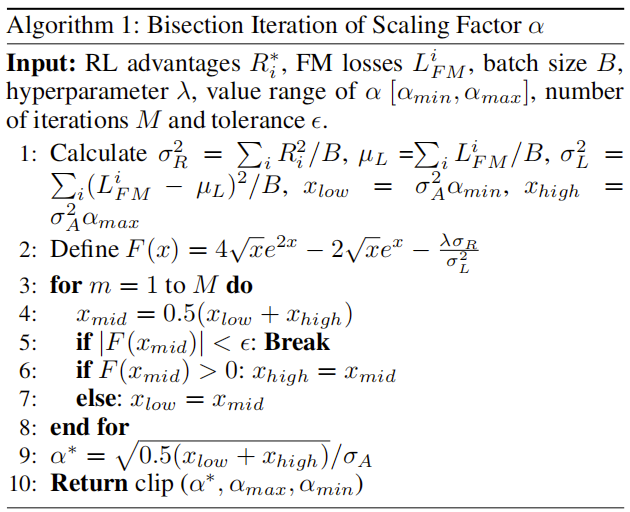

针对推论 2 中的非线性方程,设计二分迭代算法(算法 1)实时求解,确保每批次训练都能获得适配当前数据分布的最优,算法核心步骤如下:

参数初始化:输入批次内的 RL 优势、流匹配损失、批次大小B、超参数、的取值范围(默认)、迭代次数M(默认 20)与容差(默认),计算(的方差)、(的均值)、(的方差)。 函数定义:定义非线性方程对应的函数,求解的根。 二分迭代:

初始化搜索区间(由、与计算得到)。 迭代M次:每次取区间中点,若(满足精度要求)则终止;若则缩小上界,否则缩小下界。

ARFM 完整微调算法:串联各模块的工程实现

为将上述理论模块落地,设计 ARFM 后训练算法(算法 2),实现 VLA 流模型的端到端离线 RL 微调,具体流程如下:

数据输入:输入后训练数据集(含动作块与多模态观测)、批次大小B、预训练的 VLA 流模型(如)。 批次循环:对每一批次数据(到B)执行以下操作:

噪声与时间步采样:为每个样本采样高斯噪声与随机时间步。 带噪声动作生成:计算。 RL 优势与能量计算:计算每个样本的 RL 优势,并预处理得到。 流匹配损失计算:计算基础流匹配损失。

该算法通过 “批次内自适应调整”,确保模型在不同数据分布下均能平衡 RL 信号与训练稳定性,且与现有 VLA 流模型(如)兼容,无需修改模型骨干结构,工程落地成本低。

实验基础设置

实验环境与任务设计

仿真环境:采用 LIBERO 基准测试平台,该平台为综合型终身学习机器人基准,通过语言引导指令定义任务,涵盖 4 个核心套件(各含 10 个独立任务),分别针对不同操控能力评估: Object 套件:聚焦物体属性相关操控(如抓取特定形状 / 颜色物体); Long 套件:侧重长序列动作操控(如多步物体传递); Spatial 套件:考察空间位置相关任务(如按指定坐标放置物体); Goal 套件:以目标导向任务为主(如将物体堆叠至指定高度)。 真实世界环境:使用 UR5 机械臂搭建实验平台,设计 3 类抓取 - 放置任务(操控立方体、玉米、辣椒等物体),并对目标物体引入外部物理扰动(如轻微碰撞、位置偏移),模拟真实场景中的不确定性。 数据与奖励配置:真实世界实验收集约 720 条成功轨迹(含 34600 余帧数据),涵盖第一 / 第三人称 RGB 图像(480×640×3 维度)、机器人关节角度(7 维度)及期望关节角度(7 维度);奖励函数采用 13 项密集奖励组件(含子目标达成、任务进度、行为平滑度、任务完成等,具体权重见附录表 8),参考 ReinboT(Zhang 等人,2025)的奖励设计原则,兼顾任务目标与动作稳定性。

基准方法选择与设置

为全面验证 ARFM 性能,将基准方法分为非流匹配型与流匹配型两类,且为保证公平性,基于模型复现流匹配型基准的适配版本:

非流匹配型基准: 自回归模型:Octo、OpenVLA,均为通用 VLA 模型; 扩散类模型:Diffusion Policy、MDT、Dita,通过扩散过程建模动作生成; 离散技能模型:QueST,用 VQ-VAE 将连续动作离散为技能码本后自回归预测。 流匹配型基准: 基础流模型:,基于轨迹级流匹配的 VLA 模型,为 ARFM 的基础对比模型; 离线 RL 微调方法:ReinboT(引入 RL 未来回报指导微调)、RWR(通过奖励加权回归优化模型),二者均基于复现流模型版本。

关键实验参数

训练配置:LIBERO 仿真中执行 40000 步全参数微调,UR5 真实实验中执行 60000 步微调,均使用 2 块 NVIDIA A100-SXM4-80GB GPU,CPU 为 Intel (R) Xeon (R) Platinum 8358(2.60GHz); 超参数:批次大小为 16,动作时域长度,优化器采用 AdamW(学习率,权重衰减),学习率调度器为带预热的余弦衰减(预热步数 1000,衰减步数 30000),ARFM 专属超参数、取值范围、二分迭代次数(具体见附录表 7); 评估指标:以成功率(SR) 为核心性能指标,抗扰动实验中添加 0.1-0.3 级高斯动作噪声,持续学习中采用负向后迁移(NBT) 衡量遗忘程度(,为单任务学习后成功率,为全任务学习后成功率,NBT 越小表示遗忘越少)。

核心实验结果与分析

多任务学习:验证泛化能力

实验目的:对比 ARFM 与基准方法在 LIBERO 四套件多任务场景下的整体性能,结果如下表所示:

核心结论 1:流匹配型模型(、ReinboT、RWR、ARFM)整体成功率显著高于非流匹配型,其中流匹配型平均成功率最低为的 88.1%,非流匹配型最高为 QueST 的 82.7%,证明流匹配模型的轨迹建模能力更适配 VLA 多任务操控; 核心结论 2:ARFM 在流匹配型中表现最优,多任务平均成功率达 92.1%,较基础模型提升 4.5%,高于 ReinboT(91.2%,+3.5%)与 RWR(90.8%,+3.1%),验证 ARFM 的自适应能量加权机制能更高效利用 RL 信号,提升模型泛化性。

动作扰动实验:验证鲁棒性

实验目的:评估模型在动作噪声干扰下的稳定性,对模型推理阶段的动作添加 0.1-0.3 级高斯噪声,结果如下表所示:

核心数据:ARFM 平均成功率为 48.2%,显著高于(43.3%,+11.4%)、ReinboT(46.3%,+1.9%)与 RWR(46.4%,+1.8%); 关键分析:ARFM 通过动态调整平衡 RL 信号与梯度方差,避免高噪声样本导致的梯度异常,使模型学习到更稳健的动作轨迹分布,因此在噪声干扰下仍能保持较高成功率。

少样本学习实验:验证数据利用效率

实验目的:在 LIBERO-Long 套件中设置 10-shot、20-shot、30-shot(每任务仅 10/20/30 条轨迹数据)场景,评估模型在数据稀缺时的学习能力,结果如下表所示:

核心数据:ARFM 在三种少样本设置下平均成功率为 36.5%,较(32.5%,+12.2%)、ReinboT(33.9%,+2.6%)、RWR(34.6%,+1.9%)均有提升; 关键分析:ARFM 的自适应能优先聚焦高 RL 优势的稀缺样本,避免数据不足时的噪声干扰,提升数据利用效率,因此在少样本场景下表现更优。

持续学习实验:验证抗遗忘能力

实验目的:评估模型在 “Long→Long+Goal→Long+Goal+Object” 的序列任务学习中,对旧任务的遗忘程度与新任务的学习能力,结果下表 所示:

核心数据:ARFM 最终平均成功率 61.0%,较(55.2%)提升 10.5%;NBT 为 4.7,较(7.5)降低 38.0%,且显著低于 ReinboT(6.6)与 RWR(7.3); 关键分析:ARFM 通过控制梯度方差避免参数更新过度偏向新任务,同时保留旧任务的高 RL 优势信号,有效缓解 “灾难性遗忘”,更适配终身学习场景。

消融实验:验证关键组件有效性

实验目的:分析 ARFM 中核心超参数(RL 信号与梯度方差权衡系数)与M(二分迭代次数)对性能的影响,结果如图所示:

超参数:不同下模型成功率波动小于 2%,证明 ARFM 的自适应机制降低了对的敏感性,无需精细调参; 迭代次数M:当时,模型成功率趋于稳定(波动小于 1%),说明仅需 10 次迭代即可获得近似最优,算法轻量化且高效。

真实世界实验:验证场景适配性

实验目的:在 UR5 机械臂抓取 - 放置任务(含外部扰动)中评估模型实际性能,结果如图所示:

核心结论:ARFM 在三类物体操控任务中的平均成功率显著高于,且抗扰动能力最优——当目标物体受轻微碰撞时,ARFM 成功率较提升 15%-20%,证明其能将仿真中的性能迁移到真实复杂场景,适配实际机器人操控需求。

总结

ARFM 的核心是在 VLA 流模型损失函数中引入自适应缩放因子,构建偏差 - 方差权衡目标函数,动态平衡 “保留 RL 优势信号” 与 “控制流损失梯度方差”,既放大高RL优势样本权重以捕捉数据质量特性,又避免梯度爆炸保障训练稳定;同时通过合理假设推导缩放因子的优化目标与求解方程,设计二分迭代算法实时更新最优缩放因子,并配套完整微调算法,形成理论到落地的完整链路。

在 LIBERO 仿真基准与 UR5 真实机械臂平台实验中,ARFM 表现优异:多任务学习泛化能力、动作扰动场景鲁棒性、少样本学习数据利用效率、持续学习抗遗忘能力均优于、ReinboT 等基准;且超参数敏感性低、求解高效,在真实带扰动抓取 - 放置任务中适配性好,验证了其实用价值。

未来可探索 ARFM 在 VLA 流模型在线 RL 后训练中的应用,通过环境交互进一步提升模型对新场景的适配能力。