点击下方卡片,关注「3D视觉工坊」公众号

选择星标,干货第一时间送达

来源:我爱计算机视觉

星球内新增20多门3D视觉系统课程、入门环境配置教程、多场顶会直播、顶会论文最新解读、3D视觉算法源码、求职招聘等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

大家好,今天CV君想和大家聊一个机器人和自动驾驶领域的核心技术——SLAM。简单来说,SLAM(即时定位与地图构建)就是要解决一个根本问题:一个机器人在未知环境中,如何知道“我在哪?”以及“周围长啥样?”。这个问题解决了,才能实现真正的自主导航。

近年来,基于学习的“前馈式”视觉模型(Feed-forward Models)给SLAM领域带来了新的活力。它们能直接从图像中“看”出3D结构,在弱纹理等传统方法抓瞎的场景里表现出色。但这些新方法往往是“纯视觉”的,忽略了机器人身上其他有用的传感器,比如IMU(惯性测量单元)和GNSS(全球导航卫星系统)。

如何将新潮的AI视觉模型与经典的多传感器融合技术优雅地结合起来?来自武汉大学的研究者们给出了一个漂亮的答案——MASt3R-Fusion。

论文标题: MASt3R-Fusion: Integrating Feed-Forward Visual Model with IMU, GNSS for High-Functionality SLAM 作者: Yuxuan Zhou, Xingxing Li, Shengyu Li, Zhuohao Yan, Chunxi Xia, Shaoquan Feng 机构: 武汉大学 论文地址: https://arxiv.org/abs/2509.20757 项目地址: https://github.com/GREAT-WHU/MASt3R-Fusion (作者称即将开源)

技术背景:当“AI视觉”遇上“经典融合”

在MASt3R-Fusion之前,SLAM领域主要有两大技术路线:

经典几何方法:比如大家熟知的ORB-SLAM系列,它们通过匹配图像间的特征点来计算位姿,依赖多视几何,但在纹理稀疏或快速运动时容易失效。 前馈式视觉模型:比如近两年大火的DUSt3R、MASt3R等。这些模型用深度学习的方式,直接从两张图片回归出稠密的3D点云和匹配关系。它们见过海量数据,自带强大的3D空间先验,因此在弱纹理场景下非常鲁棒。但缺点是,它们是纯视觉的,存在尺度不确定性(地图可能会随时间整体变大或变小),而且没有利用IMU、GNSS这些能提供真实尺度和绝对位置的宝贵信息。

MASt3R-Fusion的目标,就是取二者之长,将前馈式模型的强大视觉感知能力与传统多传感器融合的高精度、全局一致性结合起来。

MASt3R-Fusion:优雅融合之道

MASt3R-Fusion的系统框架非常清晰,分为实时SLAM和全局优化两个主要阶段。

强大的视觉前端

系统的前端,也就是“眼睛”,采用了一个类似MASt3R的前馈式模型。它接收图像对,直接输出稠密的3D点图(pointmaps)和特征描述子。这为后续的位姿估计和数据关联提供了非常鲁棒和稠密的信息。

融合核心:因子图优化

MASt3R-Fusion的核心是一个基于“因子图(Factor Graph)”的优化框架。CV君打个比方,因子图就像一张“关系网”,上面有代表机器人状态(位姿、速度等)的“节点”,以及代表各种传感器测量信息的“边”(因子)。比如:

IMU预积分因子:提供了连续帧之间高频的运动信息。 GNSS因子:提供了全局绝对位置信息。 视觉因子:提供了相邻或有重叠区域的帧之间的相对位姿关系。

整个系统就是通过求解这张“关系网”,找到一个最优的机器人轨迹和地图,使其最符合所有传感器的测量结果。

关键创新:从Sim(3)到SE(3)的桥梁

这里就引出了本文最核心的技术贡献。前馈视觉模型估计的位姿和地图是在一个“相似变换”空间(Sim(3))下的,也就是说它的尺度会漂移。而IMU和GNSS的测量是在真实的“米”为单位的度量空间(SE(3))下的。如何将这两种不同“语言”的信息融合在一起呢?

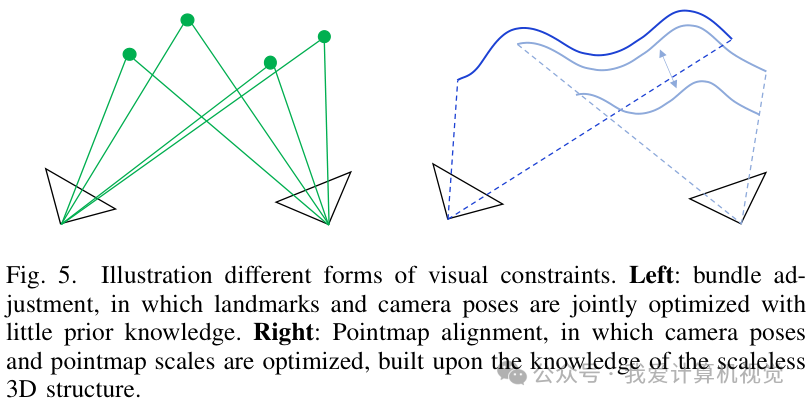

作者设计了一种新颖的基于Sim(3)的视觉对齐约束,并将其巧妙地转换为SE(3)因子图能够理解的形式。如下图所示,它不再像传统BA(Bundle Adjustment)那样联合优化所有地图点和相机位姿,而是基于前馈模型提供的可靠的(无尺度)3D结构,只优化相机位姿和点云的尺度。

通过引入“同构群变换”,论文在理论上完美地搭建了一座从Sim(3)到SE(3)的桥梁,使得视觉信息可以被严谨地、紧耦合地融入到多传感器优化框架中。

此外,系统还设计了分层的因子图结构,兼顾了实时性的滑动窗口优化和全局一致性的回环检测与优化,使得系统既快又准。

实验效果:精度与鲁棒性双丰收

MASt3R-Fusion在多个公开数据集和自采数据集上都取得了非常出色的表现。

在经典的KITTI-360数据集上,无论是VIO(视觉惯性里程计)的相对位姿精度,还是加入回环和全局优化后的绝对轨迹精度,MASt3R-Fusion都显著优于ORB-SLAM3、VINS-Fusion等知名系统。

在更具挑战性的SubT-MRS洞穴数据集上,面对弱纹理、光照变化剧烈的环境,MASt3R-Fusion的优势更加明显,轨迹精度远超其他方法。

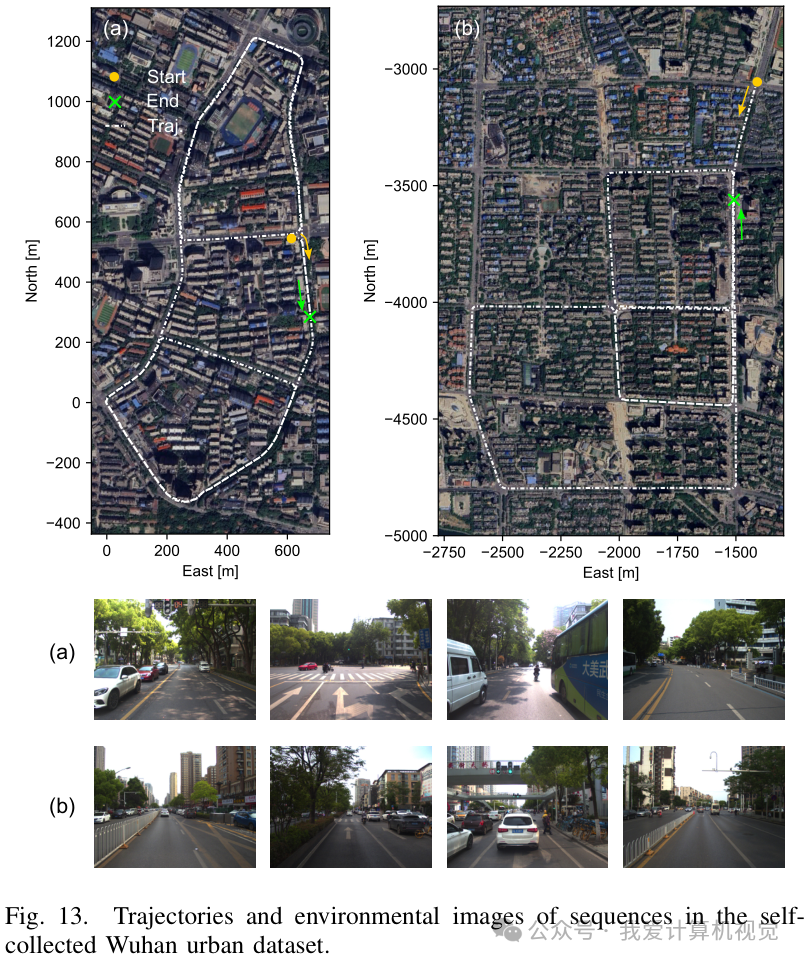

在融合GNSS的城市场景测试中,MASt3R-Fusion表现出极强的鲁棒性。即使在GNSS信号出现粗差甚至中断100秒的情况下,系统依然能凭借强大的VIO性能和全局优化能力,保持亚米级的定位精度。

最后,系统还能实时重建出稠密且度量准确的3D地图,效果非常惊艳。

总结

总的来说,MASt3R-Fusion做了一件非常漂亮的工作:它没有在“学习派”和“几何派”之间做选择,而是将前沿的AI视觉模型作为了一个强大的“视觉传感器”,并将其无缝地、严谨地融入到了经典的多传感器融合优化框架中。这不仅发挥了AI模型在感知上的鲁棒性,也继承了传统优化方法在精度和全局一致性上的优势。

将学习方法和经典优化框架融合,是近年来SLAM领域的一大趋势,大家对此怎么看?欢迎在评论区留下你的看法!

3D视觉硬件,官网:www.3dcver.com

3D视觉学习圈子

星球内新增20多门3D视觉系统课程、入门环境配置教程、多场顶会直播、顶会论文最新解读、3D视觉算法源码、求职招聘等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

3D视觉全栈学习课程:www.3dcver.com

3D视觉交流群成立啦,微信:cv3d001