允中 发自 凹非寺

量子位 | 公众号 QbitAI

腾讯混元世界模型再放大招!刚刚发布并开源混元世界模型1.1(WorldMirror)——真正统一的端到端3D重建基座大模型。

它首次支持用户从多视图或视频中一键生成3D世界,还能在单卡、秒级推理下完成高精度重建。

同时,混元世界模型1.1也是业界首个统一(any-to-any)的前馈式(feedforward)3D重建大模型。

不仅支持额外的相机、深度等多模态先验输入,还能同时实现点云、深度、相机、表面法线和新视角合成等多任务统一输出,性能达成新的SOTA。

效果上,无论是3D点云重建还是端到端3DGS重建,混元世界模型1.1都展现出领先同行的几何精度和细节还原,可以实现更稳定、更真实的场景重建。

那么话不多说,下面我们一起来康康具体效果如何吧~

场景重建效果更佳

首先体验一下此次混元世界模型1.1的生成效果:

动画风格的虚拟场景,对它来说so easy,嗖地一下就置身欧洲小镇街角,感觉下一秒就可以游戏跑图了(doge)

中华风也不在话下,背景里的石灯、房梁都还原度拉满。

真实的航拍场景也满满都是细节,妥妥的景区宣传vlog,即拿即用,这下谁还能分清是不是AI生成的~

以及还有科幻、漫画等多种风格,只要你的创意够用,混元世界模型1.1通通都能帮你实现。

那么再和业界模型横向对比看看。

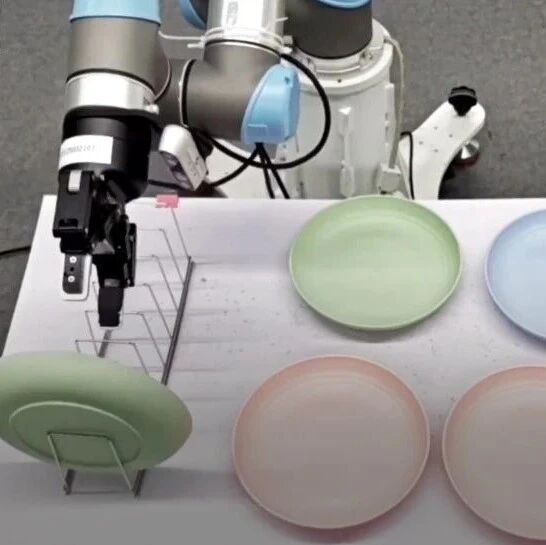

先让混元世界模型1.1和Meta的最新开源模型MapAnything同时处理3D点云重建任务。

可以看出,混元世界模型1.1生成出来的表面更平整,场景也更规整。

而在端到端3D高斯重建任务中,混元世界模型1.1在与AnySplat模型的对比中,同样也展现出领先优势。

混元世界模型1.1在几何精度和细节还原上都全面超越了AnySplat,场景重建更稳定,也更真实。

端到端3D重建大模型

新模型是继今年7月发布的混元世界模型1.0后,腾讯的又一次世界模型大升级。

混元世界模型1.0作为业界首个开源并兼容传统CG管线的可漫游世界生成模型,支持文本或单图输入生成3D场景,凭借“可在消费级显卡上部署”的特性,一经推出便引发社区热议。

而刚刚发布的混元世界模型1.1版本则是在此基础上,全新推出端到端3D重建大模型,并且同样是发布即开源。

其主要具备以下三大特性:

1、灵活处理不同输入(any input)

传统3D重建方法只能处理原始图像,无法利用现实应用中常见的额外信息,混元世界模型1.1则突破性地提出多模态先验引导机制,支持灵活注入:

- 相机位姿:

提供全局视角约束,确保多视图一致性 - 相机内参:

解决尺度歧义,精确投影几何关系 - 深度图:

为纹理缺失区域(如反光面、无纹理区)提供像素级约束

系统采用分层编码策略,紧凑先验压缩为全局语义令牌,稠密先验则以空间对齐方式融合进视觉特征。

通过动态先验注入机制,模型能灵活适应任意先验组合,简单来说,就是如果有就能用,如果没有也能照常工作。

2、通用3D视觉预测(any output)

传统方法往往为单一任务定制,点云、深度、相机位姿,三者选择其一。而混元世界模型1.1实现了业界首次统一,并均取得了SOTA的表现:

点云:密集点云回归 多视角深度图:逐像素深度估计 相机参数:完整位姿和内参预测 表面法线:支持高质量网格重建 3D高斯点:直接用于实时新视角渲染

具体实现是通过端到端多任务协同训练,各任务相互强化,例如,预测的法线图在Poisson表面重建中能产生更清晰的网格细节,而深度和相机约束则互相校准,提升整体几何一致性。

3、单卡部署、秒级推理

不同于需要迭代优化的传统方法(可能耗时数分钟甚至数小时),混元世界模型1.1采用纯前馈架构,在单次正向传播中直接输出所有3D属性,比如说处理典型的8-32视图输入,模型耗时仅需1秒钟。

另外,混元世界模型1.1的架构同样也包含三个核心设计:

多模态先验提示

每种先验采用专化编码策略,其中相机位姿和内参通过MLP投影为单个令牌;深度图通过卷积核生成空间对齐的密集令牌,与视觉特征直接相加。

这种异构融合策略既保留了全局约束的稳定性,又维持了局部几何信息的细节。

通过动态注入与随机组合训练策略,模型能够灵活适应任意先验组合甚至无先验的输入场景,实现对复杂真实环境的鲁棒解析,大幅提升三维结构一致性与重建质量。

通用几何预测架构

基于完全Transformer骨干,使用DPT头进行密集预测(点云、深度、法线),再用Transformer层回归相机参数。

而对于3DGS,系统直接预测高斯位置和属性,并通过可微光栅化器进行监督。

然后通过端到端的多任务协同训练,混元世界模型1.1在结构精度、渲染保真度及跨任务泛化能力上均显著超越现有方案,为通用三维世界建模奠定了新的技术基石。

课程学习策略

整个训练分三个维度递进:

- 任务顺序:

先学基础几何,再学表面属性,最后学3DGS。 - 数据调度:

先用多样化数据,再用高质量合成数据。 - 分辨率渐进:

从低到高。

所采用的这套策略可以将单一图像分布外的泛化能力最大化。

目前混元世界模型1.1项目已完全开源,开发者可克隆GitHub仓库,按照文档一键部署到本地使用。

普通用户也可以直接进入huggingface space在线体验,支持上传多视图图像或视频,实时预览3DGS渲染结果,相关入口点击文末链接即可获取。

混元3D世界模型1.1突破了1.0版本的局限,使用户能够上传多视图或者视频来生成3D场景,通过多模态先验融合、通用几何预测和前馈高效推理的完美结合,将3D重建从专业工具转变为人人可用的技术。

它不仅在性能上刷新开源SOTA,更重要的是打破了技术壁垒——让任何人都能在秒级内从视频或图片中创造出专业级3D场景。

混元团队表示,还将持续优化性能和资源效率,与社区共创生态,让强大的AI模型触手可及。

GitHub地址:https://github.com/Tencent-Hunyuan/HunyuanWorld-Mirror

Hugging Face地址:https://huggingface.co/tencent/HunyuanWorld-Mirror

demo地址:https://huggingface.co/spaces/tencent/HunyuanWorld-Mirror