模仿学习在从大规模真机数据中学习方面展现出巨大潜力,但预训练策略在部署过程中常常会表现不佳,这与具身智能落地场景对成功率的高要求产生了矛盾。为解决这个问题,现有研究提出了"Human-in-the-loop"系统,即在机器人部署执行策略的过程中由人类在训练策略无法完成任务的时候接管机器人,通过遥操作帮助任务完成。Human-in-the-loop系统的优势有两点:

1.对于成功率无法达到落地要求的操作算法,通过人类接管遥操作兜底,可以在Human-in-the-loop的模式下达到成功率要求,胜任任务;

2.Human-in-the-loop接管产生的数据符合具体落地场景的分布,包含了对策略无法完成的情况的处理,这部分数据对后续模型的优化能够起到极大的帮助。

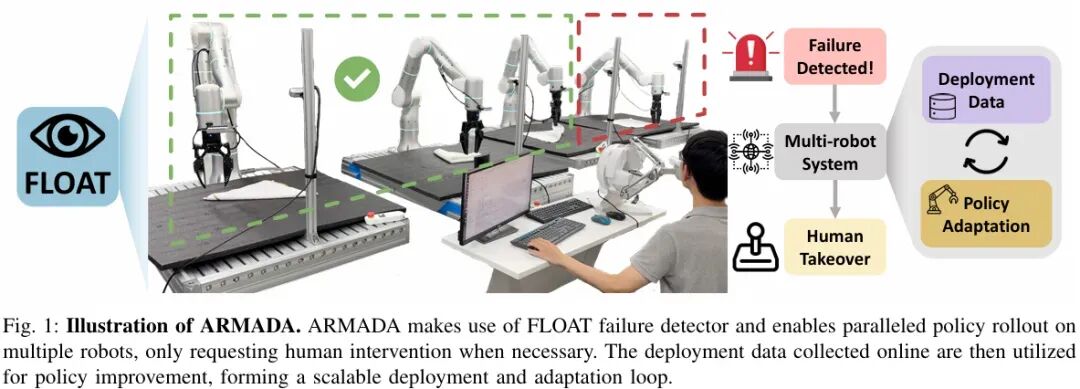

然而,此前的Human-in-the-loop系统通常需要一个人类操作员全程监督一个机器人的行为,以监测机器人是否需要人类接管。这种一对一的工作模式严重制约了系统的可落地性,要突破这一瓶颈需要满足两个关键条件:其一,部署实时故障检测模块,在任务执行异常时自动示警;其二,建立多机器人协同控制架构,通过规模化部署加速策略适应进程。

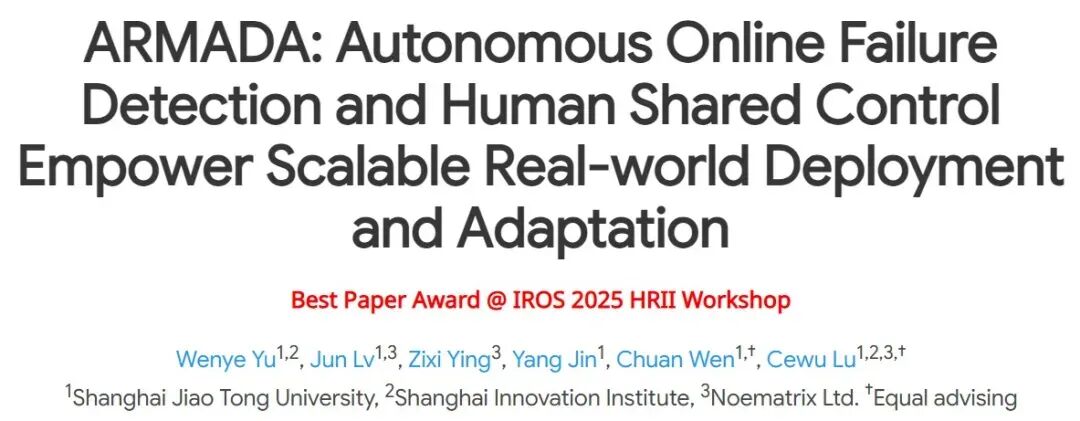

为此,上海交通大学卢策吾团队联合穹彻智能、上海创智学院提出一个人机协同共享控制的多机器人部署与自适应系统ARMADA,创新地提出了自主故障检测方法FLOAT。与ARMADA相关论文成果获得IROS 2025 HRII Workshop最佳论文奖。

ARMADA系统在真实环境中实现了一人对四个机器人的人机协作,仅在必要时请求人工干预,显著降低了对人工监控的依赖。这使得系统能够高效获取数据,实现规模化部署并快速适应新场景。研究人员在4个真实任务上评估系统性能:FLOAT平均检测准确率接近95%,高出现有最优方法20%;经过多轮部署训练,ARMADA在成功率上实现4倍以上提升,同时将人工干预的频率降低超过一半。

-

论文标题:

《ARMADA: Autonomous Online Failure Detection and Human Shared Control Empower Scalable Real-world Deployment and Adaptation》

-

论文链接:

https://arxiv.org/pdf/2510.02298

-

项目主页:

https://virlus.github.io/armada/

-

收录情况:

Best Paper Award @ IROS 2025 HRII Workshop

1

方法

1.1 FLOAT在线异常检测

FLOAT基于最优传输(Optimal Transport)原理,通过匹配当前执行轨迹与专家轨迹,计算两者间的传输成本作为异常指数(FLOAT index)。当该指数超过阈值时,系统判定任务失败。

在实现上,FLOAT从每个时间步的观测中提取策略嵌入向量(policy embedding),并以此为特征进行多轨迹并行匹配,取最小传输成本的专家轨迹作为参照。阈值由成功执行的轨迹集合进行标定,以δ百分位数设定,并在运行中根据误报或漏报情况动态调整。

FLOAT无需额外训练模块,仅依赖策略嵌入向量即可运行,具备策略无关性(policy-agnostic)与良好的实时性,相比基于大模型的方法响应更快、部署更便捷。

1.2 多机器人部署系统

ARMADA通过统一消息队列实现机器人与人类操作员的通信分配接管任务。系统引入适应性回溯(adaptive rewinding)机制:当策略失败时,根据FLOAT指数确定回溯步长,使机器人回到相应时刻并辅助人类恢复场景,从而实现有效接管与数据留存。

ARMADA支持多对多的人机协作模式,显著提升了系统的可扩展性与部署效率;其回溯机制确保每次执行都可转化为高价值的后训练数据,增强系统的自我进化能力。

1.3 策略架构与训练方案

研究人员采用Diffusion Policy作为模仿学习方法,选择Transformer架构作为动作生成主干网络。为获得更丰富的策略嵌入,使用预训练DINOv2 ViT-B/14模型作为视觉编码器。为压缩DINOv2编码器产生的高维隐变量以适配最优传输计算,在视觉编码器后接入一个linear head。

2

实验

研究人员通过实验探讨以下4个问题:

1.FLOAT与现有在线故障检测方法相比表现如何?

2.所提出的回退机制能否提升示范数据质量?

3.ARMADA在降低人工干预依赖方面的效果如何

4.ARMADA在提升部署可扩展性及适应新场景方面的表现如何?

实验涵盖四项真实世界中的任务,如下视频所示,包括"弹珠入碗"、"挂杯上架"、"取放芒果"和"折叠毛巾"。

2.1 FLOAT与先前的在线故障检测方法对比

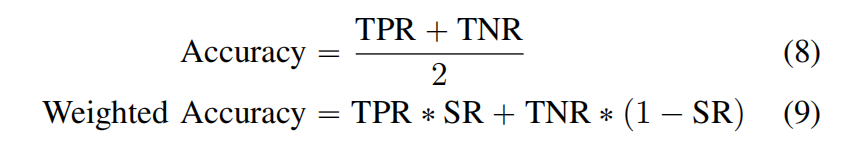

研究人员选取了两种代表性基线方法:STAC和logpZO。采用五项评估指标:灵敏度(TPR)、特异性(TNR)、准确率、加权准确率和样本级TNR。灵敏度指的是策略失败时检测器正确报警;特异性指策略成功时检测器未误报。准确率与加权准确率定义见式(8)(9)。样本级TNR作为步级指标,衡量策略失败前所有步骤中特异性的比例,对多机器人系统至关重要,因为持续误报会严重影响系统吞吐量。

实验结果如图3所示,FLOAT平均准确率高达约95%,显著优于现有方法,比次优方法STAC高出近20%。log pZO因假设数据独立同分布导致TNR极低。

此外,还构建了FLOAT与STAC的融合版本FLOAT+Action(任一检测器报警即触发警告),FLOAT在所有任务中均达到与该融合版本相当的性能,证明了该方法能够不依赖动作预测即可检测多种故障模式。

2.2 回退机制对示范数据质量的提升效果

将ARMADA与现有人机协同学习方法Sirius对比,该方法需全程人工监控,通过加权强调人工干预轨迹进行策略微调的训练策略性能。实验结果如图5所示。

2.3 ARMADA对降低人工干预依赖的效果

如图7所示,尽管首轮评估中因自适应回退机制导致ARMADA需要更多人工干预,但经过两个微调阶段后,其人工干预率降低23.3%,降幅超Sirius的两倍。这证明ARMADA能在保持相近人力消耗下,通过增加多机器人系统中的并行机器人数量来提升部署可扩展性。

2.4 ARMADA在提升部署可扩展性及适应新场景方面的表现

为验证ARMADA促进策略适应新场景的能力,在三台机器人上同步部署了预训练的叠毛巾策略进行在线数据采集,如图6所示。

值得注意的是,部署过程中引入了三组不同的干扰物,用于提升微调后策略对未知领域的泛化能力。消融实验仅在场景A进行单轮部署,每轮部署持续20分钟,随后使用采集轨迹进行策略微调,交替进行三轮。所有微调后策略在未知场景D进行评估。

实验结果如图8所示:通过多机器人并行部署与多样化场景训练,ARMADA能加速策略对未知场景的适应能力,并随部署时长提高任务成功率。

为了验证ARMADA在从各个领域获取人工干预数据方面的效率,研究人员还统计了在单次部署阶段中对人工操作员的占用时长,如图9所示。在相同时间内,ARMADA凭借并行策略部署的优势,采集到的人工干预样本数量是单机器人设置的两倍以上。这些基于多样化领域生成的高质量人工轨迹,增强了策略面对新场景时的鲁棒性,从而验证了ARMADA在实现可扩展的策略自适应以及更高效利用人类指导方面的实用价值。

3

总结

END