1

引言

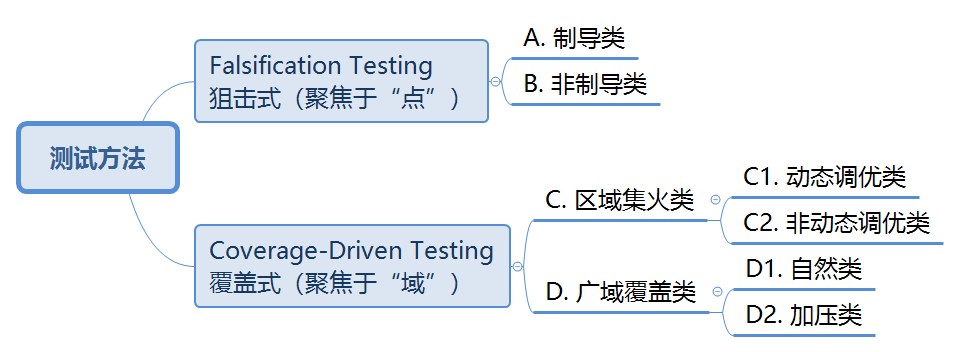

测试策略:各种基于机器学习的测试方法的研究方向由两大测试策略引导,即「证伪, Falsification」与「覆盖, Coverage-Driven」测试。

依照两大类测试策略,即证伪和覆盖,可以大致将基于场景的测试方法分为下图所示的四小类。

表1 基于场景生成的测试方法

表2 不同被测对象匹配测试工具对比

由于测试系统中包含了测试方法和测试工具的组合,其整体的性能需求也是由测试方法、测试工具及系统本身这三方面的需求共同构成。

测试策略引导下的测试方法中,Falsification Testing一类侧重“有效”,主打“成功率”;Coverage-Driven Testing一类则侧重“全面”,主打“覆盖率”。

测试工具中,面向感知系统的,侧重对于环境还原和感知的“真”;面向决策系统的,侧重对于动态对象运动编排的“真”;面向控制系统的,侧重车辆动力学模型的“真”。

测试系统本身还有一些基础共性的需求,包括测试结果的可重复性、测试过程的可追溯性、测试执行的方便性和高效性,以及通过测试提高被测对象的可解释性等。

表3 测试方法、测试工具及测试系统性能需求

2

基于场景生成的测试方法介绍

被什么问题驱动?研究的初心是什么?

受到什么研究(文章)启发?

本研究主要汲取了近年来在生成模型领域取得突破性进展的扩散模型以及(视觉语言)大模型进行复杂场景理解与生成这两大前沿方向的启示。

基于扩散模型生成场景:扩散模型能够有效学习真实交通场景的数据分布,并且为可控场景生成提供了高效途径。通过引导扩散技术,在无需额外训练的情况下,能灵活生成满足特定行为约束的轨迹[1-3]。

基于大模型生成场景:大模型凭借其强大的语义理解与推理能力,为自动化生成更符合人类意图和现实逻辑的场景注入了新的活力。除此之外,大模型可以的输出不同层级、形式多样的结果(如直接输出轨迹或者Carla仿真器脚本),使其能够灵活地嵌入到不同的方法流程和应用框架中[4-5]。

创新突破是什么?

效果是怎么样的?

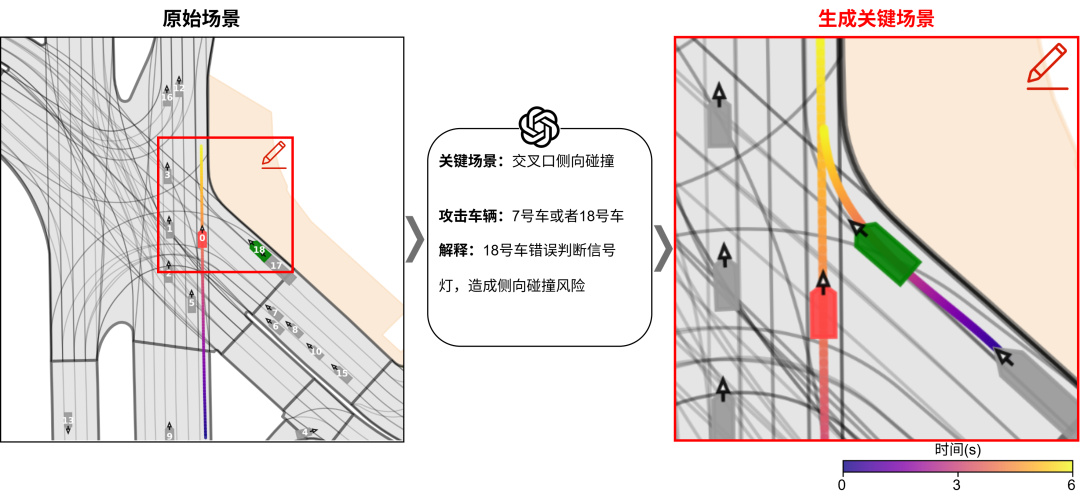

跨地图场景生成多样性:研究提出方法能够根据不同的初始场景和VLM的分析结果,生成多样化的关键场景。这意味着系统不仅仅是重复生成相似的危险情况,而是能够创造出不同类型的、具有挑战性的测试用例。

同场景行为引导多样性:即使是针对同一个具有潜在风险的初始场景,该方法也能够通过控制不同的背景车辆,或者改变这些背景车辆的行为模式,来对主车施加不同类型的关键交互。这样一来,从一个原始场景数据点出发,可以衍生出多个模式各异但都具有挑战性的关键测试场景。

被什么问题驱动?研究的初心是什么?

受到什么研究(文章)启发?

本研究的开展,受基于深度强化学习以及基于优化的安全关键场景生成方法启发。

基于深度强化学习的安全关键场景生成:近年来,基于深度强化学习的安全关键场景生成方法,在场景生成的效率和关键程度的角度取得一定的进展和成果,证实来深度强化学习方法在交通参与者建模、场景风险性优化方面的优势[6-7]。

然而,现有研究还有很多尚未解决的问题,例如对待测系统适应性的分析与验证、场景生成的效率瓶颈和多样性局限等等。

创新突破是什么?

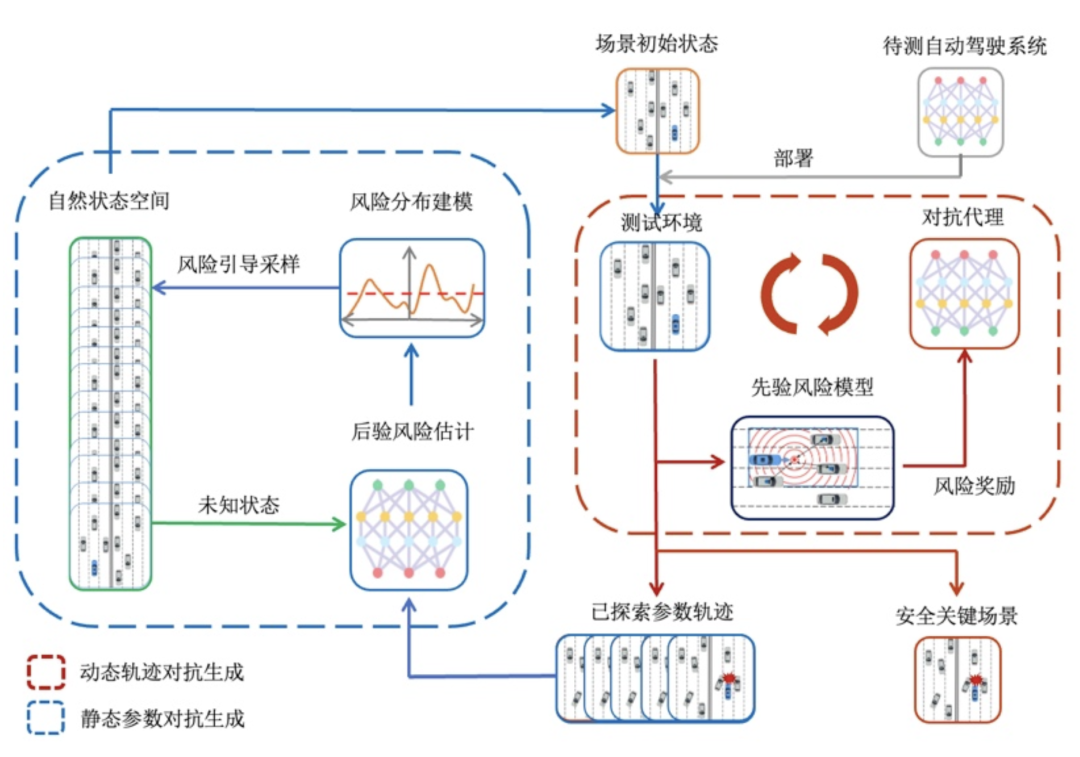

动态场景轨迹优化:提出先验风险引导的对抗性策略优化方法,将动态场景轨迹优化的过程建模为周车策略的在线优化过程,并将交通先验约束以预定义规则的形式融入到优化过程中,在此基础上,通过基于势场论的在线风险量化模型对场景生成模型给予实时引导,实现兼具效率与合理性的场景参数优化过程。

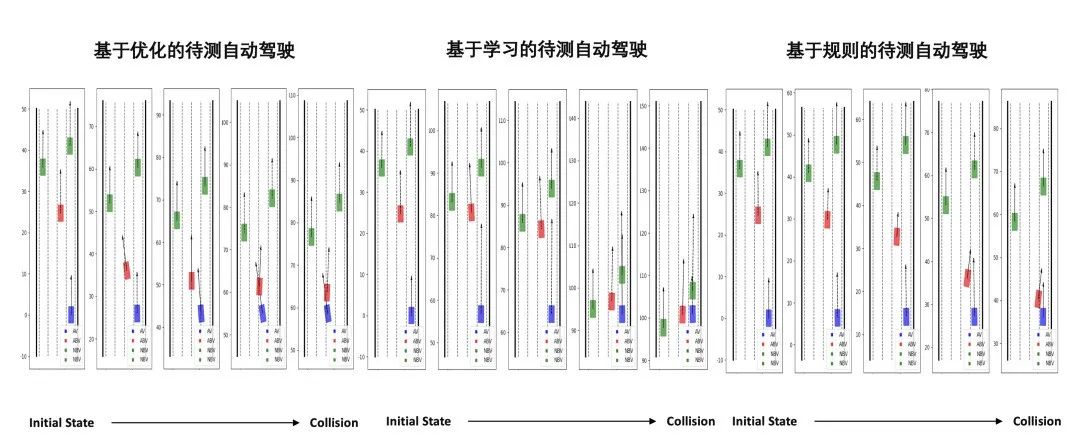

效果是怎么样的?

被什么问题驱动?研究的初心是什么?

基于关键场景的自动驾驶系统测试与算法迭代是提升其能力的核心手段。然而,当前面临的现实问题是:如何在标注数据有限的情况下,高效识别那些对系统构成挑战或影响用户体验的关键场景?

以“主观风险场景”为例,这类场景的关键性往往源于复杂的多车博弈、其他交通参与者的潜在不确定行为、或特定环境带来的压迫感,而非简单的物理碰撞风险。这种主观感受难以用传统的碰撞时间(TTC)等客观指标完全量化,其发生机理也未被充分探明。这就导致自动化标注困难,高质量数据匮乏。这严重制约了依赖大量训练数据的深度学习场景识别模型的效能。

因此,本研究的核心目标在于,探索能够深入理解场景内复杂时空交互的模型,并实现在标注数据稀缺条件下的有效学习,以期准确识别包括主观风险场景在内的各类关键场景,为自动驾驶系统的优化与验证提供支撑。

受到什么研究(文章)启发?

本研究的开展,借鉴了自动驾驶场景建模与迁移学习领域的既有成果。

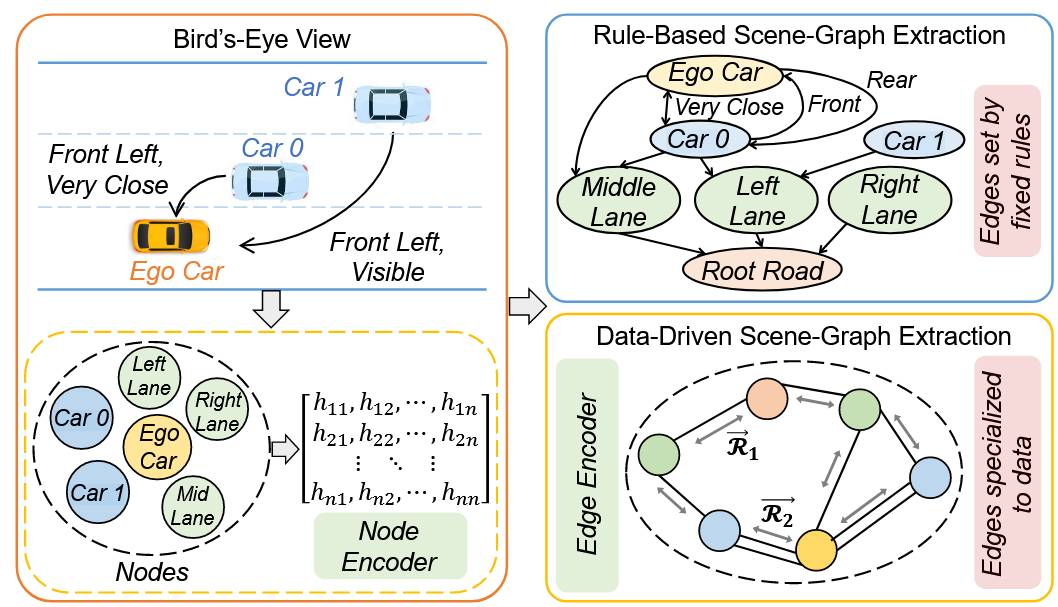

基于图的场景建模与表征:在场景表征与特征提取方面,研究采用了基于图神经网络(GNN)进行复杂场景建模的思路。例如,Jia X等人[10]与Yu S等人[11]分别利用图结构显式捕捉多智能体交互和时空动态,为轨迹预测或场景风险评估等任务提供了有效的基础。

图17 HDGT场景建模[6]

图18 RS2G场景建模[7]

基于轨迹预测的模型预训练: 为应对标注数据稀缺的挑战,本研究受到了将轨迹预测这一无需标注数据作为预训练任务的相关工作的启发。TrajPT[12]与GSAN[13]等研究已成功验证,基于轨迹预测任务预训练的模型能够有效迁移至下游任务(如意图识别)。

创新突破是什么?

边增强的图注意力层:与现有将图神经网络和注意力机制结合的工作相比,EGAL的创新在于将边特征更显式地融入注意力计算和节点更新,使模型能更精细捕捉实体间的动态交互,这对于理解复杂的驾驶场景至关重要。

效果是怎么样的?

复杂场景的理解能力:本研究提出的预训练模型,如图19所示,在Argoverse v2轨迹预测任务上实现良好的轨迹预测能力,其多模态预测(K=6)的minFDE指标为1.86米,minADE为0.98米,展现了对复杂场景的理解。

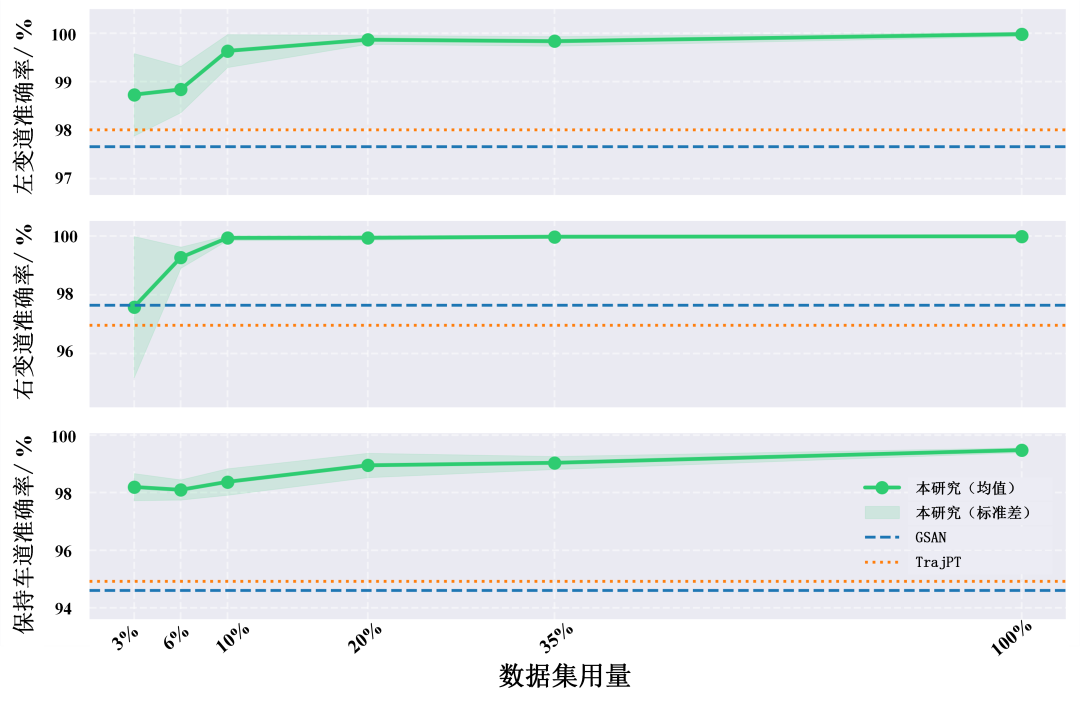

图19 预测任务中模型表现

小样本学习能力:在迁移学习方面,应用于highD数据集的变道意图分类任务时,本方法性能超越基线TrajPT和GSAN,在全量数据上各类别准确率均超99.4%。更重要的是,如下图所示,仅使用3%标注数据进行训练即可超越基线方法在全量数据上训练的表现。

图20 变道意图分类任务中模型与基线表现对比

关键场景识别能力:针对关键场景识别,在基于DNDA指标标注的数据上,模型对关键与非关键场景的分类准确率分别为81%与93%;在主观风险标注稀缺的任务中,F1分数达0.804,关键场景识别准确率为76.6%。进一步通过模型在未标注数据上的高置信度推理,可挖掘出与训练集中关键场景分布相近的新样本,如图21所示,推理得到的关键样本(深红三角)主要分布在原关键样本(浅红圆点)周围。

图21 关键场景识别任务表现

被什么问题驱动?研究的初心是什么?

开环评测:通常在离线数据上进行,仅衡量模型在单步预测任务中的准确性,如轨迹偏差或控制误差,评估效率高但无法体现模型对环境的长期影响。

有限的智能体行为建模(Limited Agent Behavior Modeling):多数模拟器中,其他交通参与者的行为往往依赖规则或简单策略,缺乏真实交通中复杂、多变的互动逻辑,导致系统评测脱离真实挑战。

受到什么研究(文章)启发?

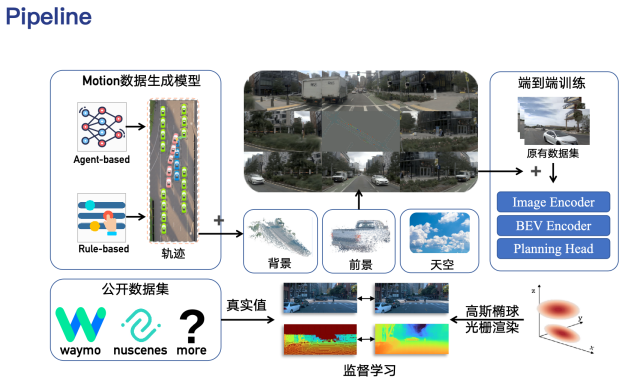

创新突破是什么?

图22 3D GS渲染具备帧间一致性

图23 本研究技术路线图

效果是怎么样的?

以下对于研究所提出方法的效果进行展示:

图24 GT图像

图25 3D GS重建图像

图26 基于规则的模型接入

图27 驾驶场景重建示例

图28 Agent-based模型框架

图29 驾驶场景重建示例

被什么问题驱动?研究的初心是什么?

预定义场景:在测试开始之前被预先定义好,场景中的背景车(BV)遵循定义的规则进行行驶,在测试过程中不和被测系统(SUT)进行交互,这种方法缺乏交互性。

受到什么研究(文章)启发?

创新突破是什么?

本研究的创新突破主要聚焦于训练方法与奖励函数设置上。

训练方法:设计了两阶段的训练框架。阶段一参照研究[1],基于 Level‑k 原理和个体奖励函数,训练驾驶员模型以获得真实可靠的基础驾驶能力;阶段二 在 SUT-in-the-loop 环境下,运用 CTDE 多智能体强化学习,并引入协作奖励,进一步促使驾驶员模型与 SUT 开展对抗训练。

图30 两阶段训练框架示意图

效果是怎么样的?

对抗驾驶能力:图31-32分别展示了两车协作对抗/三车协作对抗的情况,从三个场景中可以看出,本研究所构建的双模态驾驶员模型通过压缩SUT前向行驶空间和两侧潜在换道空间的方式,实现了与SUT的对抗,并最终导致了SUT与背景车发生了碰撞。同时,与单车对抗相比,多背景车协作对抗能得到背景车行为模式更加多样的安全关键场景。

图31 两车协作对抗

图32 三车协作对抗

驾驶行为真实性验证:本研究统计了所有生成的场景中,背景车的两个关键物理参数(速度和TTC)的分布,并将这两个分布与自然驾驶数据集highD中的对应参数分布进行比较,结果如图33所示。从图中可以看出,本研究提出的双模态驾驶员模型的行为真实性也可以保证。

图33 背景车速度与变道时TTC参数的分布统计

场景生成效率:对比本研究中提出的双模态驾驶员模型与文献[1]中的驾驶员模型在生成安全关键场景上面的效率,如表1所示,在相同的500轮仿真中,本研究提出的双模态驾驶员模型生成了429个安全关键场景,远高于文献[17]中的模型

表4 场景生成效率对比

3

小结

参考文献:

[1] Zhong Z, Rempe D, Xu D, et al. Guided conditional diffusion for controllable traffic simulation[C]//2023 IEEE international conference on robotics and automation (ICRA). IEEE, 2023: 3560-3566.

来源丨同济智能汽车研究所

责编丨高炳钊

☟☟☟

☞人工智能产业链联盟筹备组征集公告☜

☝

精选报告推荐:

11份清华大学的DeepSeek教程,全都给你打包好了,直接领取:

【清华第四版】DeepSeek+DeepResearch让科研像聊天一样简单?

【清华第七版】文科生零基础AI编程:快速提升想象力和实操能力

【清华第十一版】2025AI赋能教育:高考志愿填报工具使用指南

10份北京大学的DeepSeek教程

【北京大学第五版】Deepseek应用场景中需要关注的十个安全问题和防范措施

【北京大学第九版】AI+Agent与Agentic+AI的原理和应用洞察与未来展望

【北京大学第十版】DeepSeek在教育和学术领域的应用场景与案例(上中下合集)

8份浙江大学的DeepSeek专题系列教程

浙江大学DeepSeek专题系列一--吴飞:DeepSeek-回望AI三大主义与加强通识教育

浙江大学DeepSeek专题系列二--陈文智:Chatting or Acting-DeepSeek的突破边界与浙大先生的未来图景

浙江大学DeepSeek专题系列三--孙凌云:DeepSeek:智能时代的全面到来和人机协作的新常态

浙江大学DeepSeek专题系列四--王则可:DeepSeek模型优势:算力、成本角度解读

浙江大学DeepSeek专题系列五--陈静远:语言解码双生花:人类经验与AI算法的镜像之旅

浙江大学DeepSeek专题系列六--吴超:走向数字社会:从Deepseek到群体智慧

浙江大学DeepSeek专题系列七--朱朝阳:DeepSeek之火,可以燎原

浙江大学DeepSeek专题系列八--陈建海:DeepSeek的本地化部署与AI通识教育之未来

4份51CTO的《DeepSeek入门宝典》

51CTO:《DeepSeek入门宝典》:第1册-技术解析篇

51CTO:《DeepSeek入门宝典》:第2册-开发实战篇

51CTO:《DeepSeek入门宝典》:第3册-行业应用篇

51CTO:《DeepSeek入门宝典》:第4册-个人使用篇

5份厦门大学的DeepSeek教程

【厦门大学第一版】DeepSeek大模型概念、技术与应用实践

【厦门大学第五版】DeepSeek等大模型工具使用手册-实战篇

10份浙江大学的DeepSeek公开课第二季专题系列教程

【精选报告】浙江大学公开课第二季:《DeepSeek技术溯源及前沿探索》(附PDF下载)

【精选报告】浙江大学公开课第二季:2025从大模型、智能体到复杂AI应用系统的构建——以产业大脑为例(附PDF下载)

【精选报告】浙江大学公开课第二季:智能金融——AI驱动的金融变革(附PDF下载)

【精选报告】浙江大学公开课第二季:人工智能重塑科学与工程研究(附PDF下载)

【精选报告】浙江大学公开课第二季:生成式人工智能赋能智慧司法及相关思考(附PDF下载)

【精选报告】浙江大学公开课第二季:AI大模型如何破局传统医疗(附PDF下载)

【精选报告】浙江大学公开课第二季:2025年大模型:从单词接龙到行业落地报告(附PDF下载)

【精选报告】浙江大学公开课第二季:2025大小模型端云协同赋能人机交互报告(附PDF下载)

【精选报告】浙江大学公开课第二季:DeepSeek时代:让AI更懂中国文化的美与善(附PDF下载)

【精选报告】浙江大学公开课第二季:智能音乐生成:理解·反馈·融合(附PDF下载)

6份浙江大学的DeepSeek公开课第三季专题系列教程

【精选报告】浙江大学公开课第三季:走进海洋人工智能的未来(附PDF下载)

【精选报告】浙江大学公开课第三季:当艺术遇见AI:科艺融合的新探索(附PDF下载)

【精选报告】浙江大学公开课第三季:AI+BME,迈向智慧医疗健康——浙大的探索与实践(附PDF下载)

【精选报告】浙江大学公开课第三季:心理学与人工智能(附PDF下载)

【AI加油站】第八部:《模式识别(第四版)-模式识别与机器学习》(附下载)

人工智能产业链联盟高端社区

一次性说清楚DeepSeek,史上最全(建议收藏)

DeepSeek一分钟做一份PPT

用DeepSeek写爆款文章?自媒体人必看指南

【5分钟解锁DeepSeek王炸攻略】顶级AI玩法,解锁办公+创作新境界!

【中国风动漫】《雾山五行》大火,却很少人知道它的前身《岁城璃心》一个拿着十米大刀的男主夭折!

免责声明:部分文章和信息来源于互联网,不代表本订阅号赞同其观点和对其真实性负责。如转载内容涉及版权等问题,请立即与小编联系(微信号:913572853),我们将迅速采取适当的措施。本订阅号原创内容,转载需授权,并注明作者和出处。如需投稿请与小助理联系(微信号:AI480908961)

编辑:Zero