近年来,多模态大模型(MLLMs)发展迅猛,从看图说话到视频理解,似乎无所不能。但你是否想过:它们真的“看懂”并“想通”了吗?这些模型在面对复杂的、多步骤的视觉推理任务时,能否像人类一样推理和决策?

清华大学智能产业研究院(AIR)执行院长刘洋教授团队,联合清华大学计算机系、复旦大学带来重磅新作——EscapeCraft:一个3D密室逃脱环境,让大模型像真人一样“动脑逃生”,用于评估多模态大模型在视觉环境中,完成复杂任务推理的能力。测评结果却意外频出:模型常常看到了门,却一直绕着墙走;捡起钥匙,却忘了怎么用;甚至有模型想去“抓”沙发,理由是“可能有暗格”……这不是个别翻车,而是系统性的“看见不代表理解”。即便是 GPT-4o 这样的明星模型,也只有少部分子任务是真的想明白了完成的,其它全是歪打正着。

•项目主页:https://thunlp-mt.github.io/EscapeCraft

•GitHub地址:https://github.com/THUNLP-MT/EscapeCraft

•本次成果被计算机视觉顶会ICCV 2025录用,作者包括王梓玥、董宇睿、罗富文、阮珉源、程志立、陈驰、李鹏、刘洋,其中王梓玥和董宇睿为共同一作。

图一:论文首页

EscapeCraft环境

沉浸式互动环境,灵感源自密室逃脱

研究团队打造了可自动生成、灵活配置的 3D 场景 EscapeCraft,模型在里面自由行动:找钥匙、开箱子、解密码、逃出房间……每一步都需整合视觉、空间、逻辑等多模态信息。

任务可扩展,应用无限可能

EscapeCraft以逃出房间为最终目的,重点评测逃脱过程中的探索和决策行为、推理路径等。支持不同房间风格、道具链长度与难度组合,还可扩展到问答、逻辑推理、叙述重建等任务。它是一个高度灵活、可持续迭代的通用评测平台,也可以为未来的智能体、多模态推理、强化学习等方向研究提供基础环境、数据和奖励设置方面的支持。

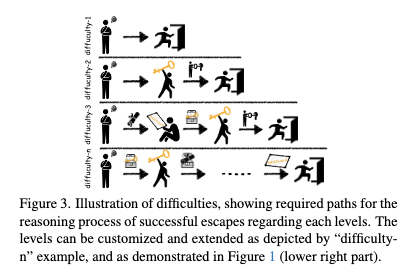

图二:EscapeCraft支持自由订制和扩展想要的难度等级。不同难度等级下所需的逃脱步骤有所不同。

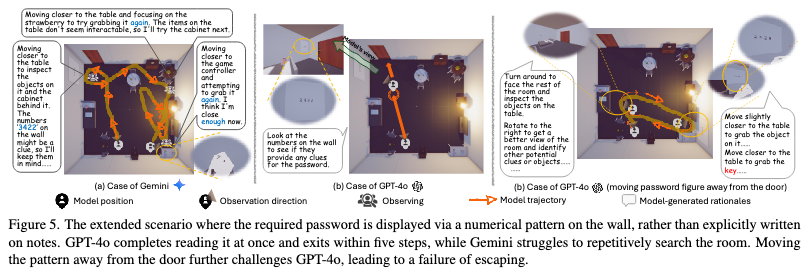

图三:对于可扩展性的说明。在该案例中,我们将线索放置在了墙上而不是箱子中,考验模型对于环境信息的接收和处理能力,除此之外线索在房间的摆放位置也可自由选择。在第一个场景中,线索位于靠近出口的墙上,此时GPT-4o的表现更加出色,可以对线索进行正确利用。然而,当我们把线索移动到距离出口较远的墙上,GPT-4o开始不断重复历史路径,无法对正确理解和利用线索,导致逃脱失败。

模型推理和过程评测

沉浸式环境 + 多模态感知 + 自由交互

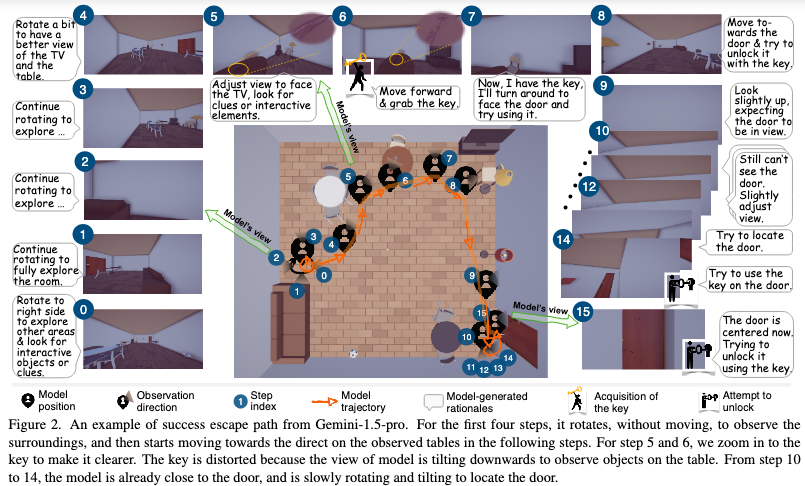

EscapeCraft 以真实密室逃脱为灵感,构建了一个可自动生成3D场景的评测环境,要求模型靠视觉线索与环境交互自主完成任务。找钥匙、解密码、开门逃生,每一步都要求“动脑子”!下图为Gemini-1.5-Pro在其中一个密室的逃脱表现。

图四:一个真实逃脱路径的示例。第0步(左下角的0号图)为模型初始位置视角,第15步(右下角的15号图)为最后“开门”时的视角。

从“答对”到“会想”

与传统只看“答对没”的评测不同,EscapeCraft 关注整个任务完成过程:模型是否自主探索?有没有重复犯错?道具用得对不对?真正测的是模型的“类人推理过程”。论文重点弥补以结果为导向的评估缺陷,设计了多个衡量视觉感知、多模态推理、环境探索和工具获取和利用的过程的创新指标:

Intent-Outcome Consistency(意图与结果一致性):衡量模型与环境的交互结果是否和的模型的交互意图一致,即模型是否“在正确的位置做正确的事”。

Prop Gain / Grab Ratio / GSR:刻画模型在探索和推理过程中的行为模式,反映模型的交互质量、推理效率和智能程度。

评测结果显示:GPT-4o 在 Difficulty-3 中仅有 26.5% 的子目标达成是“真正理解后完成的”,其余大多为偶然成功(比如想拿电视却误抓到关键道具)。

研究还发现大量有趣失败案例。例如:

模型面对不可交互的沙发,仍试图抓取,并在“理由”中解释“沙发下可能藏着钥匙”;

模型原本已经看见了关键道具,却在移动过程中将其“逐步移出视野”,随后继续提及该道具却操作失败……

团队据此将错误拆分为两类:

视觉感知错误:误判目标是否可交互,视角控制失败;

推理逻辑错误:目标设定错误,或动作与意图不符。

其中 Claude 3.5 的错误中,61.1% 属于推理问题,38.9% 属于视觉问题。这说明即便模型“看到了”,不代表它“想清楚了”。

谁能逃离“密室”?

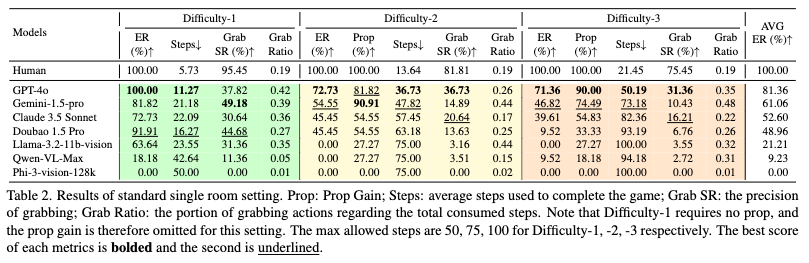

图五:单房间逃脱结果统计,包括3个不同难度级别(数值越大越难)。

研究评测了包括 GPT-4o、Gemini-1.5 Pro、Claude 3.5、LLaMA-3.2、Qwen、Phi-3 等热门模型,发现:

在任务评价指标方面:

GPT-4o 逃脱成功率(ER)最佳,但在任务复杂度提升后仍频频出错;

国产大模型Doubao 1.5 Pro在最简单的关卡中,逃脱成功率超越Gemini 1.5 Pro和Claude 3.5 Sonnet;并且其交互成功率(Grab SR)超越GPT-4o和Claude 3.5 Sonnet;

即使模型逃脱成功率相同,EscapeCraft依然能利用道具获取率(Prop)、使用步数(Step),交互成功率(Grab SR)和交互率(Grab Ratio)对模型进行比较。比如,在“Difficulty-2”中,Gemini 1.5 Pro和Claude 3.5 Sonnet有相同的逃脱成功率和道具获取率,但是Gemini 1.5 Pro凭借较高的交互率,即使它的交互成功率较低,也能通过相对较少的步数成功逃脱;而Claude 3.5 Sonnet虽然交互率低,但每一步交互的成功率较高,体现出该模型完成任务时的“深思熟虑”。

在推理和探索行为方面:

Gemini 和 Claude 常在房间角落“卡住”,空间方向等判断失误,空转失败;

多数模型容易“反复抓错”或“认错道具”,他们的失败方式也各有特色:有的不会动、有的乱动、有的只移动不采取交互行动、有的动作对了但“目的不清”……;

子目标达成率虽高,但意图-结果一致性普遍低下,即“想要和沙发交互,但是意外地拿到钥匙”;

在多房间设定下,模型能从第一个房间学习到的逃脱经验有限,仅在两个房间关卡设定相似的条件下有辅助作用。

AIR长期招聘人工智能领域优秀科研人员

点这里关注我们

关于AIR