在机器人操作中,当前常见的VLA/VA视觉运动策略(visuomotor policy)通常需要同时依赖视觉观测和本体状态(如关节角度、末端执行器位姿)来控制动作。虽然这种方法能保证训练环境下的精度,但一旦任务环境或目标位置发生变化,机器人就可能“懵了”,表现大幅下降。

这个问题的原因是当前主流的VLA/VA范式很容易过拟合到训练轨迹,本质上是是模仿学习的本身缺陷所致。对于主流VLA/VA来说,输入有机器人当前的观测Observation和本体State,输出只有Action预测的监督,对于搞过Deep Learning的人来说,我们知道模型在学习的时候会偷懒走捷径:它不认真分析视觉里的物体该怎么抓,而是直接把特定体感状态和固定动作绑定。比如训练时桌子高 80cm,机器人记住当关节角度是 X、夹爪坐标是 Y 时,执行动作 Z 就能抓起笔;可一旦桌子变高到 90cm,原来的体感状态再也没出现过,机器人就彻底懵了,这就是典型的过拟合到训练轨迹,空间泛化能力自然差。

更麻烦的是,要解决这个问题,传统思路要么靠堆数据,要么靠复杂的算法修正,但前者成本极高,后者往往在复杂场景下失效。

来自清华和千寻的高阳团队,创新性地提出了 State-free Policies(无状态策略),让机器人仅依赖视觉观测进行动作预测,不再依赖状态输入,实现了出色的空间泛化能力。

Paper: https://arxiv.org/pdf/2509.18644

Project: https://statefreepolicy.github.io/

典型案例:相对数据采集时的机械臂位置,两个臂各外移15cm后,有状态和无状态在叠衣服任务上的表现如下视频所示。

一、什么是无状态策略?

无状态策略的核心设计包括三个方面:

1. 去掉状态输入

不再依赖末端执行器位姿、关节角度等状态信息,让策略不能依赖“捷径”记忆训练轨迹。

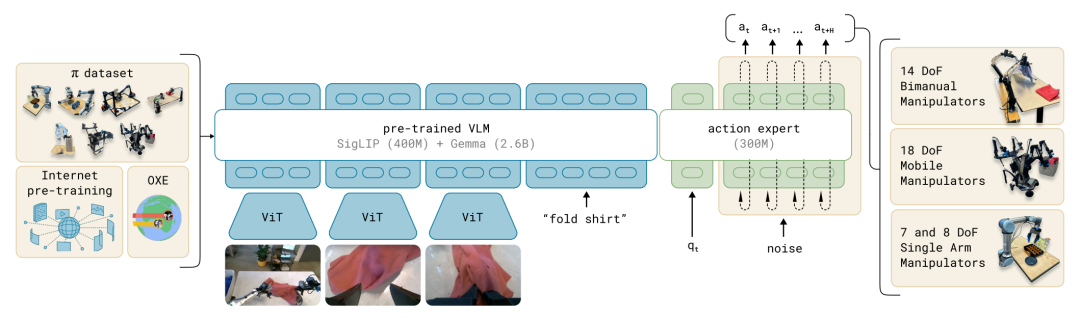

下图为模型的框架图,为典型的有状态策略(State-aware Policies),就是输入的State向量,去掉状态输入就是去掉。

2. 相对末端动作空间(Relative EEF Action Space)

机器人预测末端执行器相对移动,而非绝对位置。即便机器人在不同位置执行任务,相同的视觉观测会产生相同的动作。

3. 完整任务视觉观察(Full Task Observation)

末端执行器配备覆盖范围更全的相机设计(比如双广角手腕相机(120°×120°)),再加顶视相机,实现对任务区域的全覆盖,让策略从视觉中理解整个任务。

二、无状态策略的核心机制

绝对动作与相对动作

无状态策略的核心机制是预测的Action怎么表示和学习,Action的表示可以分为相对动作和绝对动作,相对动作比绝对动作有诸多优势,总结如下表1所示。

相对关节角与相对末端

相对动作又可分为“相对关节角动作空间(Relative Joint-angle Action Space)”和“相对末端执行器动作空间(Relative EEF Action Space)”,那到底选用哪种Action表示好呢?答案当然是“相对末端执行器动作空间”,我们来具体推演一下。

“相对关节角动作空间”输出的是关节角增量(∆θ),即:

由于正向运动学函数 依赖当前关节角 ,即使机器人在不同高度、不同构型下看到同样的场景,也会因为 不同而产生错误的末端位移。这就是为什么“相对关节角动作空间”使用“有状态策略”在空间泛化上会失败的根本原因。

而“相对末端执行器动作空间”采用无状态策略直接输出末端的相对位姿,即:

其中 𝜋 为策略网络,输入为视觉观测 ,输出为末端相对位移(Relative End-Effector Delta)。

这样一来:

-

同样的视觉输入 → 输出相同的末端位移;

-

无需知道关节角或绝对位姿;

-

末端动作语义稳定、与构型解耦;

-

具备天然的空间不变性(invariance)。

因此,当桌面升高、物体位置变化时,只要视觉观测一致,机器人就能输出相同语义的动作,实现“视觉一致性驱动”的泛化。

三、详细的对比实验

数据收集和实验设置

任务设置:

-

取放任务(Pick Pen / Pick Bottle / Put Lid)

-

折叠衬衫(Fold Shirt)

-

整机取瓶(Fetch Bottle,涉及躯干、腰部和腿部控制)

数据通过遥操作收集,每个取放任务(Pick Pen / Pick Bottle / Put Lid)约 5 小时(300 条轨迹),复杂任务(Fold Shirt / Fetch Bottle)约 80 小时(10,000 条轨迹)。训练数据中桌面高度固定,目标物体位置受限,确保策略空间泛化能力来源于模型本身,而非多样化数据。

评估指标:

-

高度泛化:在不同桌面高度(72 cm 与 90 cm)测试策略表现(数据采集的桌面高度为80cm)。

-

水平泛化:在二维平面中移动目标物体位置评估策略成功率。

每个任务每个设置下分别进行 30 次试验,完整轨迹成功完成计为成功。

评估模型:使用

真实世界操作任务

1. Pick & Place 任务的空间泛化

与基于状态的策略相比,无状态策略(State-free Policies)在高度与水平泛化上均有显著提升。

以“Pick Pen”任务为例:

-

高度泛化成功率从 0 → 0.98

-

水平泛化成功率从 0 → 0.58

同时进一步使用双广角腕部相机(Dual Wide-angle Wrist-Camera)设置:

-

高度泛化成功率从 0.87 → 0.98

-

水平泛化成功率从 0.27 → 0.58

2. 复杂任务的水平泛化

-

Fold Shirt:由于布料可变形,折叠操作具有挑战性。 -

Fetch Bottle(全身动作):难度更高,因为机器人的躯干运动不可直接观测。 -

由于硬件限制,这两个任务无法安装双广角腕部相机,因此高度泛化评估不适用。 -

即便在这些复杂任务中,State-free Policies 仍显示出显著增强的空间泛化能力。 -

对于场景较简单、任务相关物体较少的任务,普通腕部相机设置仍能提供充分的任务观测(full task observation)。

3. 不同状态表示的空间泛化性

-

评估均采用双广角腕部相机设置。 -

只有相对 EEF 动作空间在域内与空间泛化任务中均表现最佳,其余动作空间在空间泛化上几乎完全失败。 -

表明相对 EEF 动作空间对 State-free Policies 的泛化能力至关重要。

4. 不同相机设置的表现

-

随着视野扩展,State-free Policies 的空间泛化能力逐渐提高。 -

有趣的是,即便没有顶视相机,仅使用双广角腕部相机却实现了最佳的空间泛化,说明在当前任务中,双广角腕部相机已经提供了完整的任务观测;顶视相机不仅非必要,甚至可能产生干扰。

5. 不同策略架构上是否同样有效?

-

除 π0 外,还评估了其他策略架构(ACT 和 Diffusion Policy),均在双广角腕部相机设置下进行。 -

结果一致:无状态策略在空间泛化上显著优于含状态策略。 -

说明 State-free Policies 的有效性独立于具体策略实现,具有普适性和广泛应用价值。

6. State-free Policies 的进一步优势

A. 更高的数据效率

-

在“Pick Pen”任务中(双广角腕部相机设置),分别使用 300、200、100 和 50 条微调示范轨迹,进行 2 和 4 个微调 epoch 的训练。

-

实验结果显示:减少数据会导致含状态策略过拟合并失效,而无状态策略依然保持较高成功率。

B. 更好的跨本体适应性

对于含状态策略,跨机体微调需要对齐新的状态空间,即便是基于 EEF(末端执行器)状态,也可能因为不同机体的参考坐标系差异产生偏差。

无状态策略避免了这个问题:只需处理相似相机设置下的微小图像变化,从而实现更高效的跨机体微调。

-

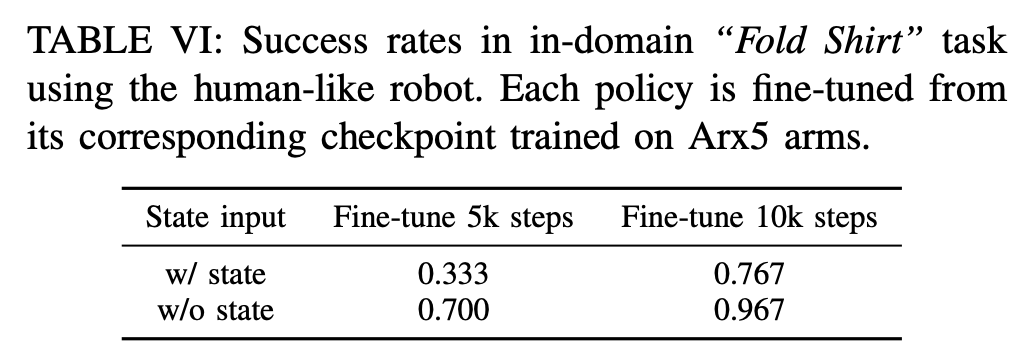

在“Fold Shirt”任务中(域内设置),策略先在双臂 Arx5 机器人上训练(EEF 空间在桌面坐标系下),然后迁移到类人双臂机器人(EEF 空间在机器人坐标系下)。

-

收集 100 条类人机器人折叠衣服示范数据,并使用含状态和无状态策略分别从 Arx5 checkpoint 初始化进行微调。

-

结果显示,无状态策略在跨机体适应中收敛更快,并且在相同微调 epoch 下获得显著更高的成功率,表明其跨本体适应能力优于含状态策略。

7. 重新思考顶视相机

在移除限制空间泛化的状态输入之后,顶视相机可能成为了一个性能瓶颈。

-

问题来源:任务中对象位置的变化会导致顶视相机图像分布发生偏移,在极端情况(如 100 cm 高的桌子)下甚至会显著降低策略表现。 -

对比观察:由于末端执行器会随着任务相关对象移动,腕部相机仍能捕捉到与训练一致的观察,避免了域外问题。 -

推测结论:考虑到双广角腕部相机已经提供了完整的任务观察,顶视相机不仅可能是冗余的,甚至可能对策略产生负面影响。

实验验证:在“Pick Pen”任务下设计更具挑战性的场景进行验证。

-

实验设置:将桌子高度提升到 100 cm;将笔筒高度提升一倍,改变其与桌面的相对高度;将笔筒位置在水平面上偏移 20 cm。

实验结果:

-

使用顶视相机的无状态策略在这三种挑战场景下表现极差; -

去掉顶视相机后,策略的成功率保持稳定且较高,证明双广角腕部相机即可提供完整任务观察,而顶视相机反而带来了有害的分布偏移。

启示:这一发现促使我们重新思考传感器设计,在未来的视觉运动策略中,可能完全不需要顶视相机。

8. 不同优化策略下的表现

我们可以看到带状态的输入本身限制了空间泛化能力,即使使用一系列优化策略也无济于事。

9. 域内评估(真机)

即使移除状态输入,策略在域内任务上仍能保持可比的性能,因为视觉观测分布与训练保持一致。

仿真世界操作任务

仿真域内评估(LIBERO 基准)

在仿真环境中,受限的相机视角下,无状态策略在域内任务表现与状态策略相当,甚至在部分任务上更优,显示了其强大的实用性。

总结

核心思想:无状态策略(State-free Policies)。

两个关键条件:

-

相对末端执行器(EEF)动作空间 -

完整任务观察,提供充分的视觉信息

主要特性:

-

超强空间泛化性:在移除状态输入的情况下,这类策略在域内任务中依然保持完美表现,同时在空间泛化能力上取得显著提升; -

降低数据需求:减少昂贵的真实环境数据收集成本; -

高效跨平台适应:能够更快速地在不同机器人形态间迁移; -

传感器设计启发:为未来的视觉运动策略提供新方向,例如可能无需顶视相机。

局限性:

-

对背景敏感:纯视觉策略可能对背景变化敏感,例如移动机器人或桌子位置,可能需要额外微调以恢复性能; -

双臂设置问题:在只使用一只手臂执行任务时,未使用手臂的视觉输入分布变化可能偶尔导致其产生意外动作。