点击下方卡片,关注“具身智能之心”公众号

作者丨Andy Yun等

编辑丨具身智能之心

本文只做学术分享,如有侵权,联系删文

更多干货,欢迎加入国内首个具身智能全栈学习社区:具身智能之心知识星球(戳我),这里包含所有你想要的。

出发点&研究背景

大语言模型(LLMs)在机器人程序规划中展现出潜力,其广泛的预训练和强大的指令遵循能力,能生成从人类视角看来合理连贯的分步动作序列。但因训练数据基于人类语言和偏好,生成的计划更贴合人类直觉,常省略机器人执行所需的精确感官或感知细节,缺乏物理世界执行必需的低层次、空间接地细节,应用于机器人时可能导致下游任务出错。

视觉语言模型(VLMs)为生成更具感知接地性的计划提供了可能,但现有方法存在局限:要么依赖仿真环境中过度专门化的设置,现实适用性有限;要么依赖大规模、高容量模型,训练成本高且在许多现实场景中部署不切实际。而教育、机器人技术和资源受限环境等场景,需要轻量级、数据高效且稳健的解决方案,无需依赖大量计算。研究认为,若训练得当,小型VLMs也能展现出强大的视觉规划能力。

核心方法

核心框架:SelfReVision

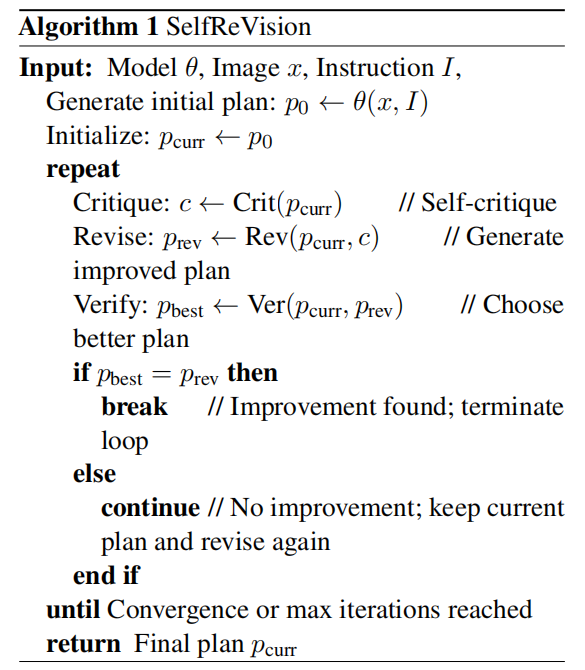

提出SelfReVision,一种基于迭代自我批判和自我改进的视觉语言程序规划自我提升框架。该框架让3B到72B规模的小型VLMs通过自我蒸馏提升性能,无需外部监督或教师模型。灵感源自思维链推理和自我指导方法,将任务拆分为三阶段循环:模型先根据提示和图像生成初始计划,然后在最小指导下自我批判,据此修订计划,最后通过自我验证步骤选择更优方案。这一循环重复直至生成满意计划,最终计划可直接用于推理或作为自监督数据进一步微调模型。

自蒸馏与三阶段流程

基于自蒸馏原则,模型通过学习自身输出来改进,无需更强的教师模型。设基础模型为,自蒸馏数据集(D)定义为:其中是输入提示,是指令或任务描述,是模型自身的初始计划输出,转换函数通过有针对性的批判和修订过程优化输出。

三阶段流程具体为:

批判(Crit):模型生成初始计划,可能存在模糊、与图像无关或不完整等问题,随后提示模型生成批判性自我评估。 修订(Rev):利用自我生成的批判,模型生成修订后的计划,通过思维链提示将复杂修订拆分为可管理的子目标,鼓励局部、有意义的改进。 验证(Ver):模型评估和,确定更优方案。若修订计划更优,过程终止;否则递归继续,直至生成更优计划。

该迭代循环在algorithm 1中形式化,可按设定的优化轮次运行,也可生成一定数量的最终计划用于与基线或彼此比较,类似人类自我提升过程:发现缺陷、尝试修订、批判性评估结果。

推理与微调的权衡

SelfReVision通过自我蒸馏生成精选输出,有两种应用方式:直接用于推理,无需模型更新,部署快速,但可能增加计算开销或编排复杂度;作为微调训练数据,将改进直接融入模型,推理更快、泛化更好,但需额外训练时间和资源。选择需权衡灵活性、性能和可扩展性。

实验与结果

实验设置

进行两类实验评估SelfReVision的规划能力:基于图像的程序规划和实体代理任务。

评估数据集:

真实世界场景:从PLACES Dataset选取100个图像和用户输入对作为测试集,用户输入由GPT-4o生成。 仿真场景:使用修改后的MFE-ETP数据集,含100个来自VirtualHome和BEHAVIOR-100的图像和用户提示对,必要时调整用户输入以适配单张图像。

评估指标:在现有评估维度(Coverage、Ordering、Completeness、Overall Quality)基础上,新增Image Groundedness评估计划与视觉上下文的契合度。采用GPT-4o作为自动评估器,经验证,30个样本上GPT-4o判断与人类标注者的平均一致性为0.52,与人类间平均一致性相当。主要评估指标为胜率,即修订计划(或模型输出)优于基础模型计划的样本百分比。

基线对比:与模型使用少样本提示生成的初始计划、GPT-4o(代表强大大型模型)、PaliGemma(为规划训练的领域特定模型)、best-of-N(生成多个输出并选择最优的推理时算法)进行对比。

主要结果

相较基线的提升:table 1显示,在所有模型规模和两个数据集上,SelfReVision始终大幅优于初始计划,PLACES数据集平均胜率68%,SIMULATION数据集72%,在完整性和覆盖度上提升最显著,常超过80%。更大模型从SelfReVision中获益更多,12B以上模型整体增益平均74%,12B及以下模型68%。

与其他方法的对比:相较Best-of-N和PaliGemma,SelfReVision优势明显。Best-of-N对小型模型仅带来8%-38%的适度改进,而SelfReVision在多数设置中提升60%;PaliGemma虽为强大的预训练VLM,但在该领域表现不佳,两个数据集上超过90%的对决中落败,可能缺乏接地多步规划所需的程序推理能力。

与GPT-4o的对比:table 2显示,对于12B参数及以上的模型,SelfReVision生成的计划胜率比GPT-4o至少高25%,表明自我批判、自我修订策略能让更小模型超越大模型。

优化轮次的权衡:随着自我优化循环中修订轮次增加,PLACES数据集整体胜率从75%升至81%,SIMULATION数据集从78%升至81%。但不同指标表现有差异,Coverage和Completeness稳步提升,Ordering和Image-Groundedness略有下降,表明后期轮次可能引入推测性或与视觉关联较弱的内容。多数改进出现在前2-3轮,少数迭代即可在不牺牲清晰度的情况下取得良好结果。

流程步骤的消融实验:table 3显示,完整的CRV(Criticize-Revise-Verify)流程性能最强,PLACES数据集平均胜率提升68.3%,SIMULATION数据集71.9%。CR变体在消融配置中表现最佳,但相较完整CRV仍有显著性能下降(PLACES数据集-9.3%,SIMULATION数据集-7.8%),部分情况下修订计划在Ordering和Image Groundedness上甚至不如初始计划。这表明Verify步骤在过滤次优修订(尤其破坏正确顺序或与视觉上下文不一致的修订)中至关重要,各阶段在计划优化中作用独特且互补。

实体代理任务应用

为研究SelfReVision在实体场景中改进规划的能力,构建两个挑战性场景:由code-as-policies控制的仿真拾取放置环境,以及基于HAMSTER路径预测的真实世界规划环境,评估限于基线程序规划表现最佳的Gemma 12B和27B模型。

评估数据集:仿真拾取放置环境中,14个语义独特的操作目标与8种初始积木配置组合,共112个样本;真实世界场景中,厨房、车间、办公室三个环境下设计10个真实场景,各涉及一个高级任务。

评估指标:仿真拾取放置环境中,通过code-as-policies模拟器运行每个计划,由人类评估员判断最终配置是否达成目标;真实世界场景中,生成每个计划步骤的轨迹,由人类评估员判断每个步骤是否成功完成。

结果:table 4显示,SelfReVision增强的计划在积木操作任务上表现优于基础模型计划,Gemma 12B提升26%,Gemma 27B提升17%,在复杂任务中改进显著。层次任务中,SelfReVision计划使HAMSTER动作模型生成的成功轨迹达70%,高于基础模型计划的61%,通过新增必要步骤和移除错误步骤提升计划精度,增强任务执行可靠性。

局限

推理成本增加:与单向前向传播生成完整计划的SFT方法不同,SelfReVision需多轮迭代优化,平均每个样本约8个推理步骤,可能对延迟敏感或实时应用构成挑战。 依赖模型自我识别错误:自我提升策略假设模型能在训练中识别并纠正自身规划错误,但若模型内部奖励信号或批判机制存在缺陷,可能强化错误行为或过度拟合表面规划启发式,虽测试模型均有改进,但更弱的模型可能无法受益。 模态局限:目前仅纳入视觉输入,未整合机器人本体感受、触觉反馈等其他潜在有用模态,单模态设计限制了在多模态现实场景中的适应性,未来可探索在自我批判循环中整合更多信息。

参考

[1]Making VLMs More Robot-Friendly: Self-Critical Distillation of Low-Level Procedural Reasoning