点击下方卡片,关注「3D视觉工坊」公众号

选择星标,干货第一时间送达

来源:3D视觉工坊

「3D视觉从入门到精通」知识星球(点开有惊喜) !星球内新增20多门3D视觉系统课程、入门环境配置教程、多场顶会直播、顶会论文最新解读、3D视觉算法源码、求职招聘等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

0. 论文信息

标题:S^2M^2: Scalable Stereo Matching Model for Reliable Depth Estimation

作者:Junhong Min, Youngpil Jeon, Jimin Kim, Minyong Choi

机构: Samsung Electronics

原文链接:https://arxiv.org/abs/2507.13229

1. 导读

追求一种具有泛化能力的立体匹配模型,使其能够在不同分辨率和视差范围内执行任务而无需针对特定数据集进行微调,这一目标揭示了一个根本性的权衡。迭代式局部搜索方法在受限基准测试中能取得高分,但其核心机制本质上限制了实现真正泛化所需的全局一致性。另一方面,全局匹配架构虽然在理论上更具鲁棒性,但历史上因计算和内存成本过高而不可行。我们通过以下方法解决了这一困境:一种全局匹配架构,在不依赖代价体滤波或深度精化堆叠的情况下,同时实现了最先进的精度和高效率。我们的设计整合了一个多分辨率Transformer以实现鲁棒的长程对应,并通过一种新型损失函数进行训练,该函数将概率集中在可行匹配上。这种方法实现了对视差、遮挡和置信度的更鲁棒的联合估计。在Middlebury v3和ETH3D基准测试中,该方法建立了新的最优性能,在大多数指标上显著超越先前方法,同时以具有竞争力的效率重建高质量细节。

2. 效果展示

3D点云的定性比较:在精细结构中增强可靠性。3D点云可视化展示,比较我们的模型与最先进的方法在Middleburyv3测试集中一个具有挑战性的样本上的表现。我们的模型能够产生更可靠的重建结果,尤其是在像自行车辐条这样的精细结构上,并减少了边缘附近的过度平滑效应。

对两个代表性基准ETH3D和Middlebury v3进行全面评估。准确性使用Middlebury的Bad-2.0指标和ETH3D的Bad-0.5指标进行测量。每个方法都绘制了与其对应的参数大小。

3. 引言

深度学习的最新进展显著提升了立体匹配精度,使得在约束条件下能够实现高质量的深度估计。然而,在多样化环境和图像分辨率下确保可靠性能仍然具有挑战性。鲁棒的立体匹配模型应能在不同条件(如室内/室外、低/高纹理场景)下泛化,而无需针对特定数据集进行调优。这种对泛化能力的追求通常涉及增加模型容量以提高精度,但此类增益并不总是与规模成比例,因此需要精心设计的架构和训练策略。此外,更大的模型本身会带来更高的计算成本,需要在效率与强泛化能力之间取得平衡,尤其是在高分辨率情况下。

基于深度学习的立体匹配领域主要由两种主流架构范式之间的权衡所定义:全局匹配与迭代精化。基于Transformer的全局匹配架构[19,23,38,39,45]本质上适合建模长程对应关系以处理遮挡和重复模式。然而,由于它们存在显著的效率挑战且难以扩展(无论是处理高分辨率图像还是有效增加模型容量),历史上一直未被充分探索。这种可扩展性瓶颈导致了代价体迭代精化方法的主导地位,该方法在既有基准测试中表现出强劲性能。然而,这一范式面临两个根本性局限。首先,初始代价体的处理需要计算昂贵的滤波操作(如3D卷积),这严重阻碍了可扩展性。其次,后续的迭代精化过程本质上是局部的,难以解决复杂和非连续的视差结构,往往无法跳出局部最小值。推荐课程:扩散模型入门教程:数学原理、方法与应用。

为克服两种主流范式固有的局限,我们提出了可扩展立体匹配模型(S²M²),通过直接解决全局匹配方法众所周知的扩展性问题来重振该范式。S²M²引入了一种多分辨率Transformer架构,能够在不同尺度之间以及每个分辨率层级内实现鲁棒的特征交互,确保模型在高效扩展时学习的稳定性。此外,自适应特征融合机制选择性整合多分辨率信息,在保持全局一致性的同时保留精细细节。这些综合改进使S²M²能够在不同图像分辨率和场景复杂度下实现鲁棒的深度估计。

除架构外,我们还引入了一种专用损失函数,旨在引导概率集中在可行匹配上。通过显式鼓励网络将概率质量聚焦于有效候选,我们的模型不仅实现了更精确的视差预测,还直接从该分布中联合生成对应的置信度得分。这允许在模糊区域(如遮挡和无纹理表面)中对不确定预测进行鲁棒滤波,这对于安全关键应用的可靠性能至关重要。

我们的模型性能在具有挑战性的真实世界基准测试中得到了验证,并与最先进方法进行了全面比较。我们的方法在多样化真实世界数据集中展示了强劲的视觉和定量性能。尽管真实世界基准测试对于评估立体匹配不可或缺,但其本身存在局限,如视差范围受限或地面实况标注不完善(尤其在复杂或细结构区域)。为补充这一真实世界评估,我们还构建了一个高保真合成数据集,能够在受控条件下进行更彻底的评估,包括具有更大视差变化和精确定义地面实况的场景。通过在真实世界和合成基准测试中均取得最优结果,我们的工作首次确凿证明了精心设计的全局匹配架构在输入分辨率和模型容量方面均可扩展,克服了其长期存在的局限,实现了鲁棒且最优的性能。

4. 主要贡献

我们的关键贡献包括:

• 一种高度可扩展的全局匹配架构:一种在输入(高分辨率、大视差)和模型规模方面均可扩展的多分辨率Transformer架构。

• 准确可靠的深度估计:一种新型损失函数,在提升视差精度的同时,通过置信度和遮挡的联合估计确保最终深度可靠性。

• 新最优性能与严格验证框架:在既有真实世界基准测试中取得最优性能,并构建新型合成数据集以验证现有基准未覆盖场景的鲁棒性。

5. 方法

我们提出的S²M²模型旨在通过解决全局匹配范式长期存在的扩展性挑战来重振该范式。为此,我们的架构由四个主要阶段组成(如图3所示):(1)特征提取器,利用多分辨率架构生成单一强特征图;(2)全局匹配模块,使用最优传输[8]建立鲁棒的长程对应;(3)混合精化阶段,全局和局部纠正误差;(4)最终上采样过程,在恢复全分辨率的同时保留细节。

6. 实验结果

7. 总结 & 未来工作

本文提出了一种名为S²M²的多分辨率Transformer框架,解决了长期以来全局匹配的难题,使其成为一种实用且最先进的方法。该提出的框架高度可扩展,能够稳健地处理高分辨率和大视差范围的挑战,同时其性能随着模型大小的增加而一致提升。通过联合建模视差、置信度和遮挡,它能产生可靠的深度估计。我们的大量实验不仅在现实世界的基准测试中建立了新的最先进水平,还展示了该框架在苛刻场景中的鲁棒性,从而为开发高精度和通用的立体视觉系统开辟了新途径。

对更多实验结果和文章细节感兴趣的读者,可以阅读一下论文原文~

3D视觉硬件,官网:www.3dcver.com

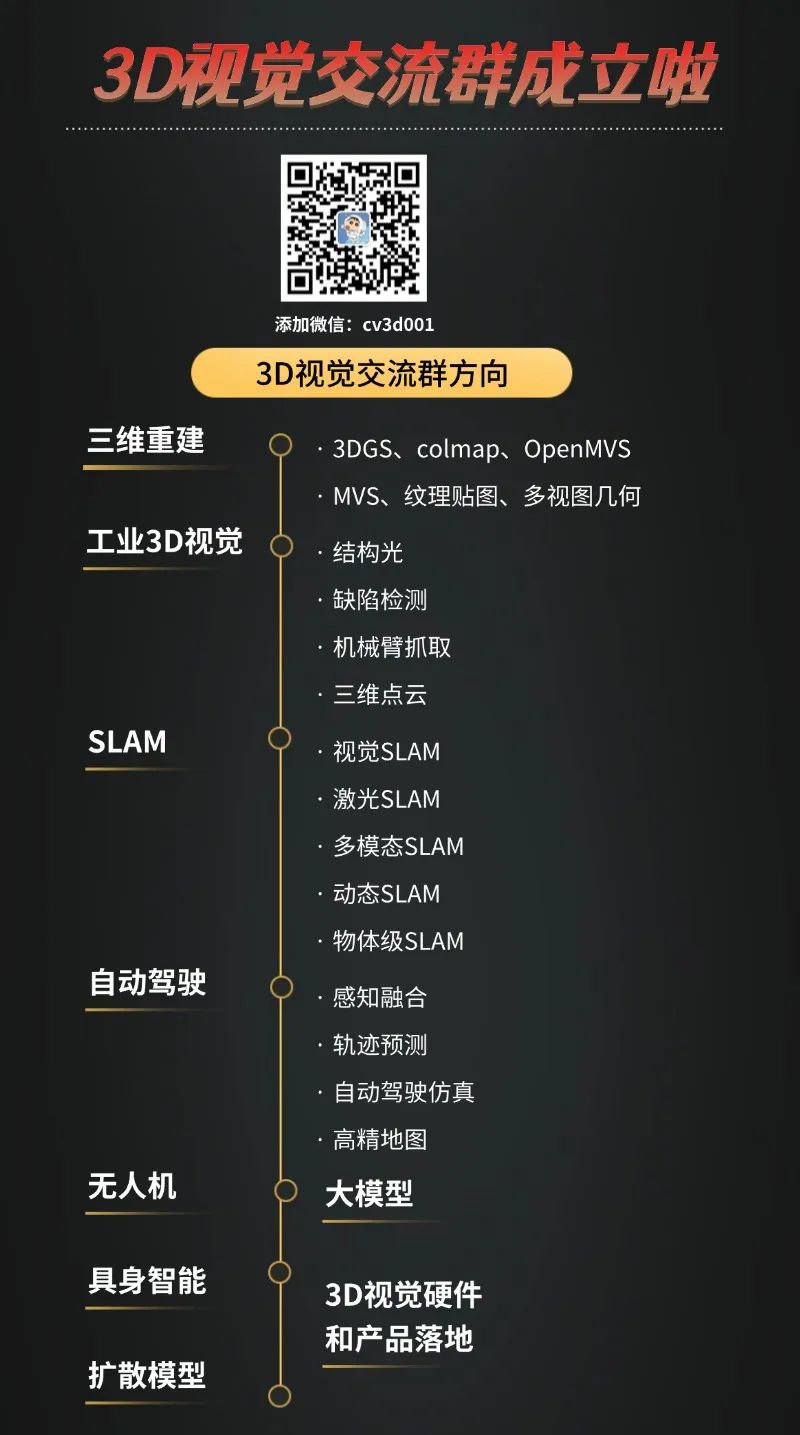

3D视觉学习圈子

「3D视觉从入门到精通」知识星球(点开有惊喜) !星球内新增20多门3D视觉系统课程、入门环境配置教程、多场顶会直播、顶会论文最新解读、3D视觉算法源码、求职招聘等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

3D视觉全栈学习课程:www.3dcver.com

3D视觉交流群成立啦,微信:cv3d001