如您有工作需要分享,欢迎联系:aigc_to_future

Gemini 2.5: Pushing the Frontier with Advanced Reasoning, Multimodality, Long Context, and Next Generation Agentic Capabilities

Gemini 2.5 Pro:最强思考模型

Gemini 2.5 Flash:混和推理模型

Gemini 2.0 Flash:经济高效的非思考模型

Gemini 2.0 Flash-Lite:快速低成本小模型

Gemini 2.5是MOE模型,Gemini 2.5视觉处理的架构变化还带来了图像和视频理解能力的显著提高,包括能够处理3小时长的视频,以及能够将演示视频转换为交互式编码应用程序。Gemini 2.5系列中的较小型号从大模型蒸馏而来(Qwen系列和Llama系列也是,目前这是主流方法,蒸馏的小模型性能均比直接训练要高)。

为了减少蒸馏成本,使用词汇表上的k稀疏分布来近似它,尽管这仍然会将训练数据吞吐量和存储需求提高k倍,但可以大幅降低计算量、存储空间和通信数据量。(缺点是训练过程会不稳定,loss变大)

# 标准蒸馏损失函数def distillation_loss(student_logits, teacher_logits, labels, temperature=2.0, alpha=0.5):soft_target_loss = nn.KLDivLoss(reduction='batchmean')(F.log_softmax(student_logits / temperature, dim=1),F.softmax(teacher_logits / temperature, dim=1)) * (temperature ** 2)hard_target_loss = F.cross_entropy(student_logits, labels)return alpha * soft_target_loss + (1 - alpha) * hard_target_loss# k稀疏蒸馏损失函数def k_sparse_distillation_loss(student_logits, teacher_logits, labels, k=3, temperature=2.0, alpha=0.5):# 1. 对教师模型输出进行top-k稀疏化batch_size, num_classes = teacher_logits.shapesparse_teacher_probs = torch.zeros_like(teacher_logits)# 计算softmax概率teacher_probs = F.softmax(teacher_logits / temperature, dim=1)# 获取top-k的索引topk_values, topk_indices = torch.topk(teacher_probs, k, dim=1)# 只保留top-k的概率值,其余置零for i in range(batch_size):sparse_teacher_probs[i, topk_indices[i]] = teacher_probs[i, topk_indices[i]]# 归一化稀疏概率分布sparse_teacher_probs /= sparse_teacher_probs.sum(dim=1, keepdim=True)# 2. 计算稀疏分布上的蒸馏损失soft_target_loss = nn.KLDivLoss(reduction='batchmean')(F.log_softmax(student_logits / temperature, dim=1),sparse_teacher_probs) * (temperature ** 2)hard_target_loss = F.cross_entropy(student_logits, labels)return alpha * soft_target_loss + (1 - alpha) * hard_target_loss

从速度上看,Gemini系列的速度远超openai和claude等其他模型。

Voxtral(音频LLM)

发布了Voxtral Mini 和 Voxtral Small两款语音大模型。

模型详解

音频编码器处理语音输入,独立处理 30 秒的音频片段。音频嵌入在输出端连接,并在音频语言适配器中进行 4 倍下采样。多模态 LLM 解码器根据音频和文本输入,自回归地预测文本标记。

音频编码器基于 Whisper large-v3,原始音频波形首先被映射到对数梅尔频谱图,该频谱图具有 128 个梅尔箱和 160 个hop-length。在 Whisper 编码器中,频谱图经过卷积主干,将其时间分辨率下采样两倍,然后被输入到一系列双向自注意力层中。最终生成的音频嵌入帧率为 50 Hz。Whisper 的感受野固定为 30 秒。

为了适应超过此时长的音频序列,计算了整段音频的对数梅尔声谱图,但限制编码器独立处理每个 30 秒的片段。每个片段的绝对位置编码都会重置,同一音频的片段会被划分到批次轴上。

在编码器的注意力层中,这种方法在功能上等同于逐块注意力机制。后者减轻了较长音频输入的计算开销,并增强了长度泛化能力。从每个片段计算出的嵌入在输出阶段连接起来,形成完整音频序列的统一表示。

# 计算音频总长度(秒)audio_length = len(audio) / sampling_rate# Whisper编码器的参数hop_length = 160 # 10ms @ 16kHztime_downsample_factor = 2 # 卷积层下采样因子frame_rate = sampling_rate / (hop_length * time_downsample_factor) # 50Hzsegment_length = 30 # 秒segment_frames = int(segment_length * frame_rate) # 每个片段的帧数 1500# 检查是否需要分段处理if audio_length <= segment_length:# 短音频直接处理inputs = processor(audio, sampling_rate=sampling_rate, return_tensors="pt")with torch.no_grad():encoder_outputs = model.encoder(inputs.input_features)return encoder_outputs.last_hidden_state音频编码器的高帧率会导致语言解码器的序列

音频编码器的高帧率会导致语言解码器的序列长度过长。例如,一段 30min、50Hz 的音频,其序列长度为 9 万个token,这会导致内存占用高且推理速度慢。需要在音频编码器输出端附加了一个 MLP 层,负责对音频嵌入进行下采样。4 倍的下采样因子在序列长度和性能之间取得最佳平衡。

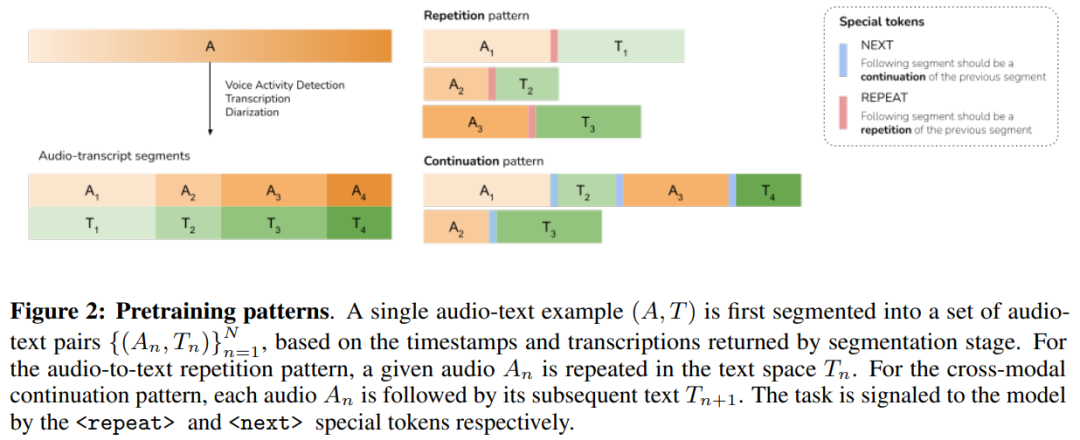

训练过程:

预训练阶段会冻结LLM和Audio Encoder,只训练MLP适配器。

利用语音+转录文本用于训练ASR功能。

利用 (A_1,T_2,A_3,T_4,…,A_{N−1},T_N) ,类似QA和问答,训练文本延续性(只训练文本输出)。

SFT阶段,会收集长语音和转录文本,将转录文本和数据提示输入LLM生成指定的数据(比如QA、翻译)。最终得到Audio+Text->Text和Audio->Text两种数据类型。

RLHF阶段,使用Online-DPO,对于每个示例,从策略中采样两个温度为T=0.5的候选响应。获取整个对话,用其转录替换音频,并利用基于文本的奖励模型。

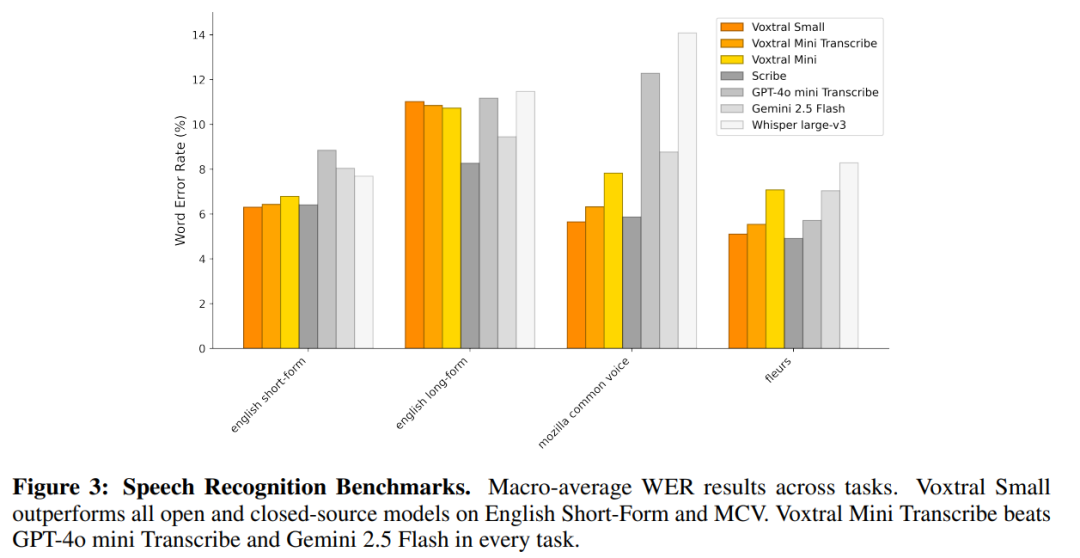

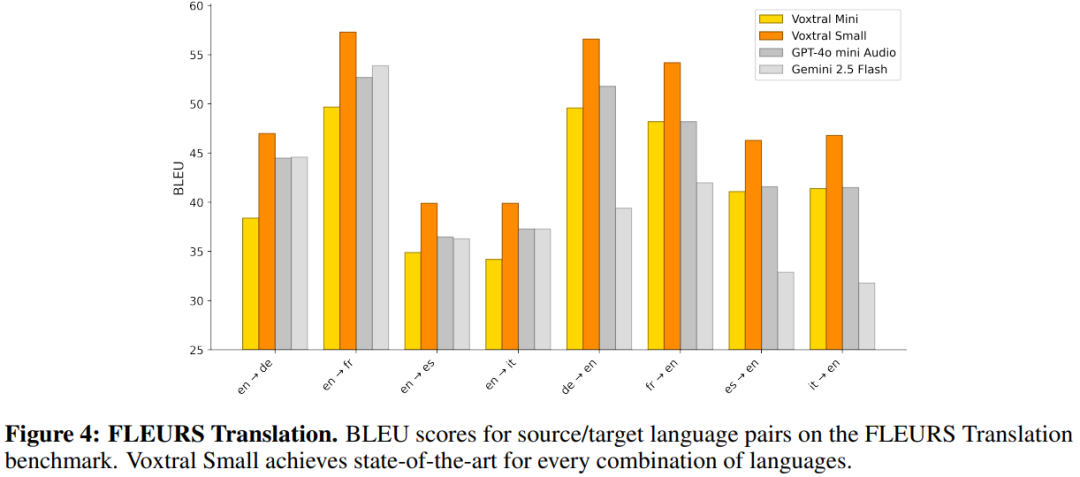

评测结果如下:

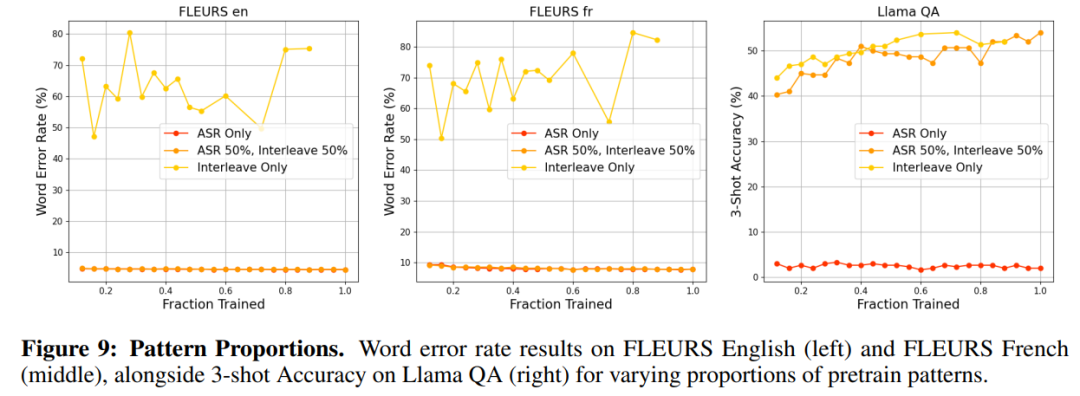

消融实验

pad or no pad

Whisper 将短音频填充至 30 秒。

禁用填充几乎不会对 FLEURS 英语造成任何惩罚,但法语的 WER 会降低 0.5%。最终还是选择了pad。

MLP的下采样倍数

基准音频编码器的运行帧率为 50 Hz。为了减少解码器的计算量和内存占用,插入了一个 MLP 适配器层,用于沿时间轴对音频嵌入进行下采样。分别以 50、25(下采样2倍)、12.5(4倍) 和 6.25 Hz(8倍) 的目标帧率进行实验。

对于 25 Hz 和 12.5 Hz,ASR 基准测试中几乎没有下降。然而,对于 6.25 Hz,FLUERS 法语的损失超过 1%。

预训练数据模式选择

仅包含音频转文本重复模式可获得出色的 ASR 性能,但 Llama QA 的性能几乎为零。相反,仅使用跨模态延续模式进行训练可获得出色的 Llama QA 性能,但 ASR 的字错误率 (WER) 接近 60%。最终选择1:1的数据配比。

DPO and Online DPO

可以看出Online-DPO > DPO > 原SFT模型。

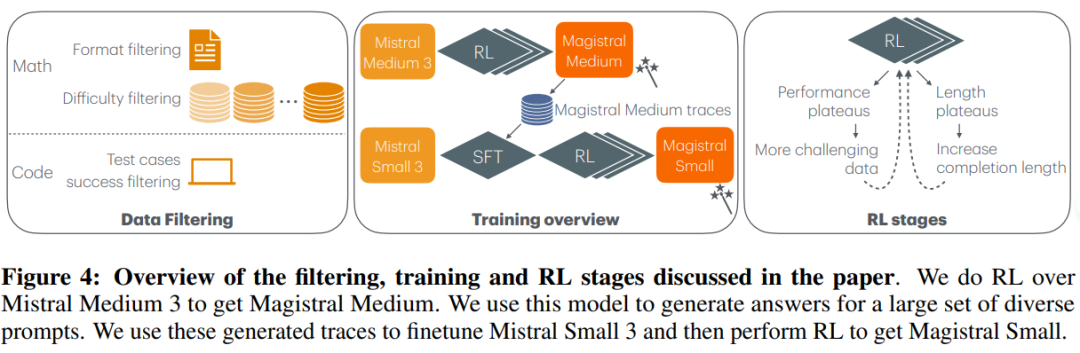

Magistral

推出了Magistral Small(基于Mistral Small 3) 和 Magistral Medium(Mistral Medium 3)得到的推理模型。

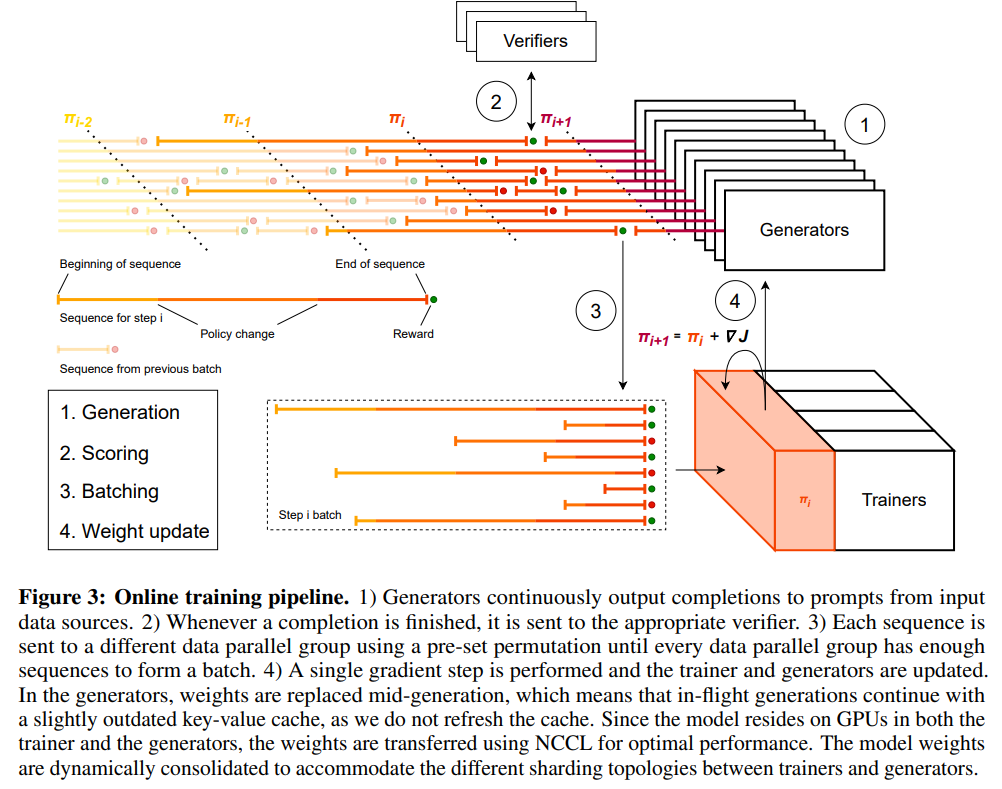

GRPO训练

消除 KL 散度。

KL散度惩罚限制了在线策略与参考策略的偏差,从而有助于保持与初始模型的一致性。然而,在 GRPO 中,无论如何,策略都会发生显著偏差,并且维护参考模型的副本进行 KL 计算会产生我们认为不合理的计算成本。因此彻底消除了 KL 惩罚。

损失归一化。

为了避免引入同一组中各代之间的长度偏差,首先对所有标记和所有代的标记损失进行添加,然后除以组 \sum_{i=1}^{G}{|oi|} 中各代的总长度,以此对损失进行归一化。

优势归一化。

简单地将每个 token 的优势估计为 A^i,t=A^i=r_i−μ ,其中μ是组内奖励的平均值。另外将每个小批量中的优势归一化为 A_{i,t}^{norm}=(A^i−A^{mean})/A^{std}

放宽置信域的上限。

采用Clip-Higher策略来解决熵崩溃问题。在标准 GRPO 中,ε-clipping 通过限制低概率 token 概率的增长来限制探索,从而阻碍了罕见但重要的推理路径的强化。通过将上限阈值提高到εhigh,低概率 token 拥有更大的增长空间,从而增强输出的熵和多样性,并改进推理探索。

剔除非多样性组。

所有世代要么完全正确,要么完全错误,这些组的优势为零,因此对批次损失没有任何贡献。这会导致梯度减小,同时噪声敏感度增加。为了解决这个问题,在形成训练批次时滤除所有优势为零的组。

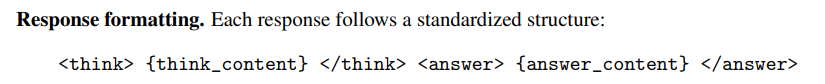

格式奖励

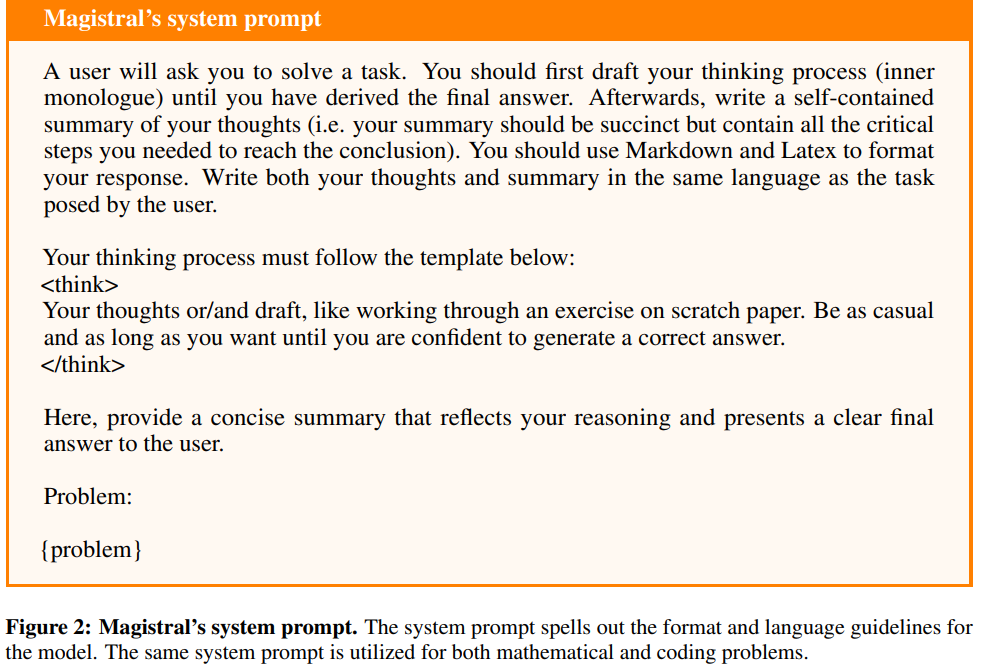

模型响应必须以<think>标签,并且必须包含相应的</think>标签。(ii)响应中应该只有一组这样的标签。

对于数学输出,答案必须包含答案部分中用 \boxed{} 括起来的最终答案,紧接着</think>标签。

对于代码输出,响应必须在答案部分至少包含一个 markdown 块,格式为三重反引号,后跟编程语言规范。

如果不符合上述任何条件,则奖励为 0,并且该答案将不再进行评分。否则,该答案将获得 0.1 的奖励并继续进行评分。

答案奖励

数学最终答案从解决方案中最后一个\boxed{}内提取,如果答案正确,则额外奖励 0.9,使总奖励为 1.0。

代码是从答案部分的第一个 markdown 代码块中提取的。从可用的测试用例中随机选择 20 个测试用例,确保在给定的响应组中使用相同的测试用例。然后针对这些测试用例执行代码,每个测试用例的超时时间为 4 秒,内存限制为 300MB。如果代码成功通过所有测试用例,则额外获得 0.9 的奖励。

使用软长度惩罚来指示模型最大完成长度的硬截止值已接近。我们固定两个长度lmax和lcache,并计算长度惩罚如下:

语言一致性奖励:将10%用英语写成的问题翻译成其他语言,用 fastText 分类器判断语言格式一致性,额外奖励0.1。

数据清洗和训练

对数据进行了全面的预处理和过滤,以确保所有问题完整,最终答案准确且可通过基于规则的系统进行验证。特别地,过滤了难以验证正确性的基于证明和多部分的问题。此外,将多项选择题重新表述为基于语句的问题,以提高验证的鲁棒性并增加难度。

使用 Mistral Large 2进行了初始难度评估,为每个问题采样16个解决方案,并移除那些从未解决或成功率较高的解决方案。然后利用这组初始的、精心挑选的问题,通过在线强化学习流程训练一个 24B 模型,最终生成一个规模虽小但功能强大的检查点,仅将其用于评分。(这个评分比直接使用Mistral Large 2的评分效果更好)

用这个更强大的强化学习训练模型重新评估整个原始数据集。再次为每个问题采样 16 个答案,过滤掉最简单和尚未解决的问题。然后进一步过滤掉那些可能不正确的问题,即大多数样本的最终答案相同,但与“真实答案”不一致的问题。当模型持续得出与参考答案相矛盾的共识时,问题本身更有可能包含错误的“真实答案”。

从各种来源收集了代码竞赛数据。每个数据点都包含一个问题陈述,以及(如果可用)正确的解决方案和相关测试。首先会剔除所有没有解决方案且测试不足的问题。然后会在所有可用的测试中执行每个解决方案,并丢弃一致性不足的测试。对于一致性足够但没有解决方案成功的测试,会假设该测试不正确,并更新它以反映解决方案输出中最常见的结果。最终生成了一个包含 3.5 万个代码问题的数据集。

在系统提示中指定了格式和语言要求,发现强化学习训练对所使用的系统提示非常敏感。例如,系统提示中的“尽可能随意,想说多久就说多久”部分会增加模型的熵,从而改善模型的探索能力。

详细训练过程如下

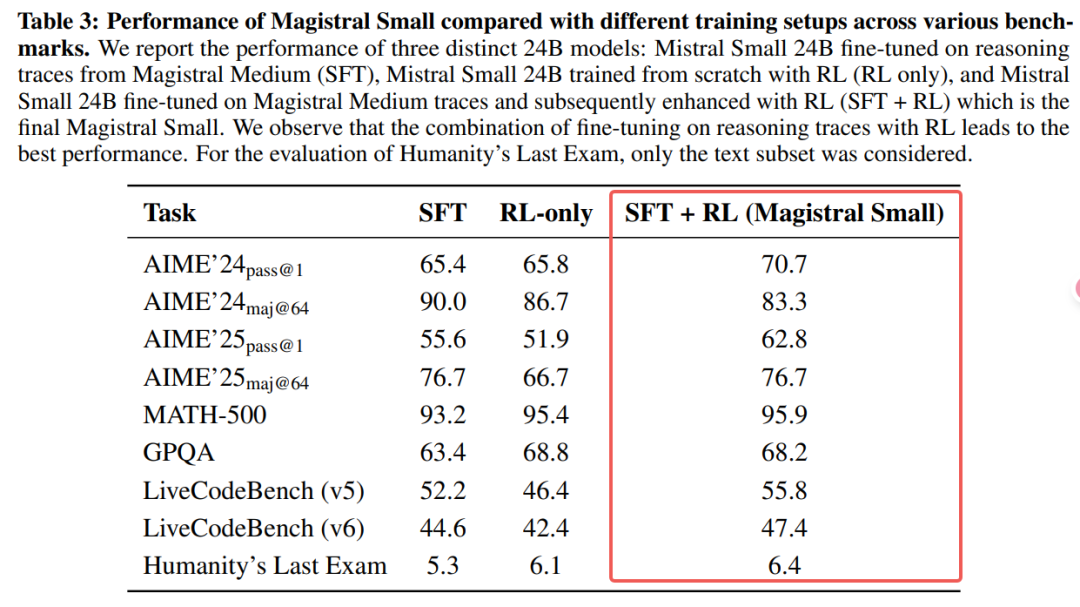

对比SFT/RL-only/SFT+Rl的效果,可以得到经过“冷启动”的RL效果最好。

数据消融

直接在小模型上RL也可以得到不错的效果,和之前的deepseek结论不一致。

MiMo

MiMo: Unlocking the Reasoning Potential of Language Model -- From Pretraining to Posttraining

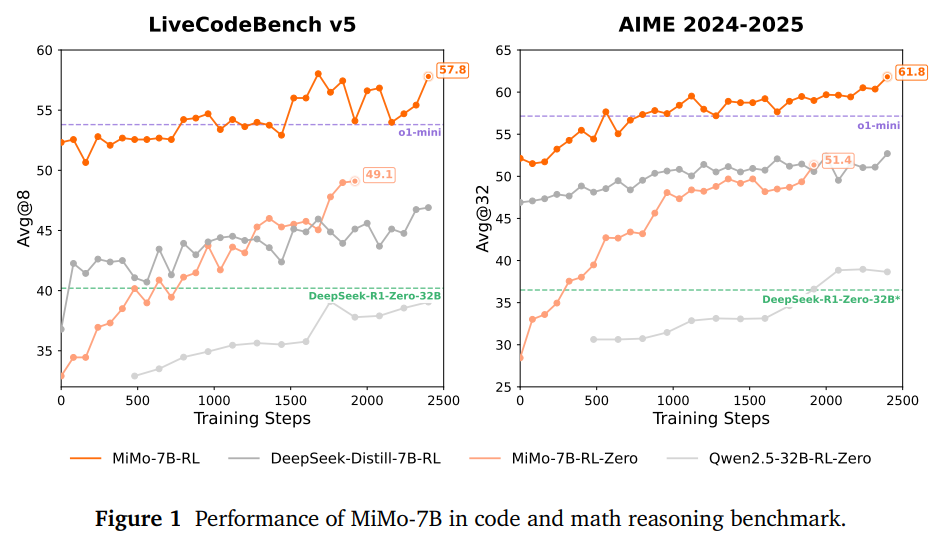

MiMo-7B-Base 已在 25 万亿个 token 上进行预训练,并附加了多 token 预测,以提升性能并加快推理速度。

在训练后阶段,整理了一个包含 13 万个可验证数学和编程问题的数据集,用于强化学习,并集成了测试难度驱动的代码奖励方案以缓解稀疏奖励问题,并采用策略性数据重采样来稳定训练。

预训练(Pre-Training)

数据预处理优化:开发了专门的HTML提取工具,优化了PDF解析工具,以更好地处理STEM和代码内容。

多维度数据过滤:使用微调的小型LLM作为数据质量标签器,进行领域分类和多维度质量评估。

合成推理数据:通过高级推理模型生成多样化的合成推理数据,包括STEM内容分析、数学和代码问题解决等。

三阶段数据混合策略:分三个阶段进行预训练,逐步增加数学和代码相关数据的比例,并在最终阶段引入合成响应数据,同时扩展上下文长度至32,768。

后训练(Post-Training)

1、监督微调(SFT):使用开源和专有数据的组合,经过三阶段预处理后进行微调。

2、强化学习(RL)数据整理:

数学数据:从多个来源收集数学问题集,使用LLM过滤掉基于证明和多项选择的问题,并进行全局n-gram去重和数据清洗。

代码数据:整理高质量的代码问题集,移除没有测试用例的问题,并使用SFT版本的MiMo-7B过滤掉容易的问题。

3、RL训练配方:

测试难度驱动的奖励:受国际信息学奥林匹克竞赛(IOI)评分规则启发,将测试用例按难度分组,并设计严格的奖励方案和软奖励方案。

易数据过滤和重采样:在训练过程中维护一个易数据池,以提高采样效率并稳定策略更新。

4、RL基础设施:

无缝Rollout引擎:通过连续Rollout、异步奖励计算和早期终止来优化GPU利用率,实现训练加速。

基于vLLM的推理引擎:扩展vLLM框架以支持MTP模块,并增强其鲁棒性。

MiMo-VL Technical Report

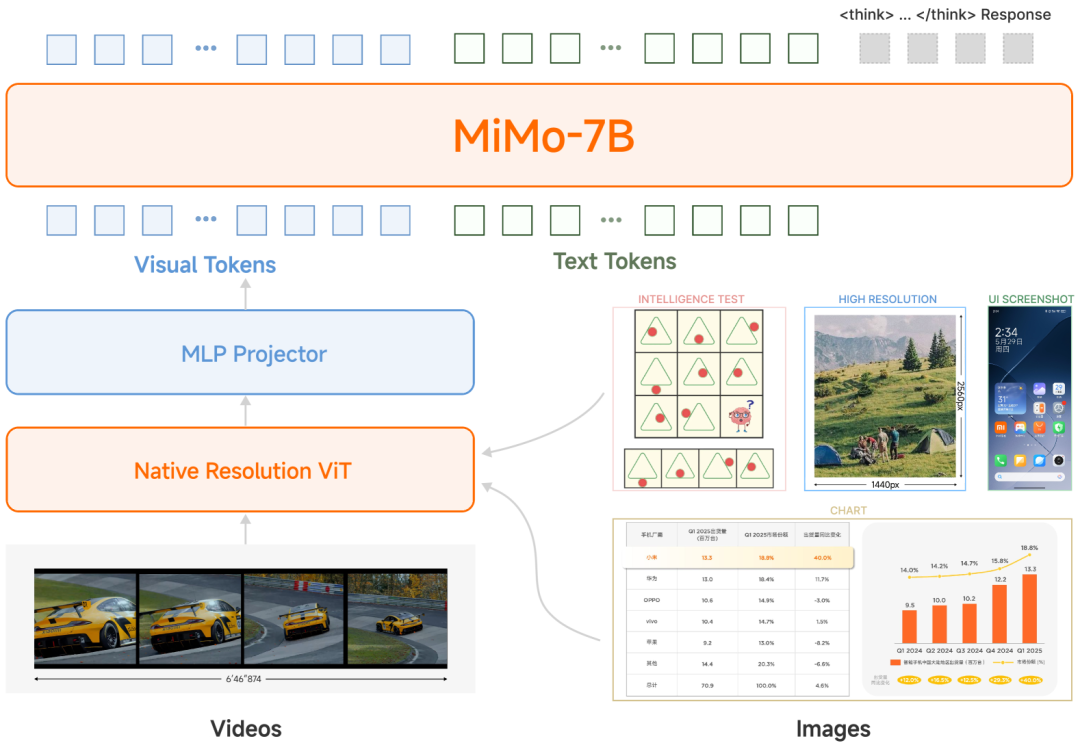

MiMo-VL-7B(MiMo-7B-Base+Qwen2.5-ViT),一个开源的视觉语言模型,旨在提升多模态AI系统在视觉理解和推理方面的能力。

四阶段预训练:

阶段一 (Projector Warmup):冻结ViT和LLM组件,仅对随机初始化的投影器 (projector) 进行预热训练,使用图像-标题对,使投影器能有效将视觉概念映射到语言模型的表示空间。

阶段二 (Vision-Language Alignment):解冻ViT组件,引入交错数据 (interleaved data),进一步加强视觉-语言对齐,提升ViT的性能和鲁棒性。

阶段三 (Multimodal Pre-training):所有参数均可训练,引入更多样化的数据和任务,包括OCR、接地、视频和GUI数据等,增强模型的通用多模态能力。

阶段四 (Long-context SFT):专注于提升模型对长文本输入的适应能力,延长训练序列长度,并引入长纯文本、高分辨率图像、长文档、扩展视频和长推理数据等。

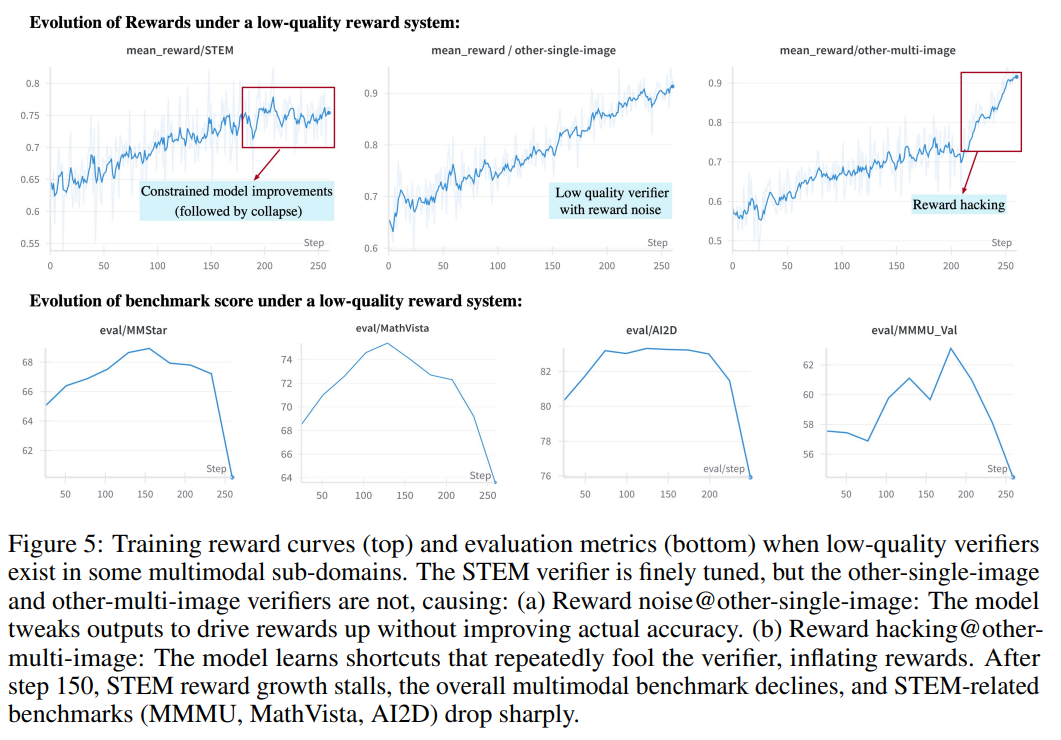

混合策略强化学习 (MORL):

强化学习与可验证奖励 (RLVR):依靠基于规则的奖励函数,设计了多种可验证推理和感知任务,涵盖视觉推理、文本推理、图像接地、视觉计数和时间视频接地等任务。

基于人类反馈的强化学习 (RLHF):收集多样化的查询,通过先进VLM对不同模型生成的响应进行成对排序,构建奖励模型训练数据集,并开发了适用于不同输入模态的专用奖励模型。

混合策略强化学习 (MORL):将RLVR和RLHF相结合,采用完全策略的GRPO变体作为RL算法,通过奖励即服务 (RaaS) 统一不同任务的奖励函数或专用奖励模型,实现对多种任务的同时优化。也做了移除 KL 损失、动态采样、简易数据过滤和重采样策略等多项措施。

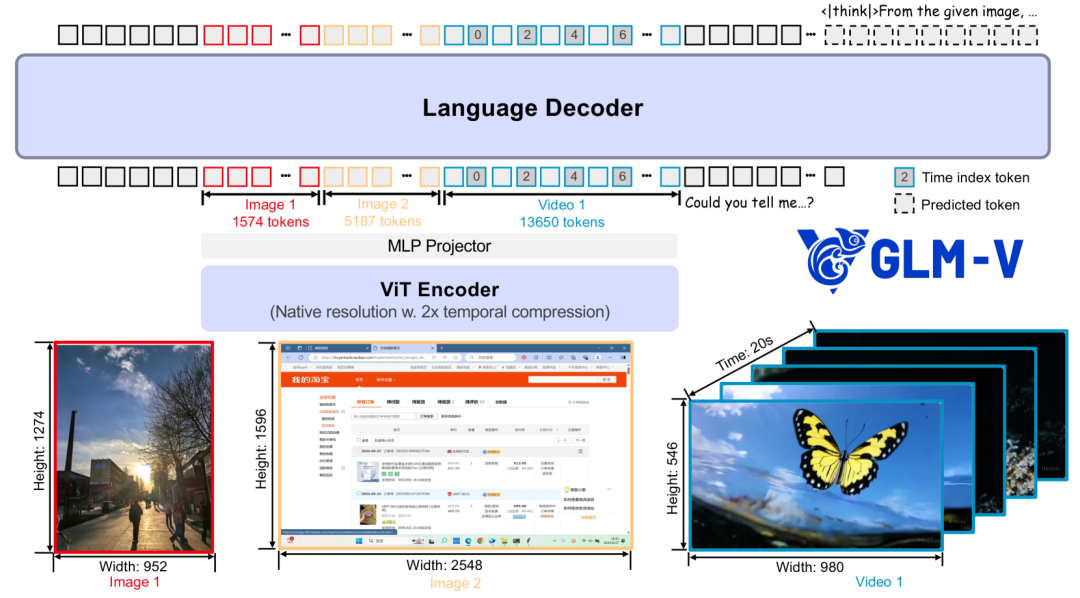

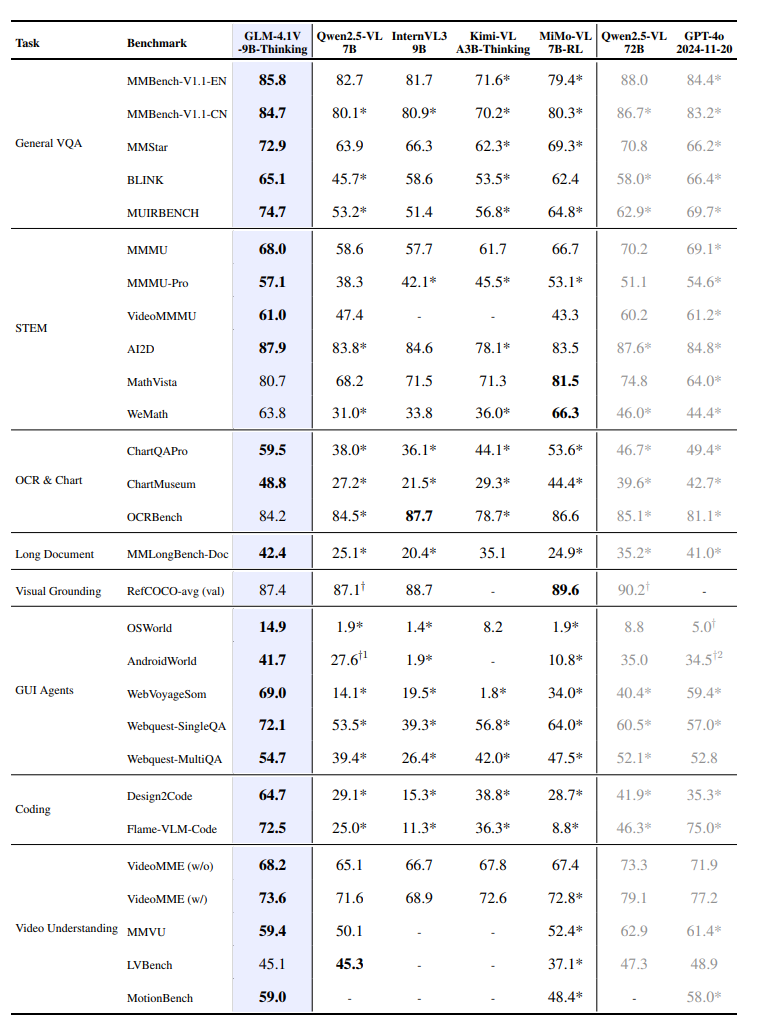

GLM-4.1V-Thinking

GLM-4.1V-Thinking: Towards Versatile Multimodal Reasoning with Scalable Reinforcement Learning

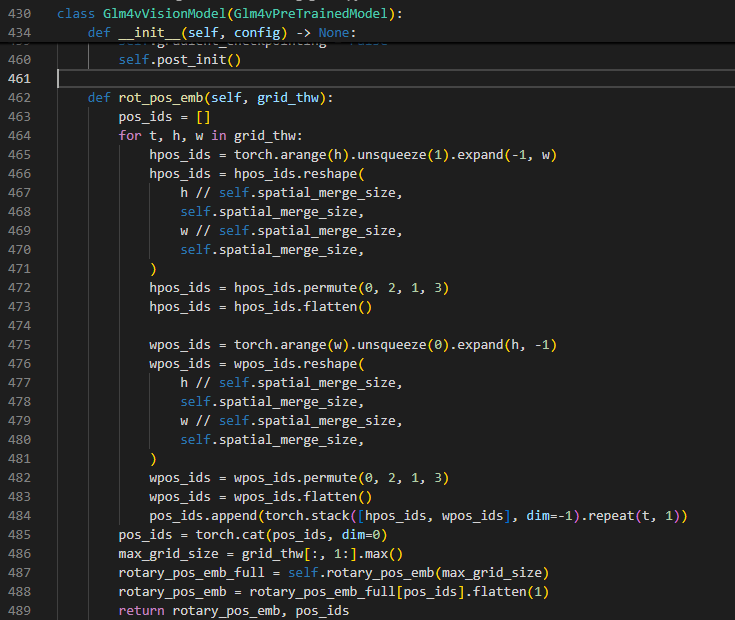

由三个核心组件组成:AIMv2-Huge视觉编码器、MLP 适配器和LLM。采用类似于 Qwen2-VL的策略,用 3D 卷积取代原来的 2D 卷积。这使得视频输入的时间下采样率可以降低两倍,从而提高模型效率。对于单幅图像输入,会复制图像以保持一致性。

为了支持任意图像分辨率和纵横比, 首先集成了 2D-RoPE,使模型能够有效处理具有极端宽高比(超过 200:1)或高分辨率(超过 4K)的图像。其次为了保留预训练 ViT 的基础功能,保留了其原始的可学习绝对位置嵌入。在训练期间,这些嵌入通过双三次插值动态适应可变分辨率输入。具体而言,对于分成Hp×Wp个图块网格的输入图像,首先将每个图块的整数坐标 =(w,h)归一化为跨越[−1,1]的连续网格 norm:

为了进一步增强语言层面的空间感知能力,在 LLM 中将 RoPE 扩展为 3D-RoPE。此扩展为多模态语境提供了卓越的空间理解能力,同时保留了原始模型基于文本的功能。

解决空间自适应问题后,转向视频输入的时间建模。对于视频,在每个帧标记后插入一个时间索引标记,其中时间索引通过将每帧的时间戳编码为字符串来实现。

代码:https://github.com/huggingface/transformers/blob/main/src/transformers/models/glm4v/modeling_glm4v.py#L1219

预训练数据:

图像描述数据:通过多阶段过滤和重写流程,生成高质量的图像描述数据。

交错图像-文本数据:从网页和书籍中提取高质量的图像-文本数据。

OCR 数据:构建大规模的 OCR 数据集,包括合成文档图像、自然场景文本图像和学术文档。

定位数据:构建自然图像和 GUI 的定位数据集。

视频数据:构建大规模的视频-文本数据集,支持复杂的视频理解任务。

训练方案:

多模态预训练。初始阶段旨在为通用多模态能力奠定坚实的基础。使用双向张量并行策略,对所有模型参数进行 120,000 步训练。训练使用的序列长度为 8,192,全局批次大小为 1,536。此阶段的数据集包含所有数据模态(视频除外)。为了最大限度地提高计算效率,采用数据打包策略,将多个可变长度样本连接成接近最大长度的单个序列。

长上下文持续训练。将模型的功能扩展到高分辨率图像、视频和扩展上下文。使用视频输入和超过 8k 个 token 的长序列交错数据来扩充训练数据。为了适应这些更长的输入,将序列长度增加到 32,768,并采用混合并行方法,将双向张量并行与四向上下文并行相结合。此阶段额外运行 10,000 步,同时保持全局批次大小为 1,536。

监督微调 (SFT) 阶段是通往强化学习的桥梁,将基础视觉语言模型 (VLM) 转化为能够进行长链思维 (CoT) 推理的模型。

强化学习 (RL) 训练方案:提出并融入了多项改进,包括基于课程抽样 (RLCS) 的强化学习、基于比例 EMA 的动态抽样扩展、更大的批次大小、丢弃 KL 和熵损失等。

课程抽样强化学习(RLCS)

预定比例混合来自各个多模态域的数据,并使用 GRPO目标进行优化。

一个所有样本都得到正确回答的 rollout 批次不会产生有用的梯度。在我们的试点实验中,超过一半的提示在仅仅 200 个训练步骤后就达到了 90% 以上的准确率。

在训练之前使用多个MLLM在整个数据集上运行 pass@k 评估,并将这些定量分数与专家的人工难度注释合并,以此评估每个样本的固有难度。此过程会产生一组细粒度的难度标签,将数据划分为多个层级,从非常容易到非常难。在训练期间进行在线难度分级。对于每个生成的 rollout,记录 pass@k 结果,将其映射到相应的难度层级,并将这些结果与离线标签合并。这种在线难度分布还能为模型的当前性能提供宝贵的见解。

为了提高多模态强化学习的性能上限,提出并纳入了以下增强功能:

更大的批量大小。

通过比率 EMA 进行动态采样扩展。在 GRPO 中,当熵和 KL 损失都被移除时,完全由正确或完全不正确样本组成的 rollout 批次不会提供有用的梯度。因此增加“无效样本比例”(not_valid_sample_rate)参数,统计当前无效样本的比例,按照比例扩展处理的数据数量,以达到有效样本数量的稳定性。进一步,对比例系数进行指数平均,解决系数波动太大的问题。

强制回答。当思考过程过长时,可能会被截断无法给出答案,会被赋予零奖励。然而,如此冗长的推理过程并不一定错误,截断处理不仅浪费 rollout 预算,还会给训练带来噪音。为了解决这个问题,通过插入 </think> 标记,后跟 <answer> 标记来强制截断,促使模型给出最终答案。我们发现,这种方法可以鼓励模型学习如何在经过任意长度的思考后给出合适的答案,从而有助于在测试时动态控制思考预算。

舍弃 KL 损失。与纯文本模型相比,视觉语言模型在强化学习过程中通常会经历 KL 散度更快的增长。然而,当应用 KL 损失来明确抑制这种增长时,模型的能力会受到明显限制。因此移除了 KL 损失。

更高限幅。在多模态强化学习中,增加重要性采样率的上限也被证明有助于提高离策略性能,并防止过度的熵崩溃。

Seed1.5-VL Technical Report

论文介绍了Seed1.5-VL,这是一个旨在推进通用多模态理解和推理的视觉-语言基础模型。Seed1.5-VL由一个5.32亿参数的视觉编码器和一个200亿活动参数的混合专家(MoE)大型语言模型(LLM)组成。

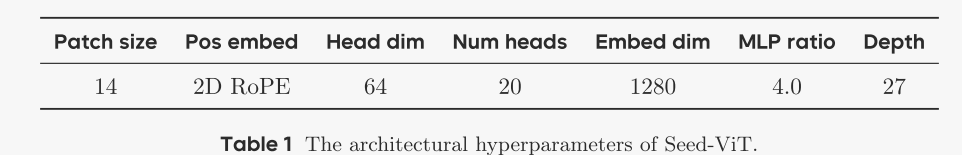

Seed 1.5-VL的架构由三个组件组成:视觉编码器、MLP适配器和大型语言模型(LLM)。

视觉编码器本身支持动态图像分辨率,并采用2D RoPE 进行位置编码,从而能够灵活适应任意尺寸的图像。为了提高计算效率,该架构在相邻的2×2特征块上应用平均池化;一个两层MLP随后在输入到LLM之前处理这些池化特征。

视觉编码器旨在适应不同尺寸的输入图像。最初,输入图像经过预处理步骤,包括双线性插值,以将其分辨率调整到最接近的28 × 28像素的倍数。随后,每个图像被分割成一系列不重叠的块,每个块的像素为14 × 14。按照NaViT中概述的方法,将来自多个输入图像的补丁序列连接成一个统一的序列。然后,这些原始补丁序列通过线性补丁嵌入层投影到嵌入空间中的令牌中,然后将其馈送到Transformer块中。

Seed1.5-VL的预训练语料库包含3万亿个多样化的高质量源标记。数据根据目标能力进行分类,每个类别的数据收集过程如下:

通用图像-文本对和知识数据

光学字符识别(OCR)

视觉定位和计数

3D空间理解

视频

科学、技术、工程和数学(STEM)

图形用户界面(GUI)

训练方法

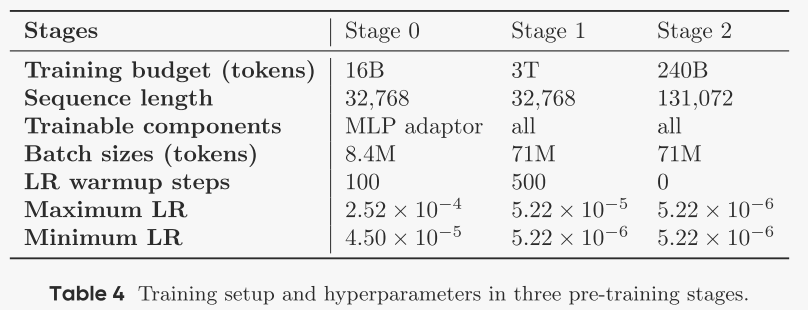

Seed1.5-VL的预训练分为三个阶段:

stage 0

目标:通过仅训练MLP适配器来对齐视觉编码器和语言模型,同时保持视觉编码器和语言模型冻结。

训练细节:使用AdamW优化器,学习率从0.000252开始,逐渐降低到0.000045。

stage 1

目标:训练所有模型参数,重点是知识积累和掌握视觉定位和OCR能力。

训练细节:使用3万亿标记的多模态语料库进行训练,包括字幕、交错的图像-文本、视觉定位和OCR数据。训练序列长度为32,768,批量大小为71M。

stage 2

目标:创建更平衡的数据混合,增加新领域的数据,如视频理解和编码,并增加序列长度以适应视频和复杂推理问题中的长依赖关系。

训练细节:序列长度增加到131,072,所有模型参数均可训练。学习率保持在阶段1结束时的水平,即0.00000522。

Seed1.5-VL在多个公共基准测试和内部基准测试中表现出色,特别是在视觉定位、计数、3D空间理解、文档理解和多模态推理任务中。

Emerging Properties in Unified Multimodal Pretraining

论文试图解决的问题是如何构建一个能够统一进行多模态理解和生成的模型

论文通过以下几个关键步骤来解决统一多模态理解和生成的问题:

数据构建

多模态数据源:整合了文本、图像、视频和网页数据,以支持复杂的多模态交互。特别是视频数据,提供了像素级、概念、时间和物理连续性,有助于大规模获取基于现实世界的知识。

数据过滤:对视频和网页数据进行了严格的过滤,以确保数据的质量和多样性。例如,视频数据通过时间分割、空间裁剪和质量过滤进行预处理,网页数据则通过主题选择和质量过滤来构建高质量的交错数据。

交错数据构建:从视频和网页中构建了交错的图像-文本序列,为模型提供了丰富的多模态交互信号。

模型架构

Mixture-of-Transformer-Experts (MoT) 架构:采用两个Transformer专家,一个用于多模态理解,另一个用于多模态生成。这种架构允许在每个Transformer块中对所有token进行共享的多模态自注意力操作,避免了瓶颈连接器,使得理解与生成之间的长文本交互成为可能。

视觉编码器:使用两个不同的视觉编码器,一个用于理解,另一个用于生成,以分别捕获语义内容和低级像素信息。

因果注意力机制:在训练期间,对于交错的多模态生成样本,模型采用了广义因果注意力机制,允许后续的图像或文本token关注前面图像的清洁VAE token和ViT token,但不关注它们的噪声VAE对应物。

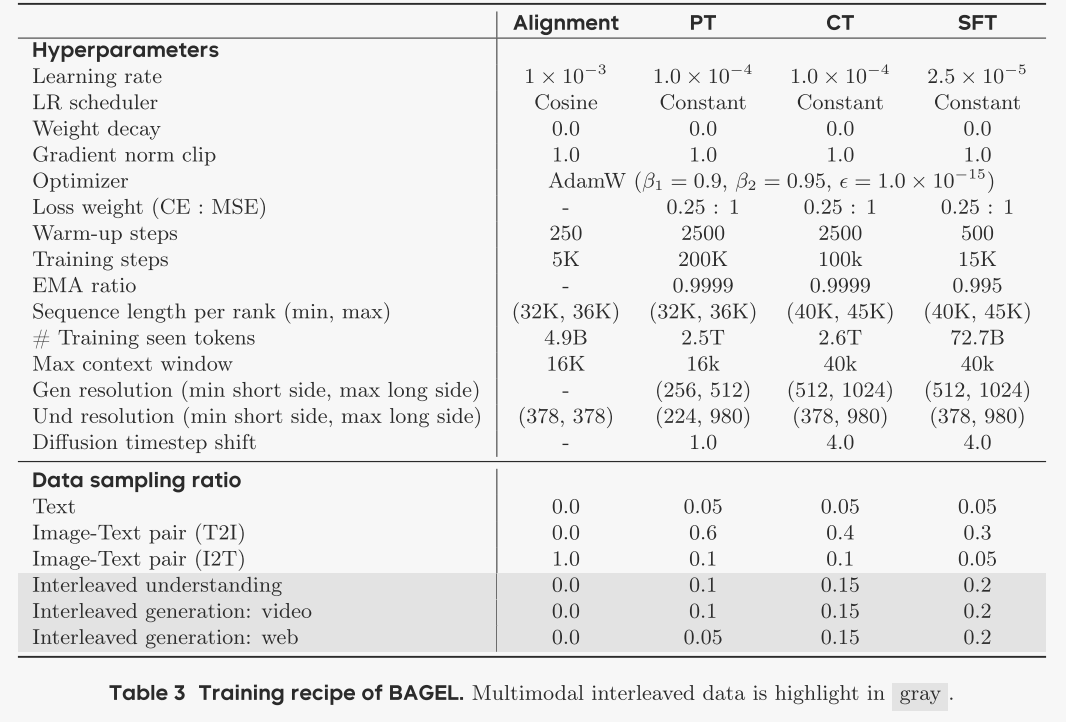

训练策略

多阶段训练策略:包括对齐阶段(Alignment)、预训练阶段(Pre-training, PT)、持续训练阶段(Continued Training, CT)和监督微调阶段(Supervised Fine-tuning, SFT)。每个阶段都有特定的数据采样比例和学习率设置,以平衡理解任务和生成任务的信号。

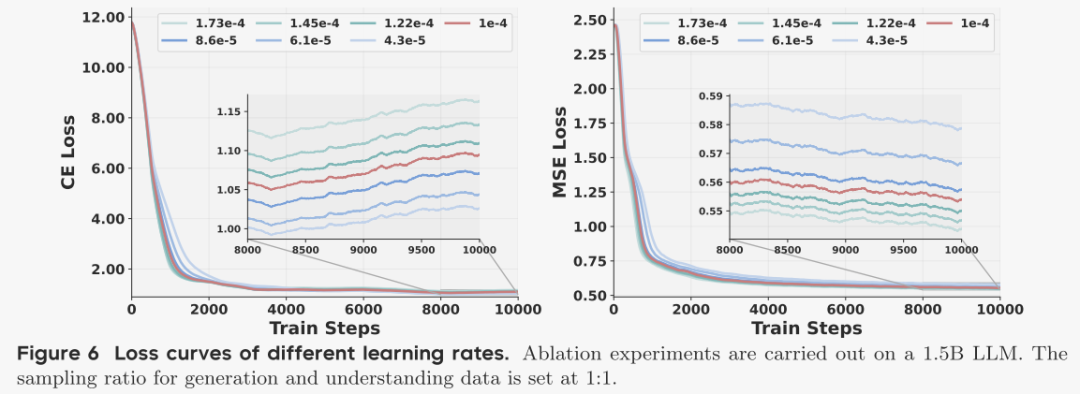

数据采样比例调整:通过实验发现,增加生成数据的采样比例可以显著降低MSE损失,而对CE损失影响不大。因此,在训练过程中,生成数据的采样比例被设置得比理解数据高。

学习率调整:为了平衡理解任务和生成任务的学习率,作者为两个目标分配了不同的权重因子。

不同数据配比的效果

不同学习率的效果

最终效果

Skywork Open Reasoner 1 Technical Report

论文提出了Skywork-OR1,一个针对长思维链(CoT)模型的基于修改版的组相对策略优化(GRPO)的高效且可扩展的RL方法。该方法基于DeepSeek-R1-Distill模型系列,通过引入MAGIC训练框架,显著提升了模型在数学和编码基准测试中的性能。

MAGIC框架包括以下几个关键方面:

数据收集:通过严格的预处理和过滤构建初始数据集,并采用更精确的验证器提供奖励信号。此外,采用离线和在线过滤策略,动态移除已完全正确的训练提示,确保模型始终在具有挑战性的问题上训练。

训练策略:采用多阶段训练,逐步增加上下文长度T,以减少计算成本并保持可扩展性;在训练初期对截断响应应用优势掩码,但实验表明这不会阻碍后期改进;设置较高的采样温度(τ=1)以增强模型的探索能力;采用在线策略更新,显著减缓熵崩溃,提高测试性能。

损失函数:采用基于令牌的策略损失,移除响应长度归一化项;引入自适应熵控制,动态调整熵损失系数,确保当前熵不低于目标熵;移除KL损失项,因为实验表明它会阻碍性能提升。

结论

1、MOE和蒸馏目前是主流的架构+小模型训练方法了。MLA还比较新,对于ROPE的部分还有待继续研究,后面可能会慢慢的从GQA向MLA过度(毕竟效果好+速度快)。

2、MLA中对部分KV剥离了位置编码,这部分应该能在kvcache复用方面起到更大的作用。

3、Mistral在音频大模型Voxtral中使用了Online-DPO作为后训练方法,而在文本推理大模型Magistral以及MiMo、GLM-4.1V-Thinking都使用了GRPO作为后训练方法。

4、Magistral和GLM-4.1V-Thinking、MiMo都对GRPO做了去除KL散度(一定程度上限制了模型能力提升的幅度)、去除无效批次、增加样本多样性、放宽置信域的上限等优化。

5、Magistral和GLM-4.1V-Thinking都采用了SFT冷启动+RL的方法,其中Magistral对比了此方式优于SFT/RL-only,而GLM-4.1V-Thinking对比了SFT冷启动的数量不需要更多(也不能太少),几千条可能就足够了,多样性和质量必须很高。此外RL的跨领域能力保持和泛化效果比SFT更强一些。

技术交流

加入「AI生成未来社区」群聊,一起交流讨论,涉及 图像生成、视频生成、3D生成、具身智能等多个不同方向,备注不同方向邀请入群!可添加小助手备注方向加群!