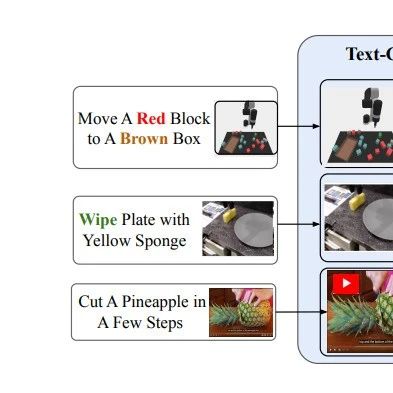

什么是显示端到端VLA,提到显示,这一点和隐式是对立的。上一期分享,我们分享了隐式端到端的模型定义,显示端到端VLA模型视频生成GOAL,明确生成了未来机械臂如何运动的图像!可以浏览下图!

其中还涉及了一个比较重要的概念:逆运动学。

逆运动学

逆运动学主要应用在机器人学、动画学和计算机图形学中,与经典运动学相对。它的目标是根据目标位置,计算物体(如机械臂或骨骼系统)的各个关节应该如何运动才能到达该目标。

列入在机器人领域,逆运动学会回答这样的实际问题:机械臂的末端(手爪)需要到达某个指定位置,那么每个关节应该如何旋转。

逆运动学的核心步骤:

已知信息:

目标位置(通常是点的坐标,比如xyz) 物体的几何构造(如机械臂的长度、关节限制等)

求解:

利用矩阵、三角学或迭代方法,计算每个关节的角度或未知,使得末端能够到达目标点。

多解性问题:

逆运动学通用会有多个解(甚至没解),需要在可能的解中选择一个最优解(如最小能量消耗或最自然运动)。

主要工作一览

1)开山之作:UniPi

将序列决策问题转化为文本条件视频生成问题:给定文本编码的目标描述,规划器会合成一组未来帧来描绘其计划执行的行动序列,随后从生成的视频中提取控制动作。通过以文本作为底层目标描述,我们能够自然而然地实现对新目标的组合式泛化。

这种"策略即视频"的框架还能将不同状态空间和动作空间的环境统一表征为图像空间,例如实现跨多种机器人操作任务的学习与泛化。此外,通过利用预训练语言嵌入和互联网海量视频资源,该方法能够通过为真实机器人预测高度逼真的视频规划来实现知识迁移。

2)Robodreamer

文本到视频模型在机器人决策领域展现出巨大潜力,既能模拟未来动作的逼真规划,又能实现精准的环境仿真。然而这类模型存在一个关键缺陷——泛化能力受限:模型仅能根据与训练数据相似的语言指令生成视频。这严重制约了决策能力的发展,因为我们期望世界模型能够合成未见过的物体与动作组合方案,以解决新环境中的未知任务。

为解决这一问题,RoboDreamer通过视频生成的因子化分解来学习组合式世界模型。利用语言天然的组合性,将指令解析为若干底层基元,并基于这些基元构建模型集来生成视频。这种分解机制天然支持组合泛化——任何新自然语言指令都可视为已见组件的重组。研究进一步证明,该框架还能融入多模态目标,允许同时通过自然语言指令和目标图像来指定待生成视频。该方法在RT-X数据集上成功合成了针对未知目标的视频规划方案,在仿真环境中实现了精准的机器人执行,其性能显著超越传统的单体式视频生成基线方法。

3)LAPA

LAPA提出隐式动作预训练(Latent Action Pretraining),这是首个无需真实机器人动作标签即可预训练视觉-语言-动作(VLA)模型的无监督方法。现有VLA模型在预训练阶段通常依赖人类远程操作采集的动作标签,这极大限制了可用数据来源与规模。本研究提出的方法能够从无机器人动作标注的互联网规模视频中学习:

动作量化建模:基于VQ-VAE目标训练动作量化模型,学习图像帧间的离散隐式动作 隐式VLA预训练:预训练隐式VLA模型,使其能根据环境观察和任务描述预测这些隐式动作 机器人动作微调:在小规模机器人操作数据上微调VLA模型,实现隐式动作到机器人动作的映射

实验结果表明,方法显著优于现有基于大规模视频训练机器人操作策略的技术,在需要语言条件控制、未见物体泛化和未知指令语义泛化的真实世界操作任务上,甚至超越了采用机器人动作标签训练的SOTA VLA模型。仅使用人类操作视频训练也展现出正向迁移能力,为利用网络规模数据构建机器人基础模型开辟了新途径。

4)GR-1

GR-1模型首次证明大规模视频生成式预训练能显著提升视觉机器人操作性能。该研究突破性地将生成式预训练模型(在语言和视觉领域已展现卓越表征能力)成功扩展到机器人操控领域。

GR-1采用简洁的GPT架构设计,专为多任务语言条件视觉操控而开发。模型输入包含:

语言指令 观测图像序列 机器人状态序列

通过端到端方式同步预测:

✓ 机器人动作

✓ 未来场景图像

凭借灵活的架构设计,GR-1可先在大规模视频数据集预训练,再无缝迁移到机器人数据微调。在CALVIN基准测试中,我们的方法将成功率从88.9%提升至94.9%;在零样本未知场景泛化设置下,更从53.3%跃升至85.4%。真实机器人实验同样显示,GR-1在未见场景和物体的泛化能力上显著超越基线方法。

更多内容

更多VLA内容,欢迎学习具身智能之心出品的《具身智能VLA算法与实战教程》,和近200名同学一起学习交流!

扫码学习课程