《从零开始构建大语言模型的关键要点》的核心内容系统性整理,按模块提炼关键结论与最佳实践:

1. 自建 vs 采购预训练LLM的决策框架

三种选择:

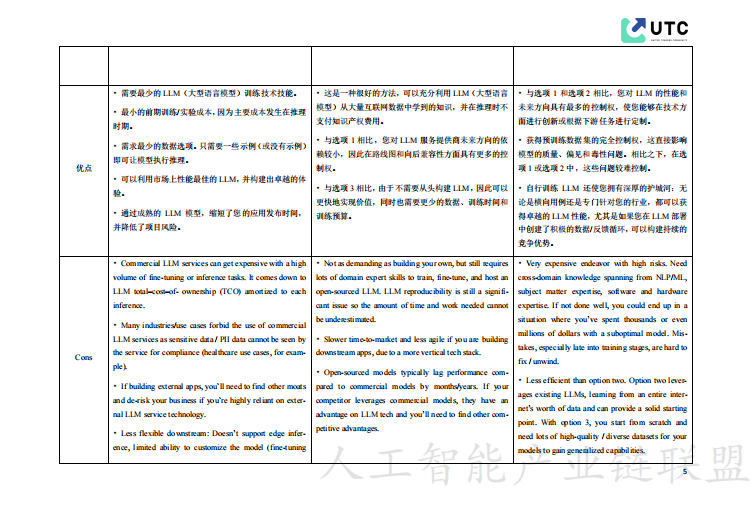

商业API(如OpenAI):低技术门槛,适合快速原型/非敏感数据,但存在合规风险、成本高、不可定制。

开源微调(如Llama):平衡性能与灵活性,需中等技术能力,适合有限数据场景。

从零训练:需海量算力/数据(如Chinchilla定律),仅当模型为核心护城河或需架构创新时选择(如专用分词器、领域数据)。

2. 缩放定律(Scaling Laws)

Chinchilla最优解:模型参数与训练数据量应同比缩放(计算预算↑10倍→模型↑3.1倍+数据↑3.1倍)。

实践建议:根据算力预算优先确定数据-模型平衡点,而非盲目增大模型。

3. 硬件与并行策略

硬件需求:

PaLM(540B):6144 TPU v4;OPT(175B):992 A100 GPU;需分布式训练。

并行技术组合:

数据并行:分片数据到多节点,适合大数据集,但内存冗余。

张量并行:拆分矩阵计算到多GPU,需高带宽,减少内存占用。

流水线并行:按层切分模型,通信开销最小,受限于模型深度。

优化技巧:梯度累积、异步SGD、微批处理提升效率。

4. 数据处理核心步骤

数据质量:

去重:用LSH模糊去重(参考《Deduplicating Training Data...》论文)。

清洗:去HTML/模板文本,修正拼写,平衡领域数据(如科学数据↑采样)。

防泄露:用n-gram移除下游任务数据。

分词策略:

子词分词(BPE/WordPiece/SentencePiece):平衡词汇量与OOV问题,SentencePiece支持无空格语言(如中文)。

无分词模型(ByT5):直接处理字节,跨语言但精度较低。

5. 预训练工程实践

架构调优:

从GPT-3/OPT基线调整:如旋转嵌入(RoPE)、并行注意力层、纯密集层。

超参数搜索:

小模型实验→外推大模型参数,动态调整学习率(线性预热+衰减)、批次大小(渐进增大)。

稳定性问题:

应对硬件故障(自动重启+隔离节点)、损失峰值(降低学习率/跳过问题批次)。

正则化(Dropout、权重衰减)、热插拔优化器应急。

6. 模型评估与风险管控

评估基准:

NLU任务:SuperGLUE、HellaSwag(常识推理)、HumanEval(代码)。

n-shot学习:零样本/少样本提示测试泛化性。

人工评估:NLP工程师(发现系统性缺陷)+领域专家(验证逻辑链)。

偏见与毒性:

训练阶段:过滤/修改偏见数据(如性别词替换)。

后训练:RLHF优化、提示工程、输出过滤。

检测工具:CrowSPairs(社会偏见)、RealToxicityPrompts(毒性生成)。

缓解策略:

7. 指令调优与RLHF

指令调优:

通过1.8K任务指令微调提升零样本性能,需链式思维(CoT)示例强化推理。

RLHF流程(如InstructGPT/ChatGPT):

代价:对齐税(性能轻微下降),可用Scale AI等第三方服务降低实施成本。

监督微调(SFT):人工标注指令数据。

奖励模型训练:人工排序模型输出。

PPO强化学习:用奖励模型优化策略。

关键决策清单

复制

| 阶段 | 关键问题 | 推荐动作 |

|---|---|---|

| 立项 | ||

| 数据 | ||

| 硬件 | ||

| 评估 | ||

| 后训练 |

总结:训练大模型是系统工程,需在数据质量、算力效率、评估伦理间动态权衡。优先复现成熟架构(如GPT-3→Chinchilla缩放),再针对性优化。

本书免费下载地址

关注微信公众号“人工智能产业链union”回复关键字“AI加油站39”获取下载地址。

【AI加油站】第八部:《模式识别(第四版)-模式识别与机器学习》(附下载)