“编者按:当下的AI浪潮,不仅是算法与模型的革新,其本质更是对物理世界基础设施的彻底重塑。

我们翻译这篇文章,因为它精准地从房地产、资本、算力、能源和网络这五个看似传统的要素切入,系统地揭示了支撑AI时代运行的宏大图景。

深度解析房地产、资本、算力、能源和网络,这五大支柱如何引爆AI数据中心建设浪潮

作者:克里斯·泽奥利

日期:2025年8月12日

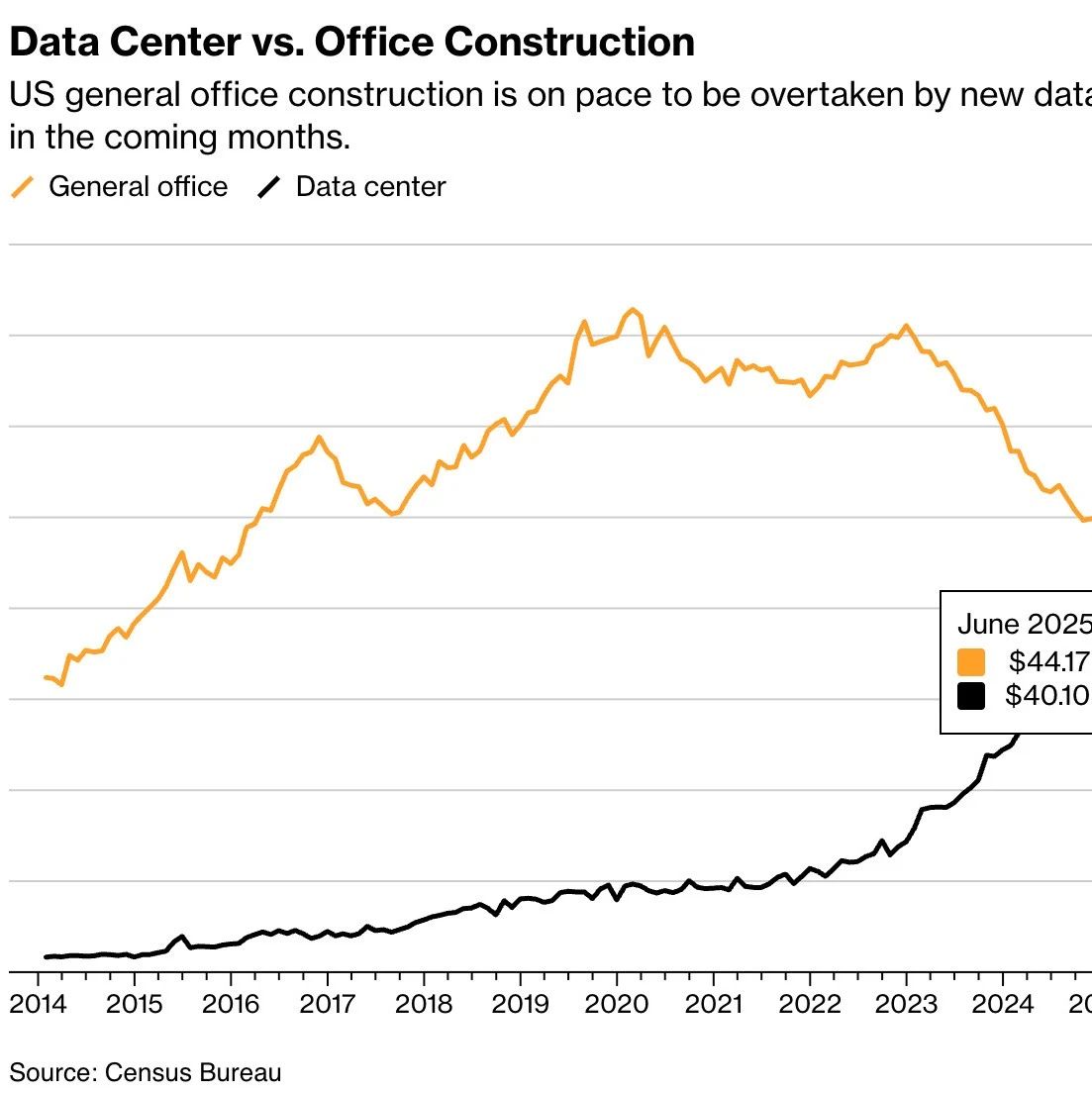

数据来源:彭博社与美国人口普查局

今年,一项深刻的行业变革正在发生:新建数据中心的年度开支,即将首次超越传统写字楼的建设投入。

回想十年前,美国数据中心建设的年投入仅有20亿美元,而写字楼建设则高达330多亿美元,两者完全无法相提并论。

疫情之后,写字楼开发从2020年的高点急转直下。与此同时,AI的军备竞赛则引爆了数据中心投资的爆炸式增长。

这一反差揭示了商业地产的重心已发生根本性转移:支撑数字经济的物理骨架,其价值正全面超越人们线下工作的物理空间。

AI对算力、存储和低延迟连接的无尽渴求,正以前所未有的速度,彻底重塑我们身边的物理世界。

房地产

构建AI数据中心的第一个关键要素,是房地产。

AI数据中心的占地面积正在飞速扩张,预计将从2025年的2.75亿平方英尺,增长至2030年的7亿平方英尺。其形态更像加密货币的矿场,而非传统的数据中心。

传统数据中心的布局由Equinix等公司和人口密度决定,但AI数据中心的选址逻辑则完全不同。

AI数据中心追求的是廉价的土地和电力,而传统数据中心看重的则是网络带宽和靠近人口中心的位置。

这些设施的单体规模也日益庞大。例如微软Azure等超大规模运营商,正在建设超过200万平方英尺的园区,体量是普通美国数据中心的100倍以上。

CoreWeave公司45万平方英尺的设施,为行业展示了专为高密度机架和液冷优化的「AI原生」建设新标准。

这种扩张浪潮,亟需有利的区域规划、临近大容量光纤,以及可靠的电力供应。最终,数据中心地产正成为全球最具竞争力的战略资产之一,已占到黑石集团旗舰基金30%以上的份额。

核心洞察:

黑石集团在收购QTS并入股Digital Realty后,其拥有的数据中心面积已超过一些规模最大的房地产投资信托基金。

DigitalBridge指出,AI租户签约时常伴有大额预付或多年一次性付款,这在传统主机托管市场极为罕见。

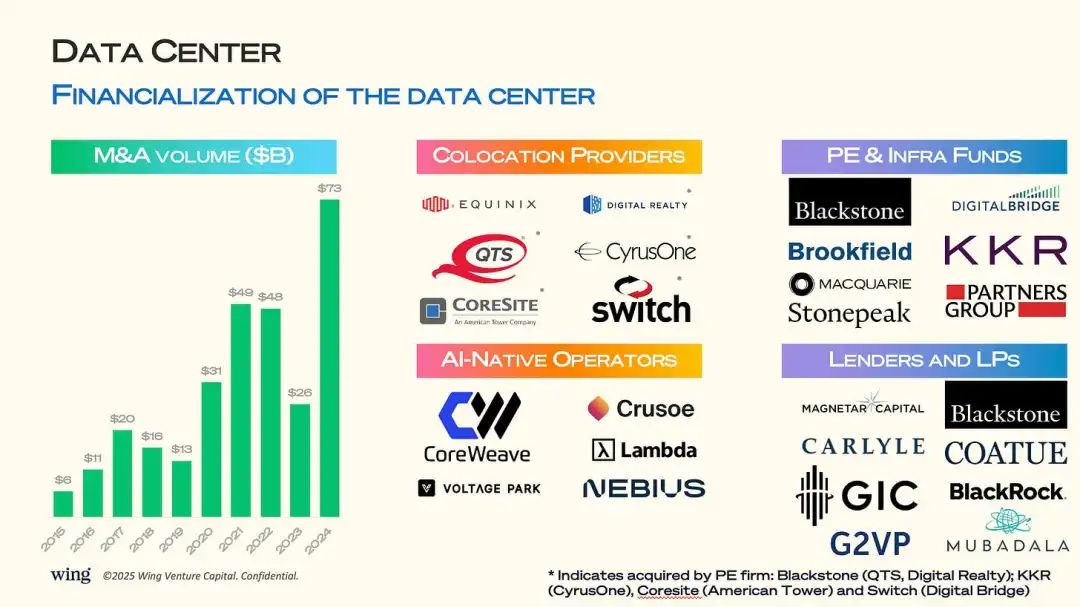

资本

数据中心开发已成为一场资本盛宴,仅2024年的并购总额就高达730亿美元。

黑石、KKR和DigitalBridge等私募股权与基础设施基金,正大举收购主机托管服务商,重注未来数十年的AI基础设施需求。

CoreWeave、Crusoe和Lambda等AI原生运营商,则同时吸引着股权和债务融资,以求快速扩张。

这个领域的资本密集度极高,年度投资额预计将从2025年的4500亿美元,增长到2030年的1.2万亿美元。

这种集长期租约、关键任务地位和AI增长引擎于一身的特性,使数据中心成为投资者眼中最顶级的核心基础设施资产。

核心洞察:

对于那些能满足超大规模运营的资产,私募买家给出的企业价值与息税折旧及摊销前利润比率,达到了十几倍,远高于历史均值。

像CoreWeave这类AI原生运营商,已通过GPU抵押获得了数十亿美元的信贷,算力正切实地演变为一种可融资的资产。

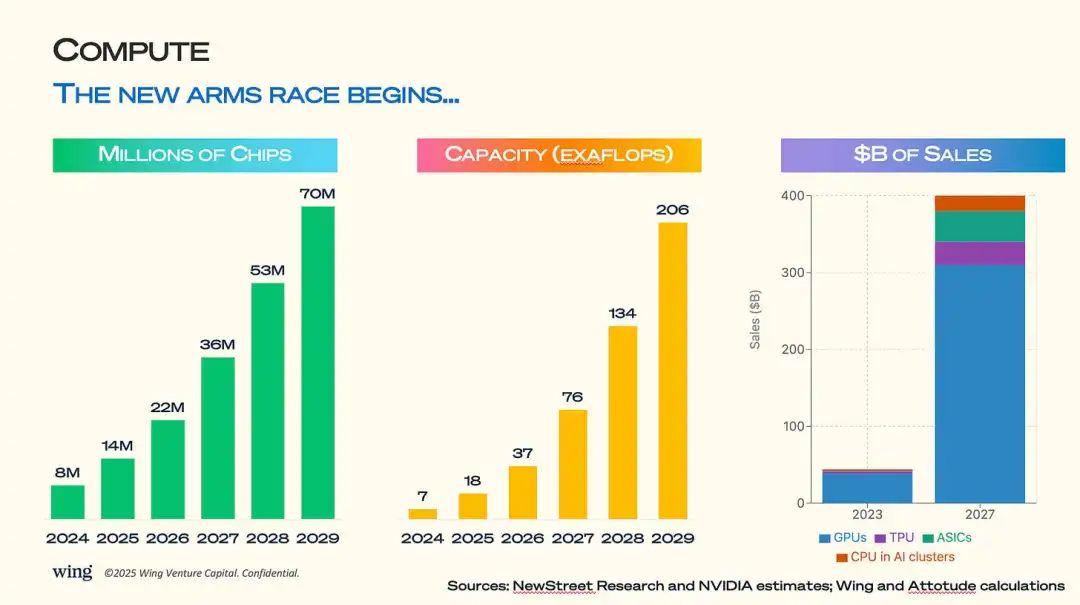

算力

算力层面正迎来史无前例的增长期,芯片出货量预计将从2025年的1400万片,增至2029年的7000万片。

只有资本最雄厚的公司才能掌握参与AI竞争的入场券,这直接导致了行业内「富GPU」与「贫GPU」两大阵营的形成。

到2030年前,全球AI总算力将突破200百亿亿次浮点运算的大关。

英伟达的GPU是当前市场的绝对主角,预计到2027年,将在4000亿美元的AI芯片市场中占据绝大部分。与此同时,谷歌的张量处理单元、云厂商自研的专用集成电路、以及博通等公司的AI优化跨平台处理单元,也都在争取更多份额。

这一趋势正驱动着从先进封装到高带宽内存在内的整个供应链和制造业的巨额投资。在AI时代,每兆瓦电力所能支持的算力密度,正成为数据中心竞争力的核心标尺。

核心洞察:

英伟达凭借其在AI加速器上的领先优势,占据了数据中心GPU市场约80%的份额,毛利率超过75%。

高带宽内存是目前供应链的关键瓶颈,三星、SK海力士和美光都在全力扩产,其价格已同比增长超过30%。

到2027年,一个能达到百亿亿次浮点运算能力的AI训练集群,仅硬件成本就高达5到8亿美元,且不含网络与设施费用。

基于Arm架构的CPU因其处理每个数据单元的功耗更低,正在处理海量推理任务的AI集群中悄然崛起。

能源

AI对能源的巨大需求,其增长速度之快,足以重塑整个国家的电网格局。

到2030年,AI相关应用将可能消耗美国总电力的10%,远高于2023年4%的水平。

要满足这一需求,意味着在2025到2030年间,需要新增90吉瓦的发电能力,这相当于新建数十座核电站或数千个大型太阳能电场。

AI领域的电力开支将增长近两倍,从2025年的580亿美元攀升至本十年末的1910亿美元。

在这样的背景下,能源策略与可持续性不再是可有可无的环保口号,而是决定成败的核心竞争力。

核心洞察:

未来几年AI所需新增的90吉瓦电力,约等于整个英国当前的总发电量。

超大规模数据中心的平均电源使用效率约为1.2,但AI训练的极端散热需求,会将这一数值推向更高。

部分运营商正探索直接的核能供应,微软公司已聘请核能专家,并着手申请小型模块化反应堆的许可证。

运营商正在重新修订与新能源供应商的弃电协议,确保优先满足AI数据中心的用电需求,而非将电力卖回给利润更低的电网。

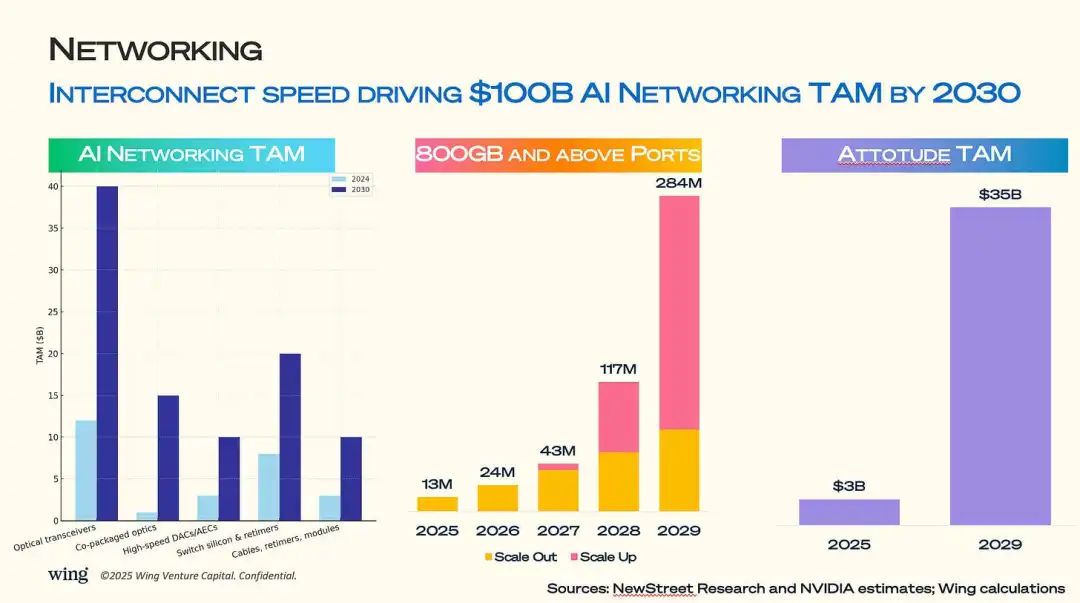

网络

如果说AI数据中心是庞大的身躯,那么高性能网络就是其赖以生存的循环系统。预计到2030年,AI网络市场的总规模将达到1000亿美元。

市场上的主要玩家,包括独立的网络设备商Arista,以及通过收购Mellanox已将网络业务悄然做到超百亿销售额的英伟达。

仅光收发模块这一项,市场规模就将从2024年的约120亿美元,增长到2030年的400亿美元。这背后的推手,是行业向800Gb及更高速率的全面转型。

800Gb端口的出货量,预计将从2025年的1300万个,飙升至2029年的2.84亿个,为AI集群的横向与纵向扩展提供支持。

当模型越来越大,真正的瓶颈已不再是计算速度,而是数据在芯片、节点和机房之间传输的效率。

核心洞察:

在紧密耦合的GPU集群中,网络链路从400Gb升级到800Gb,能将模型训练时间缩短两位数百分比。

目前市场占比不足5%的共封装光学技术,随着交换机芯片的功耗日益成为瓶颈,其市场规模有望在2030年突破150亿美元。

Infiniband与以太网的王者之争日趋白热化。英伟达的Infiniband主导着训练集群,但云巨头们正力推基于以太网的远程直接内存访问技术,以求削减成本。

一个常被忽视的细节是:在AI设施中,信号重定时器和线缆的费用,能占到网络总开销的20%以上。

原文地址:https://substack.com/inbox/post/170708408

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!