【导读】从模型具备逻辑推理,到非专业人士也能用自然语言“氛围编程”,再到智能体将互联网从“信息网络”重构为“行动网络”,我们正处在一个被大模型全面重塑的时代。在 2025 全球产品经理大会中,奇点智能研究院院长、CSDN 高级副总裁李建忠预言了孤立 App 时代的终结和“伴随式”人机交互的兴起。跟随他的思考,我们将清晰地看到 AI 如何从技术底层到产品表象,一步步颠覆我们习以为常的数字世界。

大家好!全球产品经理大会(PM-Summit)从去年 9 月到现在,短短一年的时间,感觉在 AI 领域已经经历了好几个迭代。

我今天分享的题目是《大模型驱动的 AI 产业生态和产品创新》,聊聊近一年来在这方面的研究和思考。

整个演讲分为四个部分:大模型推理范式转换、应用开发范式转换、人机交互范式转换、智能体生态演进。后两个部分是今天演讲的重点。

首先来看第一部分:推理范式转换,这是去年以来整个大模型最大的变化:

去年 9 月份之前,主流的模型都是训练模型。9 月份之后,OpenAI o1 通过强化学习实现了模型推理能力的大幅度提升。再到今年 1 月份, DeepSeek R1 在全球第一个开源推理模型,引领整个业界的主流模型都进入推理范式。

我有三句话,快速总结它们的特点:“预训练”是模型在“讲知识”;“后训练”是“讲文明”,和人类价值观对齐,它们共同构成模型的“快思考”能力;“推理”是“讲逻辑”,它构成了模型的“慢思考”能力。

这里面的核心是强化学习,强化学习之父 Richard Sutton,也是去年的图灵奖获得者,今年 4 月份有一篇论文《Welcome to the Era of Experience》,我觉得蛮重要的。

这篇论文讲了之前的训练模型,主要基于人类现存数据,是人类知识的“回声室”,模型的上限就是人类现有知识的总和。但有了强化学习,整个 AI 进入一个新的称为“经验数据的时代”。注意,这个经验不是人类的经验,是 AI 通过使用强化学习 self-play 获得的奖赏和惩罚反馈,由机器产生的合成数据来训练模型。最早的例子是 AlphaGo 所谓“37 手”(move 37)走出了人类棋手从未有过的招数。那时候的 AlphaGo 还是垂直模型,现在将强化学习引入通用大模型,在预训练的基础上进行自我迭代,这使得 AI 有机会探索出超越人类知识边界的创新。

我们回顾一下去年 9 月份之前,其实业界一度有一种言论是“Scaling Law 是不是失效了?”后来我们发现不是 Scaling Law 失效了,是 Scaling Law 的一个条件:数据、也就是公域互联网上的数据几乎被耗光了,所以它放缓了。虽然预训练阶段的 Scaling Law 放缓,但有了强化学习之后,我们发现它在另外两个方面“测试时 Test Time“和”强化学习阶段“的 Scaling Law 又加上了。三者叠加,我们看到去年 9 月份之后,整个模型仍然遵循 Scaling Law,随着规模扩展,性能不断攀升。

主流 SOTA 模型随着推理范式的转换,今年还有一个比较大的变化是:纷纷内置了整个 Agent 和 Tool Use 的能力训练,向 Agentic Model 所谓智能体模型迭代。主要依赖的就是强化学习在动态环境中进行试错学习决策策略和工具使用,使得整个大模型从“给用户建议”演进为”帮用户做事情”。

这是今年 3 月份之后,SOTA 类模型很突出的一个表现,包括最近的 GPT-5 的发布,在 Agent 和 Tool Use 方面上了很大的训练力度,这是值得我们特别注意的模型侧的发展趋势。

接下来我们来看第二部分应用开发范式的转换。

氛围编程(Vibe Coding)是最近兴起的一个话题。这个在软件开发领域的争议也非常大。

在大模型之前,软件开发主要靠程序员直接使用计算机语言进行编程。22 年之后,大家发现可以使用大模型生成代码,进入 AI 辅助编程(所谓 AI Copilot)阶段。

到今年,非专业软件开发人员使用自然语言来进行的“氛围编程”(所谓 Vibe Coding)成为一支崛起的新兴力量。很多传统软件工程的人对于 Vibe Coding 看不上或者看不起,觉得不懂编程语言理论/编译器/算法/架构的非专业人士、只能做一些小游戏、小应用,到了严肃的大规模企业级软件领域,很难 work。所以觉得氛围编程是炒作,是雕虫小技。

我觉得面对创新事务,这样一棍子打死是非常危险的。实际上历史上的很多创新刚开始看起来,都是从边缘领域、人们看不起、看不上的领域开始的。我觉得我们需要抛掉传统软件工程理论来看待氛围编程。

先回顾一下历史,在 1995~2000 年左右互联网早期起来的时候,有了 Web 网页编程,也就是 HTML/JS/CSS。那时候传统软件工程的人也看不上那时的 Web 编程,甚至认为这些写标记语言、脚本语言的不叫编程。这个说法今天看起来相当荒谬了,实际上 Web 网页编程后来随着互联网的突飞猛进创造了人类历史上“用户量最大”、“数量最多”的软件规模。今天相信大家都认可 Web 编程是软件历史上非常伟大的创新。顺便提一句,基于 HTTP 的 Web 编程也不是传统主流计算机人搞的,是欧洲核子研究组织(CERN)搞得。典型的“边缘人士”做出的颠覆式创新。

我们今天谈的氛围编程,大家也要用这样一个全新的视角来看。我个人认为,氛围编程不是来开发传统软件的。传统企业级的大型软件,仍然遵循传统软件工程理论,需要使用 AI 辅助编程(AI Copilot)在软件开发生命周期的每一个环节(包括架构、设计、编码、测试…..)利用 AI 来提效。

氛围编程和 AI 辅助编程不同,它的目的不在于提效。而是开创全新的疆域,带领软件开发进入一个新的增量市场。这个增量市场是什么呢?我这里提一个新概念叫“可塑软件(Malleable Software)。

面向对象和交互设计奠基人、施乐 PARC 研究院的开创者、也是早期图灵奖的获得者 Alan Kay,在八十年代有一个预言叫“软件未来应该像文档一样可以随时编辑”。

这个提法很早,无奈当时的技术并不能支持这一点。我觉得今天的氛围编程有机会实现 Alan Kay 当年提出的这个愿景。氛围编程会带来普通大众用户(而非专业程序员)使用自然语言来实现软件创造的平权时代。它的核心是改变软件的生产和交付方式。怎么改变呢?

我们今天的软件产品,都是标准化产品,简单说我们的产品经理给用户定义什么样的产品,用户就只能这样用这个产品。部分软件支持一些后台配置选项,但它还是由产品经理框定在标准化软件一开始的设计方案里。

但如果我们仔细观察用户使用软件的行为,比如一万个用户使用 Photoshop,实际上有一万种用法,一万种用户旅程、使用的功能点也不尽相同。但很遗憾,由于生产软件的成本高昂,尽管有非常多元的需求,软件厂商只能开发标准化软件。

但是有了氛围编程,未来的软件厂商可以做好软件底座(这部分仍然要使用传统的软件工程,AI Copilot 在这方面主要是提效),然后在界面和交互层,开放给普通用户,使用氛围编程来进行二次加工和个性化定制。由于使用自然语言编程,人人都可以参与到这样的软件二次创作中。“一万个人、可以基于 Photoshop 底座软件有一万个不同的个性化定制”,这便是“可塑软件”。“可塑软件”可能会带来颠覆式的软件交付方式和生产方式变革。特别是新一代的 Agent 应用。

另外,因为氛围编程极大地降低了软件的生产成本,可以针对各种短期需求来开发软件。传统上,因为软件开发成本极高,这部分需求就被压抑了。氛围编程生产的软件可能呈现一种“即用即抛”的特点,不一定再像传统软件那样追求复用性。

传统软件工程一直强调的“可复用性、可扩展性”底层原因还是因为软件开发成本太高了。当然我们说氛围编程,它仍需要传统软件作为底座,就像互联网 Web 前端仍然需要后端系统级软件提供 API 作为底座。

接下来谈谈最近比较热的上下文工程。

很多产品经理,去年或者前年都在钻研“提示词工程”,怎么把大模型的能力给它压榨出来,各种招数。但是今年大家发现提示词在长任务上、特别是面向 Agent 类的任务上,作用有限。

为什么?因为去年之前主流的大模型都是训练模型,发挥训练模型的能力,用好提示词就可以。但是今年以来主流大模型转向推理模型,Agentic Model,这时候要发挥优秀的推理能力,“上下文工程”就很重要的。要模型做出最优质的决策,就需要给出最全面、准确的上下文:用户需求、任务目标、场景信息、历史交互、资源约束、规则边界等。

其实,这就是智能的本质,人类也如此,假设爱因斯坦这样聪明的大脑,我们给他的是模糊不清的上下文,爱因斯坦也给不出一个正确的决策。

这让我想起在大模型之前大概 2009 年,在硅谷从 Netflix 流行的一种组织管理文化叫“Context、Not Control(提供上下文、而非控制)”,是对组织创新文化非常精辟的一种总结,后来到国内也被字节张一鸣等互联网公司奉为经典。这个当时当然不是针对 Agent,而是讲针对人构成的组织,如何激发创新活力的管理哲学。

我发现这个管理哲学非常适合 Agent。就是针对智能体,我们也不要用传统的那种所谓流程化、规则化的思维去控制它。反倒你应该给它提供充足的上下文,然后 Agent 就会以它的智能、它的创新方式来提供解决方案。

控制(Control)是图灵-冯诺依曼计算时代的精髓,而神经网络计算时代的精髓在于上下文(Context)。

第三部分,人机交互范式转换。这也是我这几年研究相对比较集中的领域,我认为这可能是 AI 爆发潜力最大的地方。

张小龙最早在 2012 年有一个言论,被后来认为是非常睿智的方向性判断,他当时讲“PC 互联网的入口是搜索框,移动互联网的入口是二维码”,那延续此问:AI 时代的入口是什么?我的答案是“自然语言的对话界面”。

注意我没有说“对话框”,因为对话框并不能囊括所有 AI 交互的入口形态。比如智能眼镜、比如 OpenAI 前段时间花 65 亿美金购买 John Ivy(苹果前首席设计师)创立的公司 io,这个公司只有 55 人。他们正在做下一代的自然语言对话的这种设备。还有智能汽车上的语音对话设备。

这些交互界面未必是对话框,但它只要能够满足使用自然语言去对话,就是 AI 交互入口发生的地方。我们先来看一下整个交互范式的变革历史:

从最早的 CUI(控制台用户界面)到 80 年代施乐 PARC 开启、后来乔布斯和比尔.盖茨引领的 GUI(图形用户界面),到 2007 年 iPhone 出来的 TUI(触控用户界面)。用户交互界面的变革一直是计算产业里的革命性力量,每一次革命都会把计算的潜力释放给更广泛的人类和场景,AI 时代的“自然语言用户界面”更是如此。

但是我也想说,自然语言交互这两年也谈得比较多,但它并不是一问一答对话这么简单。就像张小龙说二维码是移动交互入口,不是拿个摄像头扫一下这么简单,扫完之后呢?它的背后是要有一整套的移动生态系统去支撑它。张小龙早在 2012 年移动互联网爆发前夜,就看透二维码这样一个交互入口,然后以此来布局整个微信生态,我觉得这才是微信可怕的地方。

这是我今天想重点讲的,就是“自然语言交互界面作为入口之后”,如何牵引出对整个智能时代应用生态的重构?我觉得这是下一波 AI 发展的重大问题。

这方面有以下四点和大家分享:第一是应用的服务化,第二是 App 我认为不再孤立,第三是无需结构化 UI,第四是生成式 UI。

我稍微展开一下谈谈应用服务化。大家今天看到这个 GUI+TUI 为主的用户界面,是面向我们人类设计的。但是它并不适合 Agent,包括从去年到今年,大家看到很多 Agent 的这种 Computer Use 都是模拟人类点击,我觉得模拟人类点击是一个伪 AI 交互。是一个中间过渡形态,就像移动互联网期早期的 WAP 页面,当时就是介于互联网和移动互联网之间的中间过渡形态。我认为大部分 GUI 应用,会演变成可以被 Agent 直接调用的 API 服务。

就像我们经常用的,比如说这种机票、酒店、外卖等软件,未来它们未必是要用这种 GUI 的方式跟我们交互。因为用户和 Agent 之间是第一交互入口。这些软件只需要提供好它们的服务 API 给 Agent 调用就可以了。

接下来我想谈一下,孤立 App 的问题。我们今天每个人的手机上都装着几十、上百个 App,我认为未来这些孤立 App 之间的壁垒会被打破,Agent 未来会通过智能推理无缝衔接各种服务。

在传统孤立 App 模式下,假如我出差,我要订机票、订酒店、订出租车、根据目的地要看地图导航 App,还要看天气 App、看导航。要经常在这四五个 App 之间来回切换,我想很多差旅人士都有这种痛苦。

但是我们人类的需求本来不是这样子的,我们为什么要在几个不同的 App 之间来回切换呢?我认为这是图灵-冯诺依曼计算架构底下,给我们人类造成的这种鸿沟。人类的需求被拆解为不同的结构化 App 来分别满足。但是现在有了 AI 之后,这种情况会得到改变。

在 AI 时代,我们的需求颗粒度将以自然语言描述的任务为单位,而不是被拆解为一个个应用为单位。

我们的需求通过几句话的自然语言表达出来之后(如果 AI 知道了我的偏好后,甚至一句话就可以表达清楚我整个差旅需求),智能体可以将我的需求拆分成不同的服务 API 调用(订机票、酒店、地图、出租车等),而且在它们之间进行上下文信息共享(再也不用我们在不同的 App 之间将信息来回拷贝/粘贴),大大提升用户体验。

未来,我们将在用户交互层面,看不到一个个孤立的 App,它们都以服务 API 的形式藏在背后,由 Agent 来按需调度。

接下来我们再来看结构化 UI 的问题。什么叫结构化 UI?就是大家传统认知中的这种表单、按钮、导航、菜单等等,这些都是上个时代 GUI 交互的“遗老遗少”。

为什么需要这些结构化 UI?它们是为了适配图灵-冯诺依曼计算架构,而对确定性结构化信息的收集需求,人类为了使用计算机不得不迁就这种要求,或者必须被机器驯化成操作这些表单、按钮、导航、菜单等等。

但是大家想一想,为了订一个机票,在一个商旅软件里面,我们要走好几步。为什么不能在记住我的偏好前提下,一句话需求直接把机票给我买了?就像我们一句话交代给助理一样。

未来的 Agent 应该很快具备这样的能力,它可以把我们自然语言描述的需求,拆分成结构化的信息,送给商旅服务的 API。然后直接将订票结果给我们。未来,鼠标点击、触控指令将不再是主流的交互。

最后谈谈生成式 UI。我们说未来自然语言交互是入口,并不意味着对话的结果呈现永远是语言或者文本。很多场景,我们仍然需要图形展示。

人类对图形天然有很多偏好,但是此图形非彼图形,这个和传统的 GUI 图形用户交互界面非常不一样。未来生成式的用户界面(GenUI),会替代传统的结构化 GUI 图形用户界面。

我们今天在电脑/手机上看到的 GUI,它其实承担了三个职责:1、图形化呈现结果;2、响应鼠标点击/触控的人机交互;3、收集结构化的数据。

这三个职责中后两个职责未来在 GenUI 中会消失。GenUI 将主要用于图形化的方式呈现结果,而不再承担鼠标点击或者触控交互的职责、也不承担收集结构化数据的职责。后两者都会交给 AI 来完成,因为 AI 在这两方面的体验更便捷、更符合人性。

比如说未来我们通过 Agent 要外卖点一个汉堡,GenUI 根据我的偏好、地理位置,应该直接在屏幕上生成一个我想要的汉堡,直接怼在我脸前,如果我确认人脸扫描直接完成支付就行了。不需要再经过漫长的各种信息流、菜单、按钮、表单这些繁琐的流程。GenUI 现在也是人工智能领域比较活跃的创新方向。

当然这只是我在做的一些研究,包括有些是和客户合作的一些方向。未必全对,也未必全面,因为今天来看整个 AI 驱动的人机交互的生态建设还很不完善,但是我觉得方向是很明确的,就是未来五到十年,整个人机交互会被 AI 极大地颠覆。当然,完善这样的 AI 交互体验闭环,需要大量的生态建设,我觉得这也是很多创新的机会。

新一代的交互体验呼唤新一代的交互设备。

前段时间我和有硅谷精神之父之称的凯文凯利 KK 有一个对话。对话中谈到智能时代的超级设备是啥?手机的下一站如果不是手机,会是一个什么样的设备?

KK 的观点是手机之后的超级设备是智能眼镜,他有一个提法叫镜像世界。但是 KK 加了个限定语,25 年之后。这个限定语加的非常聪明,因为 25 年之后人类的预测太难说清楚了。

但是我当时在跟他对话时提了一个不同的观点,我认为手机之后未必会仍然有一个中心化的超级设备,而是很有可能进入一个“多元设备”的时代。

如果我们看手机之前,人类周围并没有一个中心化的超级设备。我们那时有 Walkman、Mp3、收音机、游戏机、电视机等等。实际上就是个多元设备时代。移动互联网起来之后,手机变成一个单一超级设备,统治了我们整个信息中枢。

AI 时代,我觉得可能有一个钟摆效应,人类可能会再次进入一个多元设备时代。不同的场景,有不同的设备。比如眼镜、手表、智能汽车,智能穿戴、等等,当然手机也还会是其中之一。但未必像今天一样成为中心化的超级设备。

这里很大的原因是,我们今天的能耗限制和物理载重限制,包括智能眼镜这样的设备,很难通吃所有场景。但它们在自己的子场景里体验却是最优的。当然,有了 AI 的加持,这些设备之间打通之后会有更好的体验。我们稍后会再谈到这一点。

最后第四部分,我们来谈谈智能体的整个生态。

我们前面有谈,对话助手只是一个交互入口,入口之后它一定有一个生态,需要一个平台来承载。我刚才从交互的角度谈了未来 AI 应用的形态,另外一个我觉得更大的是智能体平台。目前大家看到主流的模型助手、包括最近的 GPT-5 的发布,都在从这种对话助手向智能体平台演进。

智能体其实业界有很多种不同的定义。我比较认可下面这样一种定义,或者它的能力矩阵:规划、工具、协作、记忆、行动。

为什么智能体从去年下半年开始突飞猛进,很大程度上是因为强化学习带来的推理能力提升。从而给智能体带来了关键的“规划”能力。

再来谈工具能力。我们知道大模型本身并不执行图灵-冯诺依曼架构下的软件程序,但大模型想做事情,也不可能丢掉这些传统软件程序,这就是 Tools 工具能力。

我们知道早期 Function Call 等就是支持这个的,但是各家模型不够标准化。Anthropic 于去年底推出 MCP 协议,把这个标准化之后,大大提升了智能体和工具之间的交互能力,这个快速得到业界的广泛支持。今年 5 月份 Build 大会,微软 CTO 有一个说法,他说“MCP 是智能时代的 HTTP 协议”,我觉得这个比喻是比较恰当的。

还有就是 A2A 协议,Agent2Agent,这是 Google 在今年 4 月份推出的,智能体与智能体之间的协作协议。未来不可能是单一智能体帮我们干活。我们需要多智能的协作。今天主流的智能体协作大概是个位数到十几二十个。但未来智能体协作的数量很快会超越百、千,甚至会出现数万个智能体协作。

记忆也是智能体关键的一环,很多时候我们说智能体比较差强人意,其实是因为记忆能力缺失导致的。今年大模型一个突飞猛进的能力,就是记忆能力。

前面这四大能力集合在一起,就使得智能体具有了行动能力。去年9月份全球产品经理大会上,我曾经提出一个观点,未来智能体会把我们今天的互联网从“信息网络”重构为“行动网络”。

当时提出这个观点,坦白来说还是研究性的,当时我记得也有一些同行会有疑问:“真的会这样吗?”但是大家今年从 3 月份 Manus 出来之后,包括后来 OpenAI、Anthropic 和 Google 纷纷推出自家的智能体,大家都看到了互联网在飞速地从信息网络到行动网络进化。我们未来会看到很多网站主要的访问者不再是人类用户,而是智能体。这将是一个非常大的变化。

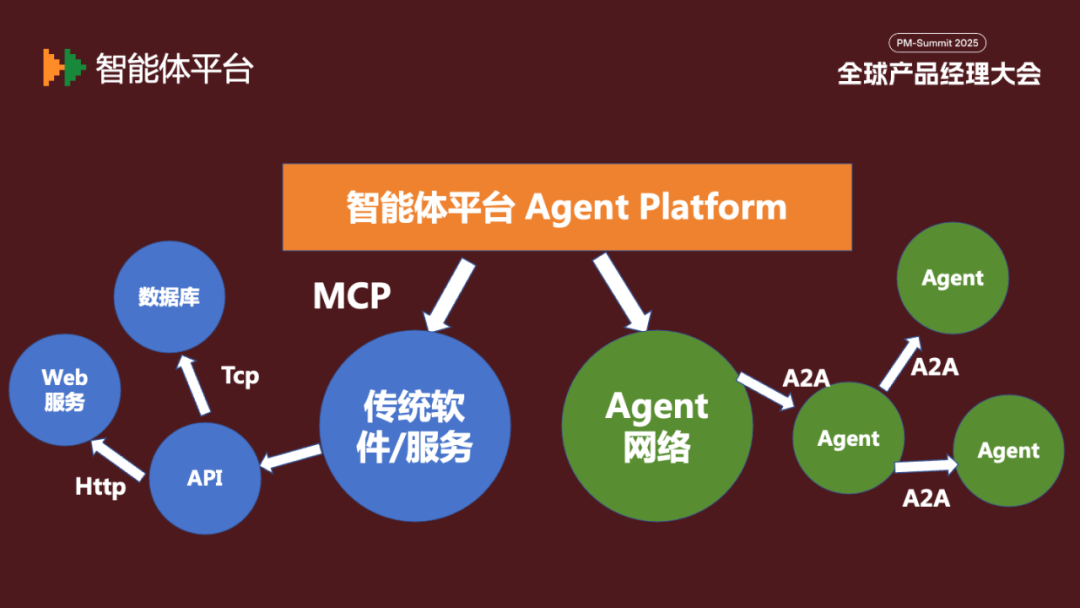

下面简单说一下 MCP 和 A2A 一些构成的智能体平台。

蓝色的部分,是智能体通过 MCP 协议调用我们传统的软件和服务(也就是图灵-冯诺依曼架构下的传统确定性计算)。这些传统软件在智能体时代并不会消失,但我有一个观点,就是它会下游化。因为 Agent 做了人机交互的第一道防线,人类用户和智能体直接交互,智能体再去下游调用那些 API / Web 服务/数据库等。我们也可以说是 MCP,是神经网络计算和图灵-冯诺依曼计算之间的桥梁。

除了传统软件,Agent 和 Agent 之间也需要协作交互,这就是绿色的部分,它们通过 A2A 协议构成一个智能体协作网络。下面是对 MCP 和 A2A 的一个对比:

MCP 执行的是 Agent 来调用传统软件 API 或服务,是机器间的协作,传递的数据格式是结构化的数据。而 A2A 执行的是多个 Agent 之间的交互,它们是拟人化的协作,传递的数据主要是自然语言或者视觉数据。它们的应用场景侧重点也不同。

下面我想谈谈,智能体的执行时长,这是一个很关键的要素。

上个时代,我称为“检索计算”的时代。我们绝大部分产品经理和架构师、程序员,都习惯了秒级服务或者毫秒级、微秒级响应。这对于以信息检索为主的系统,不成问题。包括对话模型,我们基本也能做到这一点。

但是我们发现推理模型上来之后,大家会发现完成稍微复杂的智能体任务,时长就无法维持在秒级。目前很多智能体的执行时间都到几分钟甚至数十分钟。业绩也普遍预计很快一些智能体执行时长将到数小时。

蓝色的部分是我的预测,下半年到未来三年左右,将有智能体执行的时长要到达数天(可能是一些项目类任务)、数月(工程类任务),甚至数年(科研类任务)。Sam Altman 最近也在一个访谈里透露 GPT 内部设计的一些智能体需要执行长达千小时。

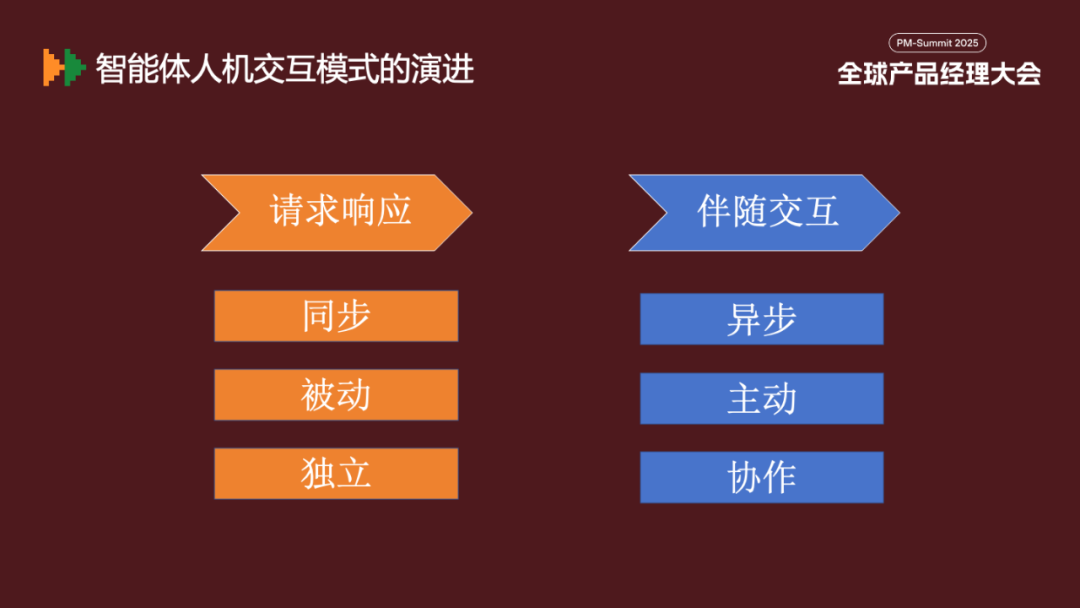

这个变化的主要原因一方面是复杂的推理必然要求更多的计算时长,另一方面从任务结构来讲,人类未来只负责定义需求,过程监督,和结果决策。中间执行过程会交给智能体。这会带来智能体和用户交互上一个巨大的变化。

目前我们比较习惯用“请求/响应的模式”,用户主动发出请求,单一智能体被动响应。但未来的变化将是“伴随交互的模式”,智能体异步执行,它可以根据状态主动和用户沟通、或者询问用户,或者主动报告进展。而且是多个智能体一起协作的模式。这对长时间允许的智能体来说,是非常重要的变化。

如果我们综合前面谈的设备、人机交互,智能体生态,我觉得未来可能会是下面这样一副图景。

人类用户用自然语言通过各种多元设备去呼叫背后的智能体。可能不同的设备,背后链接的是同一个中心化的智能体(可能在云上),它对我们的偏好,我们的 ID、我们的历史比较熟悉。然后它再根据任务类型分发,要么去调用传统软件/API/服务,或者分发给其他的智能体网络来完成任务。然后可能经过秒级、分钟级、小时级或者月级或者年级来异步的方式响应用户。

我的演讲分享就到这里。下面借着这个机会,向大家发布一个新闻,很多朋友可能知道,这几年我主要带着一支技术研究队伍做一些人工智能产业范式的研究。最近,我发起成立了“奇点智能研究院 Singularity Intelligence Research Institute”,奇点智能研究院由 CSDN、Boolan 联合多家机构成立,是专注于人工智能前沿技术和产业落地的创新研究、咨询与智库机构。官网:https://singintelligence.com。奇点智能研究院的愿景和使命是成为人工智能产业的“范式孵化器”,推动 AI 成为普惠性的生产力工具。

在 AGI Singularity 到来之前,希望我和奇点智能研究院能够为人类做一些微薄的事情。谢谢大家!

· · ·

【活动分享】2025 全球机器学习技术大会(ML-Summit)北京站将于 2025 年 10 月 16-17 日在北京威斯汀酒店举办。大会共 12 大主题、50+ 海内外专家,聚焦大模型技术和应用变革。详情参考官网:https://ml-summit.org (或点击原文链接)。