在人与机器不断走近的今天,人机交互却常常面临这样的困境:当桌上放着多个不同杯子时,如果对设备说“把杯子给我”,它可能会随意拿起一个(但不是那个最合适的),或者干脆无法响应。这类场景,正反映出当前智能系统在理解模糊指令时的能力局限。

人类之间的交流,往往依赖语境与默契,大量表达在字面上并不完整。例如我们常说“一会儿提醒我”(具体什么时间?)、“把空调开大点”(开大多少?)、“找个最近的店”(依据步行还是驾车?)。对人而言,这类信息缺口很容易通过追问或推断来补全;但对机器而言,模糊即意味着无法执行。传统自动化系统往往只能响应明确、结构化的指令,而未来的智能体,必须学会在模糊中主动沟通,在协作中完成任务。

这一挑战也推动着智能体从“被动执行者”向“主动协作者”的角色转变。具身智能体的发展目标,是成为人类在物理世界中的合作伙伴,而非停留在脚本定式的工具。与虚拟环境中的AI不同,具身智能体必须应对现实场景的开放性与不确定性。无论是在家庭、工厂还是公共空间中,它们都面临一个根本性的新课题:如何与人进行高效、自然、双向的协同作业。

近年来,视觉-语言-动作模型(VLA)的发展为实现这一目标带来了新的希望。这些模型能够将机器人的视觉观察与语言指令联系起来,并生成相应的动作。然而,目前大多数基于VLA的具身智能体仍以简单的单向模式运行:接收指令,立即执行,不需要任何反馈或澄清。这种被动模式在指令明确时可能有效,但在面对现实中常见的模糊指令时就会显得力不从心。

▍“Ask-to-Clarify”询问澄清框架的创新突破

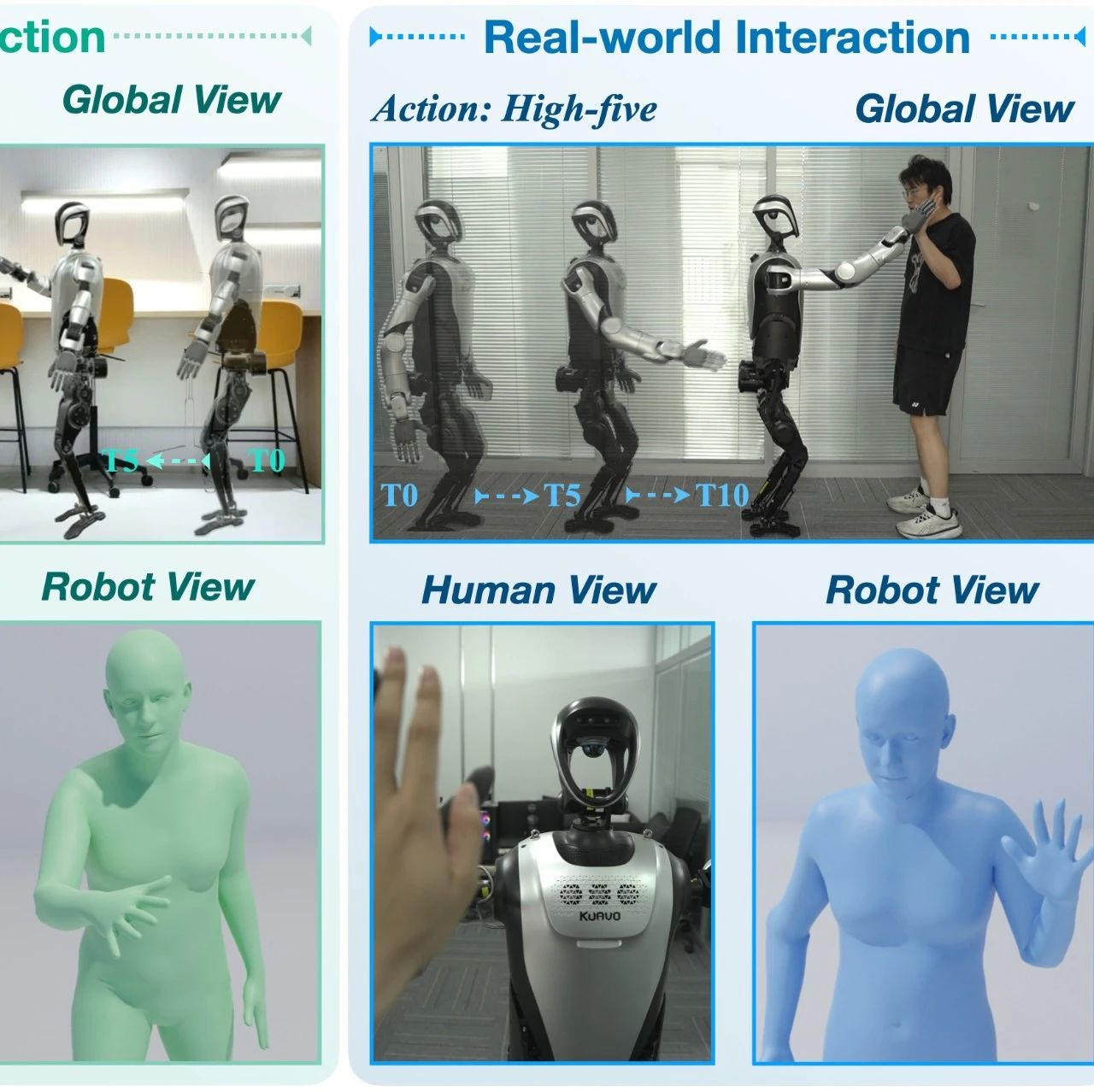

为了解决这一核心挑战,来自复旦大学的研究团队提出了“询问澄清”(Ask-to-Clarify)框架,通过多轮对话澄清歧义后,端到端生成低级动作,实现具身智能体从“被动执行者” 到 “主动协作者” 的转型,为真实人机协作提供新路径。

具体来说,该框架的运作模式类似于人与人之间的协作:当接收到模糊指令时,智能体会通过多轮对话提出澄清问题,逐步明确任务要求,只有在完全理解指令后才会执行相应的低级动作。这种双向交互模式使智能体能够从模糊指令中推断出用户的真实意图,大大提高了任务执行的准确性。

框架的核心组成

“Ask-to-Clarify”框架由两个关键组件组成:负责协作的视觉-语言模型(VLM)和专门生成动作的扩散模型。

视觉-语言模型负责理解视觉场景和语言指令,并在需要时生成澄清问题。例如,当看到多个杯子时,VLM会分析场景中的物体属性(颜色、形状、位置等),并确定需要澄清的信息点。

扩散模型则充当智能体的“肢体控制系统”,负责生成实现任务所需的连续、流畅的低级动作。与依赖“拿起物体”、“向右移动”等高级指令的系统不同,低级动作允许直接控制和端到端学习,使智能体能够应对更复杂的任务场景。

为了使这两个组件顺畅协作,研究人员还设计了一个连接模块将两者紧密集成。该模块基于VLM的输出为扩散模型生成条件,使用指令调整观察结果,创造出更可靠的动作生成条件,确保智能体的思考与行动保持一致。这就像一个有经验的翻译,不仅准确传递信息,还会根据上下文调整表达方式。

独特的训练策略

为了使智能体同时具备对话能力和动作执行能力,研究人员设计了一种两阶段“知识隔离”训练策略。

第一阶段专注于培养智能体的沟通能力。研究人员使用专门设计的歧义解决对话数据对协作组件进行训练,使智能体学会识别指令中的模糊点,并生成恰当的澄清问题。例如,当训练数据中包含多个相似物体时,智能体学习关注它们之间的区别性特征,并就此提问。

第二阶段则专注于动作生成能力的培养,同时通过“冻结”协作组件来保留已学会的对话能力。这种知识隔离策略防止了智能体在学习新技能时遗忘已有能力,类似于人类在学习新知识时不忘记基本沟通技能。

这种训练策略确保了智能体能够首先通过多轮对话澄清指令歧义,然后以端到端的方式生成精确的低级动作。

▍8项任务全面测试,“Ask-to-Clarify”框架的表现亮眼

为了验证“Ask-to-Clarify”框架的有效性,研究人员在8个实际任务中对其进行了全面测试,包括将特定水果放在盘子上、将指定颜色杯子中的水倒入盘子,以及将不同颜色的积木堆叠在一起等任务。

实验结果显示,在这8项涵盖日常操作的任务测试中,“Ask-to-Clarify”框架表现十分亮眼。该框架在所有任务中均显著优于当前最先进的视觉-语言-动作模型(VLA)。例如,在放置水果任务中,其成功率达到了95%;倒水任务中高达98.3%;即便在较为复杂的堆叠积木任务中,也实现了90%的成功率。

尤为值得注意的是,这些测试中“Ask-to-Clarify”框架接收的均为模糊指令,需通过主动对话澄清意图;而作为对比的基线模型则直接接收明确指令。即便在这样的不对等条件下,该框架依然表现卓越,充分证明了其主动协作机制在实际应用中的显著价值。

为进一步验证框架在真实环境中的适用性,研究团队还专门测试了其在非理想条件下的鲁棒性,包括低光照环境和存在视觉干扰物的场景。在低光照条件下,传统模型性能大幅下降,而“Ask-to-Clarify”框架仅受到轻微影响,成功率从90%降至80%,仍保持较高水平;

当环境中存在相似物体干扰时(例如苹果与石榴并存),该框架仍能维持80%的成功率,明显高于传统模型的65%。这种对复杂环境的强适应能力,源于框架设计中视觉编码器的冻结策略,使智能体能够更好地应对视觉变化,而传统模型往往因对训练数据过度拟合,难以适应现实世界的多变场景。

▍结语

“Ask-to-Clarify”框架的提出意味着具身智能体发展的来到了崭新一页。它不仅在技术上实现了智能体从单向执行到双向协作的转变,更在理念上重新定义了人机协作的可能性。

随着这项技术的发展,我们可以预见更多能够与人类自然沟通的智能系统出现在日常生活中。从家庭助手到工业机器人,从医疗护理到教育培训,具备协作能力的具身智能体将在各个领域发挥重要作用。

然而,这一研究也只是构建真正智能协作系统的起点。未来研究还需要解决如何在更复杂的环境中进行有效对话、如何理解人类的非语言沟通(如手势和眼神),以及如何在长时间互动中维持对话上下文等挑战。