新智元报道

新智元报道

【新智元导读】前OpenAI研究员Kevin Lu加盟由前OpenAI CTO Mira Murati创立的Thinking Machines Lab。公司2025年7月获约20亿美元早期融资,估值约120亿美元。Kevin Lu曾主导GPT-4o mini,长期研究强化学习、小模型与合成数据。

刚刚,OpenAI又离职一名华人大佬。

前OpenAI研究员Kevin Lu宣布加入AI新创Thinking Machines Lab。

Kevin Lu主导了GPT-4o mini的发布,并参与o*-mini、o3等模型工作。

Thinking Machines Lab由前OpenAI CTO Mira Murati创立的。

2025年7月,公司创历史完成约20亿美元的超大额早期融资(a16z领投),估值约120亿美元。

随后团队核心成员在社交平台上互动表示欢迎。

Kevin Lu是强化学习与小模型方向的研究者,本科就读于加州大学伯克利分校,在OpenAI期间专注强化学习、Small Models与合成数据。

加入Thinking Machines之前还在Hudson River Trading、MetaAI从事序列决策与深度学习研究。

Kevin Lu在小模型与合成数据上的实践经验,有助于Thinking Machines缩短从论文到用户价值的距离。

尤其是他7月的一篇博客非常出圈:真正推动AI进步是互联网。

深入浅出的讲明白一个事情:与其反复抠架构,不如扩大、丰富、贴近现实的数据来源(如互联网)与数据消耗方式,否则模型始终「见得少、懂得少」。

博客地址:https://kevinlu.ai/the-only-important-technology-is-the-internet

以下为博客的部分截取翻译:

虽然AI的进步常被归功于一些里程碑论文——比如transformers、RNNs、diffusion——但这忽略了AI最根本的瓶颈:数据。

那么,「好数据」究竟意味着什么?

如果我们真想推进AI,与其研究深度学习优化,不如研究「互联网」。

互联网才是让我们的AI模型实现规模化扩展的那项关键技术。

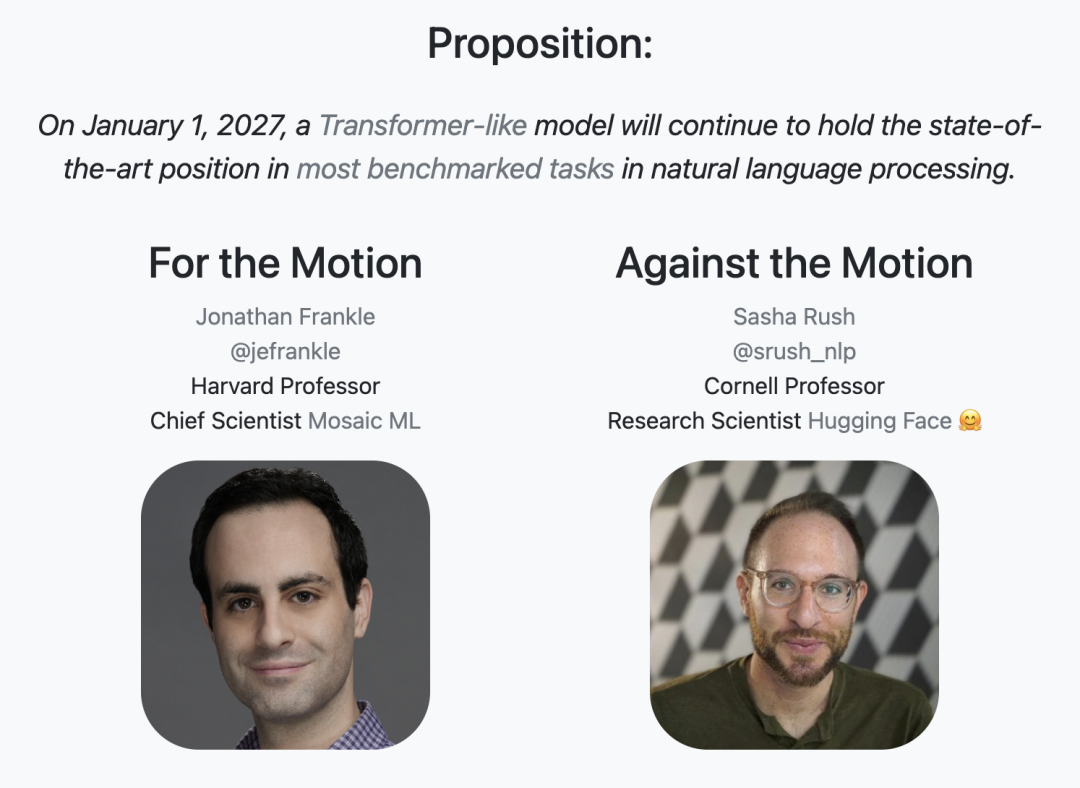

· Transformers是一种「分散注意力」

受架构创新带来的快速进展启发(5年间从AlexNet到Transformer),许多研究者一直在寻找更好的架构先验,寄望于设计出「优于Transformer」的新架构。

事实上,Transformer之后确实出现了一些更好的架构;但为什么自GPT-4以来,我们很难「切身感到」这种改进?

· 范式更迭

算力受限(compute-bound)。

曾经,方法随算力扩展,更高效的方法就更好。

真正重要的是把数据尽可能高效地塞进模型里;这些方法不仅效果更好,而且似乎「越大越灵」。

然后,数据受限(data-bound)。

研究模型架构当然不是没用。社区在Transformer之后开发出了更好的方法,比如SSMs与Mamba等。

但它们并非「免费的胜利」:在给定训练算力下,训练一个Transformer往往能得到更优性能。

但数据绑定的范式是自由的:反正各种方法最终都差不多!

因此应选择推理阶段更优的方法,可能是某种「次二次注意力变体」(subquadratic attention variant)。

这些方法很可能会再度走到台前。

· 研究者该做什么?

设想我们不只关心推理(可以理解为「产品」),而是关心渐近性能(可以理解为朝着AGI迈进):

显然,只优化架构是错的。

调整Q-function轨迹裁剪也不对。

手工打造新数据集无法扩展。

花哨的「时间高斯探索」(new temporal Gaussian exploration method)也大概率不具扩展性。

社区的许多成员已经达成共识:应研究新的「数据消费」方式。

目前两大主流范式是:(1)下一个token预测(NTP)与(2)强化学习(RL)。

(显然,我们在「新范式」上并没取得太多突破)

目前AI领域里程碑工作本质上是在开辟数据消耗&消耗的新途径:

AlexNet(2012):用「下一个token预测」的视角来「消化」ImageNet。

GPT-2(2019):用下一个词预测来学习互联网文本。

原生多模态(如GPT-4o、Gemini 1.5):用下一个词预测吸收互联网的图像与音频。

ChatGPT:在聊天场景中用强化学习摄取随机的人类偏好奖励。

DeepSeek-R1:在狭窄领域用强化学习摄取确定且可验证的奖励。

就「下一个token预测」而言,互联网是完美的解决方案:它提供了极其丰富的、按序相关的数据,正好适合序列建模去学习。

互联网充满了结构化HTML的「序列」,天生适配下一个token预测;按不同顺序重构,可以涌现多种有用能力。

这不是巧合:这种「序列数据」对下一个token预测近乎完美;互联网与下一个token预测相辅相成。

Alec Radford在2020年的一个先见之明的演讲中指出:尽管当时提出了很多新方法,但都不如「扩大与整理数据」重要。

我们从「寄望更好方法带来神奇泛化(比如损失函数暗含句法树)」,转向一个朴素原则:模型没被告知的事,它当然不知道。

与其通过打造大规模监督数据集去「硬性指定预测目标」,不如设法让模型从「外部的一切」中学习并进行预测。

每次我们做一个数据集,就像是把「世界上其他一切」的重要性设为0、把「数据集内的一切」的重要性设为1。

可怜的模型!它们知道的太少,仍有太多被隐藏。

自GPT-2之后,全球开始关注OpenAI,而时间也证明了其影响力。

低数据。在低数据范式里,Transformer可能一文不值:其「架构先验」不如CNN或RNN,因此表现应更差。

书籍。较不极端的情况是:若无互联网,我们可能用书籍/教材进行预训练。教材常被视为人类智慧的巅峰:作者受过良好教育,字斟句酌。这代表一种信念:「高质量数据胜于大数量数据」。

教材与Phi。Phi系列(「Textbooks Are All You Need」)在小模型上表现出色,但仍要依赖在互联网训练的GPT-4做过滤与合成。

总体看,Phi很不错,但尚未证明能达到以互联网数据预训练模型的渐近性能;且教材缺少大量现实世界与多语言知识(不过在算力受限下它们很强)。

「数据类别」的类比

可把「教材」视作可验证奖励(表述几乎总是真),而「书籍」(尤其是创作类)更像是「人类偏好」,能赋予学生模型更强的风格多样性。

就像我们可能不会让o3或Sonnet 3.7替我们写作一样,只在高质数据上训练的模型可能缺少某种创造性「火花」。

因此Phi的PMF(产品市场契合)并不理想:需要知识时,人们偏好大模型;要本地「角色写作」,人们也不太会选Phi。

书与教材本质上只是互联网数据的压缩(背后或许有强大智能在做压缩)。

更上一层看,互联网是极其多样化的监督源,也是人类的映射。

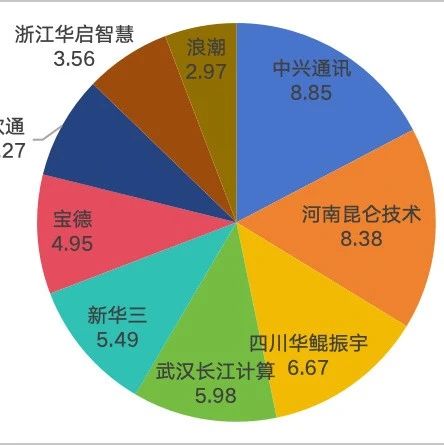

展示了互联网用户在过去三十多年里由几百万跃升到50多亿的长期、持续增长

一些研究者可能觉得「为了研究进步要转向产品」很奇怪(甚至是干扰),但如果我们关心AGI对人类有益(而不是像AlphaZero那样在真空中聪明),就该考虑AGI的形态(产品)。

我认为研究(预训练)与产品(互联网)的协同设计非常优雅。

互联网是去中心化的,任何人都能民主地添加知识;不存在单一真理源。

它承载了大量视角、文化模因和低资源语言;若用大模型在其上预训练,便能得到理解广博知识的智能。

这意味着,互联网的管理者(产品「管家」)对AGI的设计举足轻重!

若削弱互联网多样性,模型在做RL时的「熵」(信息多样度)会显著变差;若删除数据,AGI中的整个亚文化都可能被抹去。

对齐。有非常有趣的结果表明:为了得到对齐的模型,必须同时在对齐与未对齐数据上预训练,因为预训练会学到二者之间线性可分的方向。

如果去除未对齐数据,模型就难以理解「什么是不对齐,以及为何这是不好的数据」。(有点善恶共存,无善无恶的味道了)

上图指标越高(「Toxigen」)表示毒性越强。

在含10%有毒数据+人工引导上预训练的模型,比在0%有毒数据+引导上预训练的模型更不毒。

特别是,上述「有毒」数据来自4chan,这是一个匿名在线论坛,以其无限制的讨论和有害内容而闻名。

尽管这是一个产品与研究之间存在紧密联系的特定案例(我们需要这种无限制讨论来实现对齐的研究模型),但我认为你可以想到更多类似的案例,其中互联网的设计决策在训练后影响了最终结果。

非对齐的另一个例子:Improving Image Generation with Better Captions推动了DALL·E 3的发展。

通过重写标注以更清晰地区分「好/坏图像」,如今已广泛用于生成模型。

这与RLHF的「点赞/点踩」在精神上相似。

必须牢记:人们确实想使用互联网,而这些有用性质都是与「互联网这一产品」互动的涌现结果。

如果我们总是手工整理数据,就会出现「被整理的内容」与「用户觉得有用的能力」之间的二元对立。

有用的技能不应由研究者来拍脑袋选,用户会告诉你答案。

「人们想使用互联网」的另一半原因是:人均成本足够低,才能普及并汇聚数据。若互联网需要昂贵订阅,就不会有大规模数据贡献。

人们常在「扩展性」讨论里忽略这一点:互联网是那个能扩展学习与搜索(数据与计算)的简单理念。

若你找到这种「简单理念」并把它做大,就会收获卓越成果。

要点。互联网之所以对训练极有用,是因为:

1)多样,蕴含大量有用知识;

2)形成天然课程;

3)有产品市场契合,用户持续供数;

4)经济可行,单人成本低、可普及。

互联网对监督式的下一个token预测是如此完美的补充,以致我们甚至可以强说:给定互联网这个「底座」,研究者几乎必然会收敛到下一个token预测。

因此我会说:互联网就是「下一个token预测」的对偶。

如上所述,尽管我们做了大量研究,当下仍只有两大范式。

因此,提出新的「产品」点子可能比提出新的「学习范式」更容易。这引出问题:那强化学习的「对偶」是什么?

现在有一些想法,但各有缺陷。它们都不算「纯研究」,都涉及围绕RL打造产品。

我们期望的属性是:多样性、天然课程、PMF、经济可行性。

最后一评:先牺牲一些多样性也可以——在自家产品里用RL优化指标(游戏、自动售货机、留存/利润/参与度等)。

这可能有效,但难点在于:如何把它「升格」为一种多样化、可扩展的奖励宇宙,从而引发范式级跃迁。

总之,我们还远未找到一个像「互联网之于NTP」那样优雅且高产的「RL对偶」。

最后,Kevin Lu再次强调,在训练里,模型只「看到」数据集里的东西;集外的世界等于被忽略(0 权重)。

希望有朝一日我们将找到方法来解决这个问题。