智猩猩Robot整理

编辑:严浠

相较于轮式、履带式机器人,足式机器人能够适应非结构化地形,在人类存在的复杂3D环境中敏捷运动。但想要在这样的环境中鲁棒的运动,还需要具备强大的空间感知能力和快速响应能力,能够快速躲避空中障碍物和动态智能体等多类障碍物。

但传统基于深度的感知避障方法容易受噪声、光照和非平面障碍影响,性能受限。相比之下,将激光雷达原始点云直接端到端集成到足式机器人运动学习的方案仍处于早期探索阶段。这是因为足式机器人在行走、奔跑、跳跃过程中存在的剧烈高频振动和姿态变化,会导致激光雷达采集的点云数据出现严重的运动模糊和畸变,动态避障性能不佳;激光雷达也难以实现有效的sim2real迁移。

为此,香港科技大学(广州)梁俊卫老师团队联合清华大学和北京人形机器人创新中心提出基于激光雷达的敏捷避障locomotion强化学习方法Omni-Perception。为实现规模化且逼真的训练,又提出一个高逼真的激光雷达仿真插件,支持Isaac Gym、Genesis、MuJoCo等多个仿真平台,实现大规模训练,能够sim2real到真实世界中的四足机器人和人形机器人上。与Omni-Perception相关的论文成果已收录于CoRL 2025并获得Oral。

论文标题:《Omni-Perception: Omnidirectional Collision Avoidance for Legged Locomotion in Dynamic Environments》

论文链接:https://arxiv.org/pdf/2505.19214

项目主页:

https://github.com/aCodeDog/OmniPerception

收录情况:CoRL 2025 Oral

1

方法

1.1 激光雷达渲染框架

现有仿真器,如NVIDIA Isaac Gym/Sim、Gazebo、Genesis,虽提供了物理仿真能力,但缺乏对非重复扫描激光雷达等多样化传感器的支持,在并行性与跨平台执行方面也存在限制。为此,该团队设计出高性能激光雷达渲染框架:利用NVIDIA Warp实现GPU加速,采用Taichi确保跨平台兼容性,使其在缺乏专用NVIDIA GPU的系统中也能运行。

基于此框架,实现了对多种商用激光雷达模型的支持:通过利用真实设备数据确定与仿真时间t同步的扫描角度,模拟了其特性化的扫描模式;同时支持传统的旋转激光雷达,预配置模型包括Velodyne系列(HDL-64/VLP-32)及多种Ouster传感器。

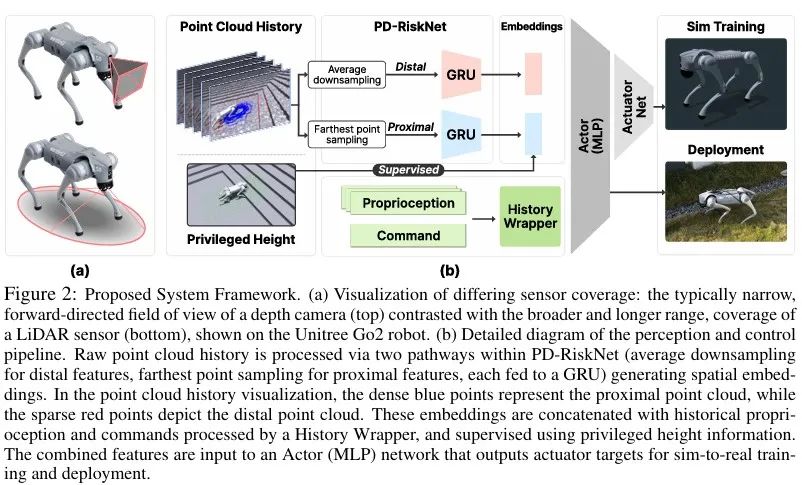

1.2 Omni-Perception框架

Omni-Perception整体框架如下图所示,包含处理激光雷达点云数据的PD-RiskNet模块、高保真激光雷达仿真工具和将感知信息与本体感知和指令相融合的强化学习策略。

整个系统以原始激光雷达点云为输入,通过PD-RiskNet提取环境风险特征,结合机器人本体感知和速度指令,输出关节控制信号,形成完整的闭环控制。

1.3 PD-RiskNet:时空点云处理

PD-RiskNet模块用于处理从足式机器人激光雷达获取的时空点云数据。首先将原始点云Praw划分为两个子集:近端点云Pproximal和远端点云Pdistal。

近端点云处理:代表附近环境的Pproximal通常具有更稠密的点云和距离变化相对较小。为了高效处理稠密点云数据的同时保留关键局部几何细节,采用最远点采样(FPS)降低数据密度,保留关键几何特征,再通过门控循环单元(GRU)捕捉局部环境动态变化。训练中引入"特权高度信号"(Privileged Height)作为监督,引导网络学习与四足机器人运动相关的地形风险表征。

远端点云处理:远处环境的Pdistal具有稀疏性且测距值变化较大。为适应稀疏点云数据特征并降低异常值影响,采用平均下采样操作,减少噪声影响,通过另一个GRU模块提取远距离环境的时空特征。这种分层设计使网络能够同时关注局部避障和全局路径规划。

1.4 风险意识运动策略

该运动策略通过多层感知机(MLP)实现,其输入为PD-RiskNet提取的融合特征与本体感知历史数据。

观测空间:观测包含本体感知历史数据、经PD-RiskNet处理后的特征

动作空间:策略输出目标关节位置at,由底层PD控制器执行。

奖励函数:奖励函数用于训练机器人在利用激光雷达数据主动避障的同时,跟踪速度指令。研究人员采用与《Extreme parkour with legged robots》相似的奖励函数架构,其核心包含带避障的线速度跟踪奖励(rvel_avoid)和距离最大化奖励(rrays)。

域随机化策略:为增强sim2real的迁移能力,在训练中域随机化策略,包括机器人物理参数的随机化以及环境与激光雷达参数随机化。

2

实验

2.1 激光雷达保真度评估

研究人员验证了激光雷达在仿真环境中的保真度,下图是将激光雷达部署在Unitree G1上。将本文的方法与真实机器人上激光雷达扫描点云与使用Isaac Sim官方传感器模型生成的点云进行对比,证明本文提出的方法准确还原了真实激光雷达中存在的自遮挡效应。

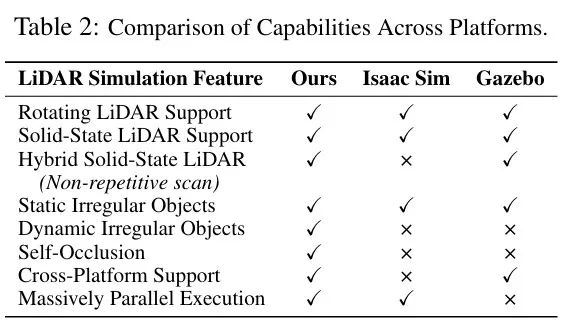

2.2 与现有仿真平台对比与分析

目前有众多的机器人仿真平台,但官方支持激光雷达仿真的相对有限,其中Gazebo与NVIDIA Isaac Sim是提供内置激光雷达仿真功能的典型代表。将本文提出的激光雷达仿真工具与Isaac Sim和Gazebo进行对比,下表总结了各平台的激光雷达仿真能力。

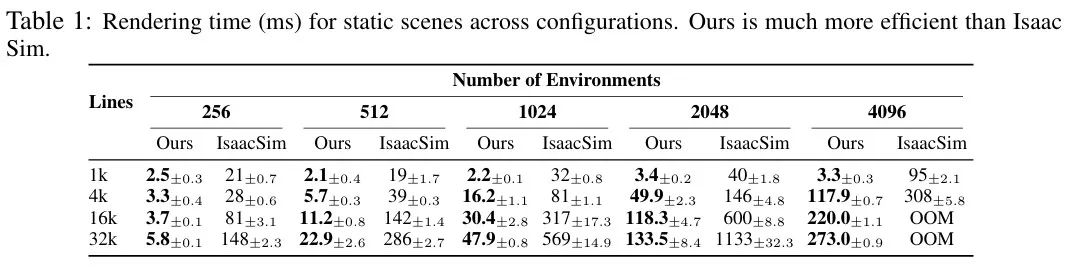

下表所示为本文提出的方法相较于Isaac Sim的激光雷达渲染速度,本文提出的激光雷达仿真工具的平均渲染速度是Isaac Sim的5-10倍。

2.3 PD-RiskNet消融实验

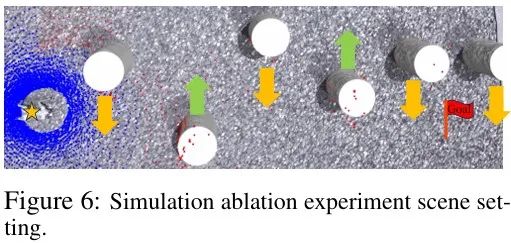

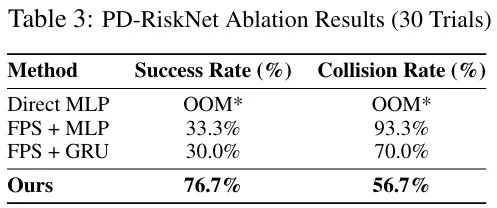

研究人员测试了四种激光雷达点云处理方法以验证PD-RiskNet的有效性。在Isaac Gym仿真环境中(包含6个以1.5m/s移动的动态障碍物),对四种方法各进行30次试验。任务要求机器人到达12米×4米区域的终点,如下图所示。

实验结果如下表所示,直接使用MLP的方法因内存不足(OOM而失败;采用FPS下采样、FPS+MLP和FPS+GRU的方法成功率极低,多数是因为超时或卡顿导致的失败。本文提出的方法成功率为76.7%,碰撞率为56.7%,显著优于其他方法。

2.4 真机部署

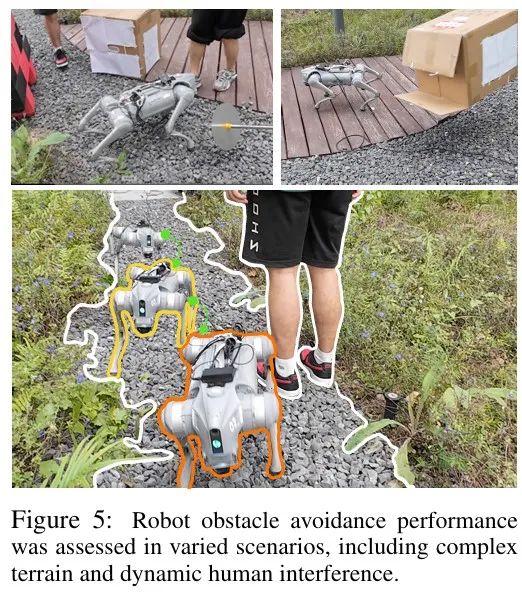

该团队将Omni-Perception部署在四足机器人上,在多种场景下评估了四足机器人的全向避障能力和反应。

进一步又测试了极端条件下的性能,如下图所示。四足机器人在茂密草丛中的岩石地形成功穿行,即使向它扔箱子和人员遮挡也能快速躲避后继续稳定运行,展现出对快速逼近的空中障碍物和频繁人员遮挡的适应能力。

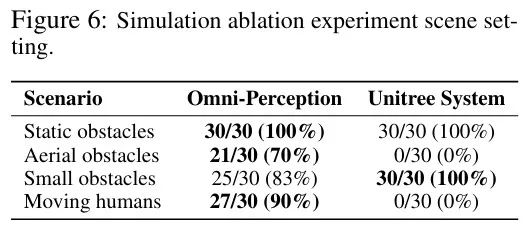

该团队又将Omni-Perception部署在Unitree G1上,将Omni-Perception方法和Unitree G1自带的避障方法进行了对比,每种障碍物经过了30次试验,实验结果如下表所示。Omni-Perception躲避空中障碍物成功率为70%,对于移动的人类躲避成功率也达到90%,而这两类障碍物Unitree G1自带的避障方法成功率均为0。该实验证明了Omni-Perception的有效性,能成功部署在人形机器人上,并帮助其成功躲避动态障碍物。

3

总结

本文提出基于激光雷达的端到端强化学习方法Omni-Perception,通过利用激光雷达点云数据,成功实现了足式机器人鲁棒的全向动态避障。为实现规模化且逼真的训练,又提出一个高逼真的激光雷达仿真插件,支持Isaac Gym、Genesis、MuJoCo 等平台,实现大规模训练,能够sim2real到四足机器人和人形机器人上。在真实环境中验证了Omni-Perception方法,部署到Unitree G1上后,躲避空中障碍物成功率为70%,躲避移动的人类成功率达到90%,证明了该方法的有效性。

END

推荐阅读

灵巧手抓放任务成功率100%!帕西尼联合上交大提出融合触觉的VLA模型OmniVTLA

全面优于π0!星海图开源端到端双系统VLA模型G0:基于500小时真机数据预训练

训练数据65万条!上海AI Lab联合提出端到端VLA模型InstructVLA,真机实验成功率超OpenVLA

20亿参数+全面超越π0!清华朱军团队&地平线提出全新VLA模型H-RDT,有效从人类操作数据中学习

机器人非抓取操作重大突破!北大&银河通用王鹤团队提出自适应世界动作模型DyWA | ICCV 2025

点击下方名片 即刻关注我们